- 저자: Syed Abdul Hannan, Hazim Bukhari, Thomas Cantalapiedra, Eman Ansar, Massa Baali, Rita Singh, Bhiksha Raj

비전-언어 모델(VLM)을 사용한 얼굴 확인 시스템의 가독성 향상에 대한 연구. 기존 접근 방식이 주로 열매 그림자만 보는 것이라면, 본 논문은 왜 결정을 내렸는지 설명하는 능력을 추가하여 시스템의 신뢰성을 높이는 방법을 제시한다.

1. **가독성 있는 얼굴 확인 태스크:**

- 이전에는 얼굴 이미지를 비교할 때 단순히 '같다', '다르다'라는 결과만 제공했지만, 본 논문에서는 두 이미지 간의 차이점을 자연어로 설명한다. 이를 위해 특별한 데이터셋을 만들었고, 모델은 이제 그 이유를 설명할 수 있다.

# 서론

얼굴 확인 시스템은 최근 몇 년 동안 심층 학습 모델을 통해 큰 발전을 이루었으며, 두 얼굴 이미지가 같은 개인의 것인지 여부를 판단하는 높은 정확도로 비디오 감시 및 범죄자 식별에 사용될 수 있게 되었다. 이러한 시스템이 내린 결정 이유를 이해함으로써 편향을 감지하고 수정할 수 있어 더 신뢰할 수 있는 결정을 내릴 수 있다. 현재 접근 방식은 중요도 열매 그림자를 기반으로 하는 설명 방법에 의존한다.

Large Language Models (LLM)는 텍스트 모달리티에서 추론 능력을 나타내었으며, 뒤이어 비전 언어 모델(VLM)과 오디오 언어 모델(ALM) 영역의 작업들은 이러한 추론 능력을 다른 모달리티로 확장하였다.

비전-언어 모델(VLM)을 사용하여 결정 이유를 설명하는 것은 이해에 매우 중요하다. 이전에는 단일 입력만 제공되었지만, 우리의 접근 방식은 두 가지 입력을 제공하여 모델이 동시에 비교하고 추론할 수 있도록 한다. 이를 위해 오디오 입력을 사용해 차이점 설명 방법을 탐색한 작업에서 영감을 받았다.

우리는 새로운 비전-언어 모델(VLM)을 도입하며, 이 모델은 두 얼굴 이미지가 같은 개인의 것인지 판단하고 결정 이유를 명시적으로 제공한다. 이를 위해 두 가지 서로 보완적인 설명 스타일인 간결한 설명과 상세한 설명을 사용하는 고유한 학습 접근 방식을 활용한다.

우리의 접근 방법은 오디오 기반 구분 모델에서 개발된 최신 모델링 프레임워크를 적응하고 강화하여 시각적 입력을 효과적으로 처리한다. 이미지 특징 추출 기술과 대형 언어 모델(LLM)의 추론 능력을 통합함으로써 우리의 VLM은 확인 과정을 명확하게 설명할 수 있게 되며, 투명하고 신뢰할 수 있는 얼굴 확인 시스템 개발에 중요한 단계를 이룬다.

이 논문에서 주요 기여 사항은 다음과 같다:

-

자연어로 두 얼굴 이미지 간의 차이점을 설명하는 가독성 있는 얼굴 확인 작업을 도입한다. 모델을 훈련시키고 평가하기 위해 가독성 있는 얼굴 확인 데이터셋을 생성했으며, 이는 LLM을 사용하여 VLM 주석 첨부 캡션에서 차이점 설명을 생성하고 나중에 인간 주석자에 의해 검증된다. 데이터셋은 두 가지 단계의 설명을 포함한다: (1) 결정에 영향을 미치는 핵심 요인들을 요약하는 간결한 설명과, (2) 이미지들 사이에서 관찰된 특정 차이점을 상세히 설명하는 종합적인 설명.

-

Verification Language Model(VerLM) 모델을 도입한다.

-

제안된 프레임워크를 사용하여 교차 투영, 언어 모델 스케일링 및 이미지 기반의 영향력을 이해하기 위해 여러 가지 절제 연구를 수행한다. 우리의 결과는 기본 모델보다 우수함을 보여주며, 또한 모델 크기 확장으로 인해 접근 방법이 개선됨을 나타낸다.

가독성 있는 얼굴 확인

비전-언어 모델(VLMs)의 출현은 다중 모달 이해를 근본적으로 변화시켰으며, Liu 등이 시각적 지시 조정 작업을 통해 큰 언어 모델이 어떻게 효과적으로 시각적 내용을 이해하고 추론하는지 보여주었다. 그들의 LLaVA 프레임워크는 세심하게 설계된 명령어 따르기 패러다임을 통해 복잡한 시각적 이해와 자연어 생성을 통합할 수 있음을 입증하였으며, 컴퓨터 비전 작업에서 더 전문적인 응용 분야를 위한 길을 열었다.

교차 모달 설명 접근 방법은 특히 오디오 도메인에서 중요한 발전을 이루었으며, 자연 언어로 청각적 차이점을 설명하는 효과적인 방법론을 제시하였다. Deshmukh 등은 ADIFF라는 새로운 오디오 언어 모델을 소개하여 오디오 샘플 간의 차이점을 자연 언어로 설명한다. 그들의 아키텍처는 독특한 교차 투영 메커니즘과 구분자 토큰을 사용해 오디오 쌍 사이의 특징을 강조하며, 구조화된 차이점 계산이 단순한 특징 연결 방법론보다 크게 우수함을 보여주었다. Elizalde 등은 CLAP(Contrastive Language-Audio Pre-training)를 개발하여 자연 언어 감독을 통해 공유 임베딩 공간에서 대조 학습을 수행하는 강력한 방법을 제시하였다. 이러한 오디오 중심 접근법은 언어 모델을 비텍스트 입력에 조건부로 적용해 의미 있는 설명을 생성할 수 있음을 입증했다.

이미지 차이 분석은 Hu 등이 도입한 OneDiff 모델을 통해 크게 발전했으며, 일반적인 이미지 차이 캡션링을 위한 특수 아키텍처를 소개하였다. 그들의 작업은 명확한 차이 모델링의 중요성을 강조하였으며, 기존의 단순히 이미지 특징을 연결하는 방법보다 큰 성능 향상을 보여주었다. OneDiff는 성공적인 이미지 차이 설명이 특정 아키텍처 구성요소를 통해 구별되는 특징을 포착하고 표현해야 함을 보여주었지만, 일반적인 이미지 차이에 초점을 맞추어 특정 도메인 적용에 대한 전문적 최적화는 크게 남겨두었다.

가독성 있는 얼굴 인식은 후속 설명 방법에 의존해왔다. 주로 가시화 기반 시각화 및 히트맵 생성을 통해 이루어졌다. DeAndres-Tame 등은 자연어 처리를 통한 얼굴 인식에서 일찍부터 설명 가능성을 도입했으며, 현재의 접근 방식이 상세하고 인간에게 이해하기 쉬운 설명을 제공하지 못함을 강조했다. 현재 가독성 있는 얼굴 인식 시스템은 중요한 얼굴 영역을 강조하는 시각화 기반 방법을 사용하나, 특정 얼굴 유사점과 차이점에 대한 상세한 설명은 제공하지 않는다.

연구 격차와 동기부여는 이러한 환경에서 분명히 나타난다. 일반적인 VLMs는 인상적인 능력을 보였지만, 특수 작업인 얼굴 확인에는 도메인별 아키텍처적 수정이 필요하다고 시스템적으로 탐색되지 않았다. 기존의 이미지 차이 모델인 OneDiff는 세밀한 분석 능력이 부족하며, 얼굴 확인에서 미세한 얼굴 특징이 정확한 식별에 중요할 수 있다. 또한 오디오 도메인에서 성공적으로 입증된 교차 투영 메커니즘은 시각적 얼굴 확인 작업에 적응되고 평가되지 않아, 다중 모달 지식 전환의 중요한 기회를 제공한다.

우리의 제안한 VerLM은 오디오 기반 차이점 설명에서 성공적인 교차 투영 메커니즘을 시각 도메인에 적응시키고, 도메인별 얼굴 인코더와 새로운 이중 계층 설명 시스템을 구현함으로써 이러한 식별된 격차를 해결한다. 이를 통해 높은 정확도의 얼굴 확인과 인간이 이해할 수 있는 설명을 결합하여 더 투명하고 신뢰할 수 있는 얼굴 인식 시스템을 제공하며, 자연어로 추론 과정을 설명할 수 있다.

가독성 있는 얼굴 확인 데이터셋

우리는 VGGFace2 데이터셋의 부분집합을 사용하였으며, 이는 9,131명의 개인에 대한 3.31백만 개의 이미지를 포함하고 다양한 자세와 방향성을 가지고 있다. 우리는 두 가지 데이터셋을 만들었으며 각각은 79,771개의 이미지 쌍과 일치하는 얼굴 7,689개를 포함한다. Llama 2를 사용하여 각 이미지 쌍에 대한 설명을 생성하였다. Dataset 1은 평균 학습 설명 길이가 53.35단어이고, Dataset 2는 더 포괄적인 학습 설명으로 평균 길이가 121.64단어이다. 데이터셋의 통계는 표 1에서 확인할 수 있다.

우리는 Llama 3.2 VLM을 사용하여 데이터셋 내 각 얼굴에 대한 설명을 생성하였다. 그런 다음 무작위로 얼굴 쌍을 선택하고 레이블(일치 또는 불일치)을 지정하였다. 마지막으로 다시 Llama 3.2를 사용해 이미지 쌍의 얼굴 설명을 한 개의 단락으로 압축하여 두 개인 간의 유사점과 차이점을 설명하였다. 또한 레이블에 접근할 수 있어 같은 사람인지 아닌지를 설명하도록 요청하였다. 다음은 각 데이터셋에 대한 생성된 설명의 예이다.

Dataset 1의 설명:

-

얼굴 일치:

두 얼굴 이미지는 핵심 식별 특징에서 높은 유사성을 나타낸다. 두 이미지 모두 따뜻한 탄색 피부, 검은 눈동자, 곱슬머리로 묘사된 여성이 나온다. 약간의 차이는 얼굴 모발에 대한 세부사항이다.

-

얼굴 불일치:

두 이미지는 일부 유사한 특징을 공유하지만 눈동자 색상, 머리색과 스타일, 그리고 얼굴 모발의 차이로 같은 개인이 아닌 것으로 보인다.

Dataset 2의 설명:

-

얼굴 일치:

두 이미지를 분석한 결과, 그들이 같은 개인에게서 온다는 여러 유사 특징을 발견했다. 두 이미지는 비슷한 피부색, 얼굴 구조, 이마 라인 및 코 형태를 공유한다. 검은 머리 색상과 스타일, 그리고 눈썹 모양과 두께도 일치한다. 그러나 헤어 텍스처와 약간의 눈동자 색상 차이가 있으나, 조명 조건이나 미세한 관리 변화로 인한 것으로 추정된다. 이러한 작은 차이에도 불구하고, 전체적인 얼굴 특징과 구조는 매우 유사하여 이 이미지들이 같은 개인을 나타내고 있음을 결론 짓는다.

-

얼굴 불일치:

제공된 설명에 따라 두 얼굴 이미지는 일치하지 않는다. 주요 차이점은 피부색(1번 사람의 경우 밝고 부드러움, 2번 사람의 경우 가벼운 갈색), 얼굴 구조(1번 사람의 날카로운 턱, 2번 사람의 둥근 턱), 눈 색상과 모양(1번 사람의 파란 눈, 2번 사람의 갈색 눈), 머리 색상과 스타일(1번 사람의 노랑빛 갈색 웨이브 머리, 2번 사람의 검은색 dreadlocks), 얼굴 턱수염(1번 사람 없음, 2번 사람 면도 및 수염), 눈썹 모양과 두께(1번 사람 얇고 밝은 갈색, 2번 사람 두껍고 어두운 갈색)이다. 이러한 큰 차이점들은 이미지가 같은 개인을 나타내지 않음을 보여준다.

|

평균 |

중앙값 |

최대 |

어휘 |

| Dataset 1 - Train |

53.35 |

54 |

127 |

4341 |

| Dataset 1 - Test |

53.71 |

54 |

124 |

1727 |

| Dataset 2 - Train |

121.64 |

121 |

325 |

6008 |

| Dataset 2 - Test |

122.19 |

121 |

263 |

2664 |

설명 길이 통계

= [rectangle, rounded corners, minimum width=3cm, minimum

height=1cm,text centered, draw=blue] = [trapezium, trapezium left

angle=70, trapezium right angle=110, minimum width=3cm, minimum

height=1cm, text centered, draw=black, fill=blue!30] = [rectangle,

minimum width=3cm, minimum height=1cm, text centered, draw=black,

fill=orange!30] = [diamond, minimum width=3cm, minimum height=1cm,

text centered, draw=black, fill=green!30] = [thick,->,>=stealth]

모델

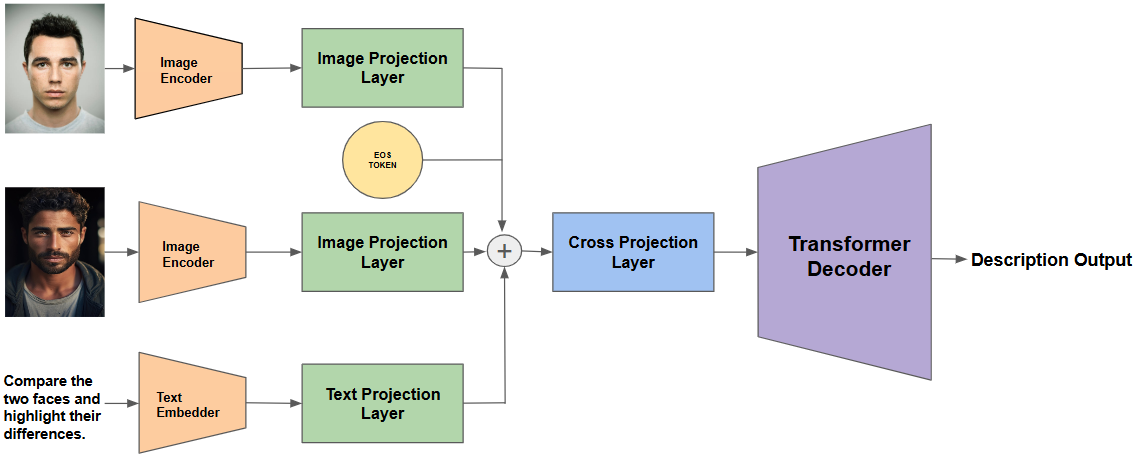

이 섹션에서는 자연어를 사용한 종단간 가독성 얼굴 확인 작업을 위한 우리의 제안된 비전-언어 모델, VerLM에 대해 설명한다. VerLM 모델은 세 가지 다른 입력값인 두 이미지(이미지 1과 이미지 2)와 사용자가 제공하는 텍스트 프롬프트를 받아들인다. 이 모델의 출력은 이러한 입력을 기반으로 생성된 자유 형식 텍스트이다.

VerLM 아키텍처는 여섯 가지 주요 구성 요소로 구성된다: (1) 이미지 인코더, (2) 이미지 프로젝션 레이어, (3) 텍스트 임베더, (4) 텍스트 프로젝션 레이어, (5) 교차 프로젝션 레이어, 그리고 (6) 디코더만 언어 모델.

이미지 인코더: 실험에서 주로 사용한 이미지 인코더는 VGG Face 모델이며, Labeled Faces in the Wild(LFW) 데이터셋에서 99.65%의 정확도를 달성한다. 또한 VGG Face 인코더를 CASIA-WebFace 인코더와 비교하는 절제 연구를 제공하며, 이는 LFW 데이터셋에서 99.05%의 정확도를 달성했다. 이러한 실험의 자세한 결과와 비교 분석은 Ablations 섹션에 제시된다.

이미지 프로젝션 레이어: 이 프로젝션 레이어는 이미지 인코더에서 추출된 얼굴 임베딩을 교차 투영 레이어와 언어 모델의 잠재 공간으로 투영한다. 이미지 프로젝션 레이어는 단일 임베딩 $`[b,h]`$를 디코더만 언어 모델 입력을 위한 잠재 토큰 시퀀스 $`[b,s,d]`$로 변환한다. 여기서 $`b`$는 배치 크기, $`h`$는 이미지 인코더의 최종 출력 레이어에서의 은닉 차원, $`s`$는 토큰 시퀀스 길이이고 $`d`$는 디코더만 언어 모델 입력의 차원이다. 이를 위해 먼저 은닉 차원을 더 큰 은닉 차원 $`k`$로 투영한다($`k = s*d`$). 이어서 학습 가능한 상수를 연결하여 $`[s+c, d]`$가 된다. 마지막으로 이 출력은 변환기를 통과한 후 학습 가능 상수 출력 $`c`$가 잘리게 된다. 이 레이어의 최종 출력 형태는 $`[b, s, d]`$이다. 이러한 투영 아키텍처는 prefix-tuning 아키텍처에 대해 잘 작동한다.

텍스트 임베더: 여기서 사용하는 텍스트 임베더는