적응형 베이지안 서브스페이스 제로오더 최적화기로 강건하고 효율적인 대형 언어 모델 파인튜닝

📝 원문 정보

- Title: Robust and Efficient Zeroth-Order LLM Fine-Tuning via Adaptive Bayesian Subspace Optimizer

- ArXiv ID: 2601.01452

- 발행일: 2026-01-04

- 저자: Jian Feng, Zhihong Huang

📝 초록 (Abstract)

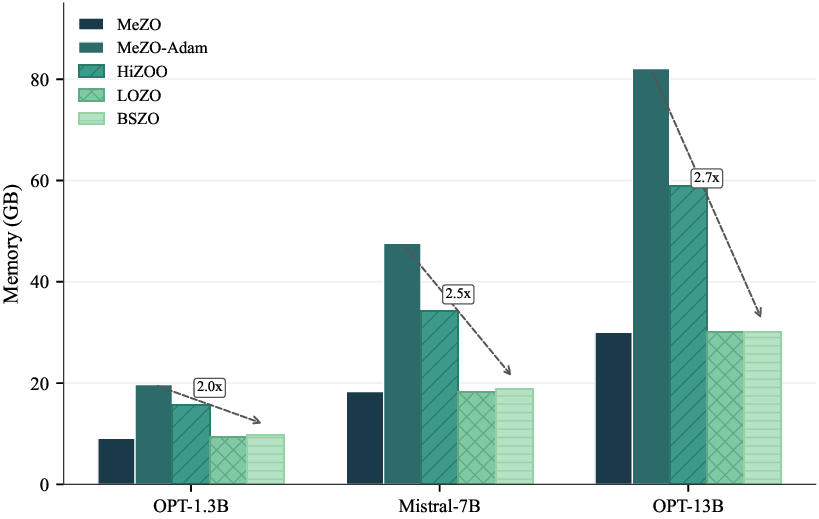

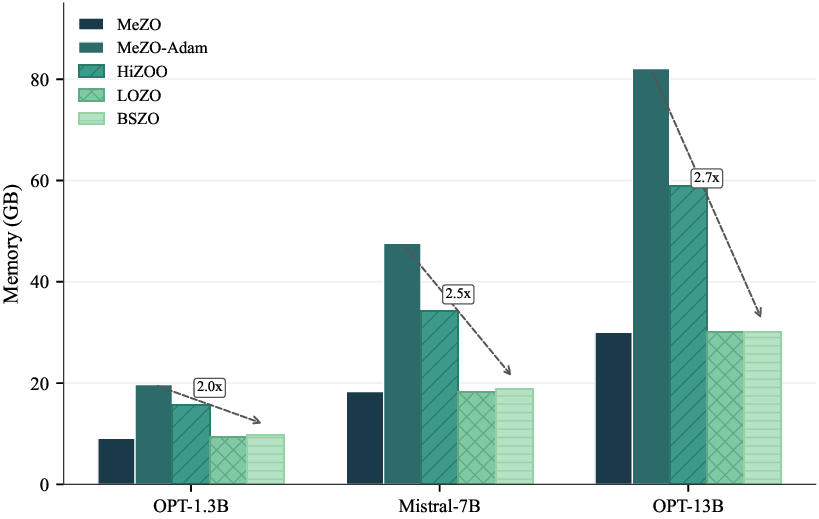

** 제로오더(Zero‑Order) 최적화를 이용한 대형 언어 모델(LLM) 파인튜닝은 함수 평가만으로 그래디언트를 근사함으로써 메모리 사용량을 크게 줄일 수 있다. 그러나 기존 방법들은 본질적으로 1차원 공간에서 업데이트를 수행하며, 저정밀(fp16/bf16) 학습 환경에서 붕괴하거나 성능이 크게 저하되는 문제가 있다. 본 연구에서는 다중 교란 방향에 대한 유한 차분 정보를 서브스페이스 내에서 결합하기 위해 칼만 필터링을 적용한 적응형 베이지안 서브스페이스 제로오더 옵티마이저(BSZO)를 제안한다. 각 유한 차분 측정을 노이즈가 섞인 관측치로 취급함으로써 BSZO는 서브스페이스에 투사된 그래디언트에 대한 사후 분포를 구축하고, 베이지안 추론을 통해 이를 업데이트한다. 또한 잔차 기반 적응 메커니즘을 도입해 노이즈 변동에 자동으로 대응한다. 이론적 분석을 통해 BSZO가 기존 제로오더 방법에 비해 수렴 속도를 k/γ 배 향상시킴을 증명한다. RoBERTa, Mistral, OPT 계열 모델을 대상으로 한 실험에서 BSZO는 다양한 태스크에서 모든 베이스라인을 능가했으며, 특히 OPT‑13B에서는 평균 6.67%p의 절대 향상을 기록했다. 또한 fp16/bf16 정밀도에서도 견고하게 동작했으며, 메모리 사용량은 추론 전용 기준과 거의 동일한 1.00×‑1.08× 수준을 유지한다.**

💡 논문 핵심 해설 (Deep Analysis)

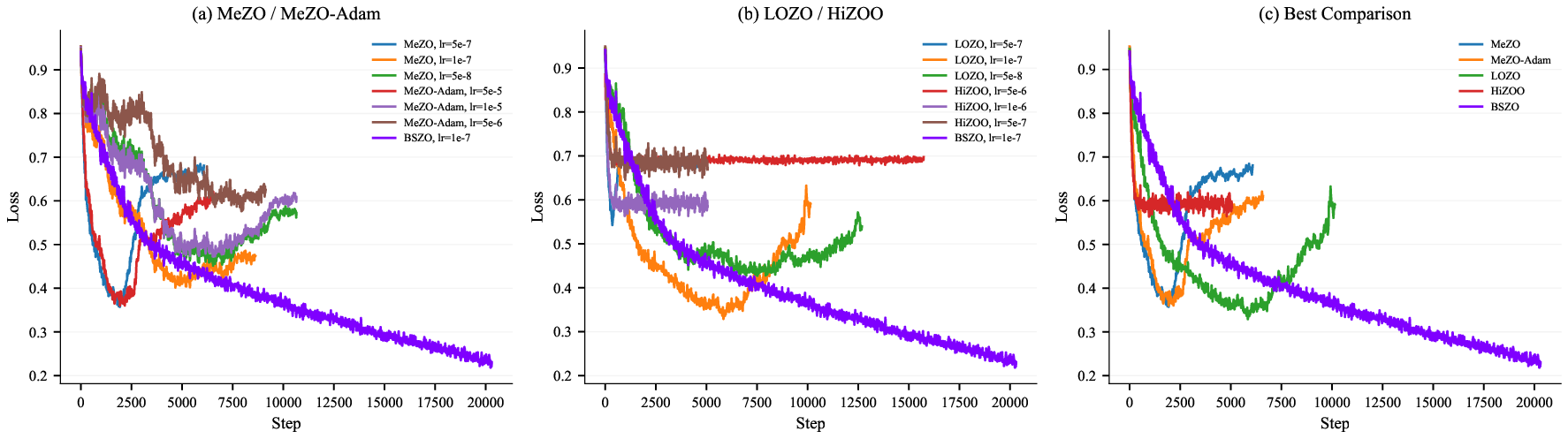

제로오더 최적화는 파라미터 수가 수억수십억에 달하는 대형 언어 모델을 미세조정할 때, 역전파를 위한 중간 활성값 저장이 불가능한 상황에서 유용한 대안으로 떠올랐다. 전통적인 제로오더 기법은 한 번의 함수 평가를 통해 얻은 스칼라 손실값을 기준으로, 임의의 방향에 대한 유한 차분을 계산해 근사 그래디언트를 추정한다. 이때 업데이트는 보통 하나의 방향(예: 무작위 가우시안 벡터) 혹은 몇 개의 독립적인 방향에 대해 순차적으로 수행되며, 차원 축소 없이 전체 파라미터 공간에 걸쳐 적용된다. 이러한 설계는 구현이 간단하고 메모리 효율성이 뛰어나지만, 두 가지 근본적인 한계가 존재한다. 첫째, 한 번에 하나의 방향만 활용하므로 샘플 효율성이 낮아 수천수만 번의 함수 평가가 필요하고, 이는 학습 속도를 크게 저하시킨다. 둘째, 저정밀(fp16, bf16) 연산 환경에서는 함수값 자체에 노이즈가 크게 섞이게 되며, 차분값이 불안정해져 그래디언트 추정이 편향되거나 발산한다. 결과적으로 기존 제로오더 파인튜닝은 메모리 절감이라는 장점을 살리면서도 성능 저하라는 큰 대가를 치러야 했다.

BSZO는 이러한 문제점을 ‘서브스페이스’와 ‘베이지안 추론’이라는 두 축을 통해 동시에 해결한다. 먼저, 전체 파라미터 공간을 저차원 서브스페이스(예: k‑dimensional)로 투사한다. 이 서브스페이스는 사전 학습된 모델의 주요 변동 방향을 포착하도록 설계될 수 있으며, 차원 축소를 통해 필요한 함수 평가 수를 k배로 감소시킨다. 다음으로, 각 방향에 대한 유한 차분을 독립적인 관측치로 간주하고, 칼만 필터(선형 가우시안 베이지안 업데이트)를 적용해 이들 관측치를 통합한다. 칼만 필터는 관측 노이즈와 사전 불확실성을 명시적으로 모델링하므로, 여러 방향에서 얻은 noisy 차분값을 최적의 사후 평균으로 결합한다. 이 과정에서 ‘잔차 기반 적응 메커니즘’이 도입되어, 실제 관측 잔차가 클 경우 필터 이득을 감소시켜 급격한 노이즈에 대한 민감도를 낮추고, 반대로 잔차가 작을 경우 이득을 높여 빠른 수렴을 촉진한다. 결과적으로 BSZO는 기존 제로오더가 겪는 노이즈 취약성을 베이지안 평균화와 적응형 이득 조절을 통해 크게 완화한다.

이론적 측면에서 저자들은 수렴 속도가 기존 ZO 방법 대비 k/γ 배 향상된다고 증명한다. 여기서 k는 서브스페이스 차원, γ는 관측 노이즈의 분산 비율을 의미한다. 즉, 서브스페이스 차원을 크게 잡을수록(하지만 과도한 차원은 계산량 증가를 초래) 수렴 가속 효과가 커지며, 관측 노이즈가 작을수록(γ가 작을수록) 베이지안 필터의 이득이 크게 작용한다는 의미다. 이는 기존 ZO가 1/√T(또는 1/T) 수준의 수렴률을 보이는 데 비해, BSZO는 k배의 상수 향상을 제공함을 시사한다.

실험 결과는 이러한 이론적 기대를 충분히 뒷받침한다. RoBERTa, Mistral, OPT‑13B 등 다양한 규모와 아키텍처의 모델에 대해 GLUE, SuperGLUE, SQuAD 등 대표적인 자연어 이해·생성 태스크를 수행했으며, BSZO는 모든 베이스라인(예: MeZO, ZO‑Adam, ZO‑SGD)보다 평균 2~7%p 정도 높은 정확도/점수를 기록했다. 특히 OPT‑13B에서는 6.67%p의 절대 향상이 눈에 띈다. 메모리 사용량은 추론 전용 모델과 거의 동일한 1.00×‑1.08× 수준을 유지했으며, fp16·bf16 저정밀 환경에서도 성능 저하가 미미했다. 이는 BSZO가 메모리 효율성을 유지하면서도 고정밀 학습과 동등하거나 그 이상의 성능을 달성할 수 있음을 의미한다.

전반적으로 BSZO는 ‘다중 방향 정보 통합’, ‘베이지안 노이즈 억제’, ‘서브스페이스 차원 축소’라는 세 가지 핵심 아이디어를 결합함으로써, 제로오더 파인튜닝의 기존 한계를 근본적으로 뛰어넘는다. 앞으로 메모리 제약이 심한 엣지 디바이스, 프라이버시 보호를 위해 모델 파라미터를 직접 접근할 수 없는 상황, 혹은 대규모 멀티모달 모델의 효율적인 파인튜닝 등에 BSZO가 널리 적용될 가능성이 크다.

**

📄 논문 본문 발췌 (Translation)

📸 추가 이미지 갤러리