- Title: Improved Object-Centric Diffusion Learning with Registers and Contrastive Alignment

- 저자: Bac Nguyen, Yuhta Takida, Naoki Murata, Chieh-Hsin Lai, Toshimitsu Uesaka, Stefano Ermon, Yuki Mitsufuji

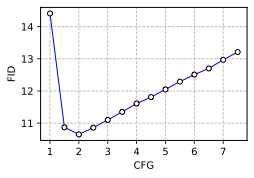

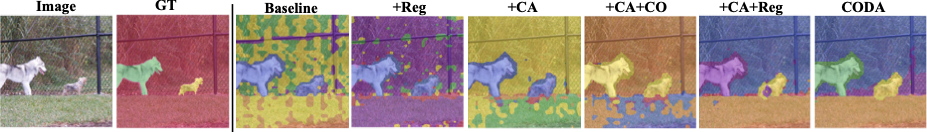

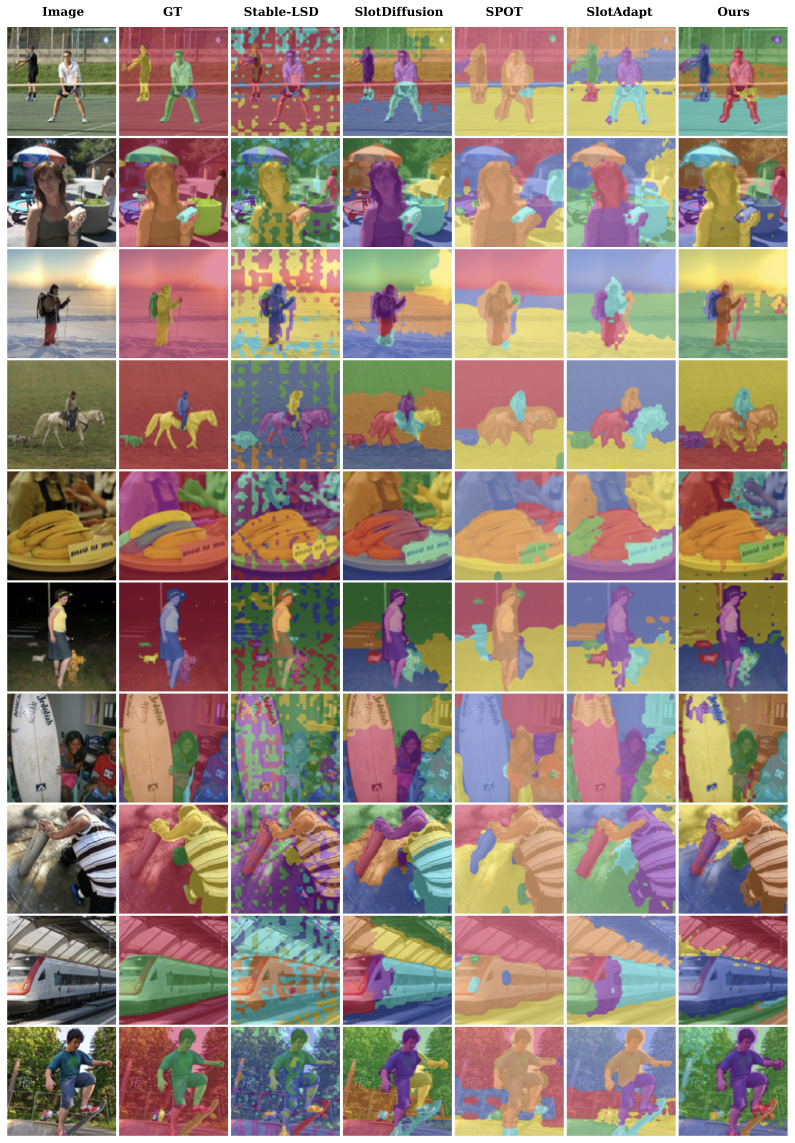

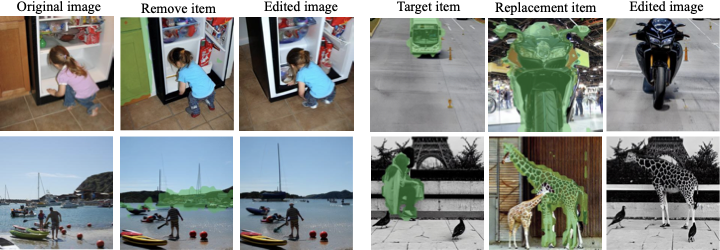

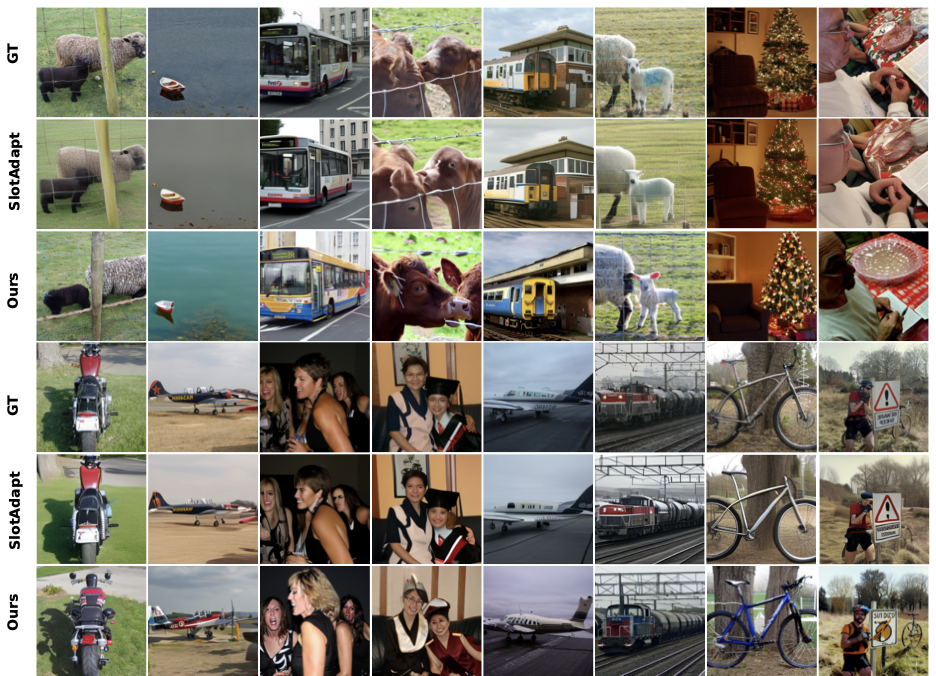

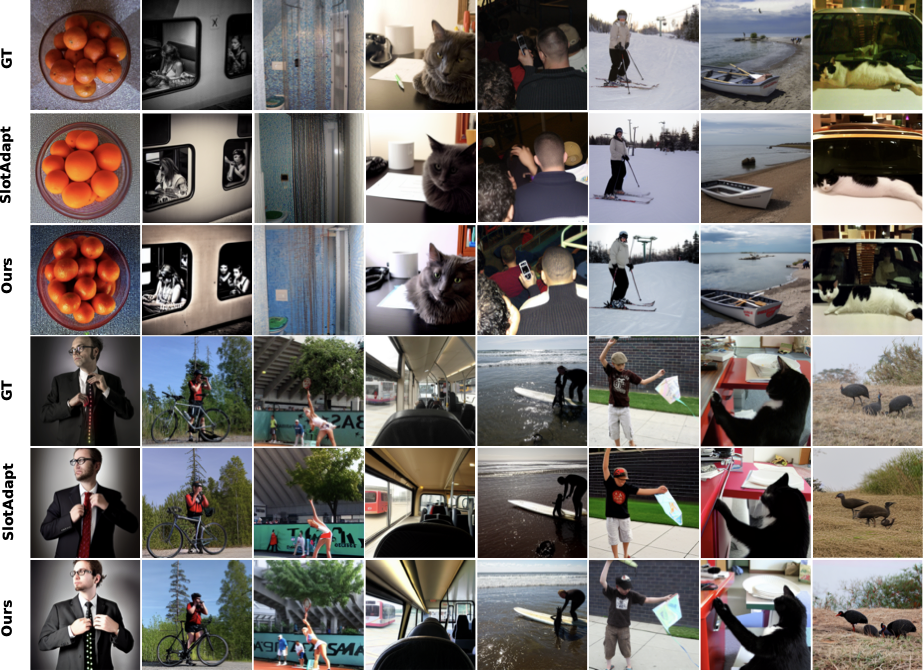

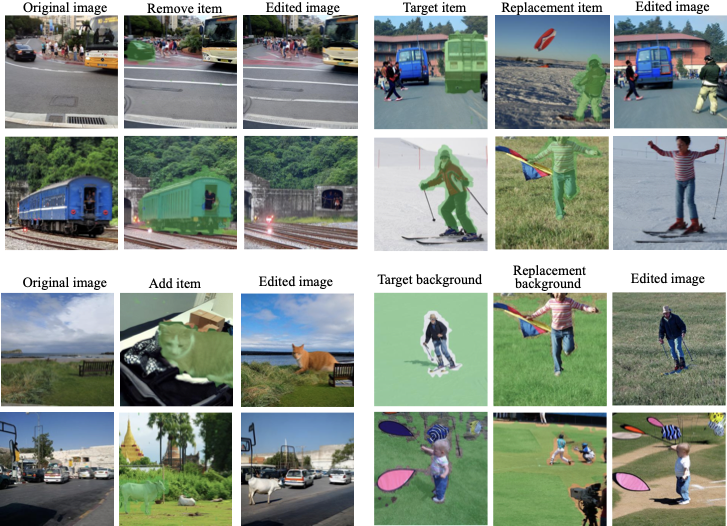

슬롯 어텐션(SA)과 사전 훈련된 확산 모델은 최근 객체 중심 학습(OCL)에 대한 잠재력을 보여주었지만, 슬롯 얽힘 및 객체 슬롯과 이미지 내용 간의 약한 정합성 문제를 겪고 있습니다. 저희는 Contrastive Object-centric Diffusion Alignment(CODA), 즉 간단한 확장 방법을 제안합니다. 이 방법은 (i) 잔여 어텐션을 흡수하고 객체 슬롯 사이의 간섭을 줄이기 위해 등록 슬롯을 사용하고, (ii) 슬롯-이미지 대응을 명시적으로 유도하기 위해 대조적 정합성 손실을 적용합니다. 결과적인 학습 목표는 슬롯과 입력 사이의 상호 정보(MI)를 최대화하는 실용적인 대체 방식으로 작동하여 슬롯 표현의 질을 강화합니다. 합성(MOVi-C/E) 및 실제 데이터셋(VOC, COCO) 모두에서 CODA는 객체 발견(예: COCO에서 +6.1% FG-ARI 증가), 속성 예측, 그리고 구성적 이미지 생성을 강력한 베이스라인보다 향상시킵니다. 등록 슬롯은 무리 없이 추가되므로 CODA는 효율적이며 확장 가능합니다. 이러한 결과는 복잡하고 실제 상황에서 견고한 OCL을 위한 효과적인 프레임워크로서 CODA의 잠재적 응용 가능성에 대한 증거를 제공합니다.

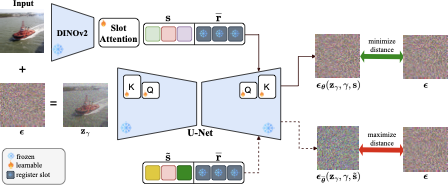

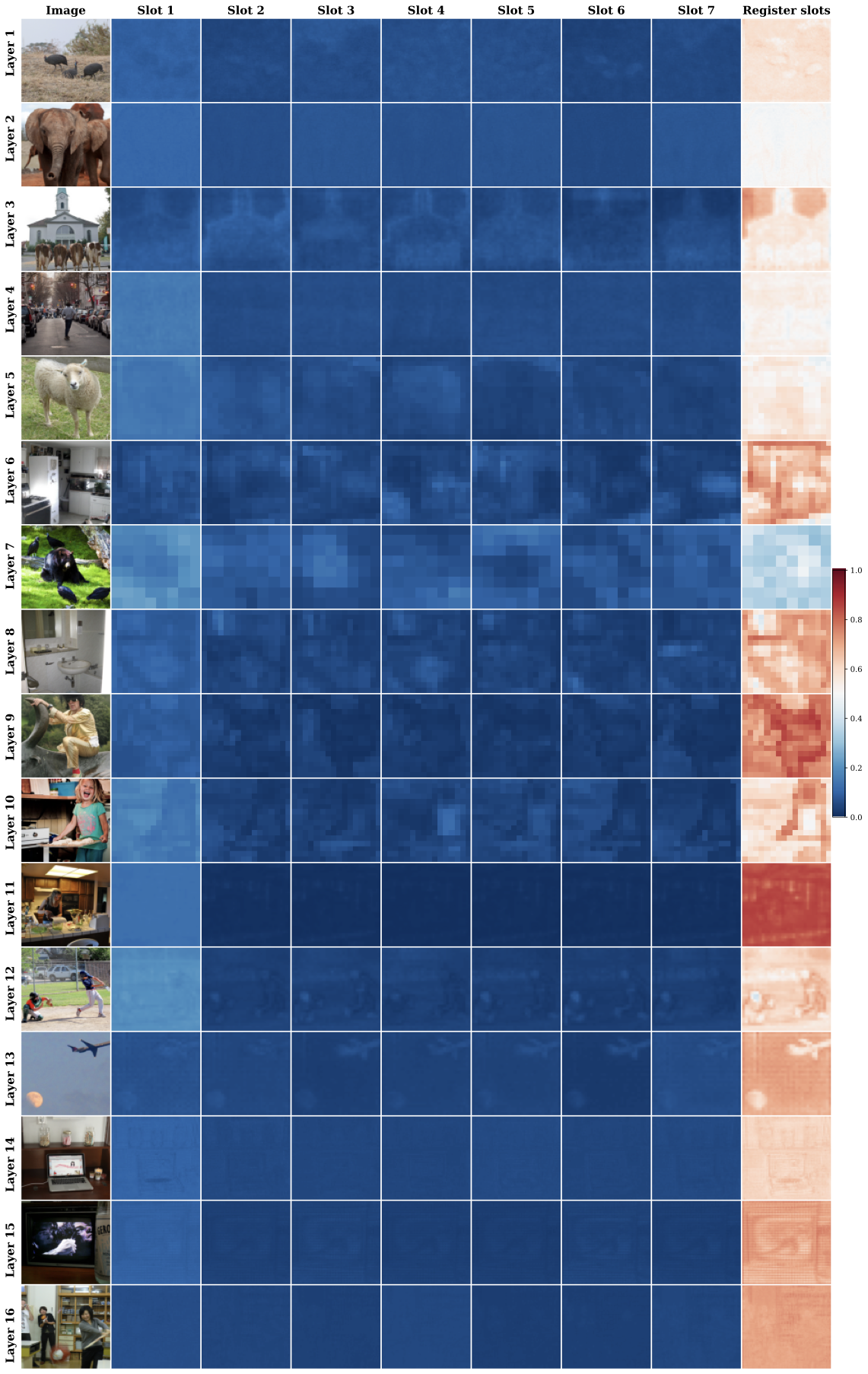

1) **등록 슬롯을 사용한 분리된 슬롯 확산**. CODA는 입력 이미지에 독립적인 등록 슬롯을 도입합니다. 이 슬롯들은 의미 정보를 가지고 있지 않지만, 잔여 주의를 흡수하여 객체 슬롯들이 중요한 개념과 연결될 수 있도록 돕습니다. 이를 통해 슬롯 간의 간섭이 줄어들고 객체 섞임 현상이 완화됩니다.

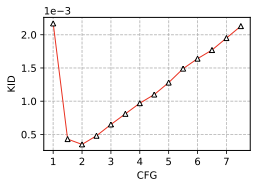

2) **텍스트 조건화 편향 감소**. CODA는 사전 학습된 확산 모델에서 상속받은 텍스트 조건화 편향을 줄이기 위해 크로스 주의 층의 키, 값, 출력 프로젝션을 미세 조정합니다. 이를 통해 슬롯과 시각적 내용 간의 정합성이 개선되고 더 신뢰할 수 있는 객체 중심 분해가 가능해집니다.

3) **대조 정렬 목표**. CODA는 이미지에 나타나는 개념들을 캡처하도록 슬롯을 강제하는 대조 손실을 도입합니다. 이와 함께 노이즈 제거 손실과 함께, 우리의 학습 목표는 입력과 슬롯 간의 상호 정보량 (MI)을 최대화하는 가역적인 대체 수단으로 볼 수 있습니다.

maketitle 감사 aketitle

서론

객체 중심 학습 (OCL)은 복잡한 장면을 구조화되고 해석 가능한 객체 표현으로 분해함으로써, 시각적 추론, 인과 추론, 세계 모델링, 로봇 제어 및 조합적인 생성 등의 하류 작업을 가능하게 합니다. 그러나 이미지에서 이러한 조합적인 표현을 직접 학습하는 것은 여전히 주요 과제입니다. 텍스트와 달리, 단어가 자연스럽게 조합 가능한 단위를 형성할 수 있지만, 이미지는 객체나 개념의 명확한 경계를 가지고 있지 않습니다. 예를 들어, 보행자, 차량 및 신호등이 있는 거리 장면에서 모델은 라벨 없이 이러한 엔티티들을 분리하고 그들의 공간 관계 (예: 사람과 차 사이에 걸쳐 있는)도 포착해야 합니다. 다중 객체 장면은 추가적인 복잡성을 가집니다: 모델은 개별 객체를 감지하는 것뿐만 아니라 그들의 상호작용을 포착해야 합니다. 데이터셋이 더 복잡하고 텍스처가 많아짐에 따라 이는 더욱 어려워집니다. 객체 경계 또는 조합 구조의 수동 주석화는 비싸기 때문에, 슬롯 주의 (SA)와 같은 완전 무감독 접근 방식의 필요성이 생깁니다. SA는 단순한 합성 설정에서는 효과적이나, 실제 세계 이미지의 큰 변이에 대응하는 데 어려움을 겪어 시각 작업에서 제약을 받습니다.

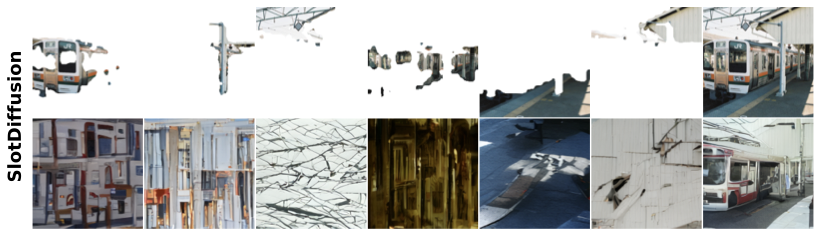

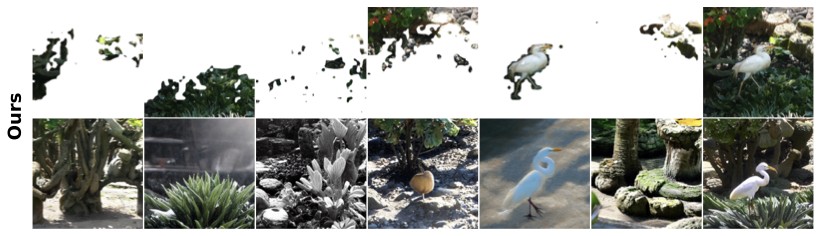

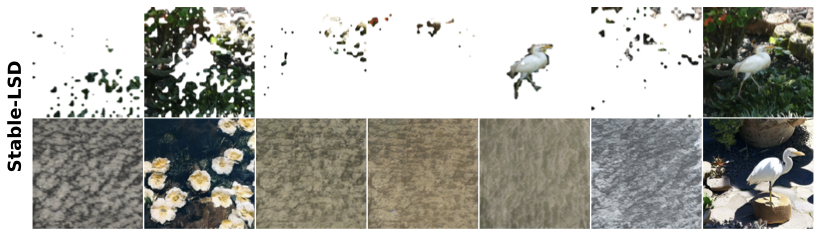

확산 모델과 결합된 SA는 최근 OCL에서 진전을 이루었습니다. 특히 Stable-LSD 및 SlotAdapt은 사전 학습된 확산 백본인 Stable Diffusion (SD)을 활용하여 강력한 객체 발견과 고품질 생성을 달성합니다. 그럼에도 불구하고, 이러한 접근 방식은 여전히 두 가지 주요 과제를 안고 있습니다. 첫째로, 슬롯 얽힘 현상이 발생하는데, 이는 하나의 슬롯이 여러 개체나 그 일부의 특징을 인코딩하여 단일 슬롯 생성이 불충실해집니다. 이러한 얽힘은 세분화 품질을 저하시키고 새로운 장면과 객체 구성에 대한 조합적 생성을 방지합니다. 둘째로, 슬롯들은 일관된 이미지 영역으로 대응하지 못하는 약한 정렬 문제를 보입니다. 특히 실제 세계 이미지에서 오버 세분화 (하나의 개체가 여러 슬롯으로 분할됨), 언더 세분화 (여러 개체가 하나의 슬롯에 합쳐짐) 또는 불정확한 객체 경계 문제가 발생합니다. 이 두 가지 문제는 객체 중심 표현의 정확성과 조합적 장면 생성을 위한 활용도를 떨어뜨립니다.

이에 대응하여, 우리는 Contrastive Object-centric Diffusion Alignment (CODA)라는 슬롯 주의 모델을 제안합니다. CODA는 사전 학습된 확산 디코더를 사용해 입력 이미지를 재구성하는 데 중점을 두고 있습니다. CODA는 잔여 주의를 흡수하고 객체 슬롯 간의 간섭을 줄이는 등록 슬롯과, 슬롯-이미지 정합성을 명시적으로 촉진하는 대조적 목적을 추가합니다. 이를 통해 CODA는 개별 슬롯뿐만 아니라 그들의 조합에서도 이미지를 신뢰할 수 있게 생성합니다.

관련 연구

**객체 중심 학습 (OCL)**의 목표는 이미지에서 구성 가능한 객체 표현을 발견하여 체계적인 일반화와 강력한 시각적 추론을 가능하게 합니다. 원시 픽셀로부터 직접 학습하는 것은 어려우므로, 이전 연구들은 약한 감독 (예: 광학 흐름, 깊이, 텍스트, 사전 학습된 특징) 또는 슬롯 마스크를 움직이는 객체로 안내하는 보조 손실을 활용했습니다. OCL의 복잡한 데이터셋에 대한 확장도 주요 관심사였습니다: DINOSAUR은 자가 감독 특징을 재구성하여 실제 세계 이미지를 세분화했고, FT-DINOSAUR은 인코더 미세 조정을 통해 강력한 제로샷 이전을 확장했습니다. SLATE와 STEVE는 이산 VAE 토큰화를 결합하고 슬롯 조건 자동 회귀 변환기를 사용했으며, SPOT은 패치 순열 및 주의 기반 자기 학습을 통해 오토리그레시브 디코더를 개선했습니다. 우리의 연구는 SA에 근거하지만 추가적인 감독을 필요로 하지 않습니다.

확산 모델을 사용한 OCL. 최근 연구들은 확산 모델을 OCL의 슬롯 디코더로 활용했습니다. 다양한 방법들이 어떻게 확산 모델을 통합하는지를 달리합니다. 예를 들어, SlotDiffusion은 확산 모델을 처음부터 학습했으며, Stable-LSD, GLASS 및 SlotAdapt은 사전 학습된 확산 모델을 활용했습니다. 사전 학습된 모델은 강력한 생성 능력을 제공하지만 텍스트 조건화에 대한 편향이 종종 있습니다. 이를 해결하기 위해, GLASS는 크로스 주의 마스크를 가상 지상 참조로 사용하여 SA 학습을 안내했습니다. GLASS와 달리 CODA는 생성된 캡션과 같은 감독 신호에 의존하지 않습니다. SlotAdapt은 새로운 조건 신호를 가능하게 하면서 기본 확산 모델을 동결시킨 어댑터 계층을 도입했습니다. 대조적으로, CODA는 단순히 크로스 주의 층에서 키, 값 및 출력 프로젝션을 미세 조정하여 추가 계층 없이도 완전 호환성을 유지하면서 개념적 간결성과 연산 효율성을 보장합니다.

OCL에 대한 대조 학습. 재구성 손실만으로 SA를 학습하는 것은 종종 불안정하거나 일관되지 않은 결과를 초래합니다. 이를 개선하기 위해 여러 연구들은 대조적 목적을 도입했습니다. 예를 들어, SlotCon은 입력 이미지의 증강된 뷰 사이에 InfoNCE 손실을 적용하여 슬롯 일관성을 강제했습니다. 비슷하게 다른 연구는 동영상 객체 중심 모델에서 시간적 일관성을 강제하기 위해 대조 손실을 사용했습니다. 그러나 CODA는 이미지와 그 슬롯 표현 간의 정합성으로 조합성을 해결하며, 개별 슬롯과 그것들의 조합에서 신뢰할 수 있는 생성이 가능합니다. CODA는 무작위 슬롯 혼합에 대한 확률을 직접 최대화하지 않으므로 조합적 생성에 대한 직접적인 튜닝은 하지 않습니다; 대신 슬롯-이미지 정합성을 강제함으로써 간접적으로 조합성의 이점을 얻습니다. CODA는 부정 손실 항을 사용하지만, 확산 모델에서의 부정 유도와 그 역할은 본질적으로 다릅니다.

배경

슬롯 주의 (SA). 이미지의 입력 특징 $`\{\mathbf{f}}\in \mathbb{R}^{M\times D_\mathrm{input}}`$을 제공하면, OCL의 목표는 $`N`$ 슬롯으로 구성된 시퀀스 $`\{\mathbf{s}}\in \mathbb{R}^{N \times D_{\mathrm{slot}}}`$를 추출하는 것입니다. 각 슬롯은 조합 가능한 개념을 나타내는 $`D_{\mathrm{slot}}`$ 차원의 벡터입니다. SA에서, 우리는 무작위로 초기화된 슬롯 $`\{\mathbf{s}}^{(0)} \in \mathbb{R}^{N\times D_\mathrm{slot}}`$으로 시작합니다. 초기화 후, SA는 반복 메커니즘을 사용해 슬롯을 세밀하게 조정합니다. 특히, 슬롯은 쿼리로 작용하고 입력 특징은 키와 값으로 작용합니다. $`q`$, $`k`$ 및 $`v`$는 주의 계산에서 각각 사용되는 선형 프로젝션을 나타냅니다. 현재 슬롯 $`\{\mathbf{s}}^{(t)}`$과 입력 특징 $`\{\mathbf{f}}`$가 주어졌을 때, 업데이트 규칙은 다음과 같습니다.

\begin{align*}

{\mathbf{s}}^{(t + 1)} = \mathtt{GRU} ({\mathbf{s}}^{(t)}, {{\mathbf{u}}^{(t)}}) \quad \text{where} \quad {\mathbf{u}}^{(t)} = \mathtt{Attention}(q({\mathbf{s}}^{(t)}), k({\mathbf{f}}), v({\mathbf{f}})) \,. %\rvm^{(t)}=\mathtt{softmax}(q(\rvs^{(t)})\dot k(\rvf)^\top/\,.

\end{align*}

여기서 주의 읽기는 게이트된 순환 유닛 (GRU)을 통해 집계되고 세밀하게 조정됩니다. SA에서와 같이 $`\mathtt{softmax}`$ 함수는 슬롯 축을 따라 적용되어 슬롯 간 경쟁을 강제합니다. 이 반복 과정은 여러 단계 동안 수행되며, 마지막 반복의 슬롯이 최종 슬롯 표현으로 취급됩니다. 마지막으로 이러한 슬롯들은 입력 이미지를 재구성하도록 학습된 디코더로 전달됩니다. 슬롯 디코더는 다양한 형태를 가질 수 있으며, 최근 연구에서는 (잠재) 확산 모델을 슬롯 디코더로 사용하는 것이 특히 강력하고 효과적임이 입증되었습니다.

잠재 확산 모델 (LDMs). 확산 모델은 점차적으로 가우시안 노이즈를 제거함으로써 데이터 샘플링을 수행하는 확률적 모델입니다. 전방 과정에서는 데이터가 점진적으로 가우시안 노이즈로 오염되며, 역방 과정에서는 노이즈 제거와 원래 신호의 복원을 학습합니다. 효율성을 향상시키기 위해 SD는 픽셀 공간 대신 압축된 잠재 공간에서 이 프로세스를 수행합니다. 구체적으로, 사전 학습된 오토인코더가 이미지를 잠재 벡터 $`\{\mathbf{z}}\in \mathcal{Z}`$로 매핑하고, U-Net 디노이저는 노이즈 잠재물을 반복적으로 세밀하게 조정합니다. 신호 $`\{\mathbf{z}}`$와 가우시안 노이즈 $`\{{\boldsymbol{\epsilon}}\sim \mathcal{N}(0, \mathbf{I})`$를 혼합하는 변동량 보존 과정을 고려하면 다음과 같습니다.

{\mathbf{z}}_\gamma = \sqrt{\sigma(\gamma)} {\mathbf{z}}+ \sqrt{\sigma(-\gamma)} {\boldsymbol{\epsilon}}

여기서 $`\sigma(.)`$는 시그모이드 함수이고, $`\gamma`$는 로그 신호-노이즈 비율입니다. 또한 $`\{{\boldsymbol{\epsilon}}_{\boldsymbol{\theta}}({\mathbf{z}}_\gamma, \gamma, {\mathbf{c}})`$은 조건부 신호 $`\{{\mathbf{c}}`$에 의해 조건화된 노이지 잠재물 $`\{{\mathbf{z}}_\gamma`$에서 가우시안 노이즈 $`\{{\boldsymbol{\epsilon}}`를 예측하는 디노이저입니다. SD에서는 크로스 주의를 통해 조건부 신호와 U-Net으로 생성된 특징 사이의 주의를 계산합니다. 확산 모델 학습은 진정한 노이즈 $\{{\boldsymbol{\epsilon}}가 추가되는 전방 과정을 예측하는 문제로 포뮬레이션됩니다.

\min_{{\boldsymbol{\theta}}} \quad \mathbb{E}_{({\mathbf{z}}, {\mathbf{c}}), {\boldsymbol{\epsilon}}, \gamma} \left[ \| {\boldsymbol{\epsilon}}- {\boldsymbol{\epsilon}}_{\boldsymbol{\theta}}({\mathbf{z}}_\gamma, \gamma, {\mathbf{c}})\|^2_2 \right]

여기서 $`\{{\mathbf{z}}, {\mathbf{c}})`$는 데이터 분포 $`p({\mathbf{z}}, {\mathbf{c}})`$에서 샘플됩니다. 학습이 완료되면, 무작위 가우시안 노이즈로부터 샘플링을 시작하고 훈련된 디노이저를 사용해 반복적으로 세밀하게 조정합니다.

제안 방법

2에서 요약된 것처럼, CODA는 확산 기반 OCL을 통해 DINOv2 특징으로부터 SA를 사용해 슬롯 시퀀스를 추출하고 사전 학습된 SD v1.5로 디코딩합니다. 슬롯 얽힘과 약한 정합성 문제를 해결하기 위해 CODA는 세 가지 구성 요소를 도입했습니다: (i) 잔여 주의를 흡수하고 객체 슬롯을 분리하는 등록 슬롯, (ii) 텍스트 조건화 편향 감소를 위한 크로스 주의 키와 쿼리 미세 조정, 및 (iii) 이미지와 그 슬롯 간의 정합성을 명시적으로 강제하는 대조 정렬 손실. 이러한 수정을 통해 분리되고 잘 정합된 슬롯이 생성되어 신뢰할 수 있는 단일 슬롯 생성과 조합적 편집이 가능합니다.