임베딩 일관성 규제로 소형 언어 모델의 의미 구조 보존

📝 원문 정보

- Title: ECR: Manifold-Guided Semantic Cues for Compact Language Models

- ArXiv ID: 2601.00543

- 발행일: 2026-01-02

- 저자: Chung-Wei Victor Yuan

📝 초록 (Abstract)

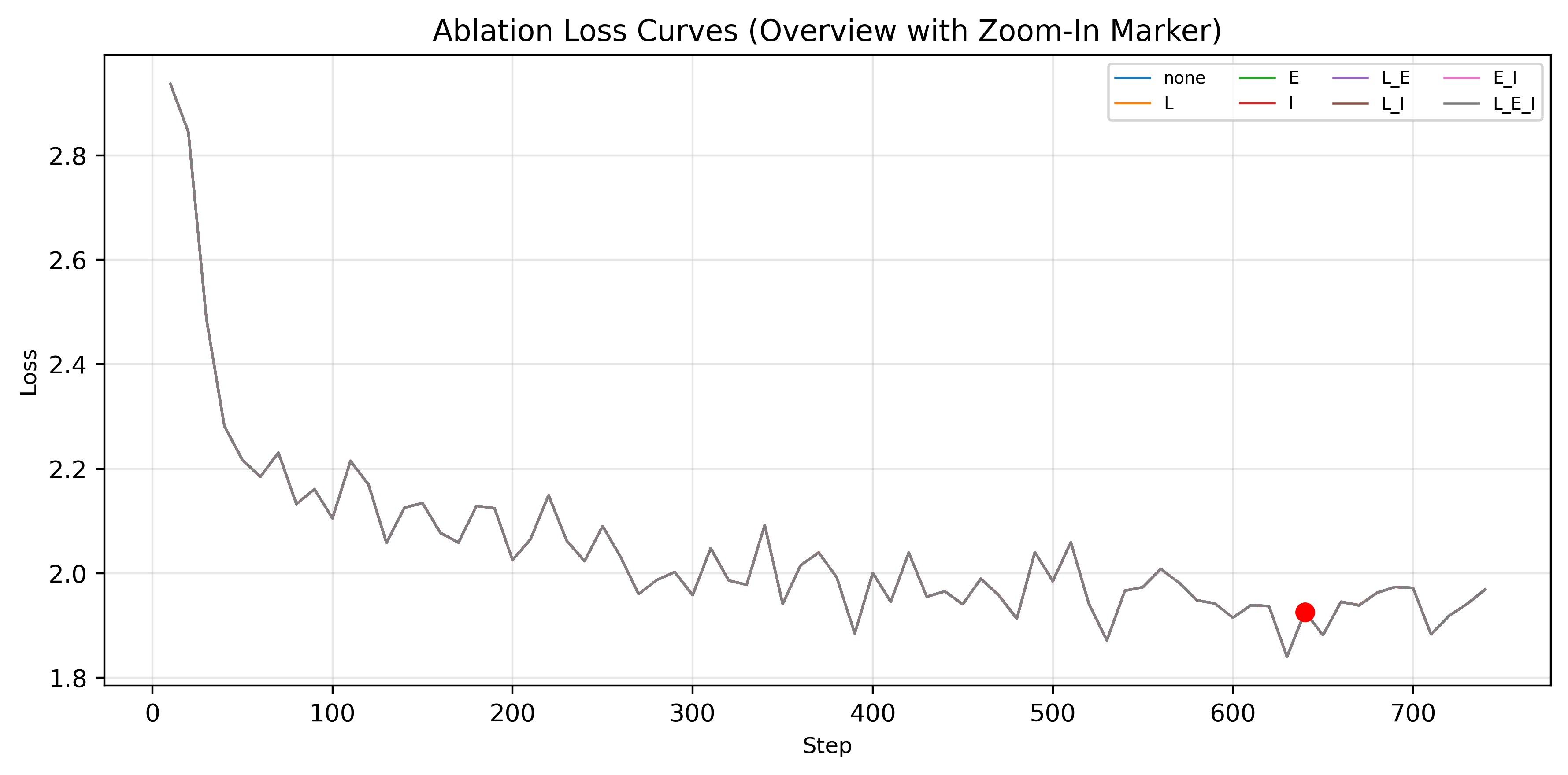

소형 모델은 용량이 제한되거나 다언어 데이터를 다룰 때 임베딩 공간의 구조가 붕괴되는 경향이 있다. 기존 압축 기법은 출력 로짓이나 내부 특징을 맞추는 데 초점을 맞추지만, 근본적인 매니폴드 구조를 유지하지 못한다. 본 연구는 교사 모델의 임베딩으로부터 의미 앵커를 사전에 추출하고, 압축 모델이 이 앵커 주변의 기하학적 일관성을 학습하도록 하는 Embedding Consistency Regulation(ECR) 프레임워크를 제안한다. ECR은 추론 단계에서 작은 투영만 추가하고 디코딩 구조나 실행 속도에는 영향을 주지 않는다. 10만 문장의 다국어 코퍼스 실험에서 ECR은 학습 안정성을 높이고, 다양한 작업·언어에 걸쳐 의미 구조를 보존한다. 또한 교사 출력이 필요 없으며, 기존 지식증류와 병행해도 독립적으로 작동한다. 결과적으로 ECR은 저용량 모델이 더 정돈된 매니폴드를 학습하도록 도와, 효율·프라이버시 제약이 엄격한 환경에서의 배포를 용이하게 만든다.💡 논문 핵심 해설 (Deep Analysis)

전통적인 모델 압축 방법—가중치 프루닝, 양자화, 지식증류 등—은 주로 출력 로짓이나 중간 레이어의 활성값을 교사 모델과 맞추는 것을 목표로 한다. 이러한 접근은 “표면적인” 일치만을 보장하고, 임베딩 공간의 기하학적 토폴로지를 보존하지 못한다. 결과적으로 압축 모델은 교사 모델과 동일한 예측 정확도를 보일 수 있으나, 내부 표현은 완전히 다른 형태로 재구성된다. 이는 특히 다언어 상황에서 “언어 간 정렬”이 깨지는 원인이 된다.

ECR은 이 한계를 극복하기 위해 두 단계의 전략을 채택한다. 첫째, 교사 모델의 임베딩을 한 번 오프라인으로 계산해 의미 앵커 집합을 만든다. 이 앵커는 고차원 공간에서 의미적으로 대표적인 포인트(예: 빈도 높은 단어, 핵심 문장)이며, …