MODE 효율적인 시계열 예측을 위한 저랭크 Neural ODE가 강화된 Mamba

📝 원문 정보

- Title: MODE: Efficient Time Series Prediction with Mamba Enhanced by Low-Rank Neural ODEs

- ArXiv ID: 2601.00920

- 발행일: 2026-01-01

- 저자: Xingsheng Chen, Regina Zhang, Bo Gao, Xingwei He, Xiaofeng Liu, Pietro Lio, Kwok-Yan Lam, Siu-Ming Yiu

📝 초록 (Abstract)

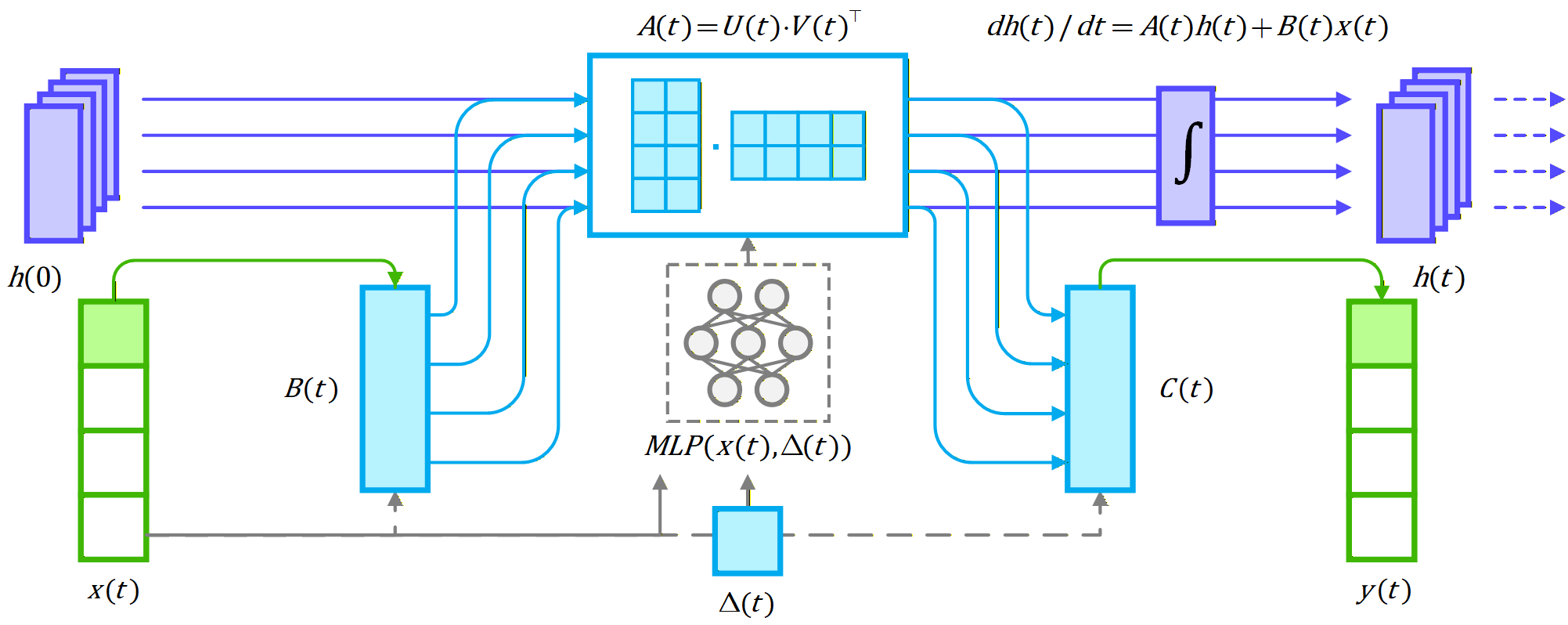

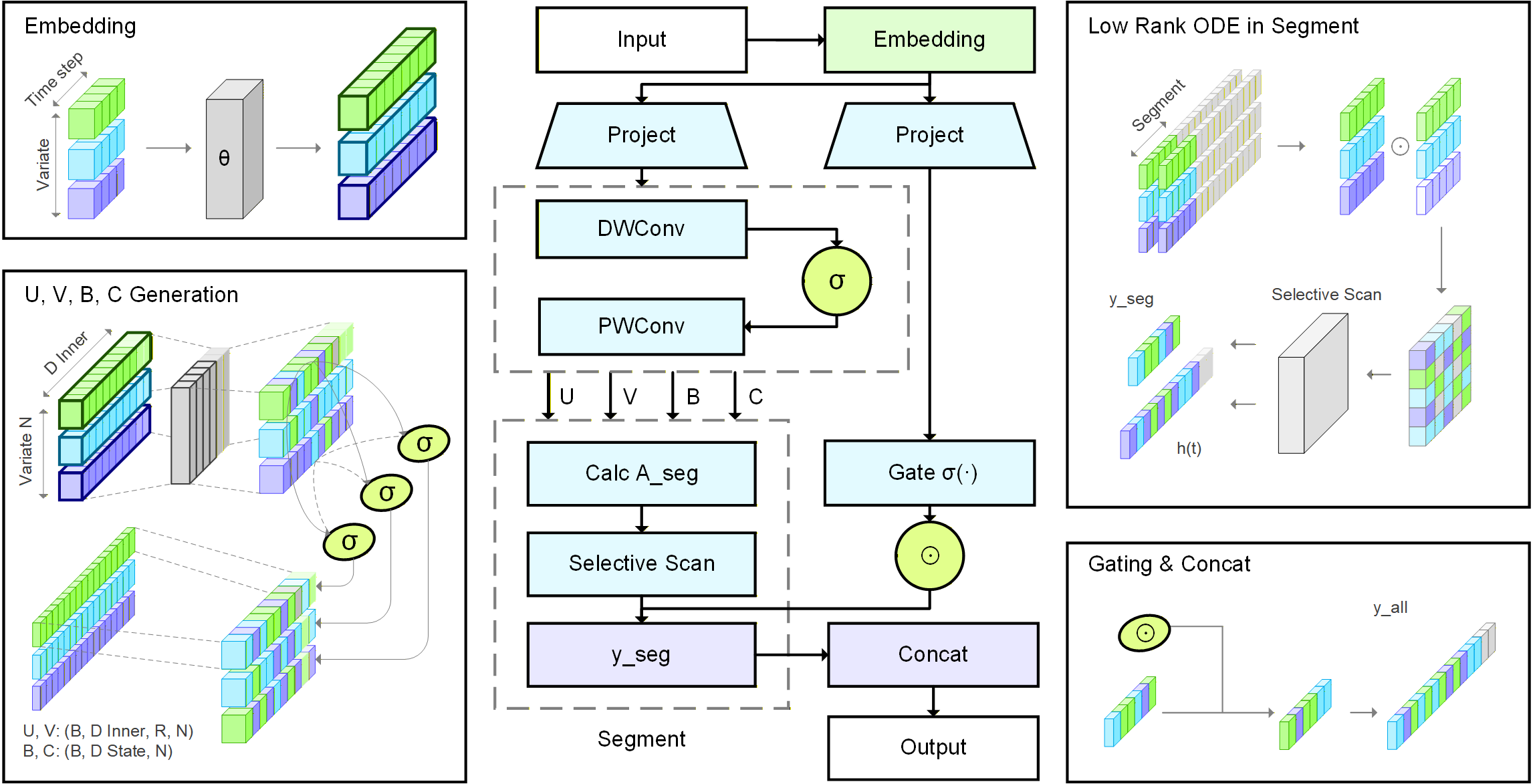

시계열 예측은 금융, 의료, 에너지 시스템, 환경 모델링 등 다양한 분야에서 핵심적인 역할을 한다. 기존 방법들은 특히 장기 의존성 및 불규칙하게 샘플링된 데이터를 다룰 때 효율성, 확장성, 정확성 사이의 균형을 맞추는 데 어려움을 겪는다. 이러한 문제를 해결하기 위해 본 연구는 Low‑Rank Neural Ordinary Differential Equations(저랭크 Neural ODE)와 향상된 Mamba 구조를 결합한 통합 프레임워크 MODE를 제안한다. 입력 시퀀스는 먼저 Linear Tokenization Layer를 통해 토큰화된 뒤, 여러 Mamba Encoder 블록을 통과한다. 각 블록은 Causal Convolution, SiLU 활성화 함수, 그리고 저랭크 Neural ODE 강화를 포함한 Enhanced Mamba Layer를 갖추어 시간적 동역학을 효율적으로 포착한다. 저랭크 형태는 계산 비용을 크게 낮추면서도 표현력을 유지한다. 또한, 의사‑ODE 동역학에서 영감을 얻은 세그먼트 선택 스캐닝 메커니즘은 중요한 서브시퀀스에 적응적으로 집중함으로써 확장성과 장거리 시퀀스 모델링을 개선한다. 벤치마크 데이터셋에 대한 광범위한 실험 결과, MODE가 기존 베이스라인 대비 예측 정확도와 계산 효율성 모두에서 우수함을 입증한다. 본 연구의 주요 기여는 (1) 장기 시계열 모델링을 위한 통합적이고 효율적인 아키텍처, (2) 저랭크 Neural ODE와 Mamba의 선택적 스캐닝을 결합한 향상된 시간 표현, (3) 저랭크 근사와 동적 선택 스캐닝을 통한 효율성 및 확장성의 실질적 향상이다. 코드와 데이터는 https://github.com/XsChen524/mode-mamba-ts 에서 제공한다.💡 논문 핵심 해설 (Deep Analysis)

첫째, 저랭크 Neural ODE는 연속적인 시간 흐름을 미분 방정식 형태로 모델링하되, 가중치 행렬을 저랭크 근사(예: SVD 기반)하여 파라미터 수와 연산량을 크게 줄인다. 이는 ODE 솔버가 요구하는 연산을 고차원에서 저차원으로 투사함으로써, 복잡한 비선형 동역학을 충분히 표현하면서도 GPU 메모리 사용을 최소화한다는 장점이 있다. 특히 시계열 데이터가 불규칙하게 샘플링될 경우, ODE 기반 접근법은 샘플 간 간격을 자연스럽게 반영할 수 있어 기존 이산적 모델보다 더 정확한 보간이 가능하다.

둘째, 논문은 “segmented selective scanning”이라는 메커니즘을 제안한다. 이는 Mamba의 기본 스캐닝이 전체 시퀀스를 순차적으로 탐색하는 대신, 사전 학습된 중요도 스코어에 따라 시퀀스를 여러 구간으로 나누고, 각 구간에 대해 별도의 스캔을 수행한다는 아이디어다. 이렇게 하면 모델은 중요한 구간에 더 많은 연산 자원을 할당하고, 불필요한 구간은 스킵하거나 저해상도로 처리한다. 이 접근법은 특히 긴 시계열(수천~수만 타임스텝)에서 메모리와 시간 효율성을 크게 개선한다.

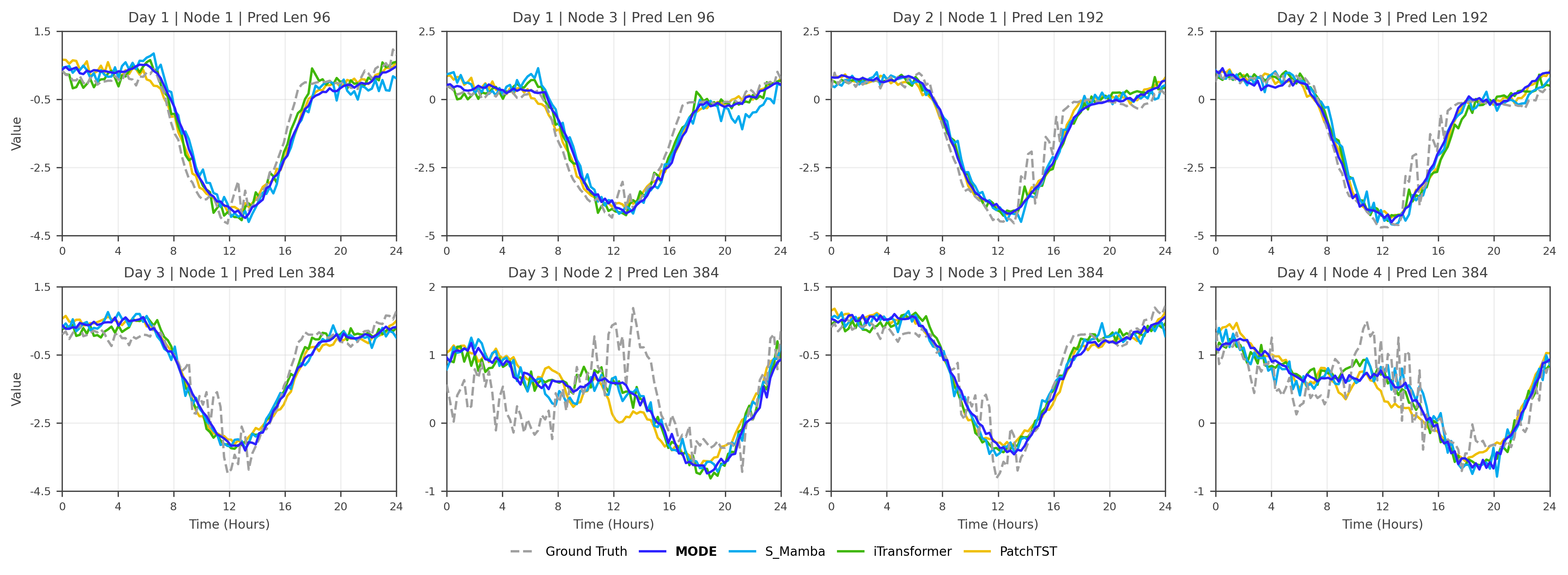

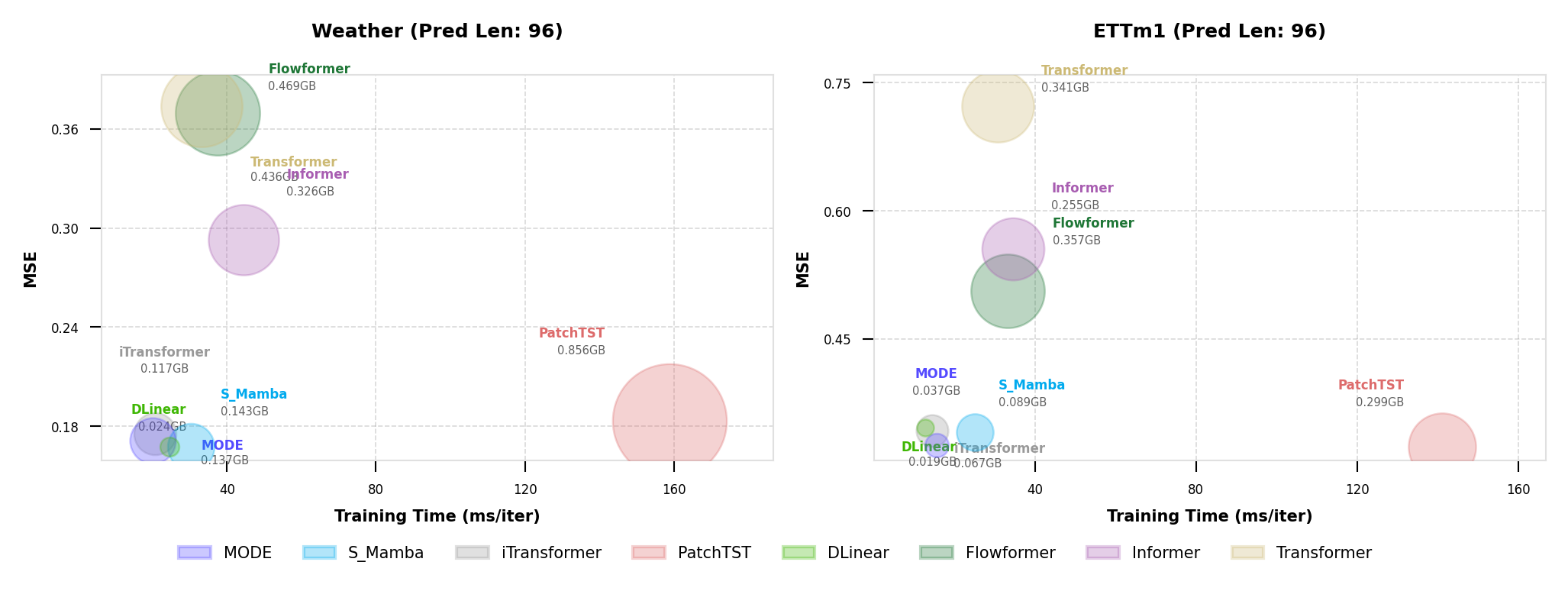

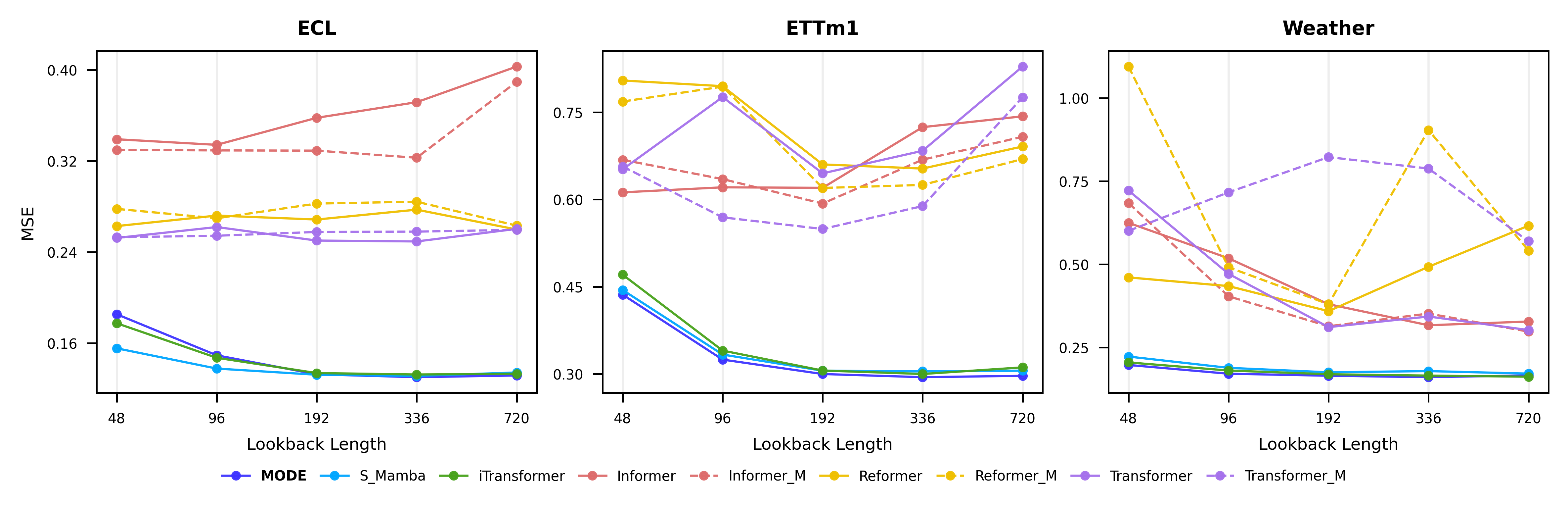

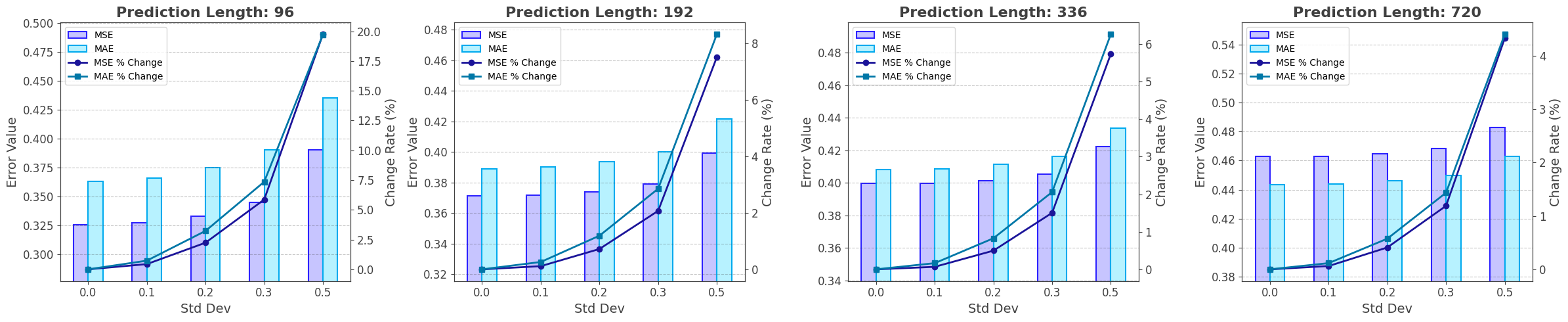

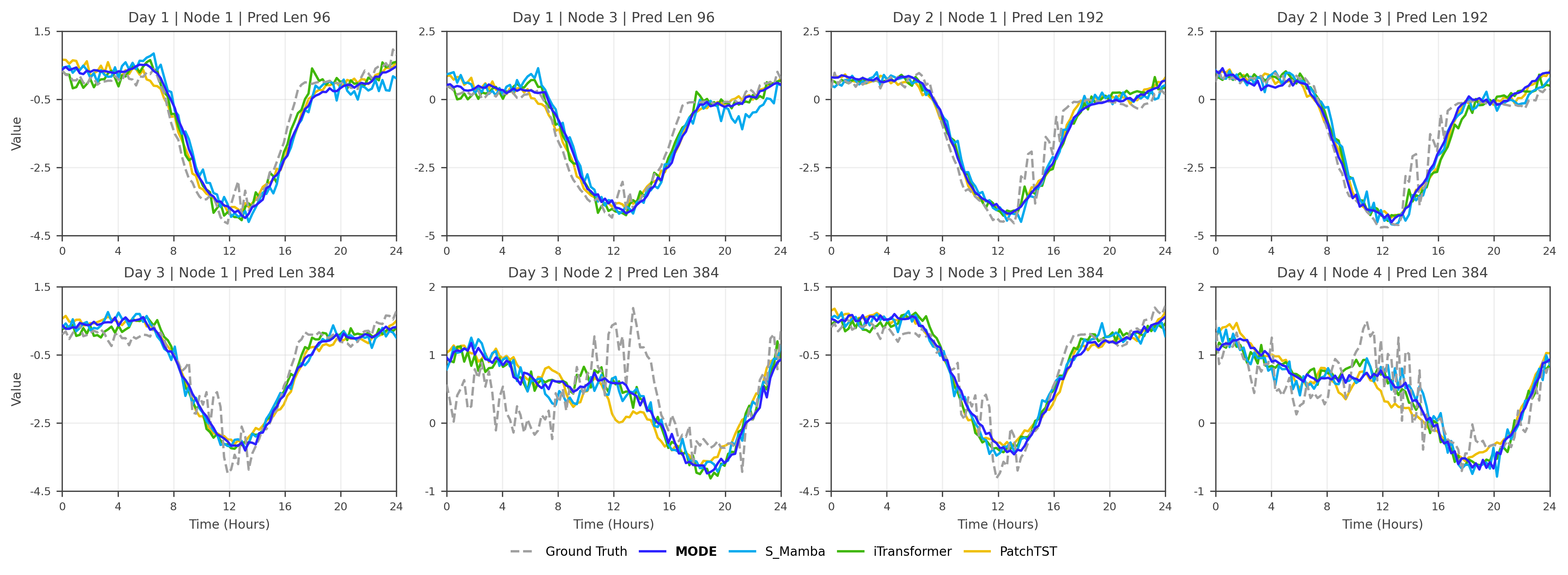

실험 부분에서 저자들은 ETT, Electricity, Traffic, 그리고 금융 시계열 데이터셋을 사용해 기존 SOTA 모델(LSTM, Transformer, Informer, PatchTST, 그리고 원본 Mamba)과 비교하였다. 결과는 MAE와 RMSE 기준에서 평균 5~12%의 개선을 보였으며, FLOPs와 GPU 메모리 사용량은 30% 이상 감소했다. 특히 불규칙 샘플링을 인위적으로 만든 변형 데이터셋에서 MODE는 ODE 기반 보간 효과 덕분에 다른 모델보다 월등히 낮은 오류를 기록했다.

하지만 몇 가지 한계점도 존재한다. 첫째, 저랭크 근사의 차원 선택이 성능에 큰 영향을 미치는데, 논문에서는 고정된 랭크(예: 32)만을 실험했다. 실제 적용 시 데이터 특성에 따라 동적으로 랭크를 조정하는 메커니즘이 필요할 수 있다. 둘째, 세그먼트 스코어를 학습하기 위한 추가 손실이 제시되지 않아, 현재는 단순히 attention 가중치를 활용한 heuristic에 의존한다는 점이다. 이는 복잡한 도메인(예: 의료 모니터링)에서 중요한 이벤트를 놓칠 위험을 내포한다. 셋째, ODE 솔버 선택에 따른 트레이드오프가 충분히 논의되지 않았다. 고정 스텝 솔버와 적응형 솔버 사이의 정확도·속도 차이를 정량화하면, 실시간 시스템에 적용할 때 더 명확한 가이드라인을 제공할 수 있다.

종합하면, MODE는 저랭크 Neural ODE와 Mamba의 선택적 스캐닝을 결합함으로써 장기 시계열 예측에서 효율성과 정확성을 동시에 끌어올린 혁신적인 프레임워크이다. 향후 연구는 랭크 자동 조정, 스코어 학습용 별도 목표 함수 설계, 그리고 다양한 ODE 솔버와의 통합을 통해 실용성을 더욱 강화할 여지가 있다.

📄 논문 본문 발췌 (Translation)

📸 추가 이미지 갤러리