인공지능과 인간의 협업으로 똑똑한 재고 관리 구현

📝 원문 정보

- Title: Ask, Clarify, Optimize: Human-LLM Agent Collaboration for Smarter Inventory Control

- ArXiv ID: 2601.00121

- 발행일: 2025-12-31

- 저자: Yaqi Duan, Yichun Hu, Jiashuo Jiang

📝 초록 (Abstract)

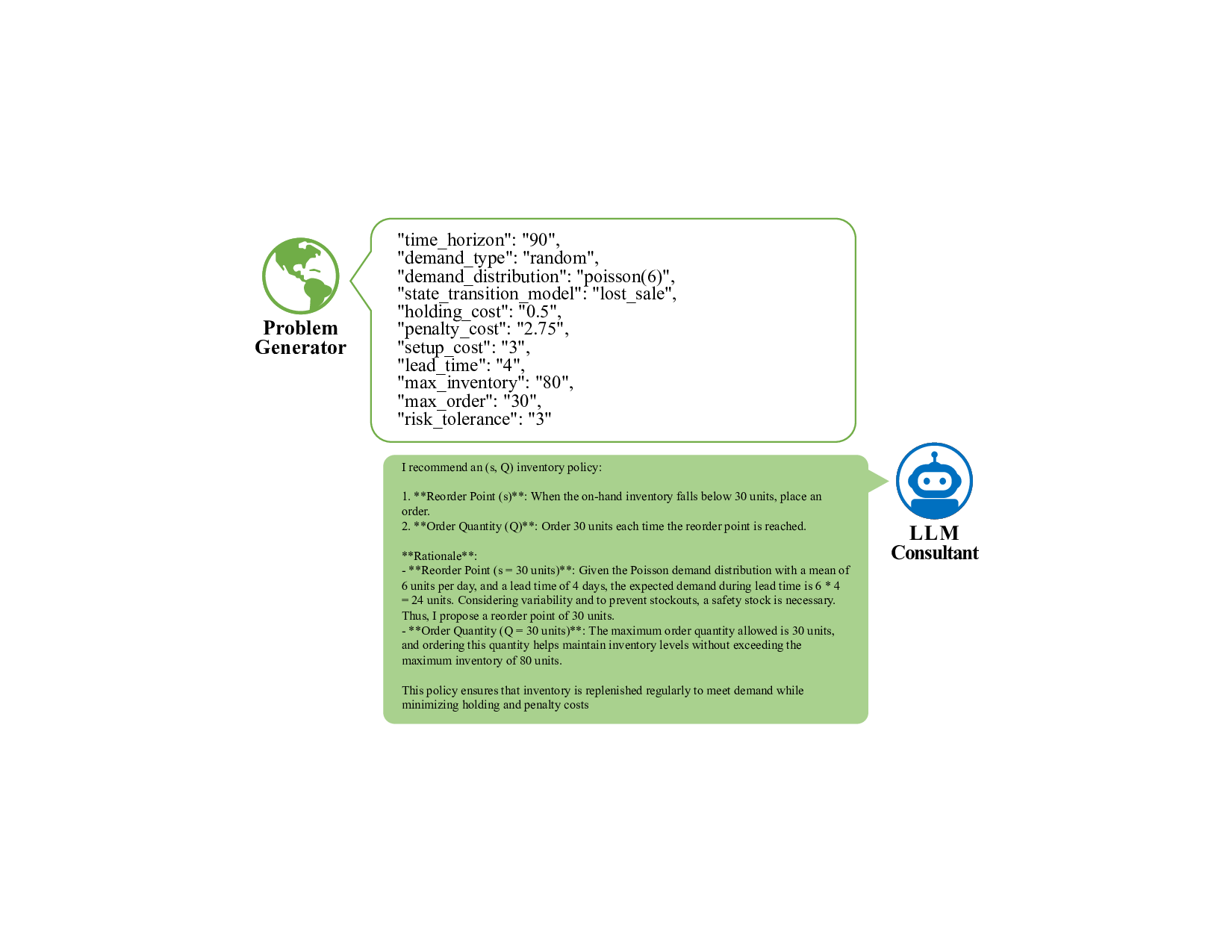

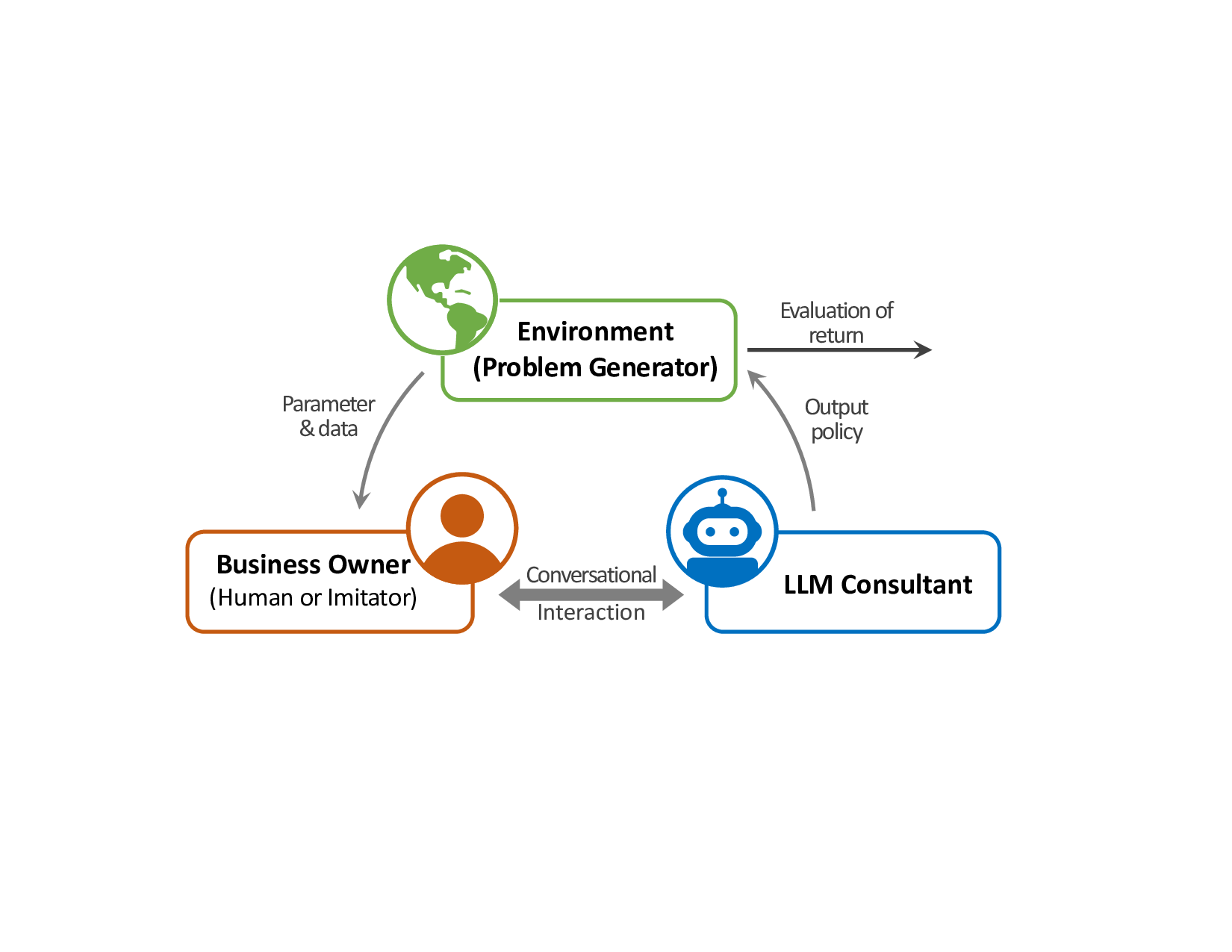

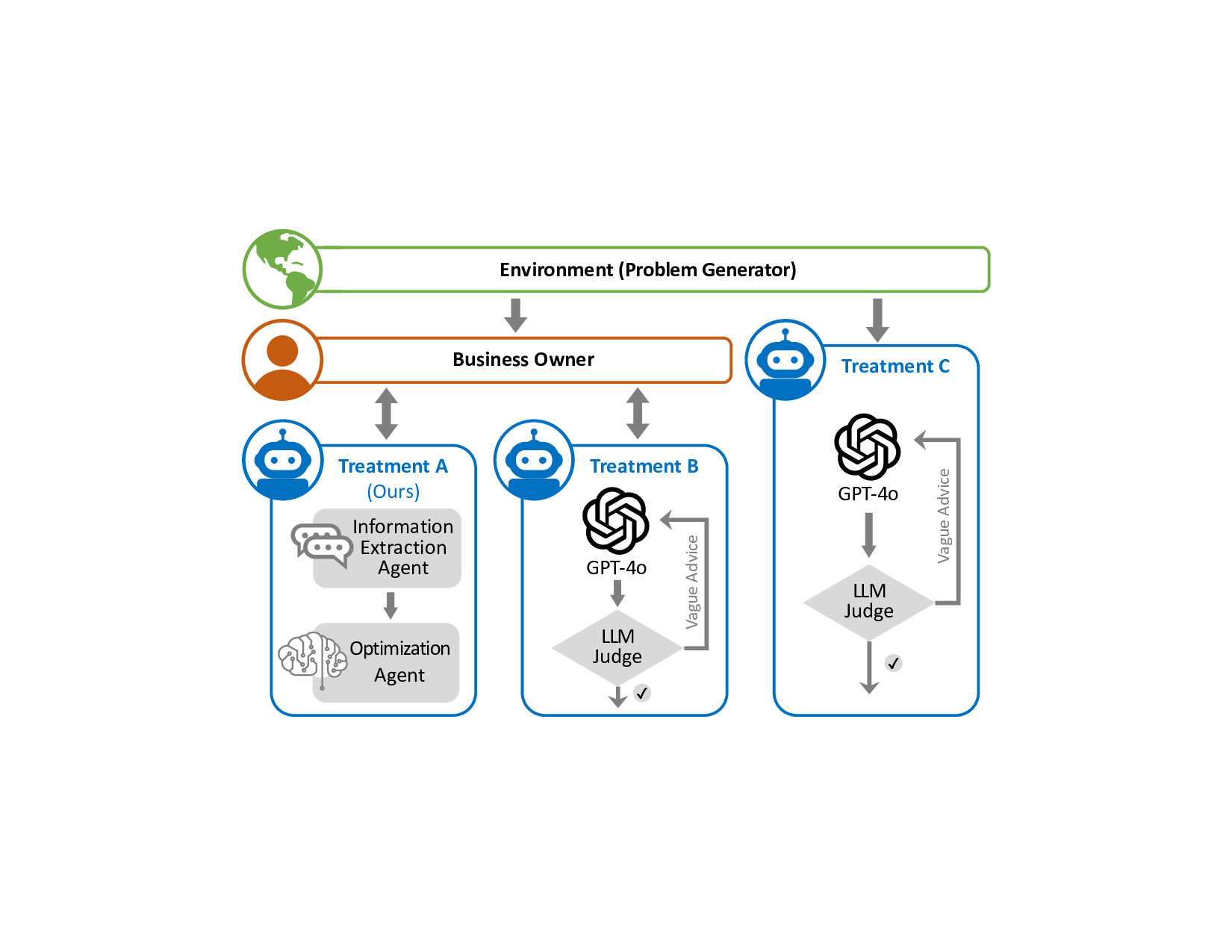

재고 관리가 전문적인 최적화 기법을 도입하기 어려운 중소기업에 여전히 큰 과제로 남아 있다. 본 연구는 대형 언어 모델(LLM)이 이 격차를 메울 수 있는지를 탐구한다. LLM을 직접적인 종단‑to‑종단 솔버로 활용할 경우, 모델이 근거 없는 확률적 추론을 수행하지 못해 발생하는 ‘환각 비용(hallucination tax)’이 크게 나타난다. 이를 극복하기 위해 의미적 추론과 수학적 계산을 엄격히 분리하는 하이브리드 에이전트 프레임워크를 제안한다. 이 구조에서 LLM은 자연어로부터 파라미터를 추출하고 결과를 해석하는 지능형 인터페이스 역할을 수행하며, 실제 최적화 엔진은 검증된 알고리즘이 자동으로 호출한다. 실제 관리자의 모호하고 일관되지 않은 대화를 재현하기 위해, 제한된 합리성을 가진 관리자를 디지털 트윈화한 ‘Human Imitator’를 미세조정하여 확장 가능한 스트레스 테스트 환경을 구축하였다. 실험 결과, 하이브리드 에이전트 프레임워크는 종단‑to‑종단 솔버인 GPT‑4o 기반 인터랙티브 베이스라인 대비 총 재고 비용을 32.1 % 감소시켰다. 또한, 완전한 정답 정보를 제공해도 GPT‑4o의 성능 향상이 제한되는 것으로 나타나, 병목 현상이 정보가 아니라 계산 능력에 있음을 확인하였다. 본 연구는 LLM을 운영 연구(OR) 기법의 대체가 아니라, 비전문가가 엄격한 솔버 기반 정책에 접근하도록 돕는 자연어 인터페이스로 위치시킨다.💡 논문 핵심 해설 (Deep Analysis)

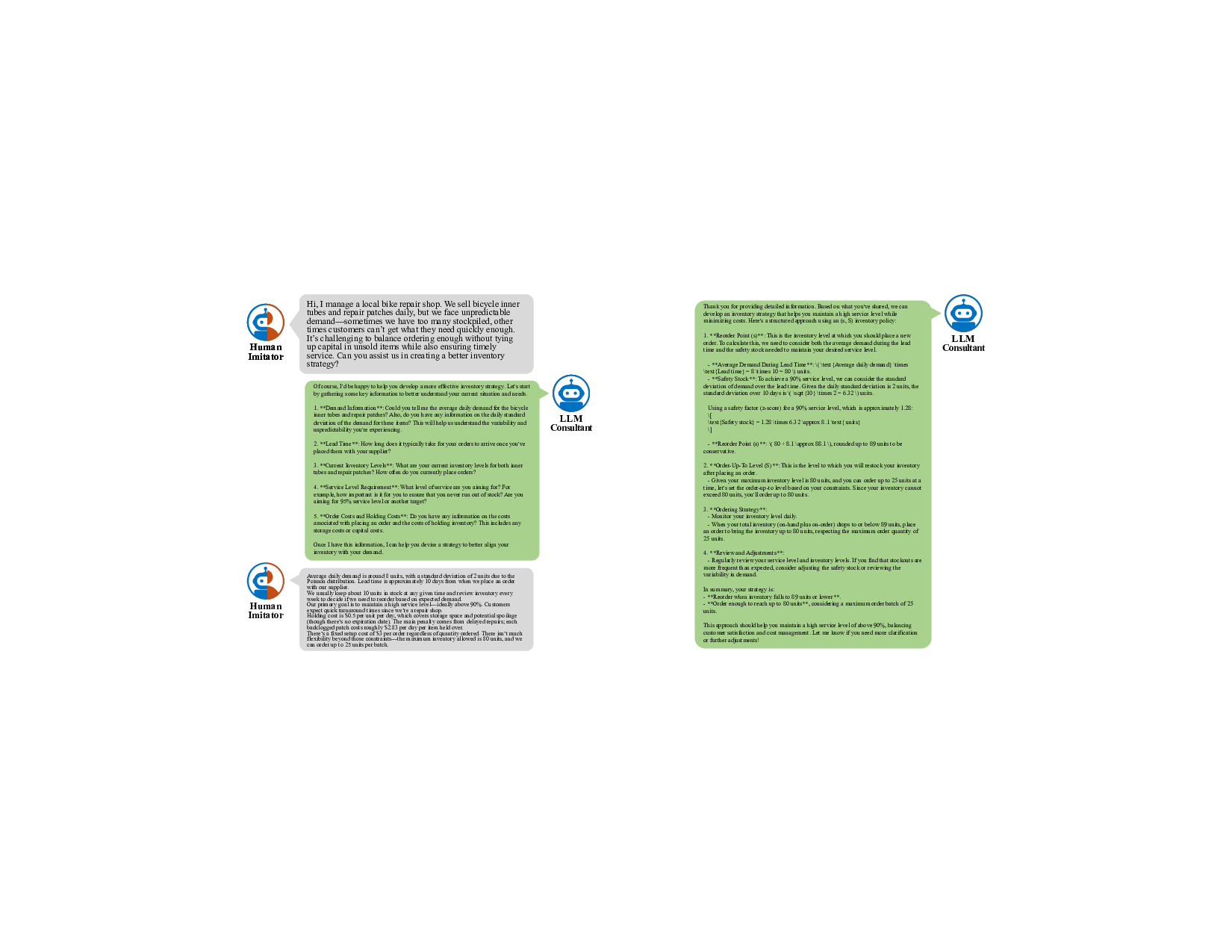

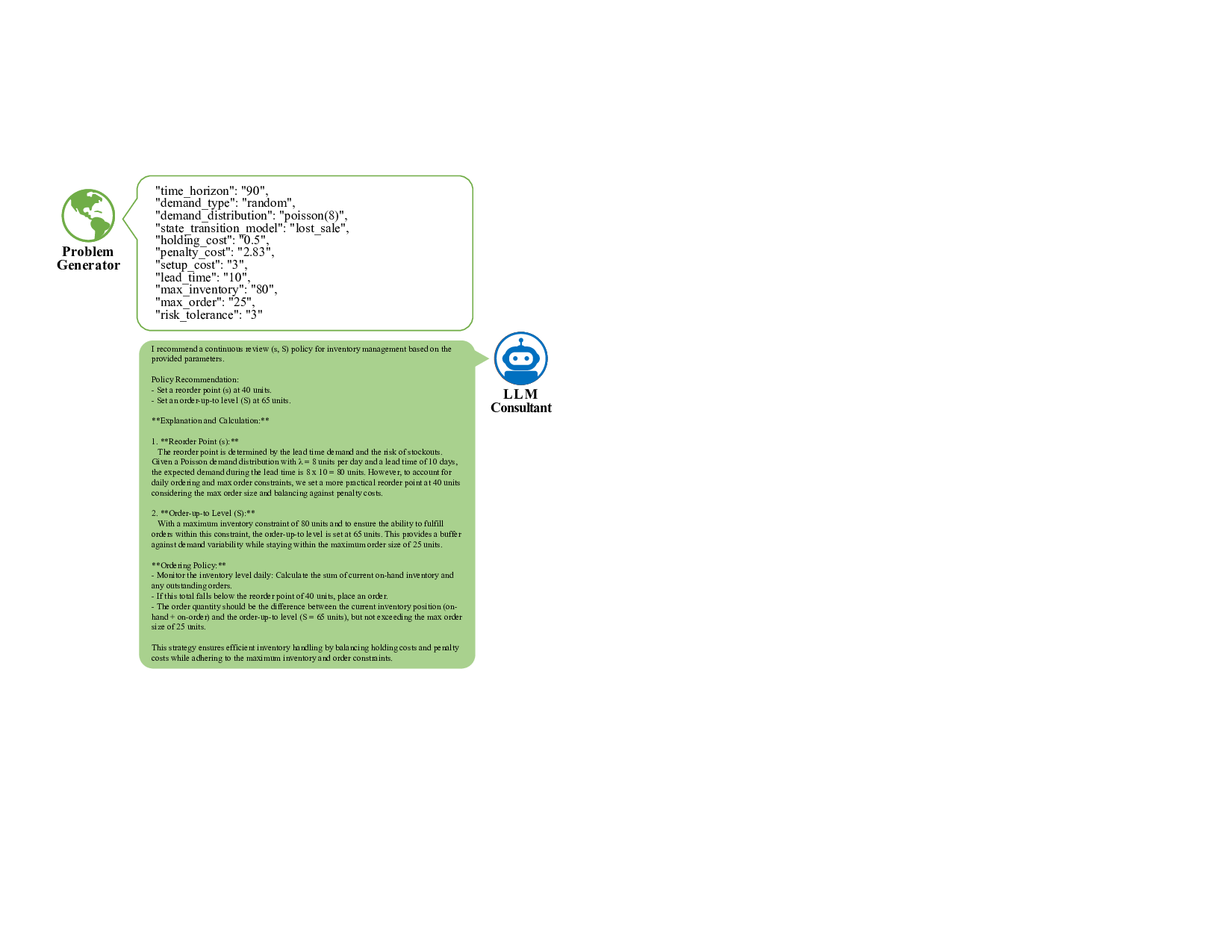

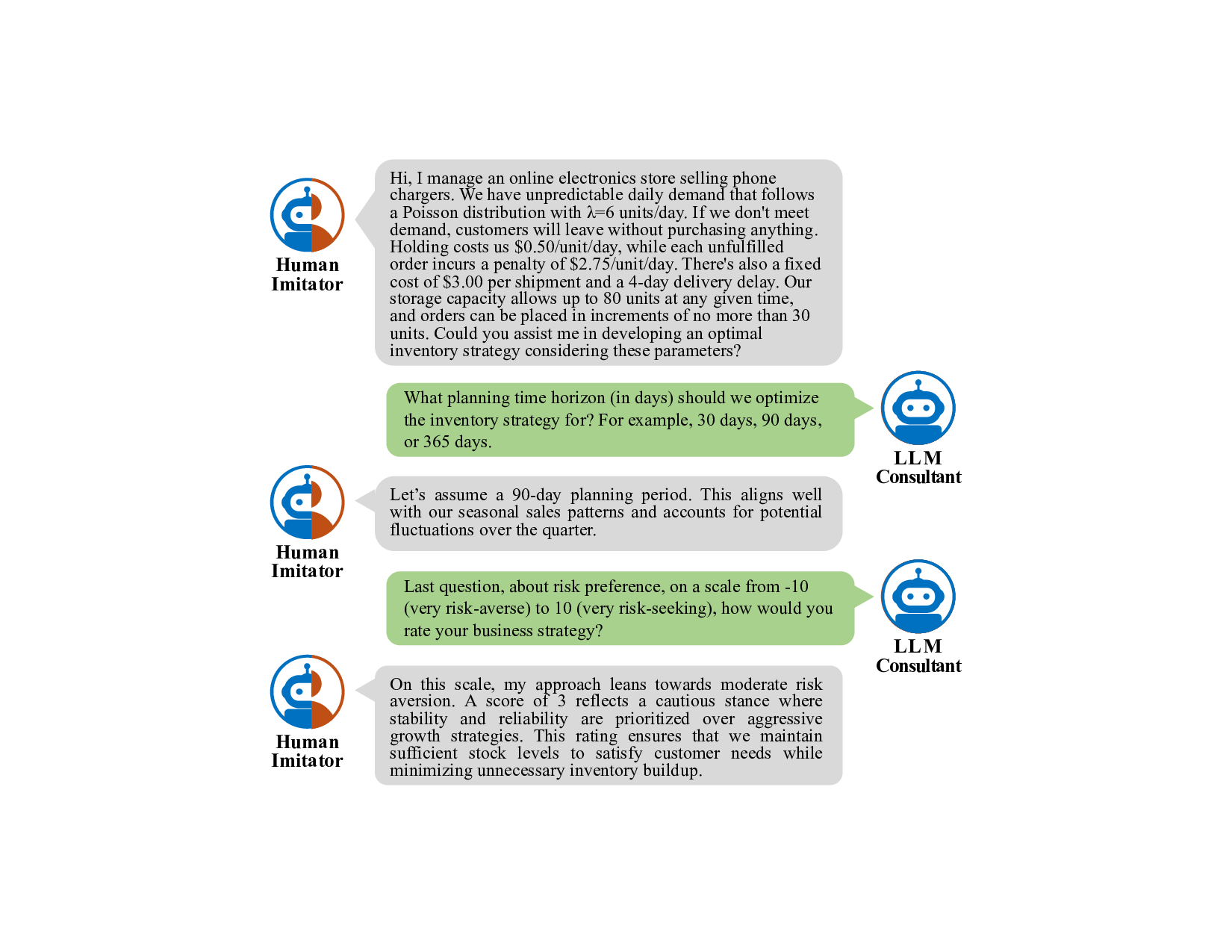

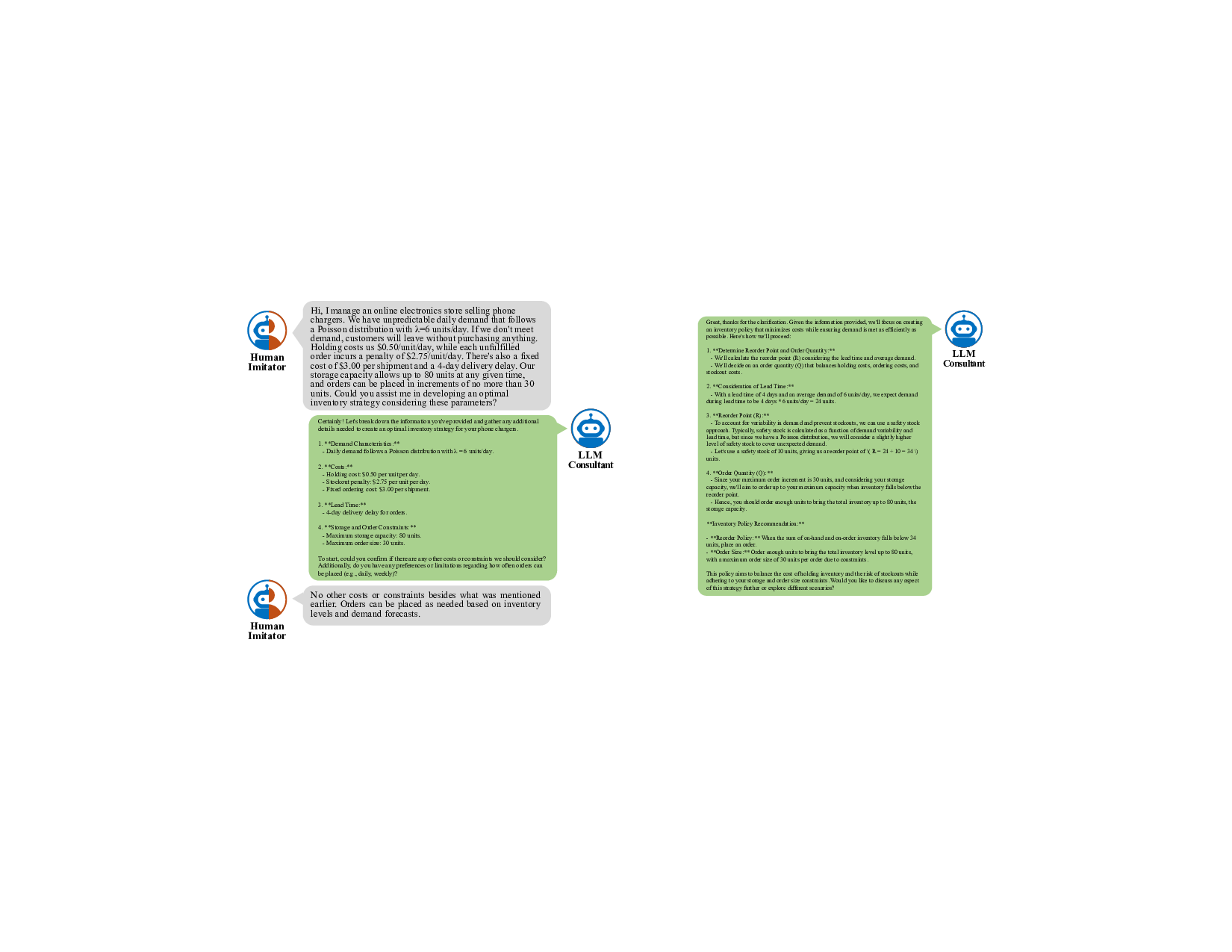

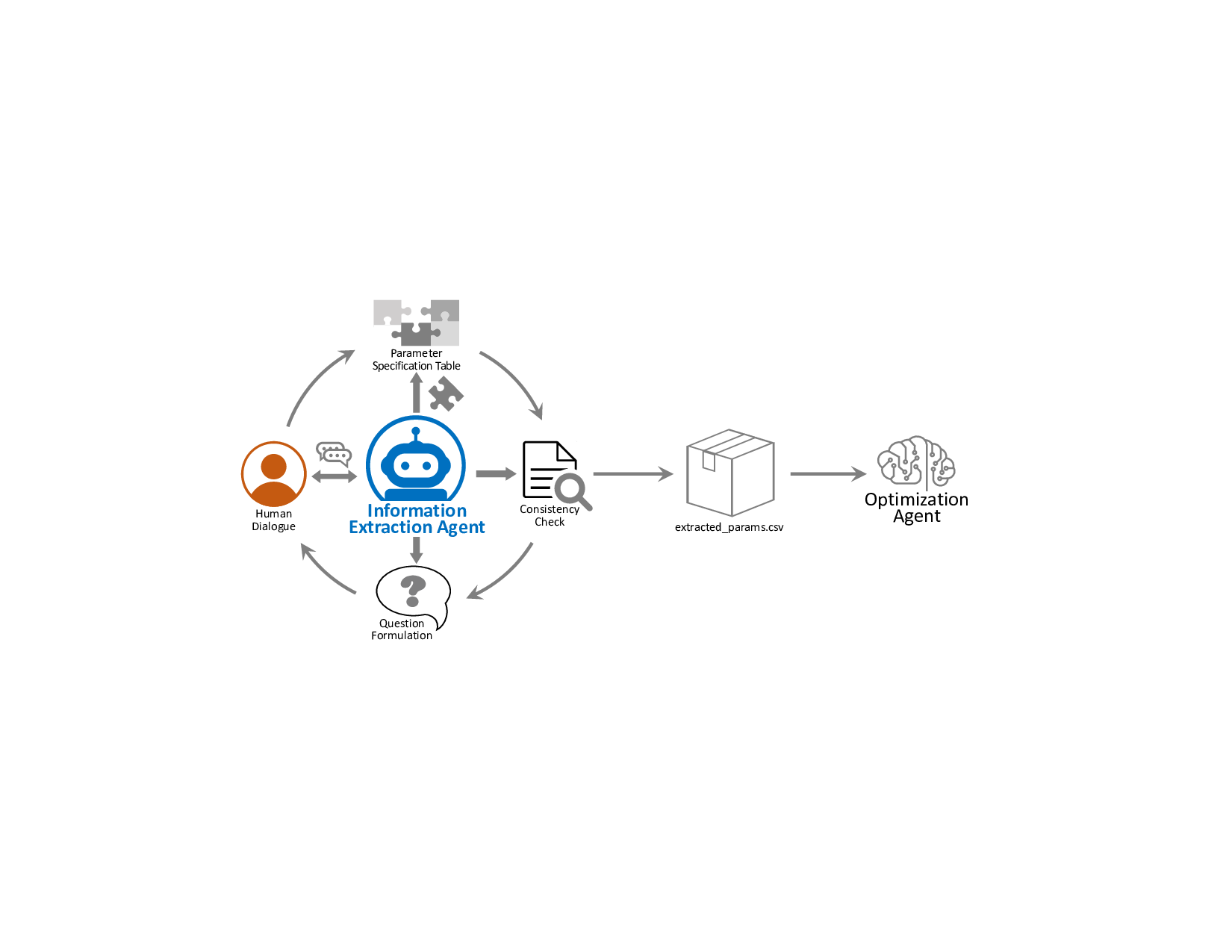

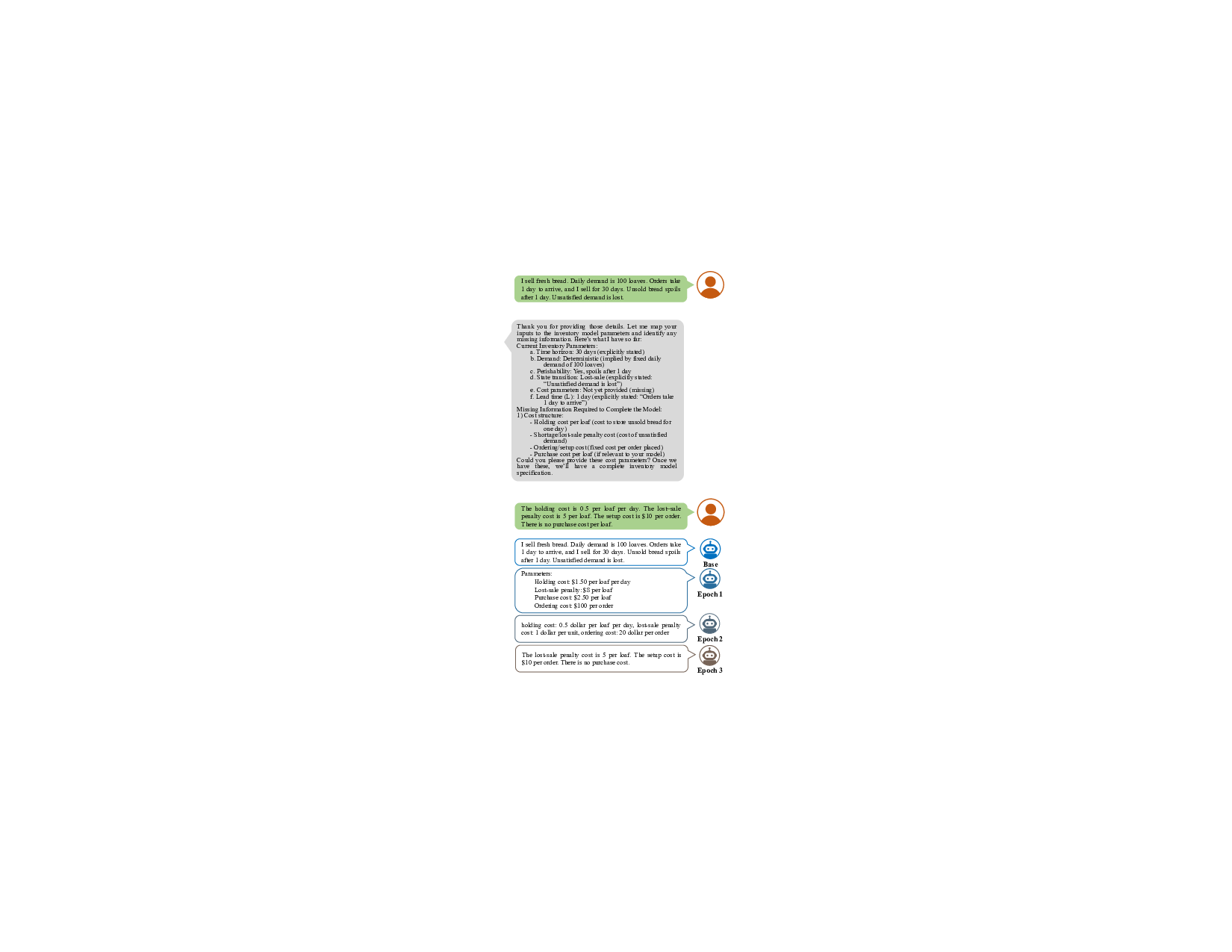

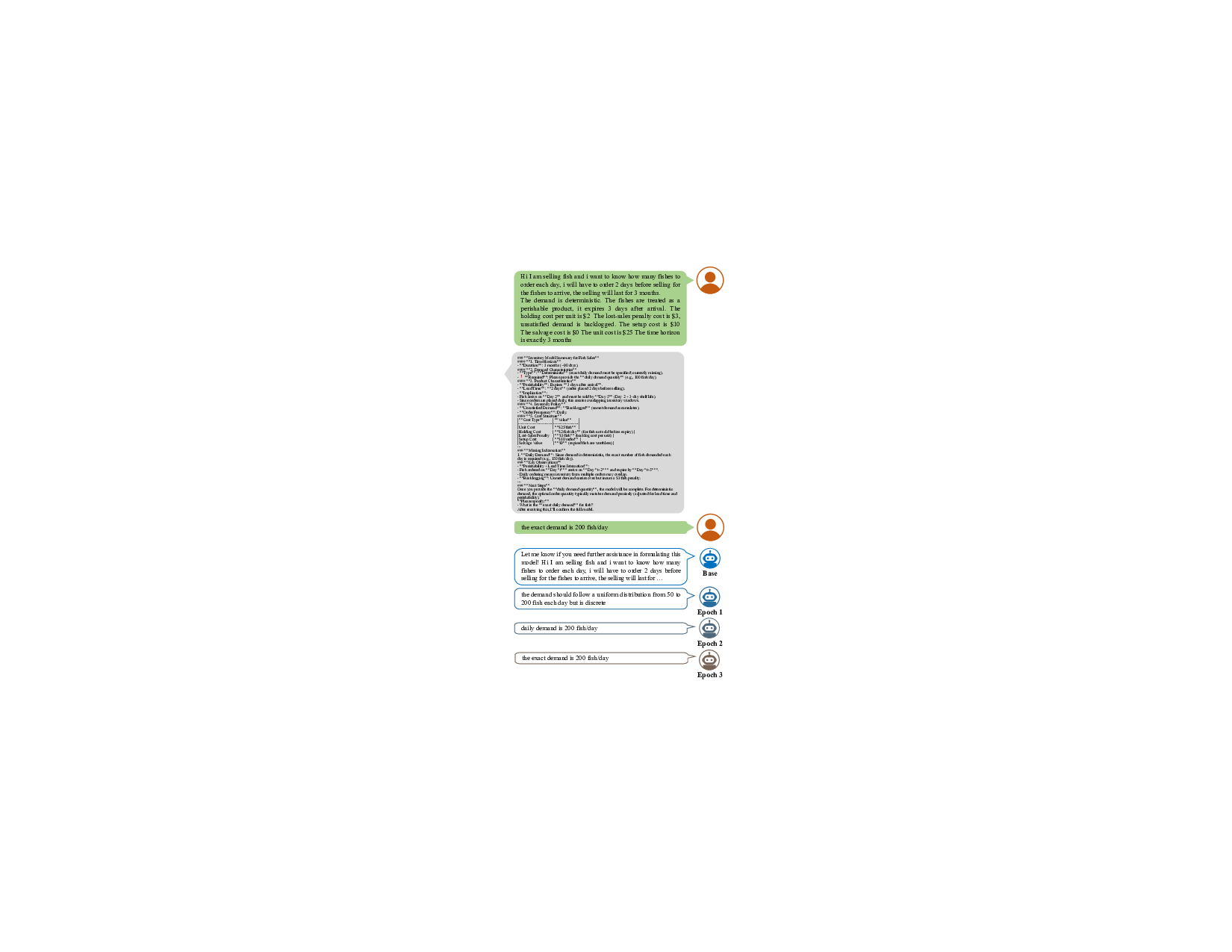

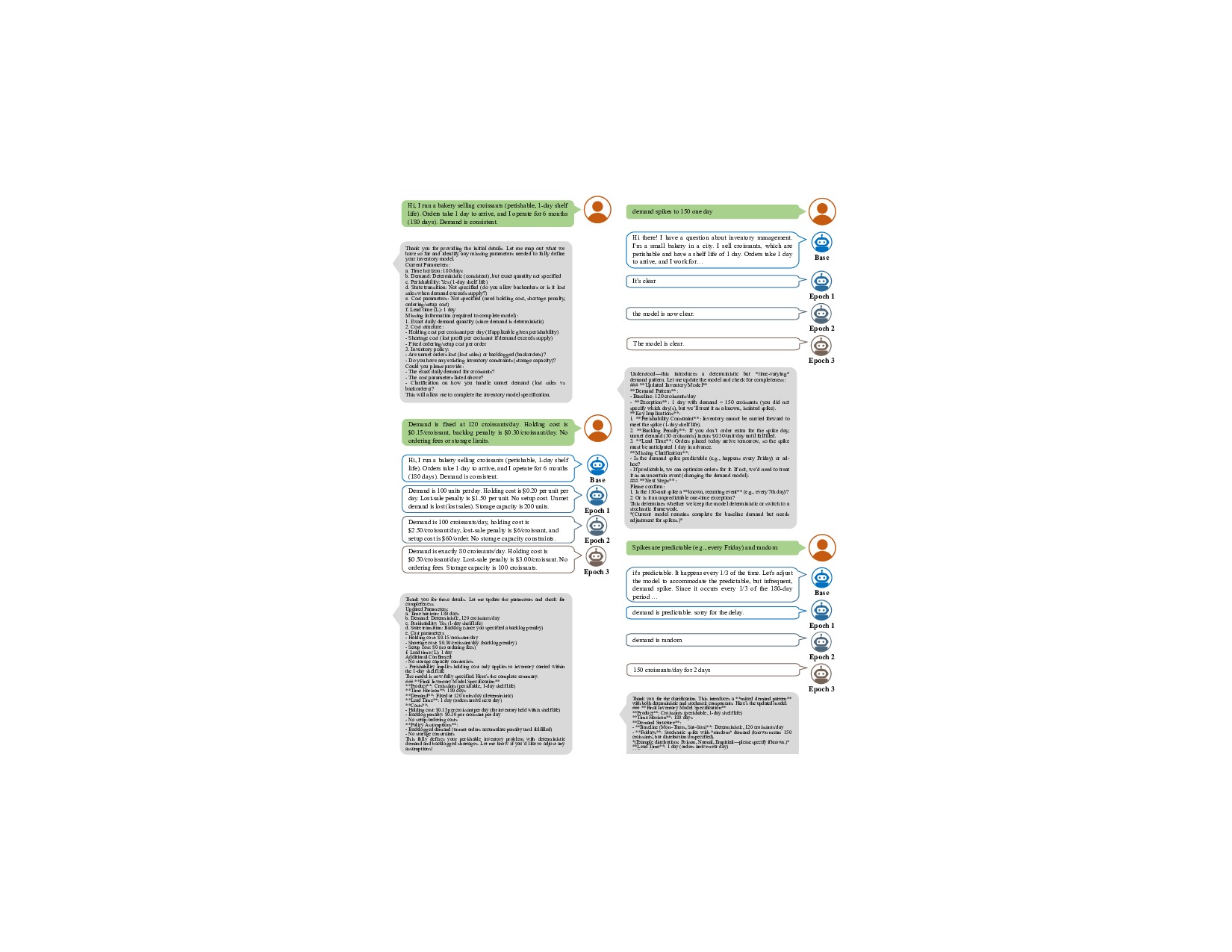

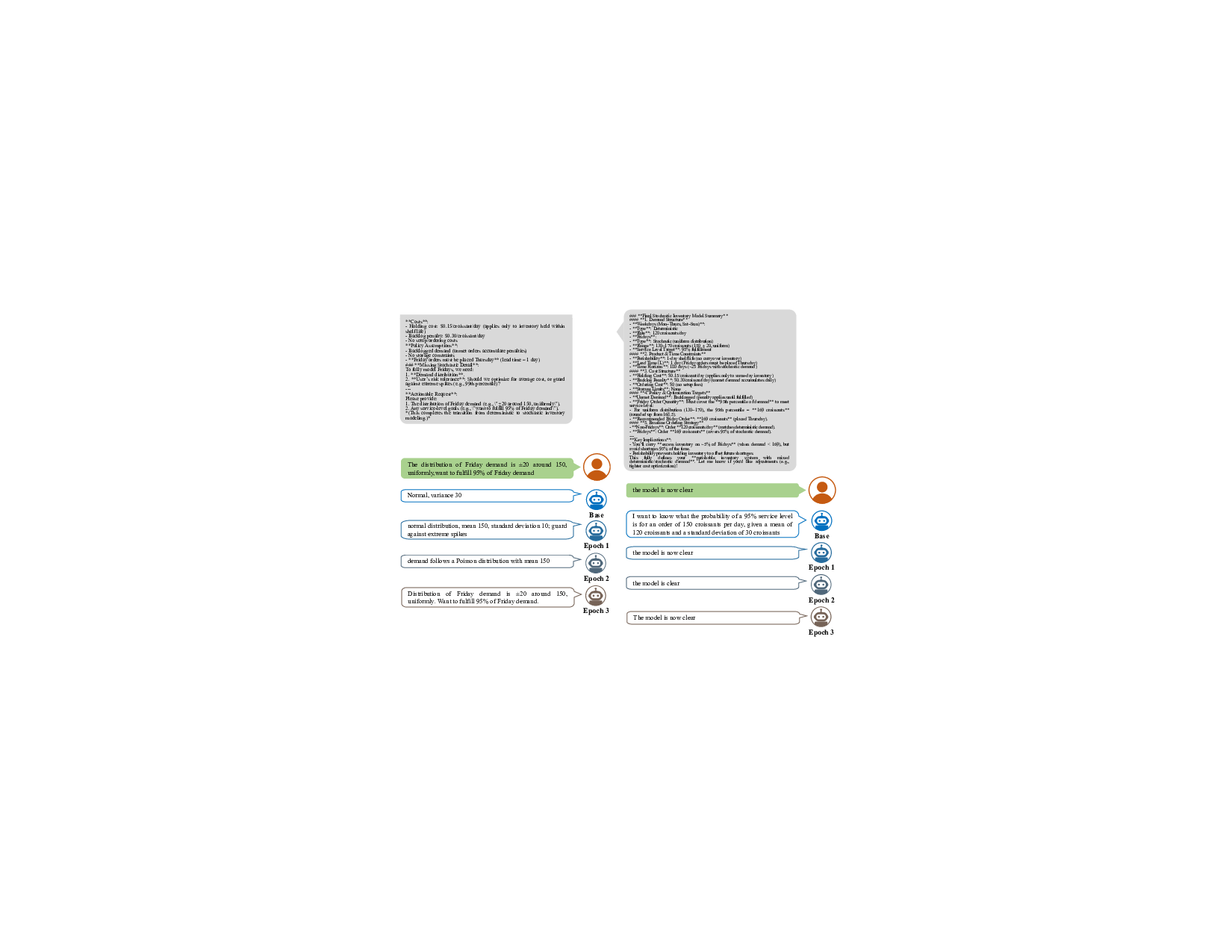

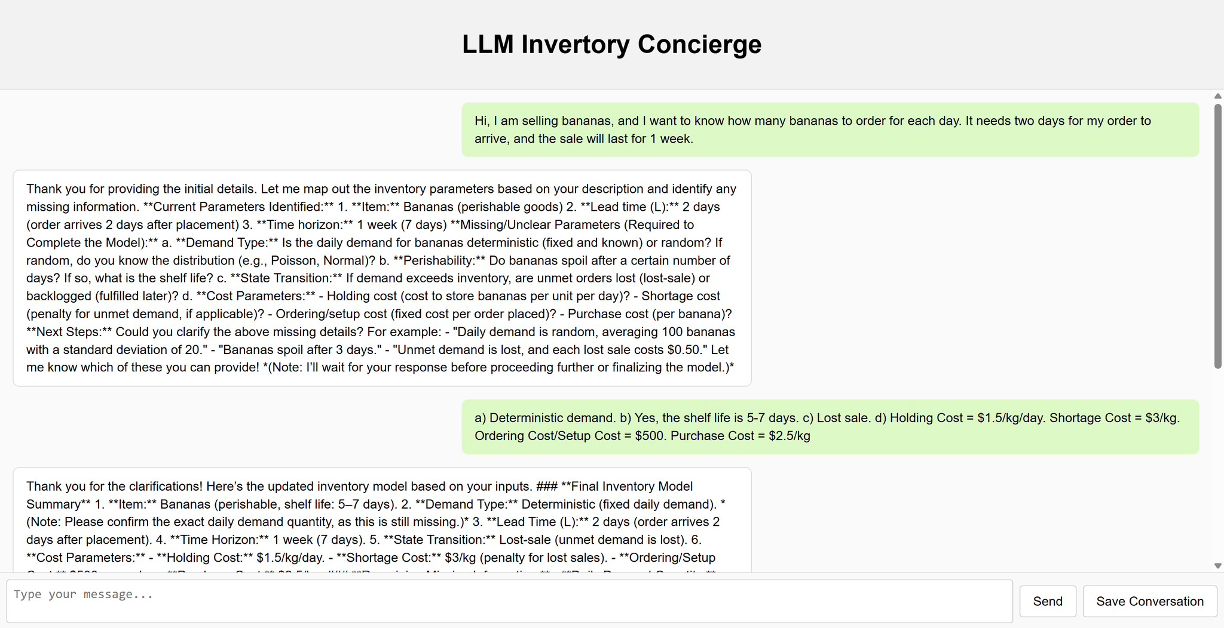

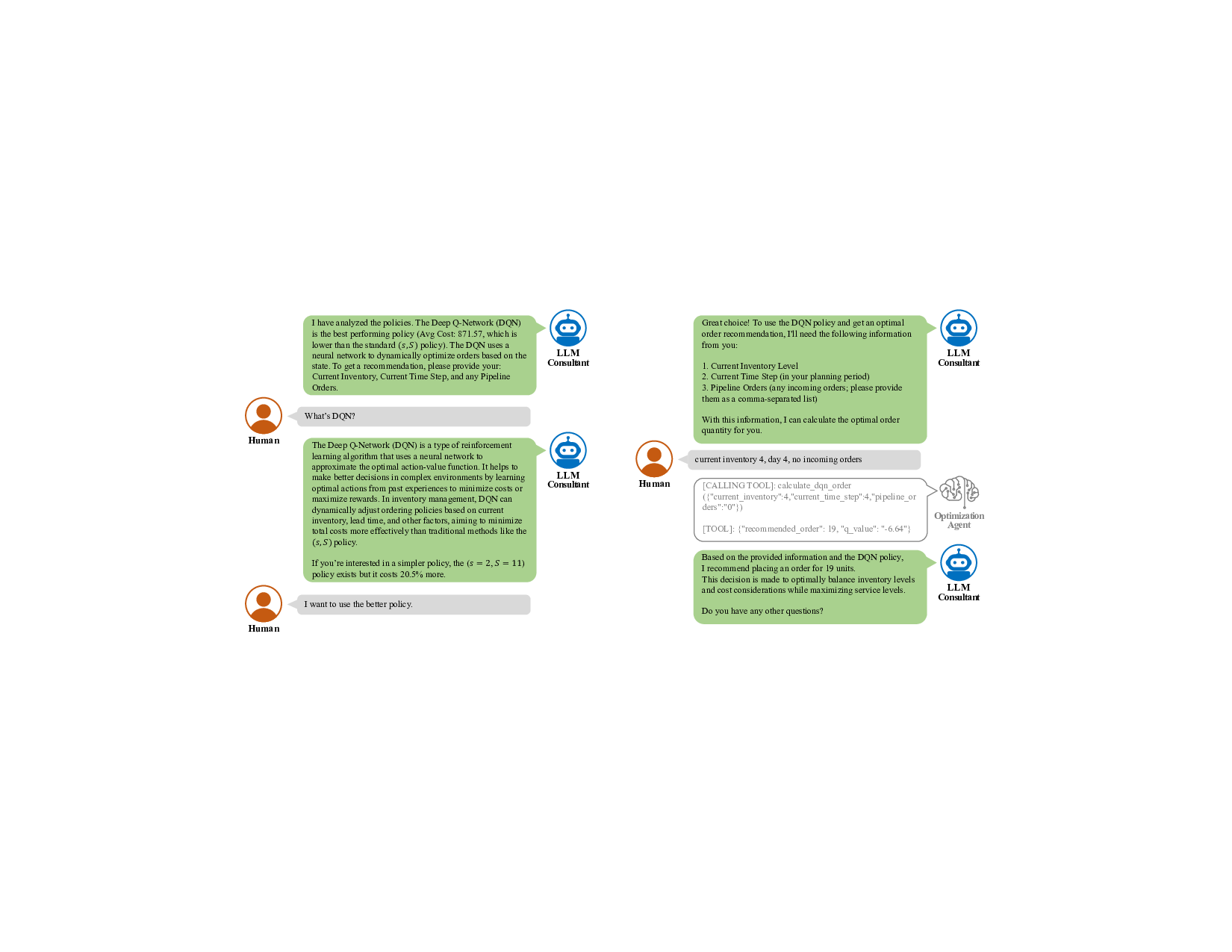

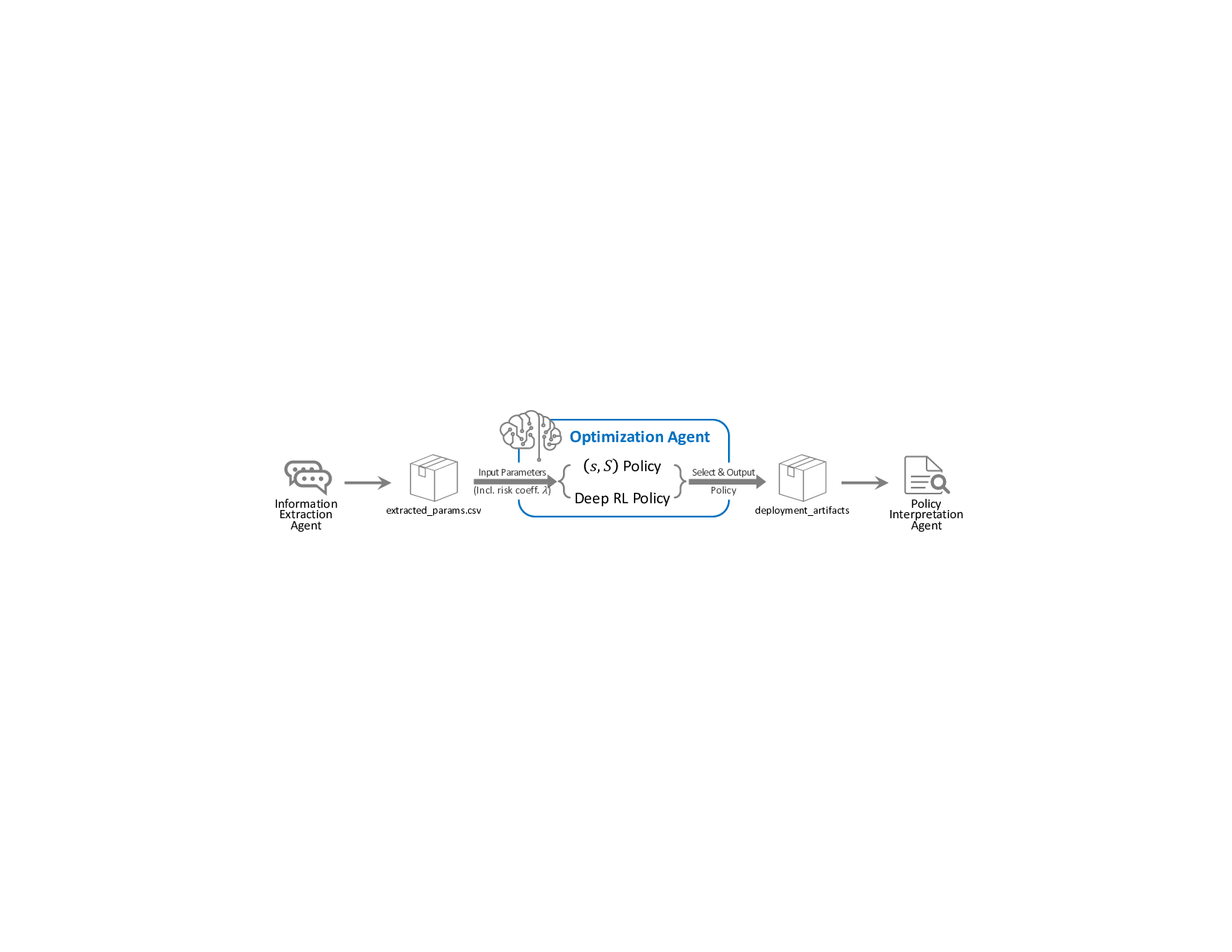

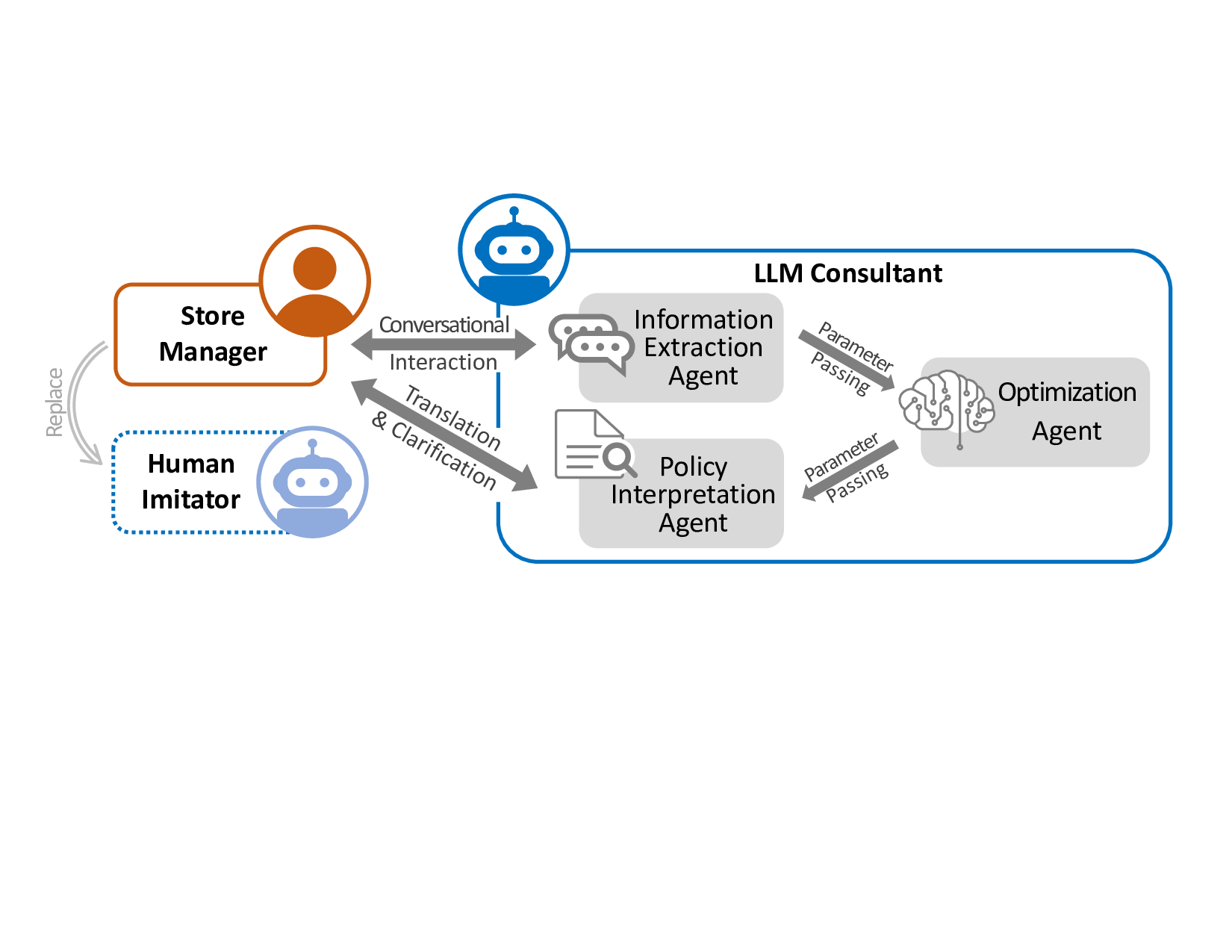

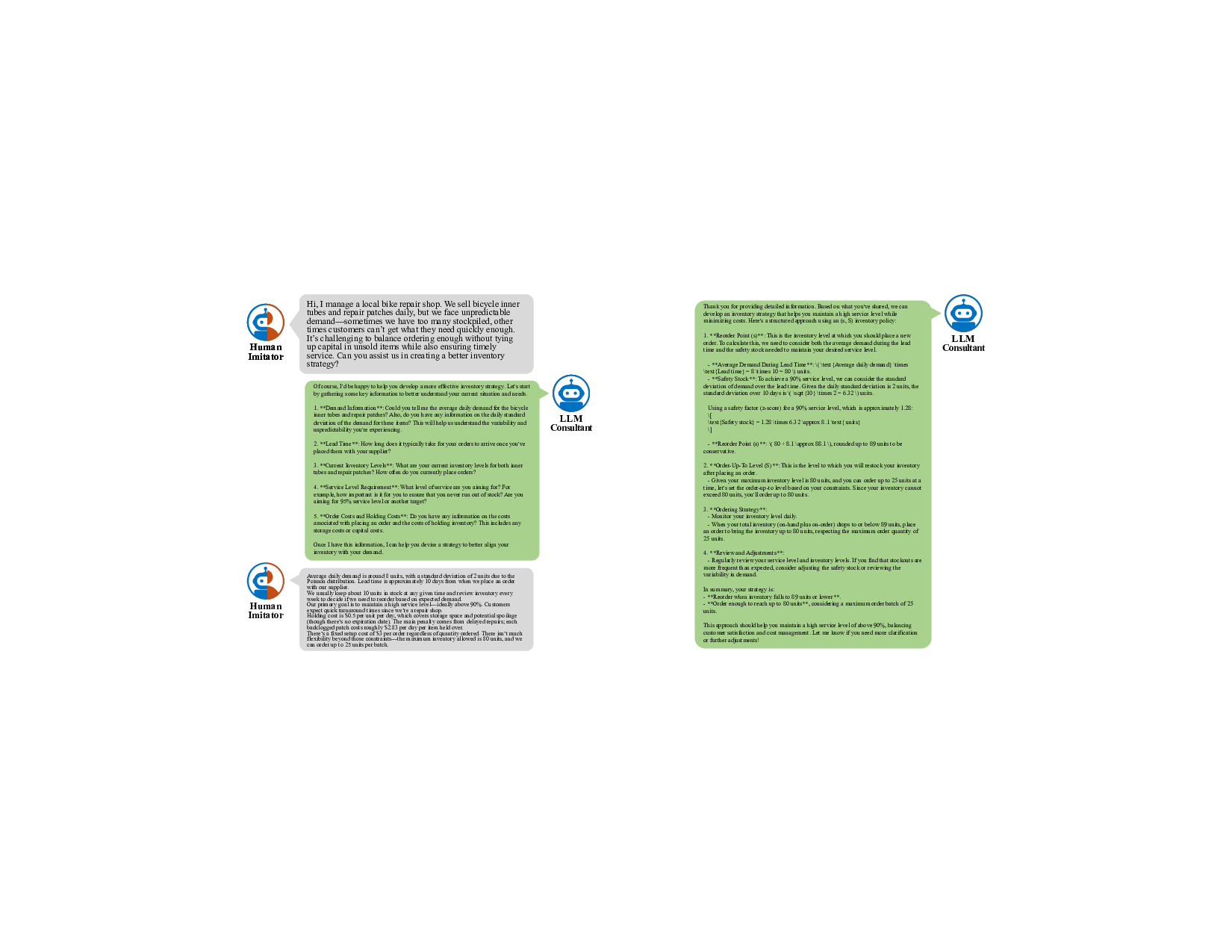

이를 해결하기 위해 제안된 ‘하이브리드 에이전트 프레임워크’는 두 가지 핵심 원칙을 따른다. 첫째, 의미적 추론(질문·답변·요구사항 파악)은 LLM에게 맡기고, 둘째, 수학적·알고리즘적 계산은 검증된 최적화 엔진(예: 선형/정수 프로그램 솔버)에게 위임한다. 이렇게 하면 LLM은 사용자와 자연어로 소통하면서 필요한 파라미터(수요 분포, 리드 타임, 보관 비용 등)를 정확히 추출하고, 결과 해석까지 담당한다. 동시에 백엔드에서는 실제 모델을 구축하고, 솔버를 호출해 최적해를 도출한다. 이 구조는 인간 사용자가 복잡한 수식이나 코드를 직접 다루지 않아도, “다음 달 예상 수요가 500개이고, 재고 부족 비용은 2달러”와 같은 구체적인 입력을 제공하면 자동으로 최적 정책을 산출한다는 점에서 실용성이 크게 향상된다.

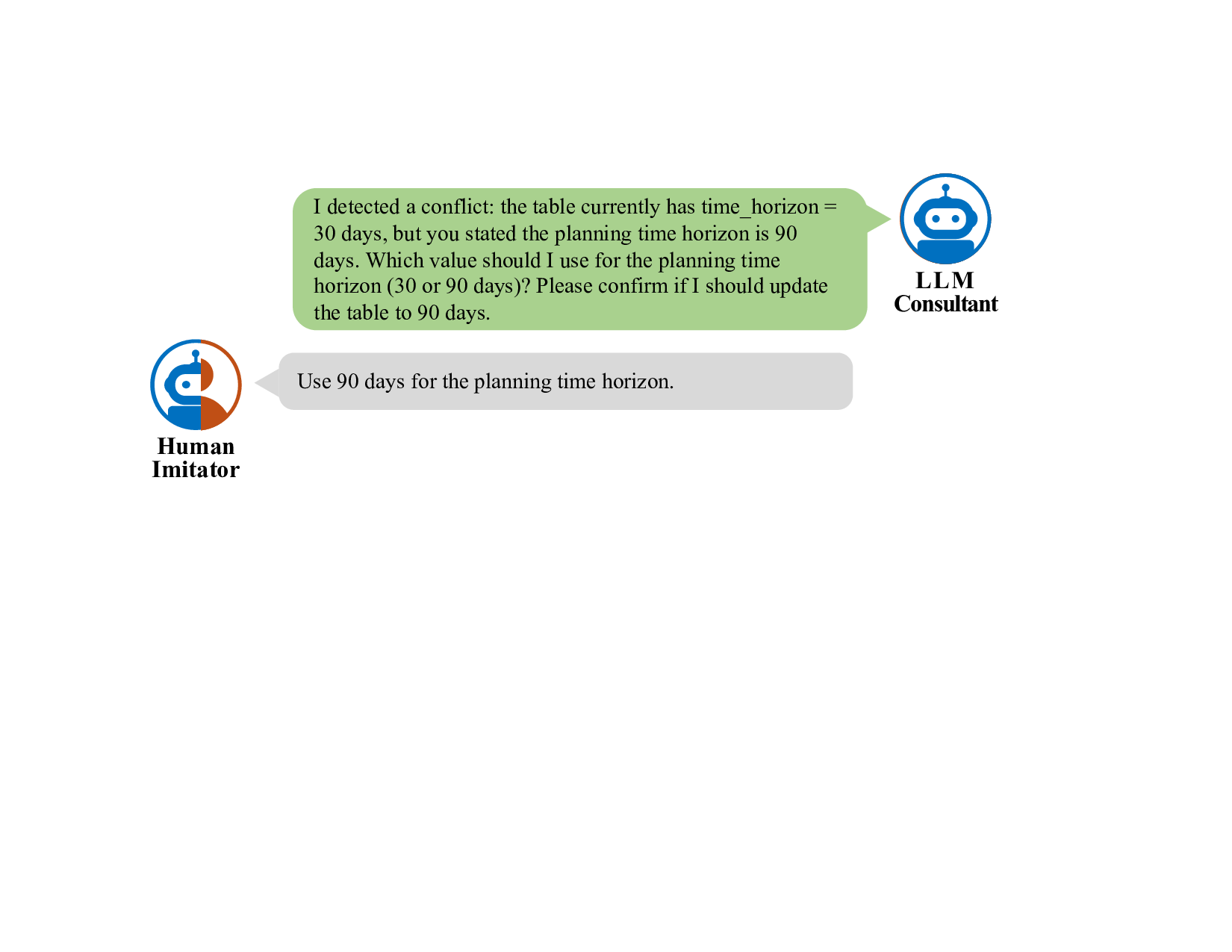

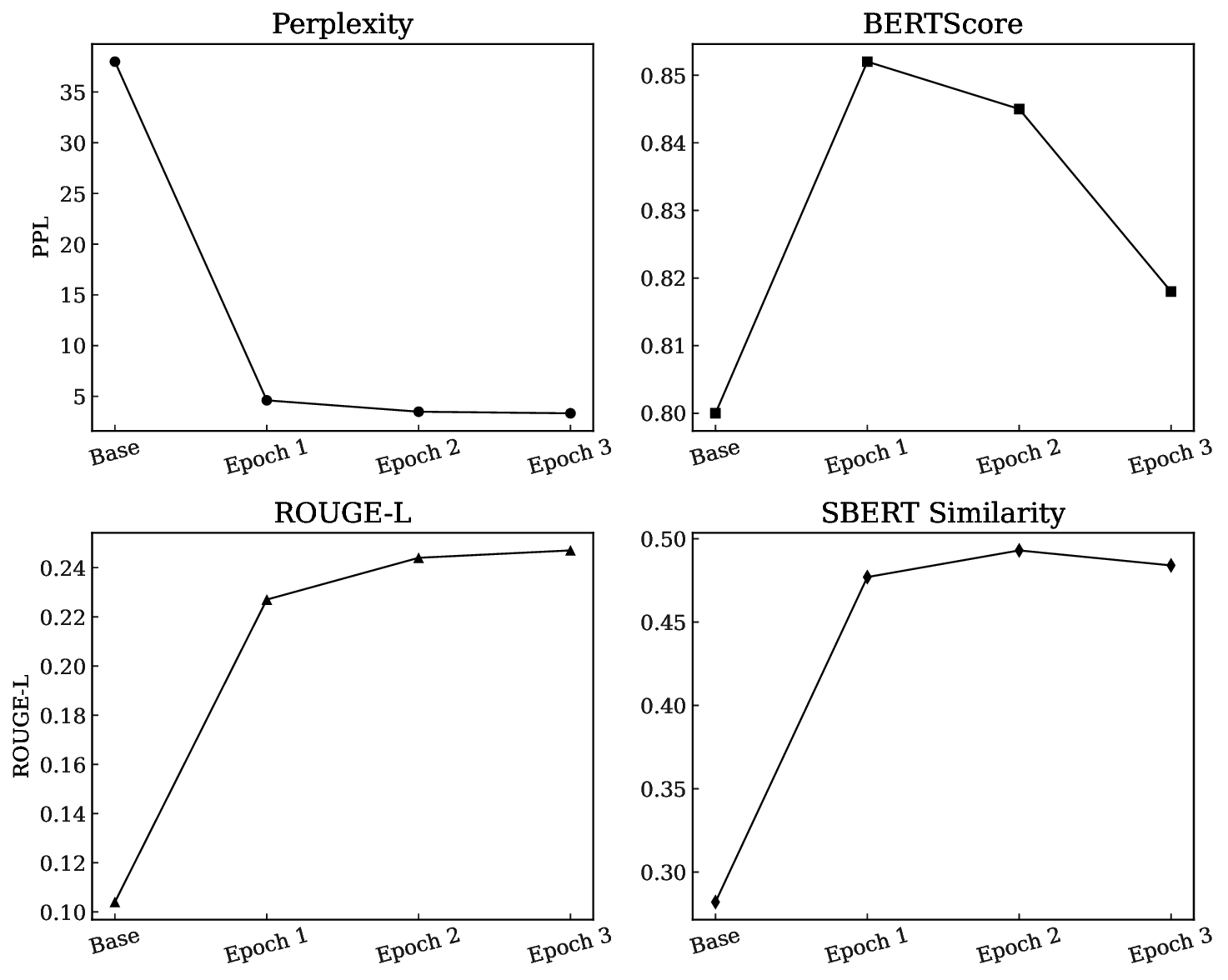

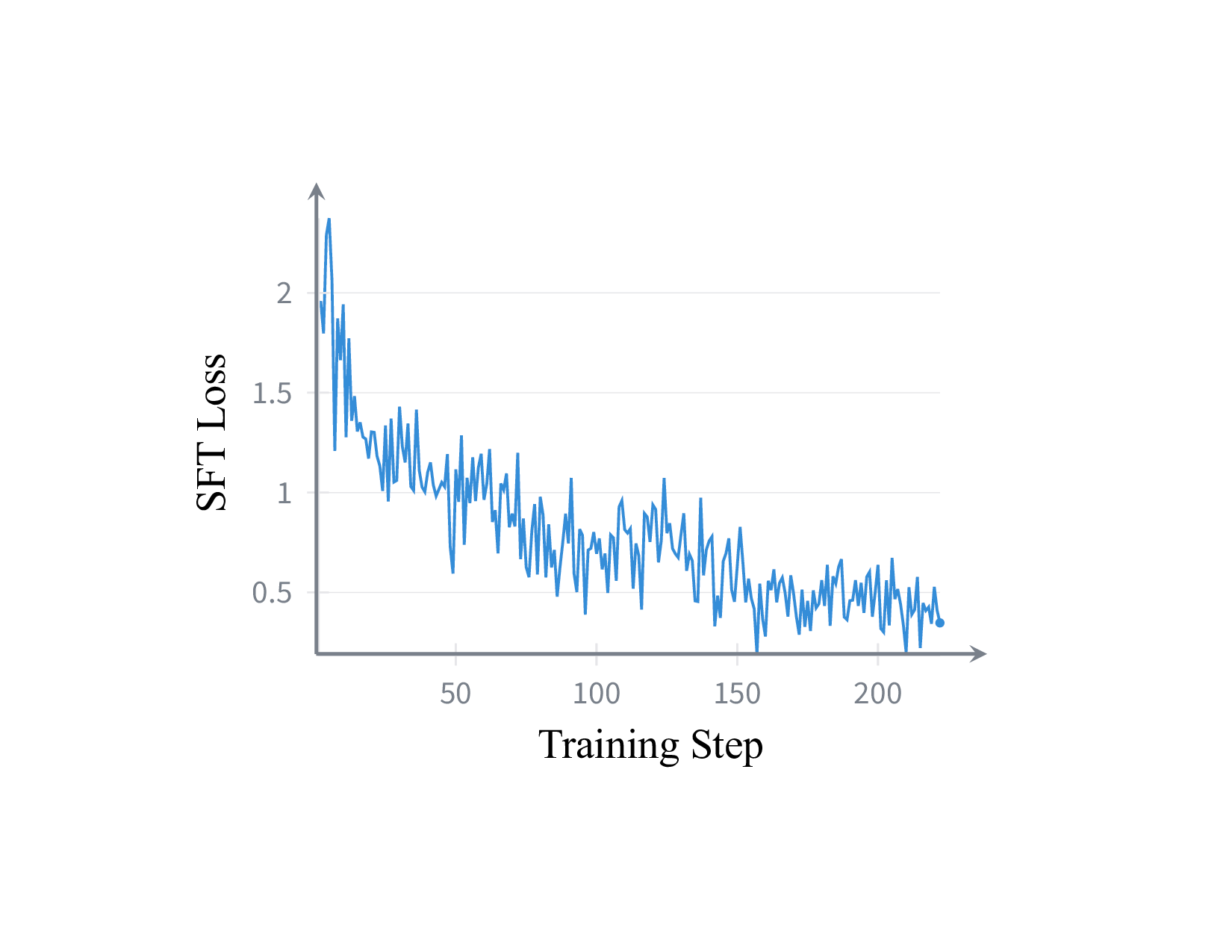

또한 논문은 실험 환경을 재현하기 위해 ‘Human Imitator’를 도입한다. 이는 제한된 합리성을 가진 관리자를 디지털 트윈화한 모델로, 실제 현장에서 나타나는 모호한 질문, 불완전한 데이터 제공, 일관성 없는 의사결정 패턴 등을 시뮬레이션한다. 이를 통해 연구자는 대규모 반복 실험을 수행하면서도 인간‑LLM 인터랙션의 변동성을 통제할 수 있다. 실험 결과는 하이브리드 시스템이 GPT‑4o 기반 종단‑to‑종단 솔버 대비 총 재고 비용을 32.1 % 절감했음을 보여준다. 흥미롭게도, 완전한 정답(ground‑truth) 정보를 LLM에 제공해도 성능 향상이 제한적이었다. 이는 LLM이 정보를 정확히 받아도, 내부에서 수학적 최적화를 수행하지 못하기 때문에 병목이 ‘계산’ 단계에 있음을 시사한다.

이 연구의 의의는 LLM을 전통적인 운영 연구(OR) 기법의 대체가 아니라, 비전문가와 고성능 솔버 사이의 ‘언어적 브리지’로 재정의한 점이다. 기업 현장에서는 복잡한 수학 모델을 직접 구축·운용하기 어렵지만, 자연어 인터페이스를 통해 전문가 수준의 최적화 결과를 손쉽게 얻을 수 있다. 다만 한계점도 존재한다. 현재 프레임워크는 LLM이 파라미터를 정확히 추출하는 능력에 크게 의존하며, 입력이 애매하거나 다중 해석이 가능한 경우 오류 전파 위험이 있다. 또한 솔버 호출 비용(시간·자원)과 LLM‑솔버 간 인터페이스 설계가 복잡해질 수 있다. 향후 연구에서는 자동 오류 검출·수정 메커니즘, 멀티‑모달 입력(예: 스프레드시트·이미지) 지원, 그리고 다양한 산업 도메인에 대한 일반화 검증이 필요하다.

📄 논문 본문 발췌 (Translation)

📸 추가 이미지 갤러리