프롬프트 최적화를 위한 보편 조건 논리

📝 원문 정보

- Title: Universal Conditional Logic: A Formal Language for Prompt Engineering

- ArXiv ID: 2601.00880

- 발행일: 2025-12-31

- 저자: Anthony Mikinka

📝 초록 (Abstract)

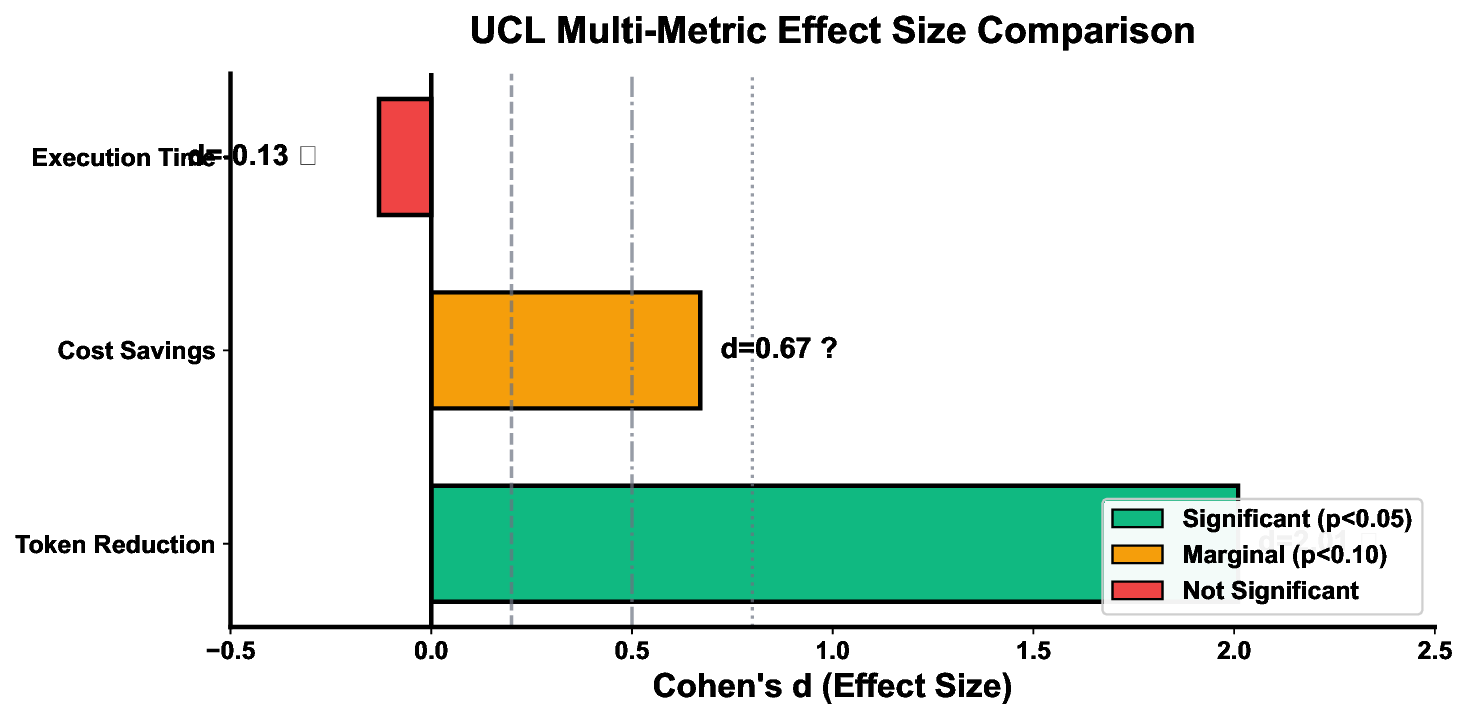

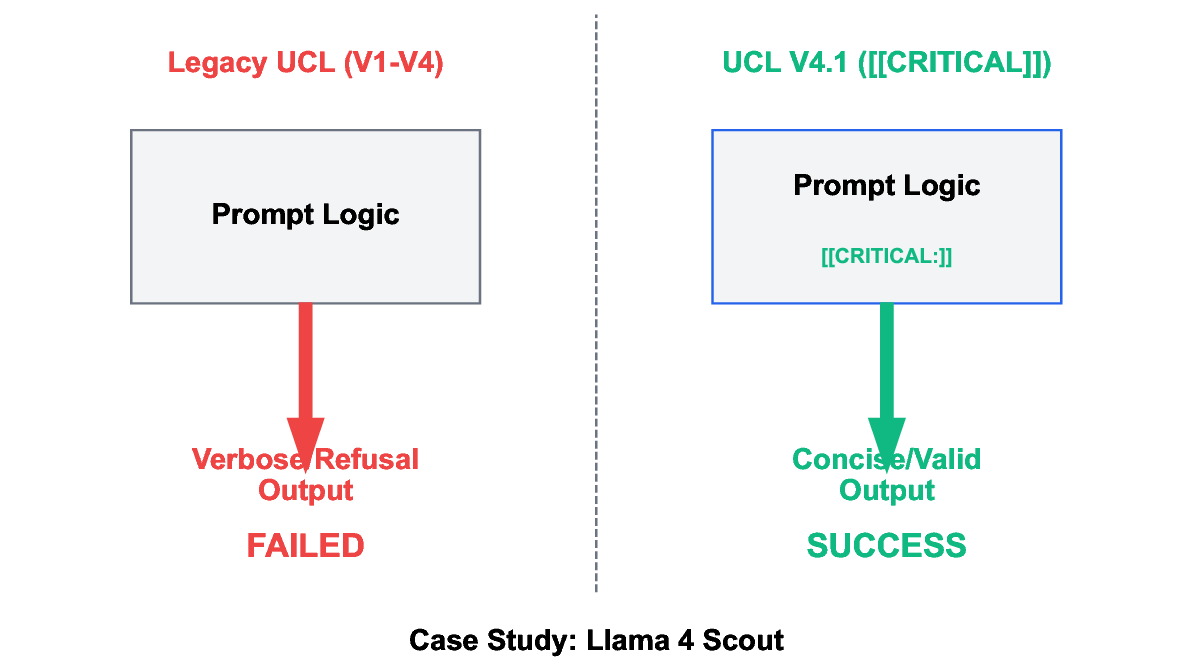

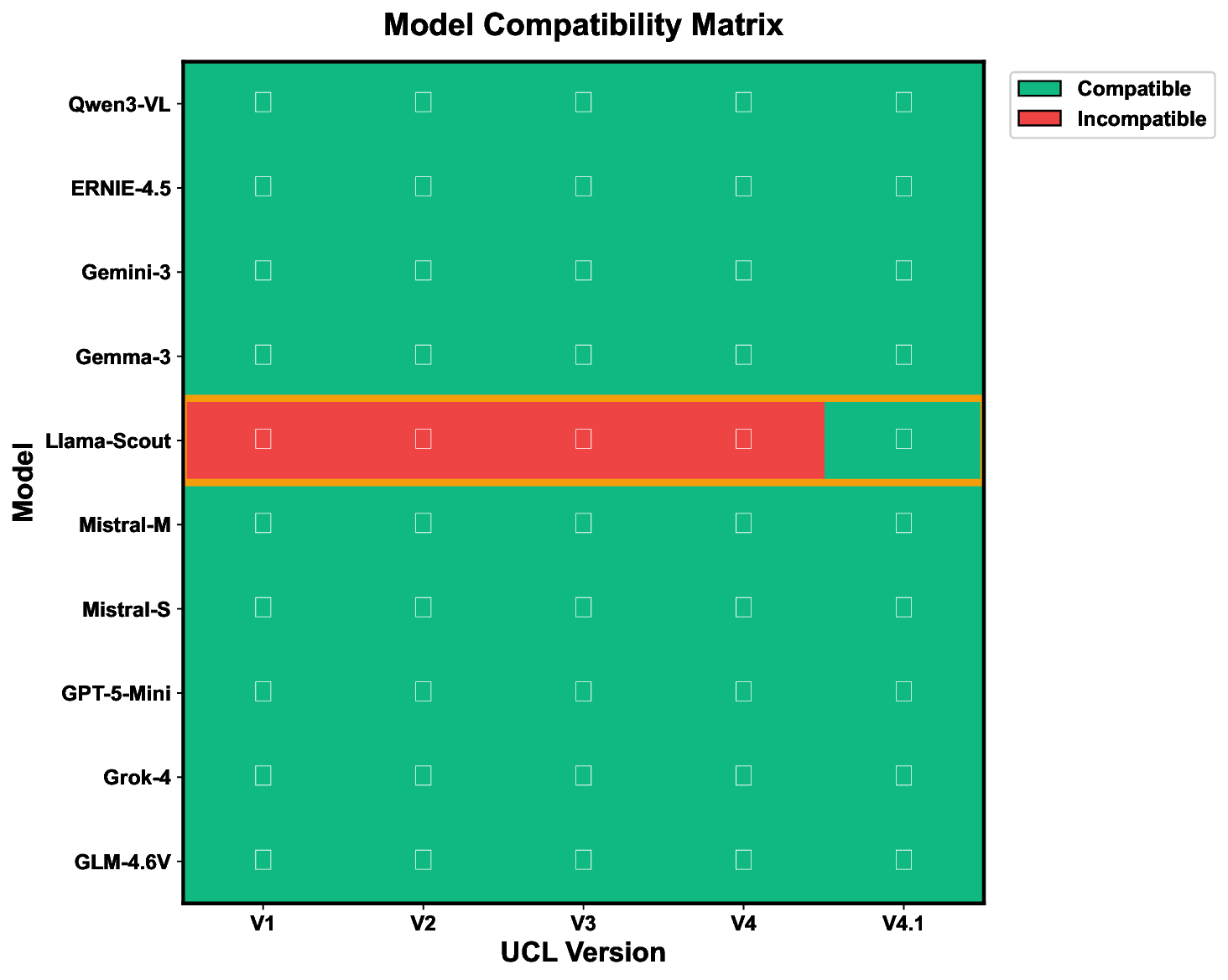

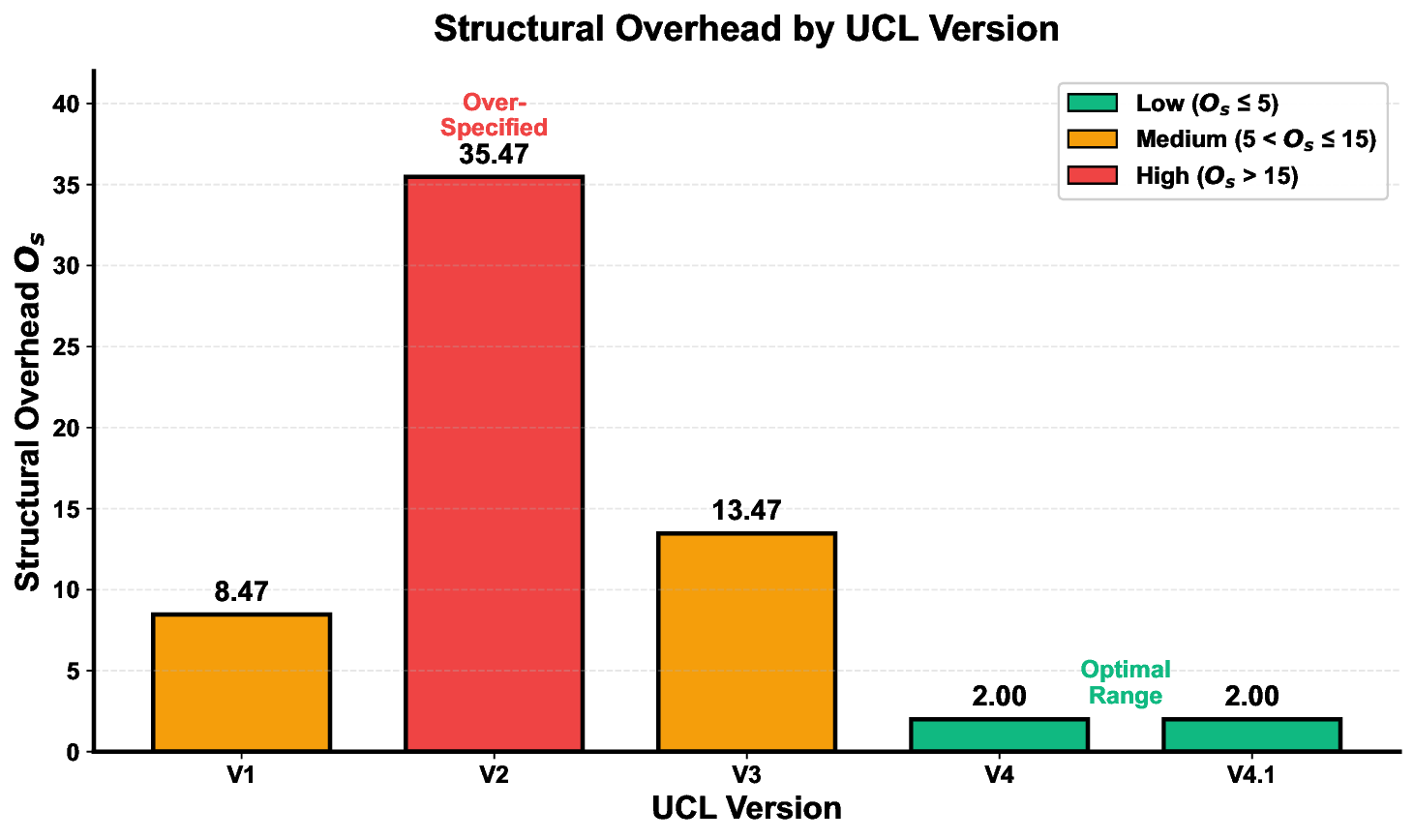

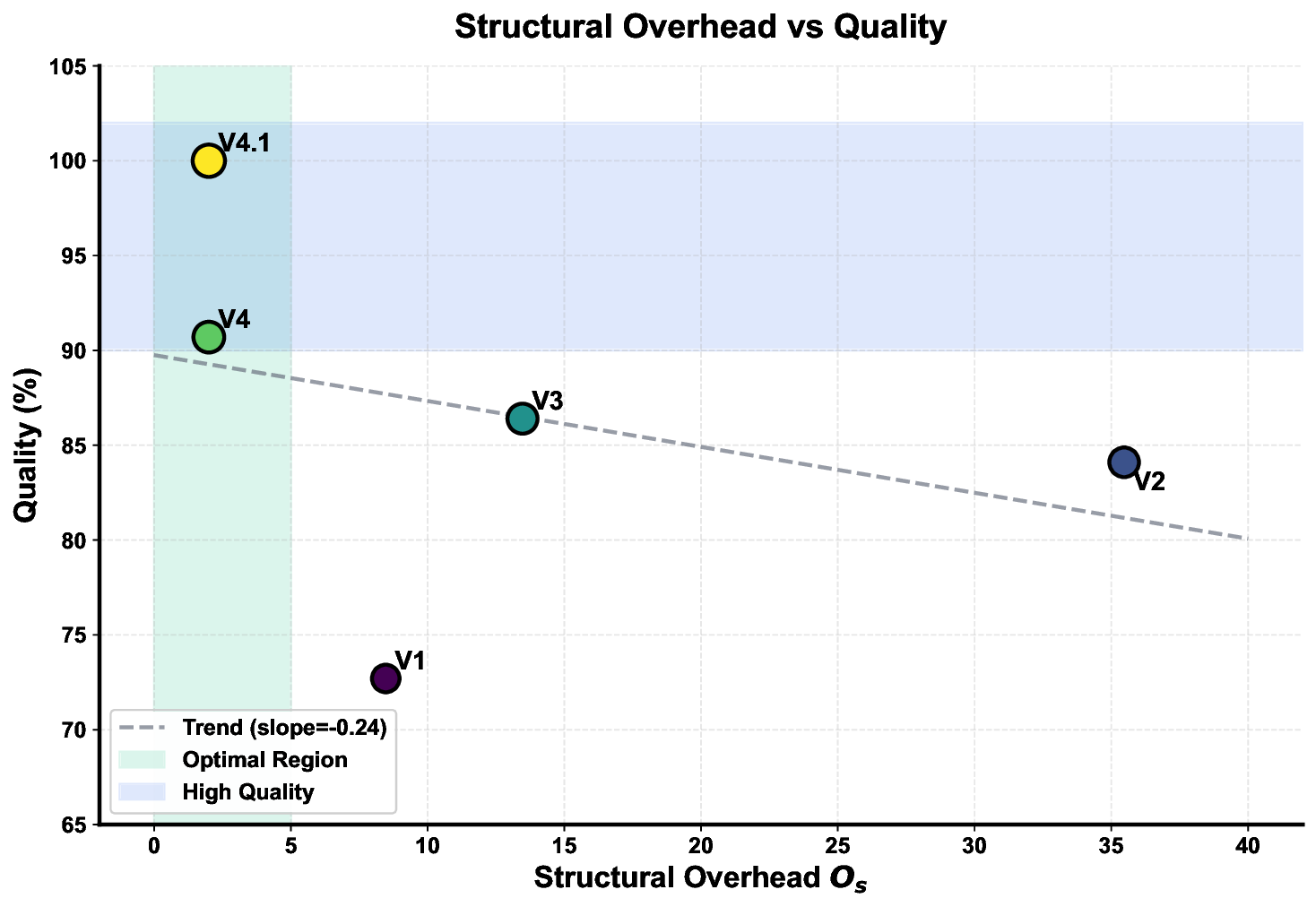

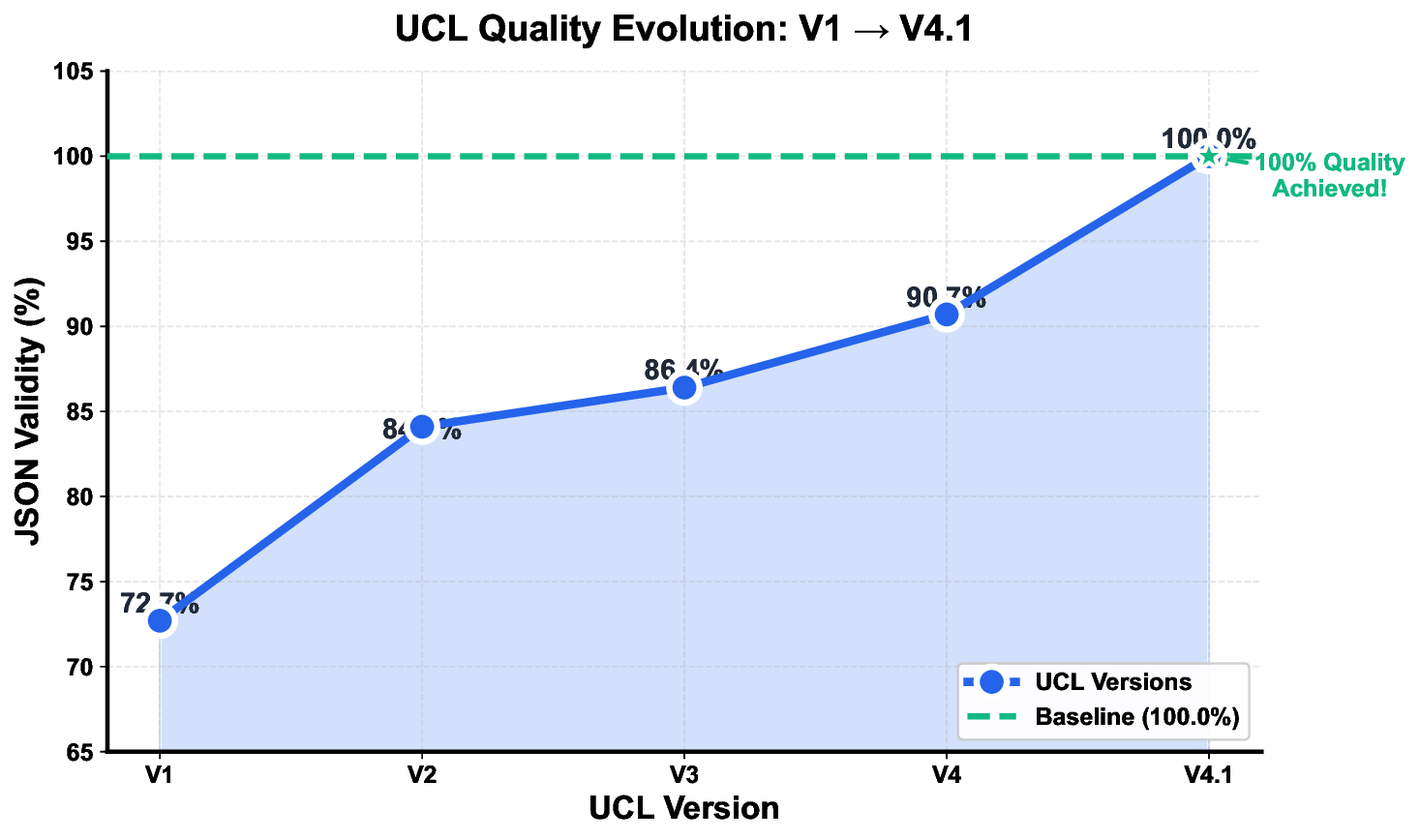

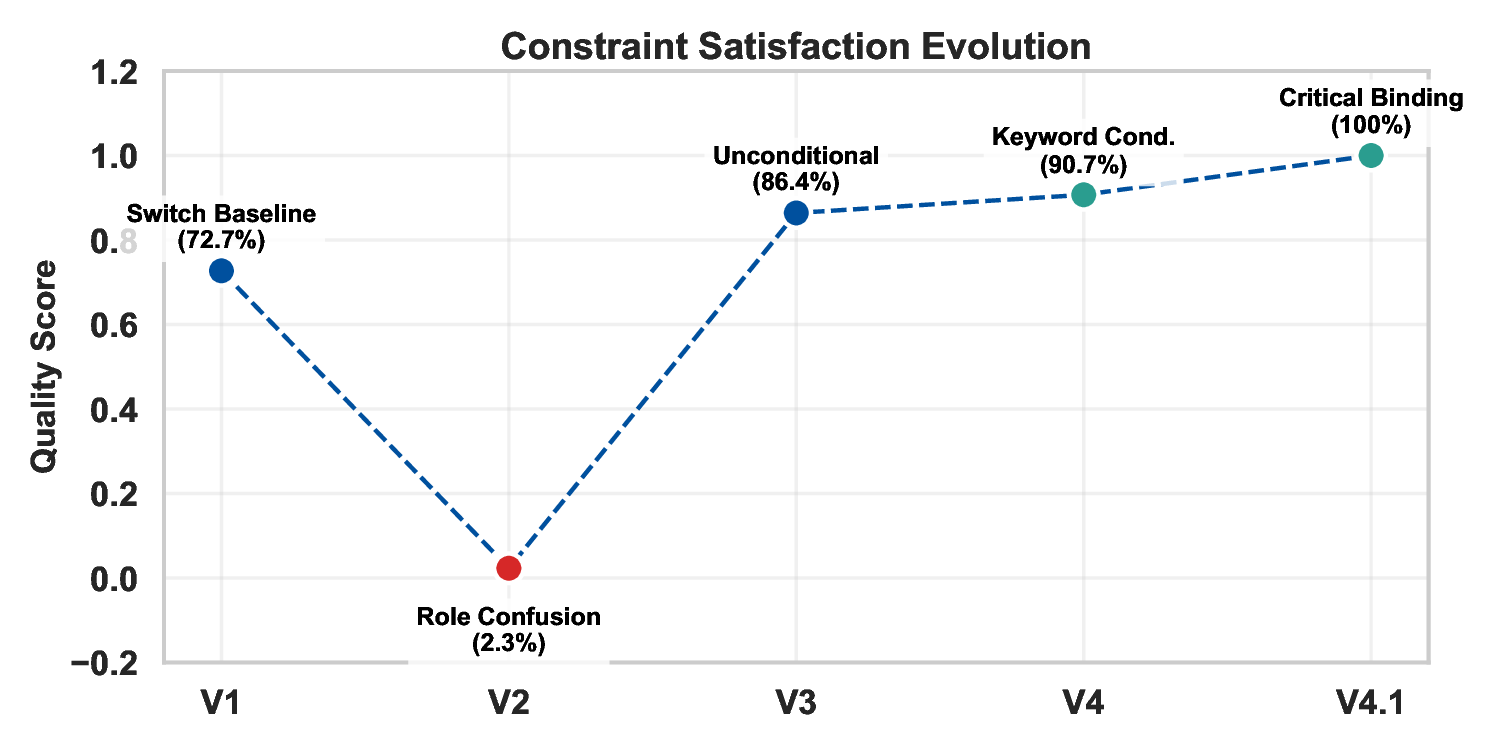

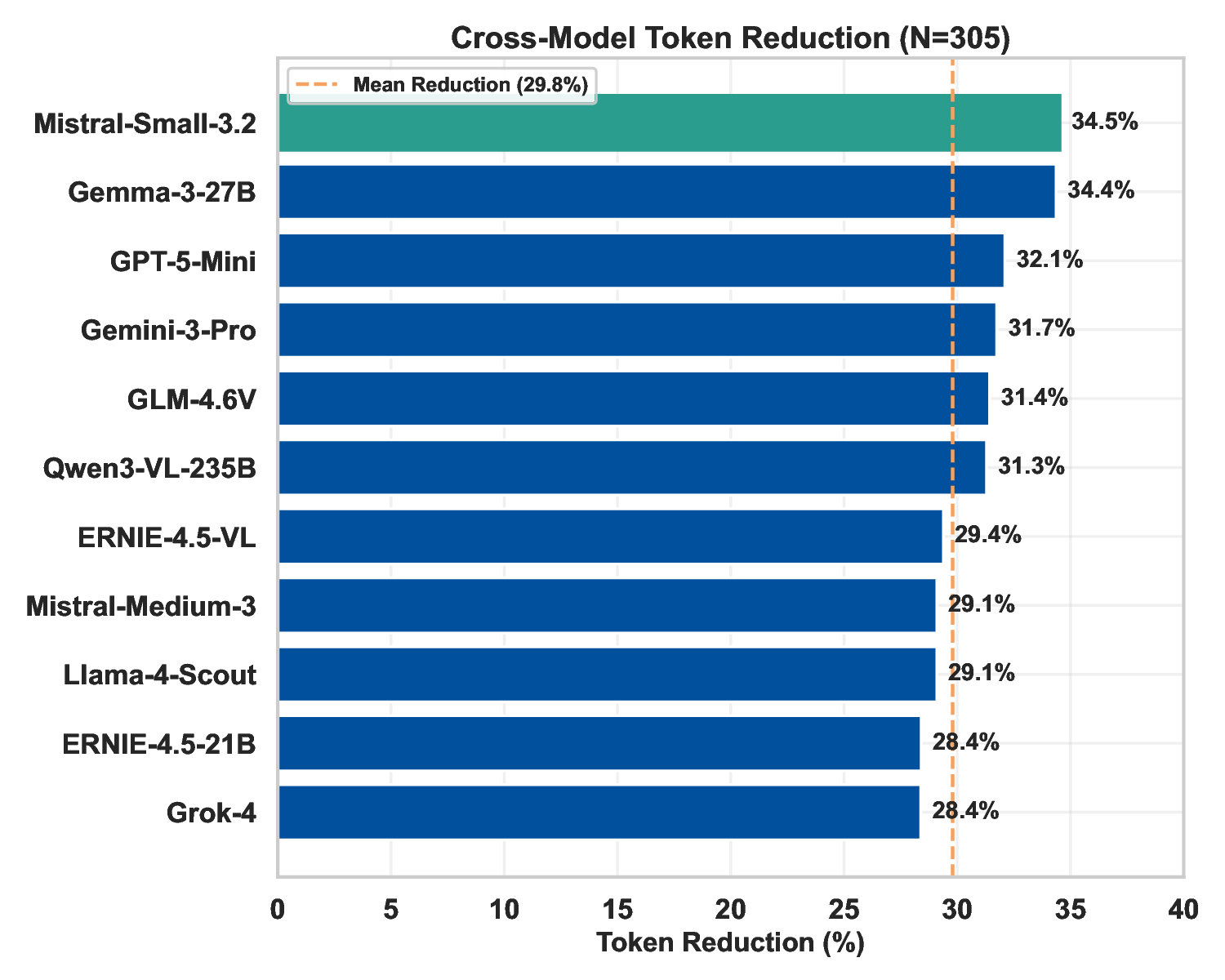

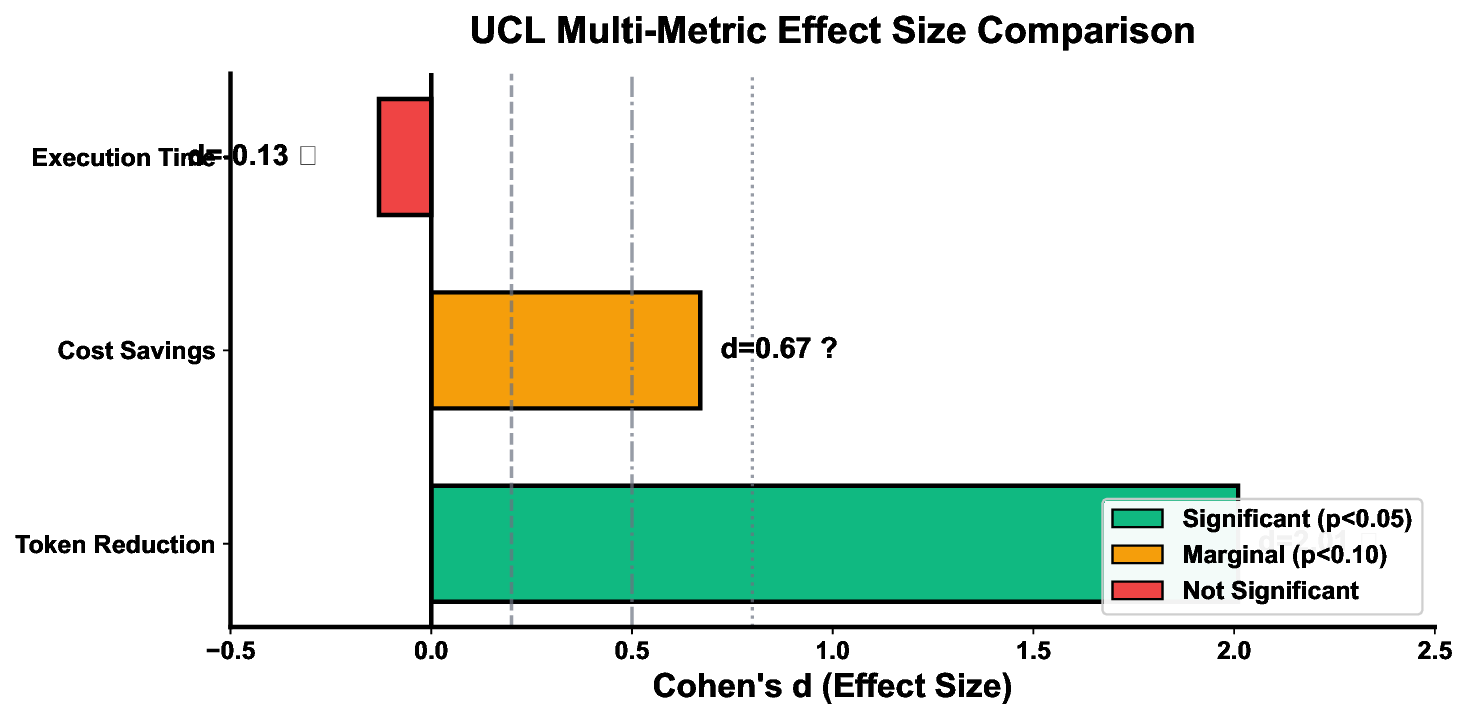

우리는 프롬프트 최적화를 수학적 체계로 전환하는 보편 조건 논리(UCL)를 제시한다. 305개의 실험, 11개 모델, 4회 반복 평가를 통해 토큰 사용량을 평균 29.8% 감소시켰으며(t(10)=6.36, p<0.001, Cohen’s d=2.01) 비용 절감 효과를 입증하였다. UCL의 구조적 오버헤드 함수 Os(A)는 버전별 성능 차이를 설명하며, 과도한 명시가 성능을 2차적으로 악화시키는 과잉 명시 역설을 제시한다(임계값 S* = 0.509). 핵심 메커니즘인 지시자 함수 Ii∈{0,1}, 구조적 오버헤드 Os=γ ln Ck, 그리고 초기 바인딩이 검증되었다. 특히 최적 UCL 구성은 모델 아키텍처에 따라 달라지며, Llama 4 Scout과 같은 일부 모델은 버전‑특화 적응(V4.1)이 필요하다. 본 연구는 UCL을 효율적인 LLM 상호작용을 위한 교정 가능한 프레임워크로 확립하고, 모델 패밀리별 최적화가 주요 연구 방향임을 강조한다.💡 논문 핵심 해설 (Deep Analysis)

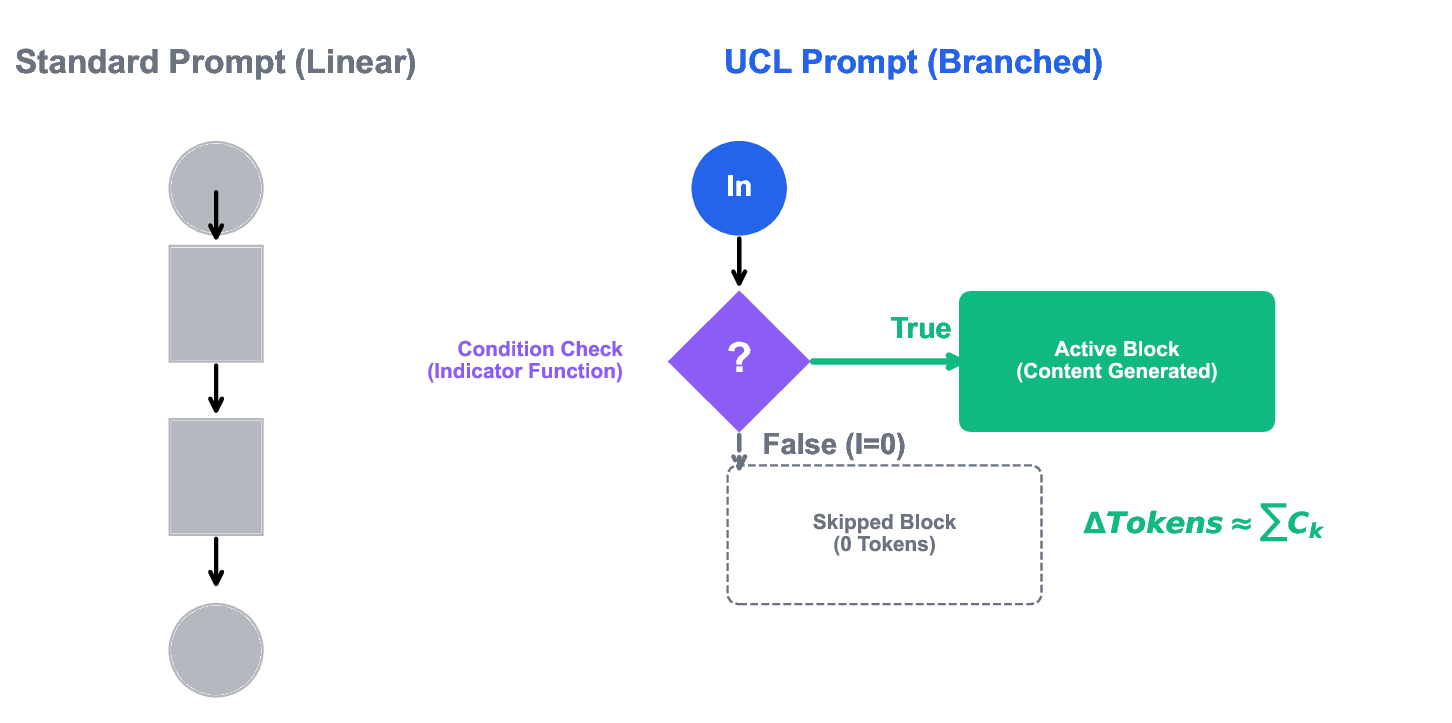

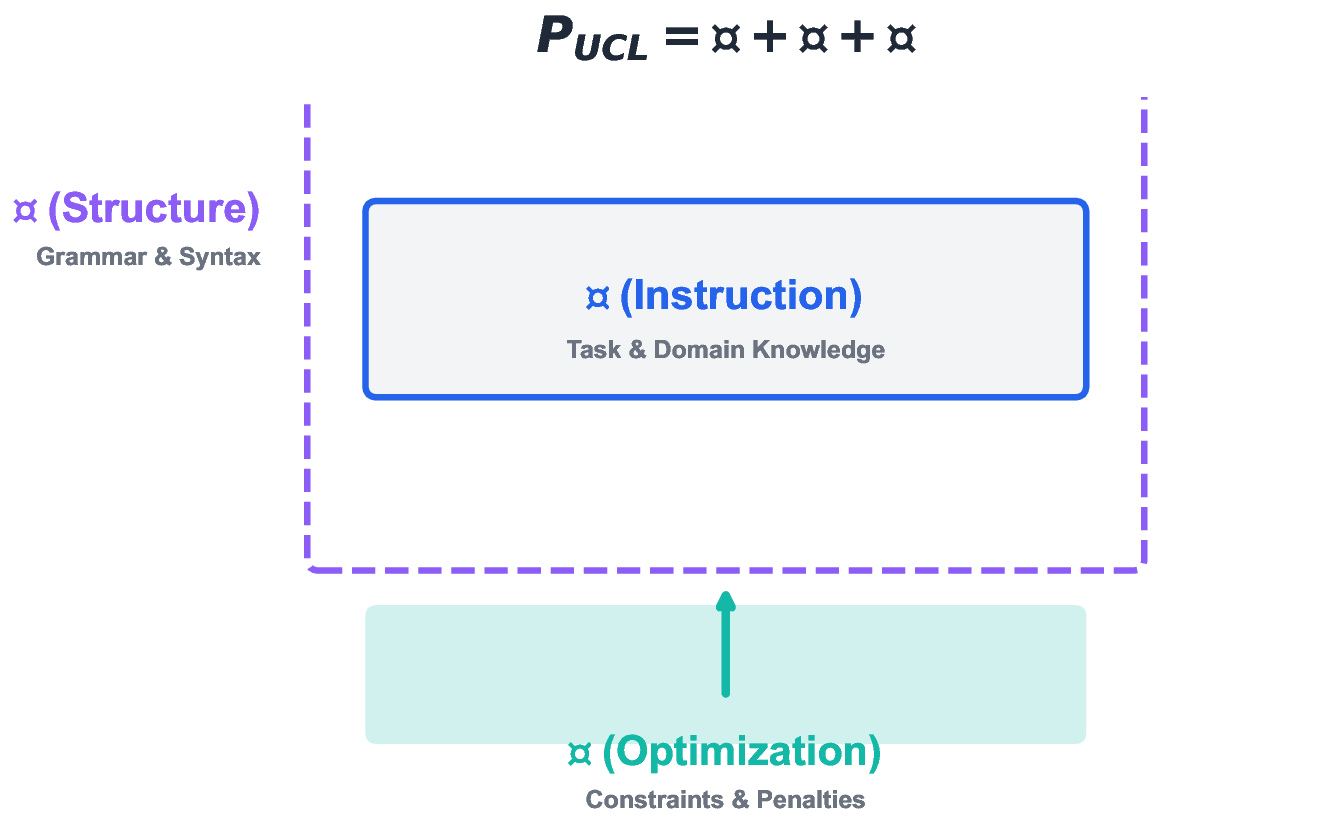

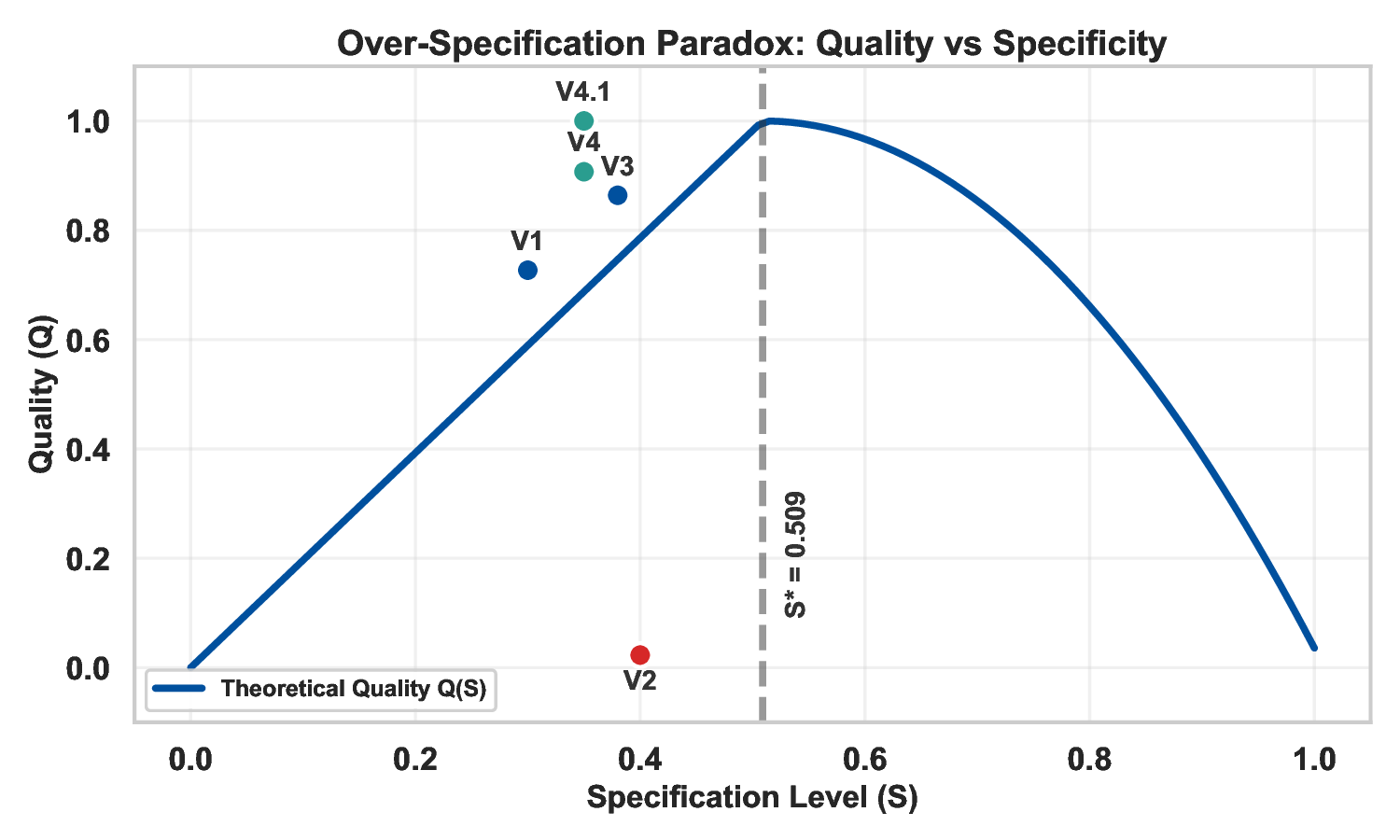

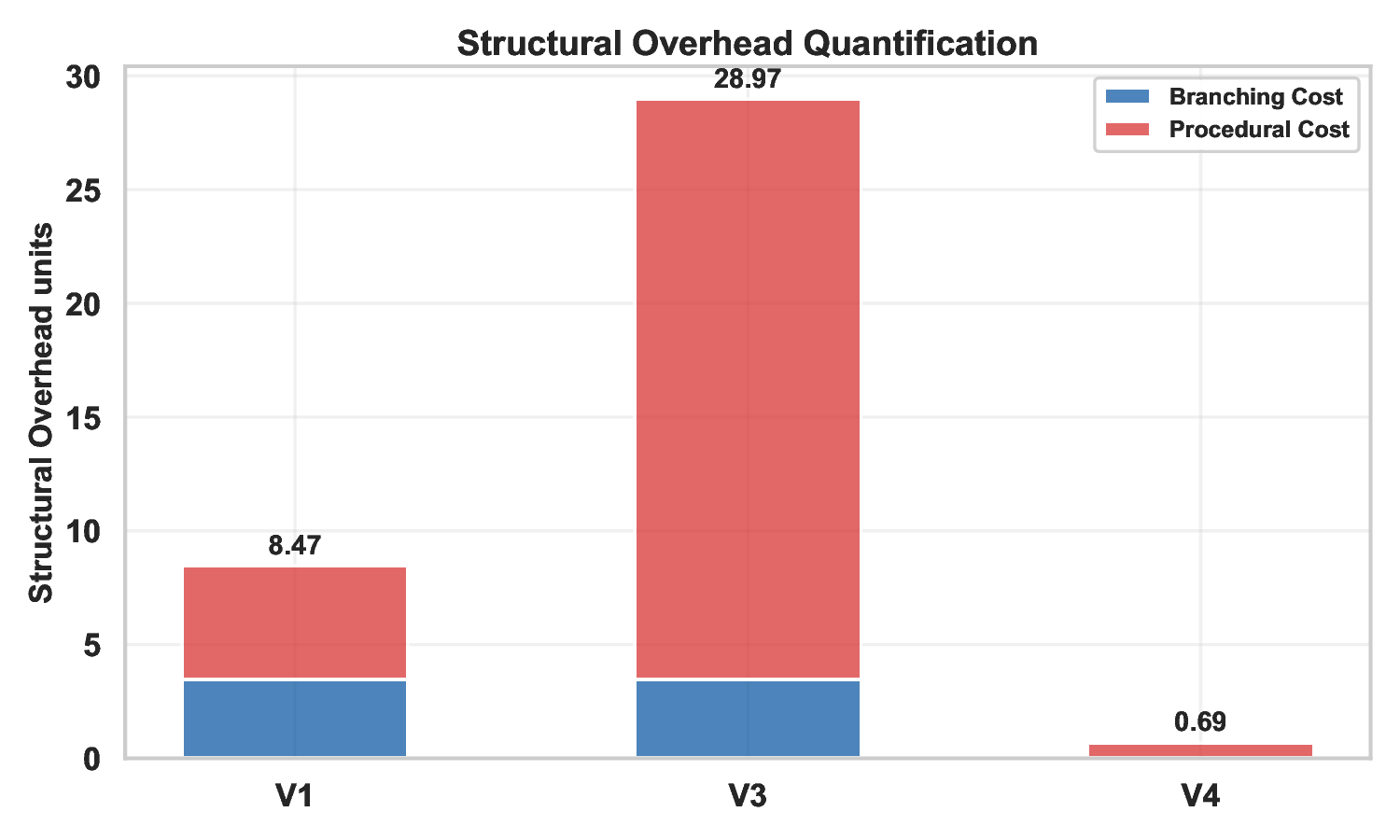

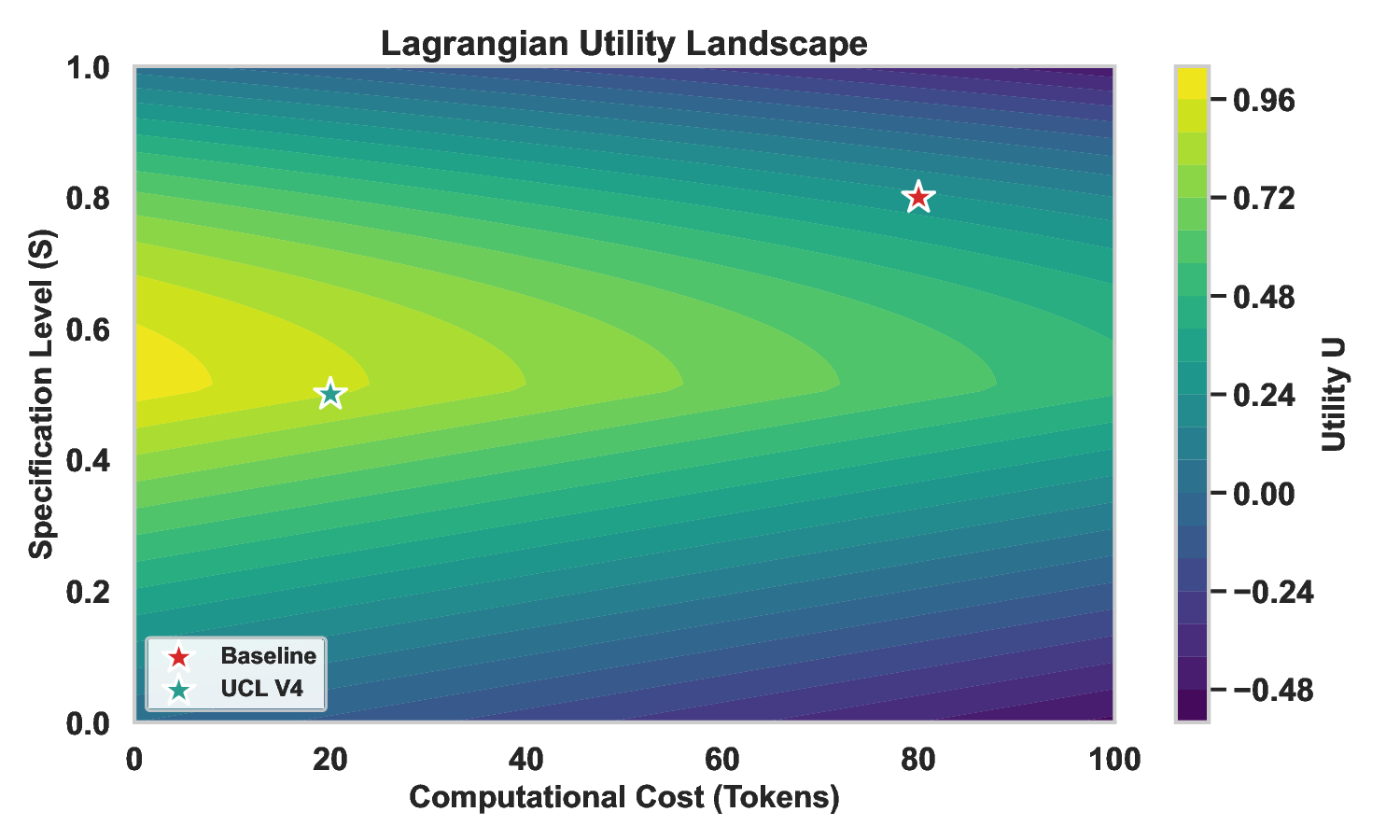

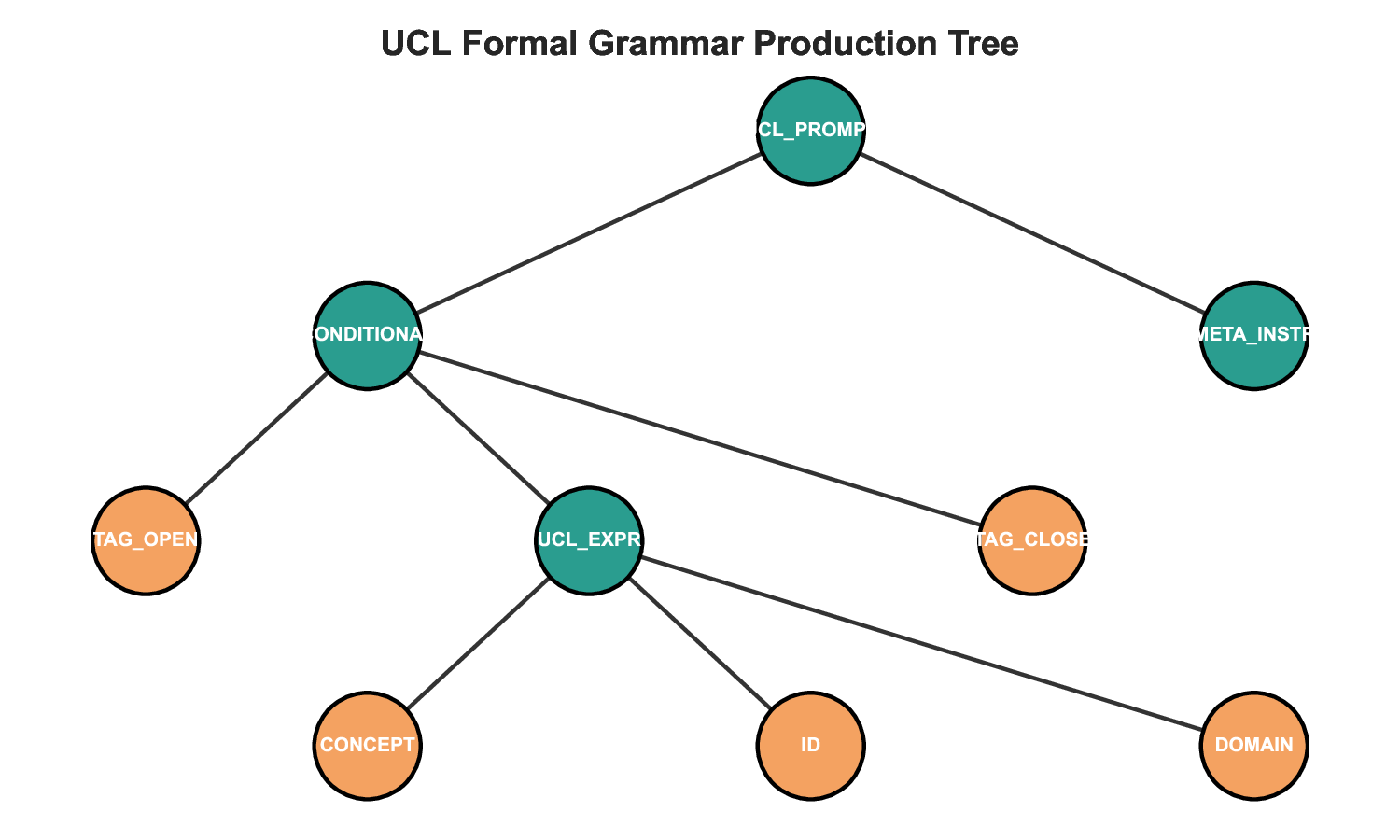

UCL의 핵심 구성 요소는 ‘구조적 오버헤드 함수’ Os(A)=γ ln Ck 로, 여기서 C는 프롬프트의 복잡도(조건 수, 변수 수 등)를, k는 모델별 민감도 파라미터를 의미한다. 이 함수는 프롬프트가 지나치게 상세화될 경우 발생하는 ‘과잉 명시 역설(Over‑Specification Paradox)’을 수학적으로 설명한다. 논문에서는 임계값 S* = 0.509를 도출했으며, S>S* 구간에서는 성능이 제곱적으로 감소한다는 비선형 관계를 제시한다. 즉, 프롬프트에 불필요한 조건을 추가하면 모델이 해석 부담을 안게 되어 출력 품질이 급격히 저하된다.

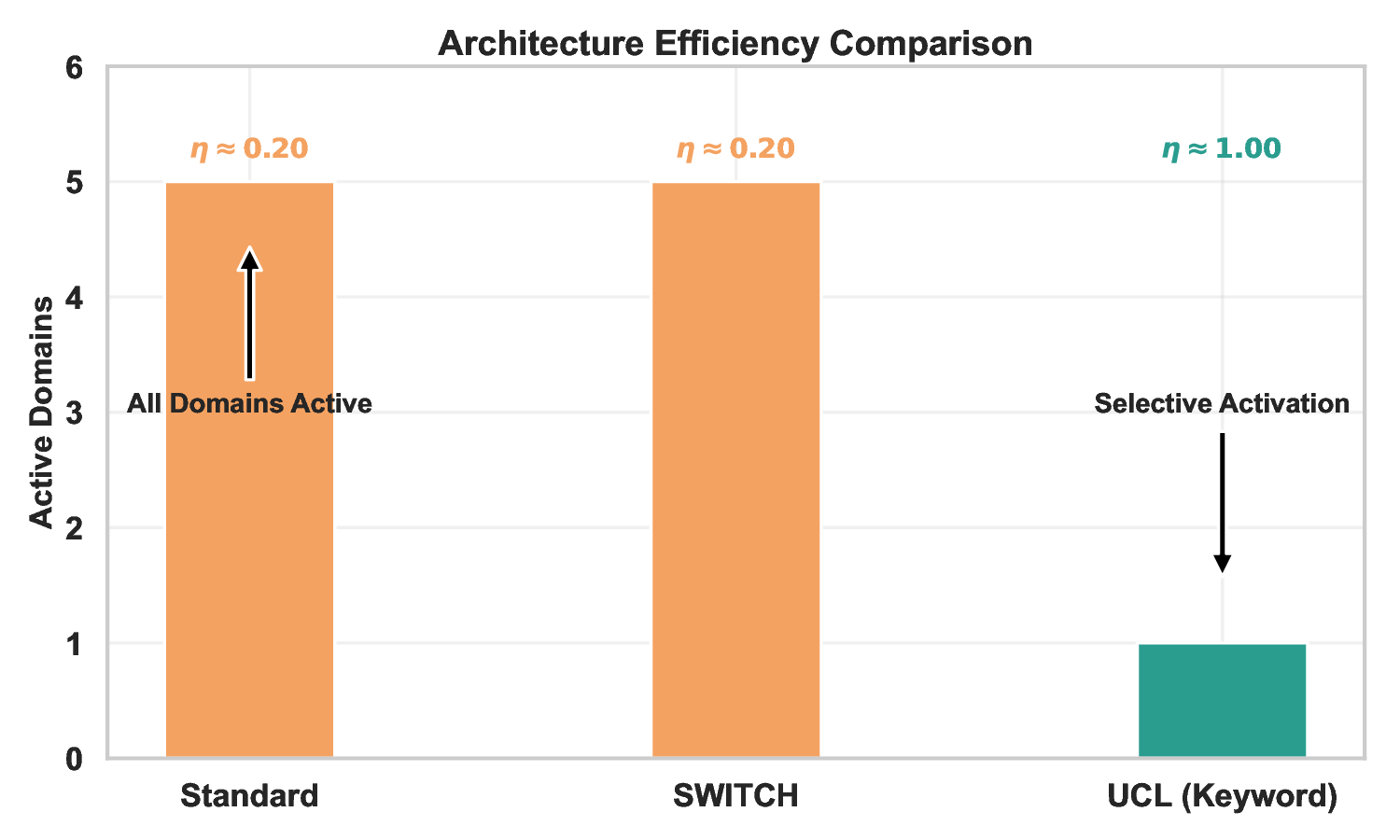

또한, 지시자 함수 Ii∈{0,1}는 특정 조건이 활성화되는지를 이진값으로 표시하며, 초기 바인딩 메커니즘은 프롬프트가 모델에 전달되는 순간에 변수와 컨텍스트를 고정시켜 일관된 응답을 유도한다. 실험 결과, 이러한 메커니즘을 적용한 프롬프트는 동일한 작업에서도 변동성을 크게 줄였으며, 특히 Llama 4 Scout과 같은 최신 모델에서는 버전‑특화 적응(V4.1)이 필요함을 확인했다. 이는 모델마다 내부 파라미터와 토큰 처리 방식이 다르기 때문에, UCL이 제공하는 ‘조정 가능한 파라미터 집합’을 통해 개별 모델에 맞춤형 최적화를 수행해야 함을 의미한다.

결론적으로, UCL은 프롬프트 설계 과정에서 ‘얼마나 많은 정보를 제공해야 하는가’라는 근본적인 질문에 정량적 답을 제공한다. 모델‑가족별 최적화가 향후 연구의 핵심 과제로 부각되며, UCL을 기반으로 한 자동화 도구가 상용화될 경우 LLM 활용 비용을 획기적으로 낮출 수 있을 것으로 기대된다.

📄 논문 본문 발췌 (Translation)

📸 추가 이미지 갤러리