Vulcan LLM 기반 탐색을 통한 인스턴스 최적 시스템 휴리스틱

📝 원문 정보

- Title: Vulcan: Instance-Optimal Systems Heuristics Through LLM-Driven Search

- ArXiv ID: 2512.25065

- 발행일: 2025-12-31

- 저자: Rohit Dwivedula, Divyanshu Saxena, Sujay Yadalam, Daehyeok Kim, Aditya Akella

📝 초록 (Abstract)

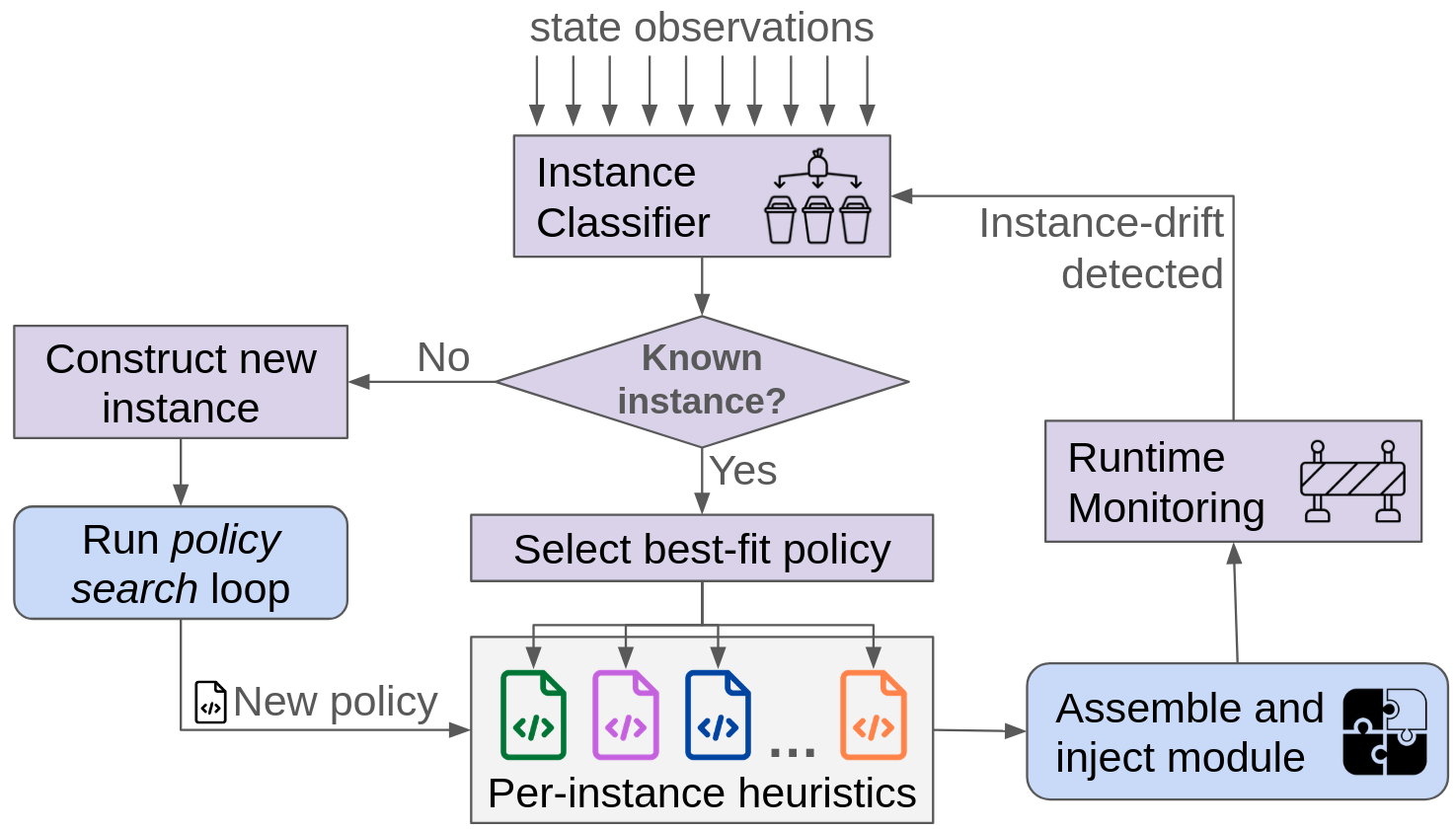

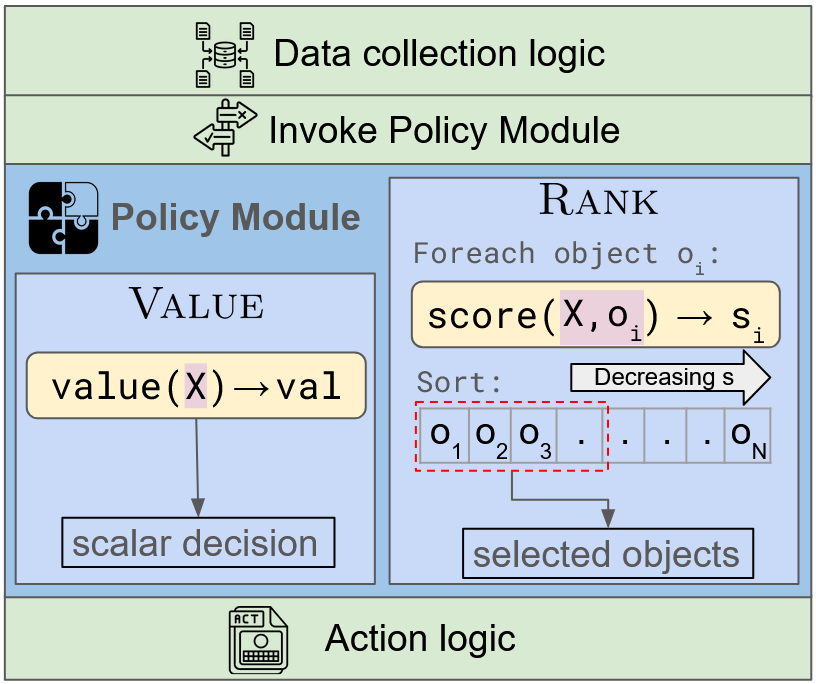

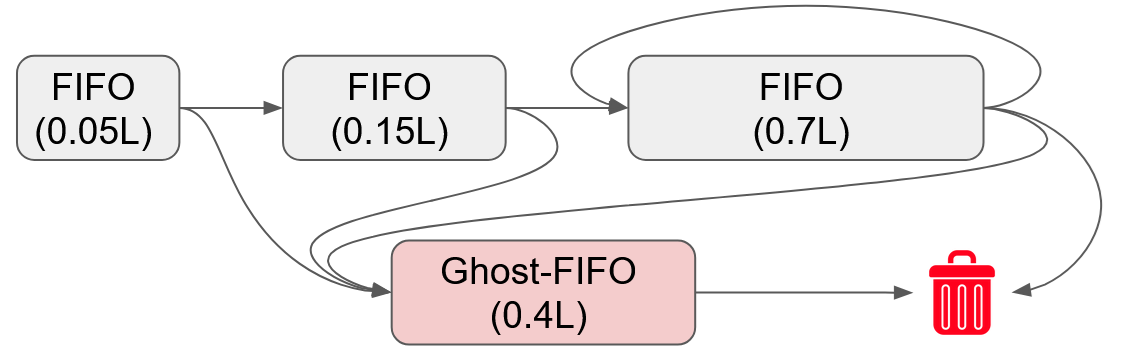

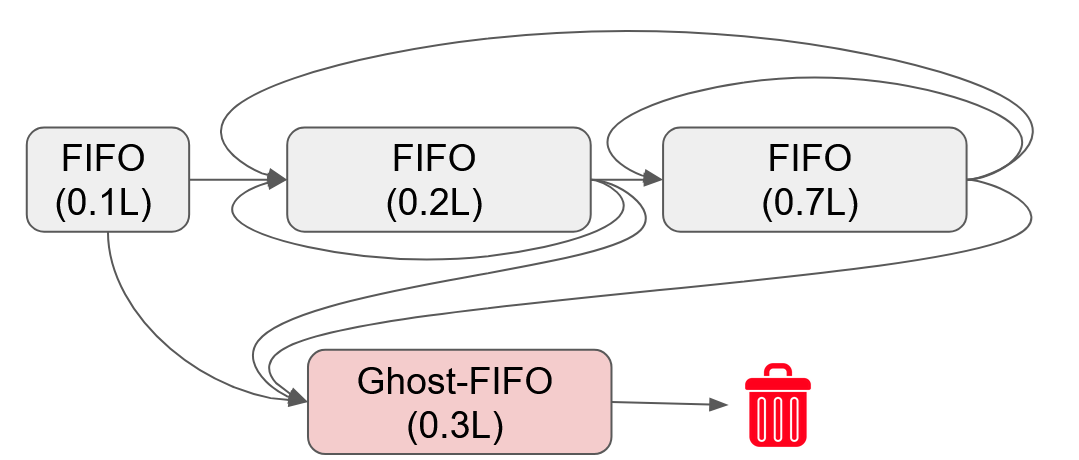

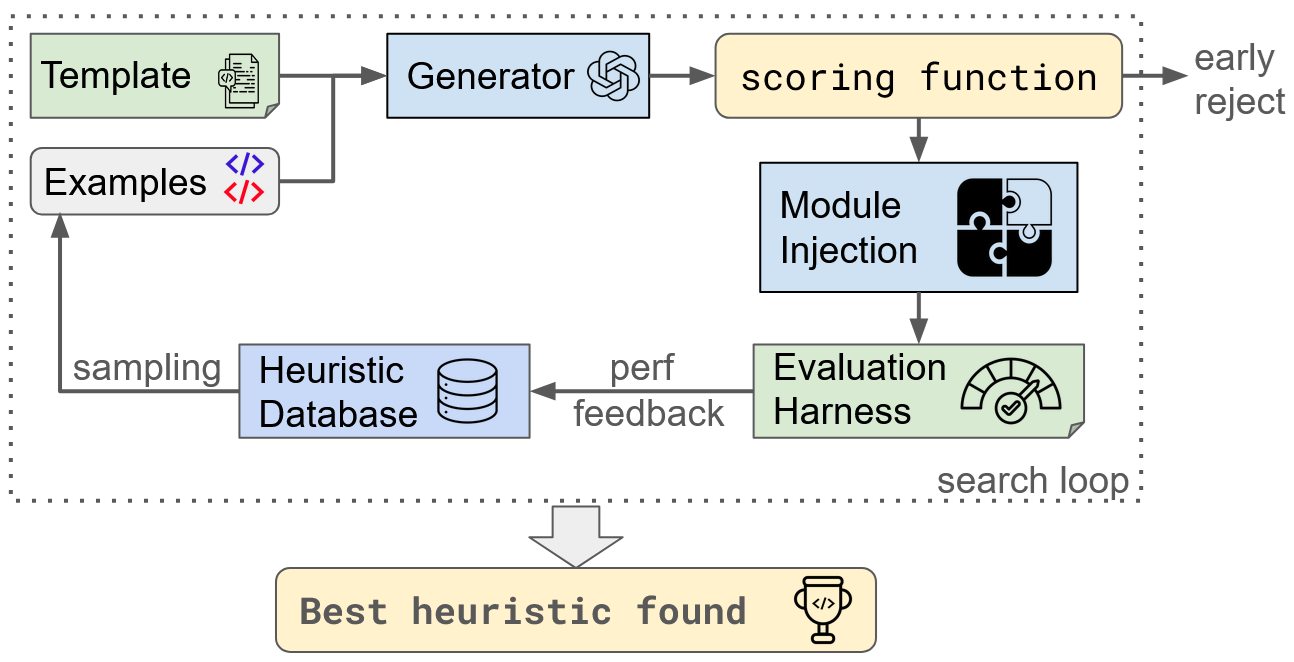

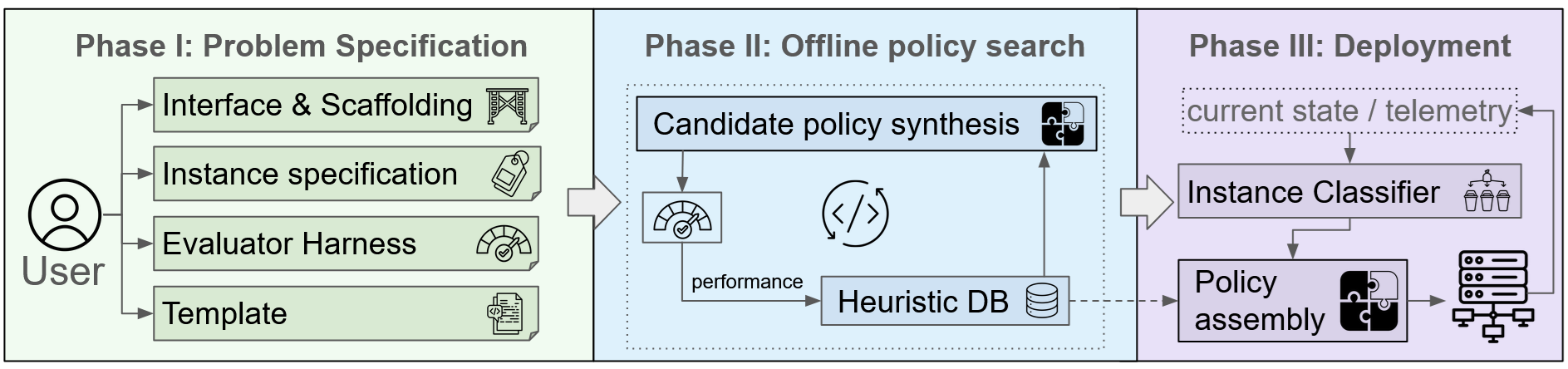

현대 운영·분산 시스템의 자원 관리 작업은 스케줄링, 캐시 교체, 활성 큐 관리 등에서 여전히 손수 설계한 휴리스틱에 의존한다. 하드웨어·워크로드·환경이 지속적으로 변동함에 따라 성능 좋은 휴리스틱을 만들기 위한 설계 비용과 시간이 크게 증가한다. 본 논문은 이러한 문제를 해결하기 위해, 정확히 배포될 워크로드와 하드웨어에 특화된 **인스턴스 최적** 휴리스틱을 코드 생성 LLM을 이용해 자동 합성하는 새로운 접근법을 제안한다. VULCAN은 정책과 메커니즘을 분리한 LLM 친화적인 작업‑무관 인터페이스를 제공한다. 사용자는 정책이 필요로 하는 입력과 목표를 인터페이스에 정의하고, VULCAN은 진화적 탐색을 통해 LLM이 생성한 코드 후보들을 평가·선택한다. 이 인터페이스는 다양한 시스템 정책을 표현할 수 있을 만큼 충분히 풍부하면서도, 작은 저비용 LLM도 올바르고 실행 가능한 코드를 만들 수 있을 정도로 제약을 둔다. VULCAN을 캐시 교체와 메모리 티어링에 적용한 결과, 기존 인간이 설계한 최첨단 알고리즘을 각각 최대 69 %와 7.9 % 정도 능가하는 성능 향상을 달성하였다.💡 논문 핵심 해설 (Deep Analysis)

두 번째 기여는 진화적 코드 탐색이다. VULCAN은 초기 프롬프트를 기반으로 여러 LLM 인스턴스가 생성한 코드 조각을 수집하고, 이를 변이·교배 연산을 통해 새로운 후보를 만든다. 각 후보는 실제 시스템 시뮬레이터 혹은 벤치마크 워크로드에 적용돼 성능 지표(예: 캐시 적중률, 메모리 대역폭 이용률)와 비용(실행 시간, 메모리 사용량)으로 평가된다. 이 과정은 전통적인 자동 프로그램 합성(Program Synthesis)에서 사용되는 SAT/SMT 기반 탐색보다 훨씬 스케일러블하며, LLM의 창의성을 유지하면서도 실험적 피드백을 통해 최적화한다는 점이 특징이다.

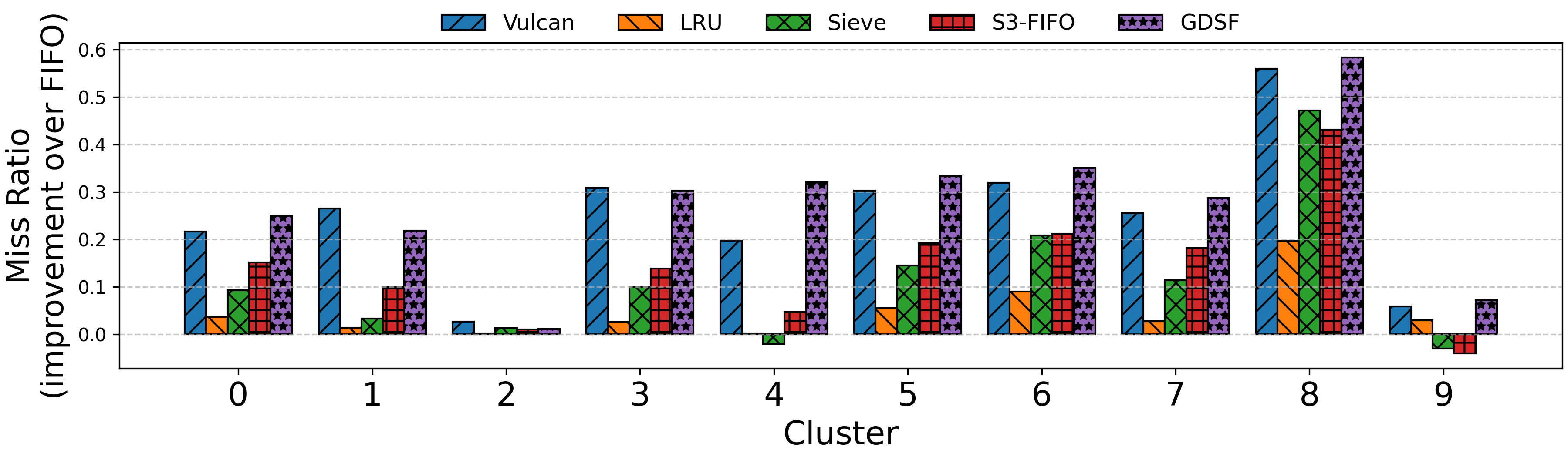

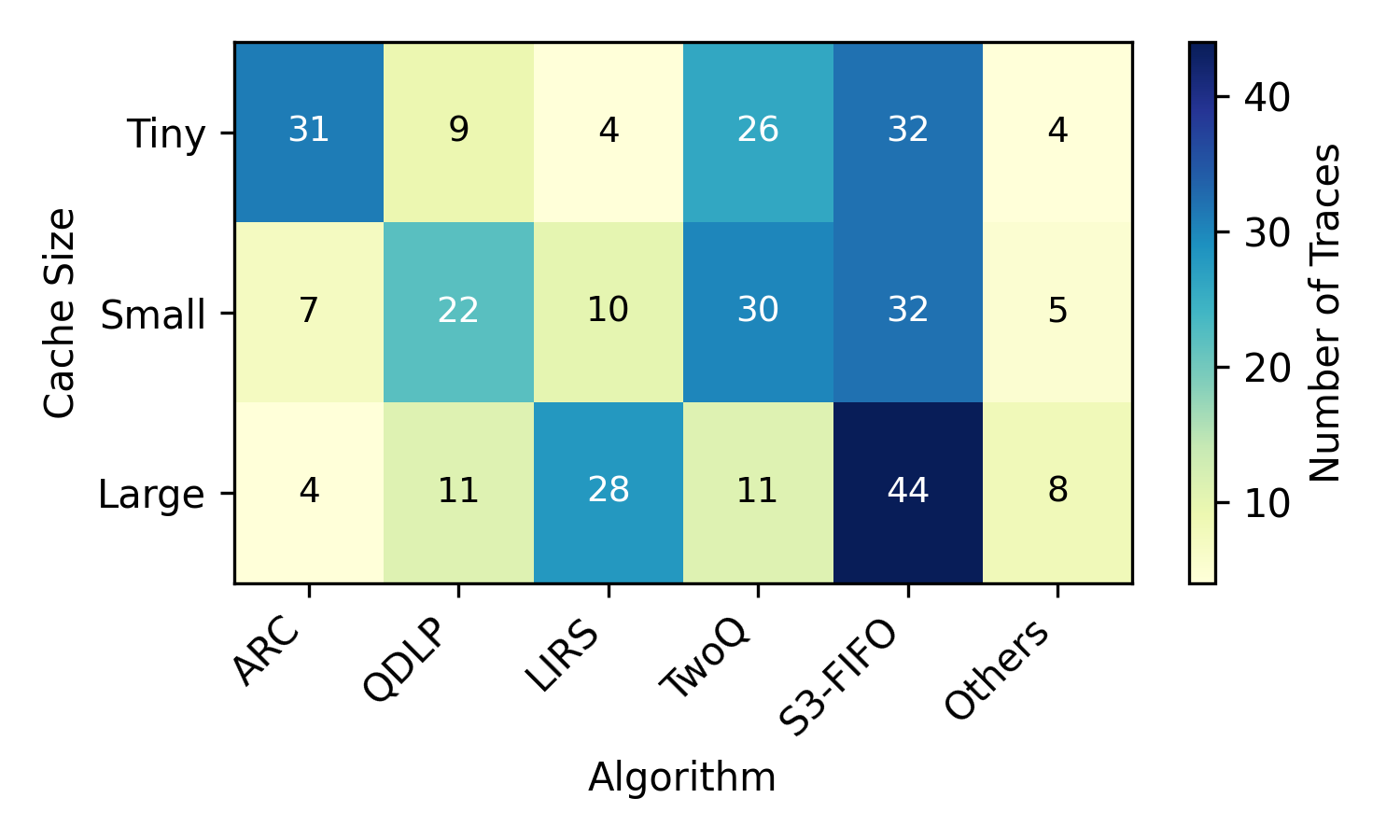

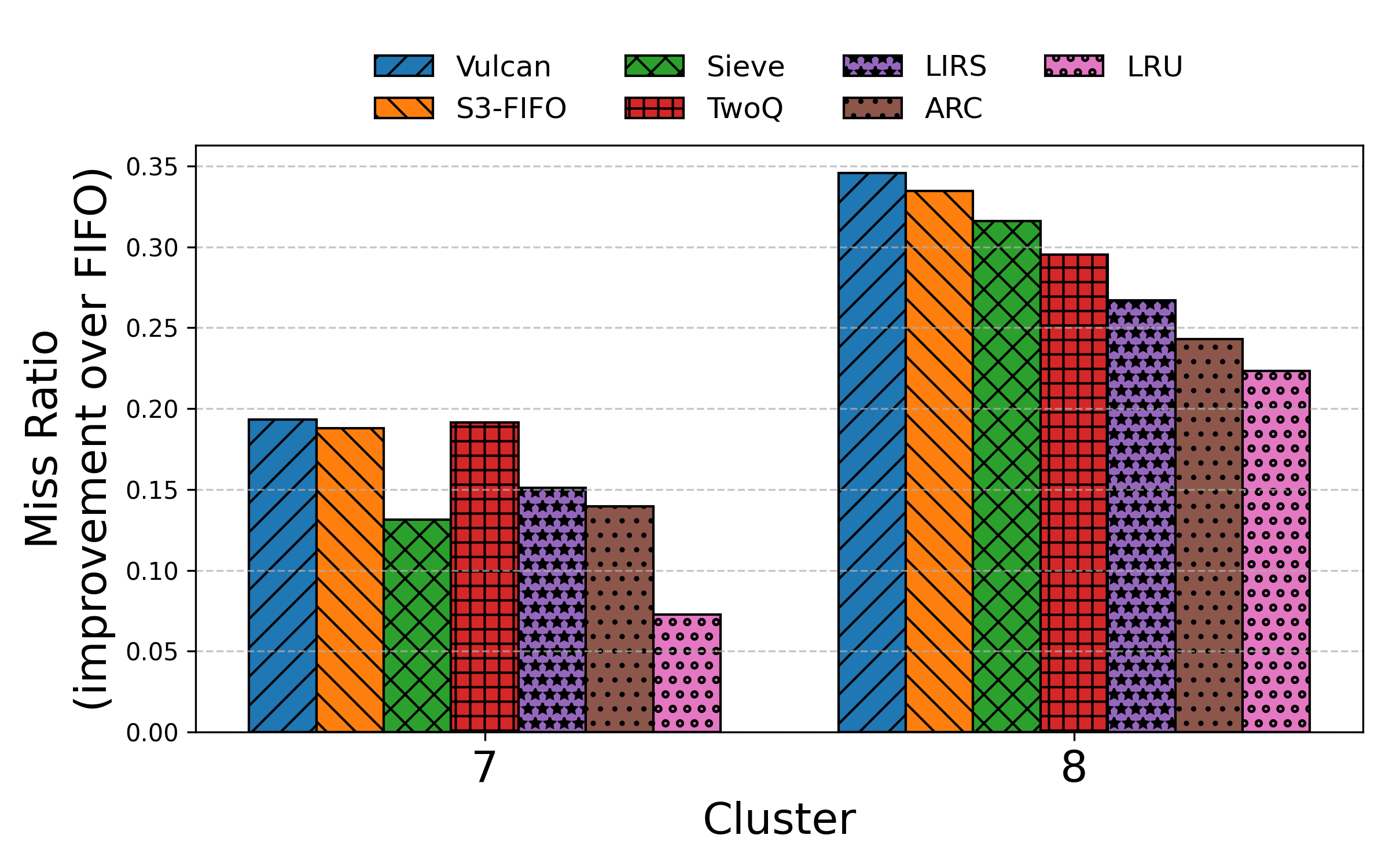

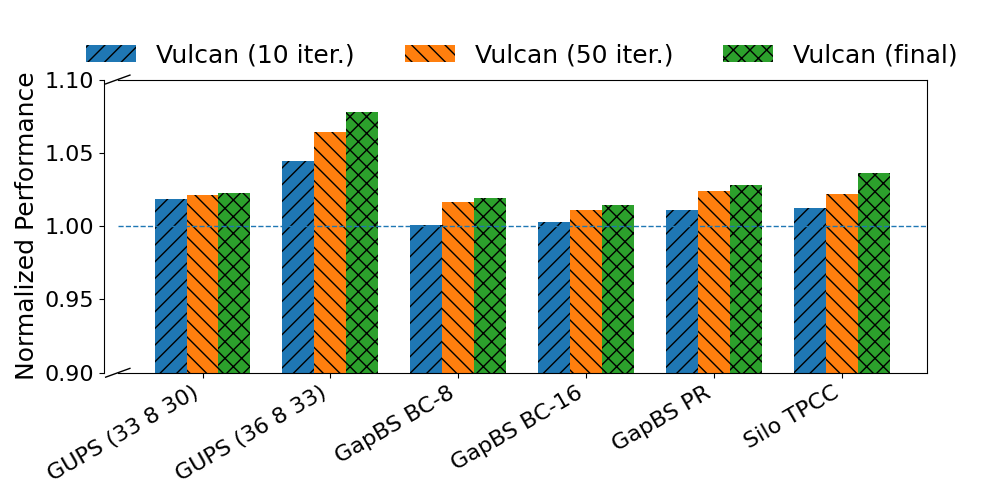

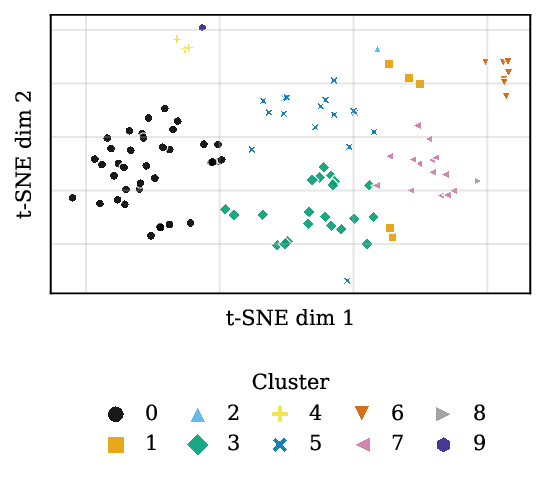

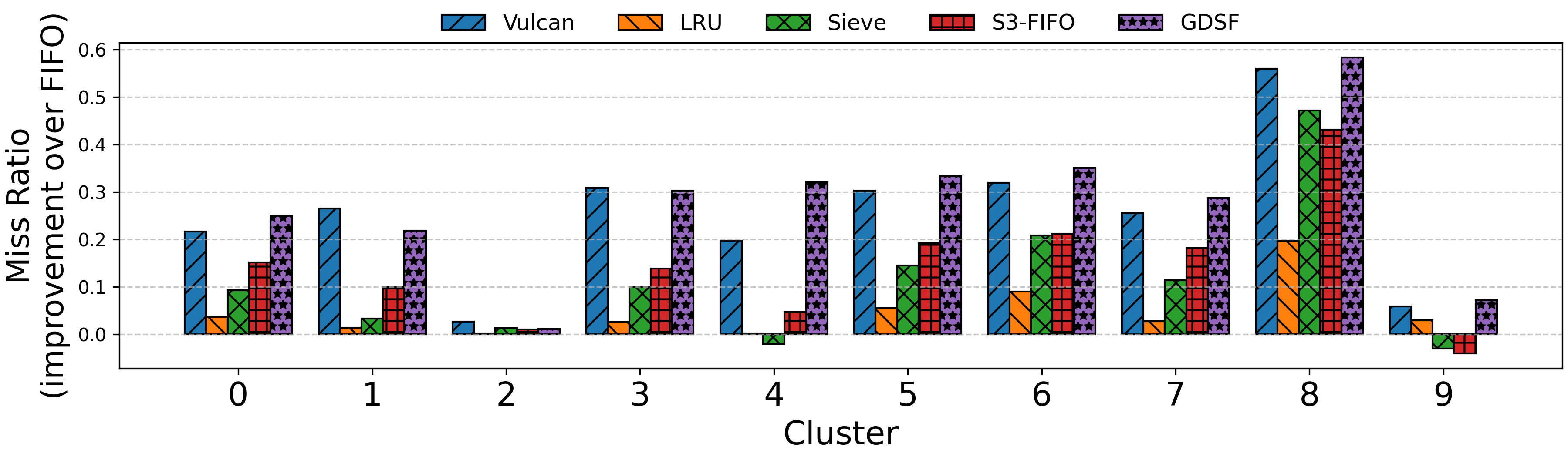

세 번째로, 논문은 인스턴스 최적이라는 개념을 실증한다. 기존 연구는 일반적인 워크로드 집합에 대해 평균적인 성능을 목표로 하는 반면, VULCAN은 특정 하드웨어·워크로드 조합에 맞춰 정책을 맞춤화한다. 캐시 교체 실험에서는 LRU, LFU, ARC 등 전통적인 알고리즘을 능가하는 새로운 정책을 자동으로 발견했으며, 특히 고밀도 메모리 계층을 가진 최신 서버 환경에서 69 %까지 성능 향상을 기록했다. 메모리 티어링에서는 데이터 접근 패턴이 복합적인 경우에도 기존 정책보다 7.9 % 높은 효율을 보였다. 이러한 결과는 도메인 전문 지식 없이도 LLM과 자동 탐색만으로도 경쟁력 있는 시스템 정책을 만들 수 있음을 입증한다.

하지만 몇 가지 한계도 존재한다. 첫째, 현재 실험에 사용된 LLM은 비교적 작은 모델이며, 복잡한 정책(예: 다중 목표 최적화, 실시간 제약)에서는 코드 품질이 떨어질 위험이 있다. 둘째, 진화적 탐색 과정에서 시뮬레이션 비용이 크게 증가한다는 점이다. 대규모 클러스터 환경에서는 시뮬레이터 자체가 병목이 될 수 있어, 비용 효율적인 샘플링 전략이 필요하다. 셋째, 생성된 코드의 안전성·검증 문제가 남아 있다. 현재는 실행 전 기본적인 타입 체크와 제한된 정적 분석만 수행하지만, 운영 시스템에 직접 배포하기 위해서는 포괄적인 형식 검증과 런타임 보호 메커니즘이 필수적이다.

향후 연구 방향으로는(1) 더 큰 LLM과 프롬프트 튜닝을 결합해 복잡한 정책 공간을 탐색하고, (2) 멀티-오브젝트 진화를 도입해 성능·전력·지연 등 여러 목표를 동시에 최적화하며, (3) 자동 생성 코드에 대한 형식적 검증 프레임워크를 구축해 실운영 적용성을 높이는 것이 제시된다. 전반적으로 VULCAN은 시스템 정책 설계에 LLM을 활용한 새로운 패러다임을 제시함으로써, 지속적인 하드웨어·워크로드 변화에 대응하는 자동화된 최적화 길을 열었다고 평가할 수 있다.

📄 논문 본문 발췌 (Translation)

📸 추가 이미지 갤러리