- Title: LearnAD Learning Interpretable Rules for Brain Networks in Alzheimer s Disease Classification

알츠하이머병(AD)은 신경퇴행성 질환으로, 뇌에 아밀로이드-베타 플라크와 타우 단백질 섬유가 축적되는 특징을 가진다. 이 연구에서는 AD의 진행과 발현 사이의 구조적 뇌 네트워크와 관련성을 이해하기 위해, 통계적 기계 학습 방법과 olic machine learning 방법을 결합한 새로운 접근법인 LearnAD를 제안한다. LearnAD는 MRI 데이터에서 추출된 특징들을 이용하여 AD를 예측하고, 이를 통해 뇌의 구조적 패턴이 AD에 어떻게 영향을 미치는지 학습한다.

1. **3가지 주요 기여**: 알츠하이머병(AD) 진단에서 통계적 기계학습과 심벌릭 머신러닝의 결합은 예측력 뿐만 아니라 해석 가능성까지 갖춘 모델을 제공한다.

2. **간단한 설명 및 비유**: 이 연구는 AD를 예측하는 것을 자동차 조립에 비유할 수 있다. 통계적 기계학습은 차체와 엔진, 심벌릭 머신러닝은 운전자의 판단과 같은 역할을 한다.

3. **Sci-Tube 스타일 스크립트**:

- 초보자: "알츠하이머병 예측에서 통계적 기계학습과 심벌릭 머신러닝의 결합은 무엇인가요?"

- 중급자: "LearnAD는 MRI 데이터를 통해 알츠하이머병을 예측하고, 이를 통해 뇌 구조적 패턴을 이해합니다."

- 고급자: "GNN과 FastLAS의 결합으로 AD 진단에 있어 높은 해석 가능성과 예측력을 동시에 제공합니다."

# 소개

알츠하이머병(AD)은 아밀로이드-베타 플라크의 외세포적 축적이 이어져 치매와 인지능력 저하 등의 임상 및 인지 증상을 나타내는 진행성 신경퇴행 질환이다. 그러나 이러한 변형 단백질은 임상 증상과 인지 증상이 나타나기 전에 뇌에서 발견된다. 따라서 AD의 병리학적 진행과 확산의 기제를 더 잘 이해하는 것은 AD의 조기에 진단하고 치료 대상을 식별하기 위한 필수 요소이다. 이를 위해 구조적 뇌 네트워크와 질병 진행 및 발현 간의 연관성을 이해하는 것이 하나의 방향이다. 본 연구에서는 알츠하이머 병상상 영상학 연구(ADNI)를 활용하여 인지 정상(CN)과 AD를 구분하는 규칙을 학습한다.

통계적 기계 학습 방법은 구조적 및 기능적 뇌 자기 공명 영상(MRI) 데이터로부터 알츠하이머 병(AD)을 예측하기 위해 사용되었다. 초기 연구는 지지 벡터 머신(SVMs), 의사결정 나무(DTs), 랜덤 포레스트(RFs) 등의 분류기를 사용한 수작업 특징에 의존하였다. DTs는 SVMs와 RFs보다 해석 가능성이 더 높아, 학습된 지식을 설명해야 할 때 선호된다. RFs는 여러 개의 DT에서 예측을 통합하여 일반화를 향상시키고, 일반적으로 DTs보다 우수하지만 투명성은 감소한다.

최근 ADNI와 같은 대규모 데이터셋이 이용 가능하게 되면서, 깊은 컨볼루션 신경망(CNN)들이 최소한의 사전 처리 MRI 데이터에서 구별력 있는 패턴을 학습하는 것으로 나타났다. 이러한 모델들은 특히 횡단면적 AD에 강력한 성능을 보이지만, 예측 과정은 불투명하다는 단점이 있다. 그래프 신경망(GNNs)은 의료 분야에서 점점 더 많이 연구되고 있으며, 뇌의 네트워크 조직을 포착하는 자연스러운 방법으로 AD를 모델링하는 유력한 패러다임으로 부상하고 있다. 일반적으로 노드는 관심 영역(ROIs)을 나타내고, 에지는 MRI에서 파생된 구조적 또는 기능적 연결성을 인코딩한다. 메시지 전달은 정보 흐름에 대한 지역 이웃 사용이 가능하게 하여, 글로벌 표현 학습 시 예측이 그래프의 자연스러운 지역 구조에 의해 크게 영향을 받는다. 임상 컨텍스트에서 GNNs는 AD를 예측하는 데 중요한 구조적 패턴을 학습한다. 그러나 학습된 모델을 해석할 때, 특정 노드 특징, 에지 및 서브그래프가 추론 과정에 어떤 기여를 하는지는 명확하지 않다.

AD의 예측적 모델 학습 시 해석 가능성을 해결하는 것은 여전히 개방적인 도전과제이다. 심벌릭 머신러닝은 구조화된 데이터와 도메인 지식에서 학습하고, 검증 가능한 의사결정을 제공함으로써 형식적 보장을 갖춘 새로운 학습 패러다임을 제시한다. 논리 형태로 표현된 학습된 예측 모델은 본질적으로 투명하며 인간이 해석할 수 있다. 그러나 MRI 데이터의 구조화되지 않은 성격과 AD를 예측하는 복잡성으로 인해 그 적용 가능성과 확장성이 제한적이다. 따라서 이러한 문제를 해결하기 위해, 구조화되지 않은 MRI 데이터로부터 관련된 구조화된 특징을 자동적으로 공학화하여 검색 공간을 제어하면서도 예측 성능을 유지할 수 있는 새로운 방법이 필요하다.

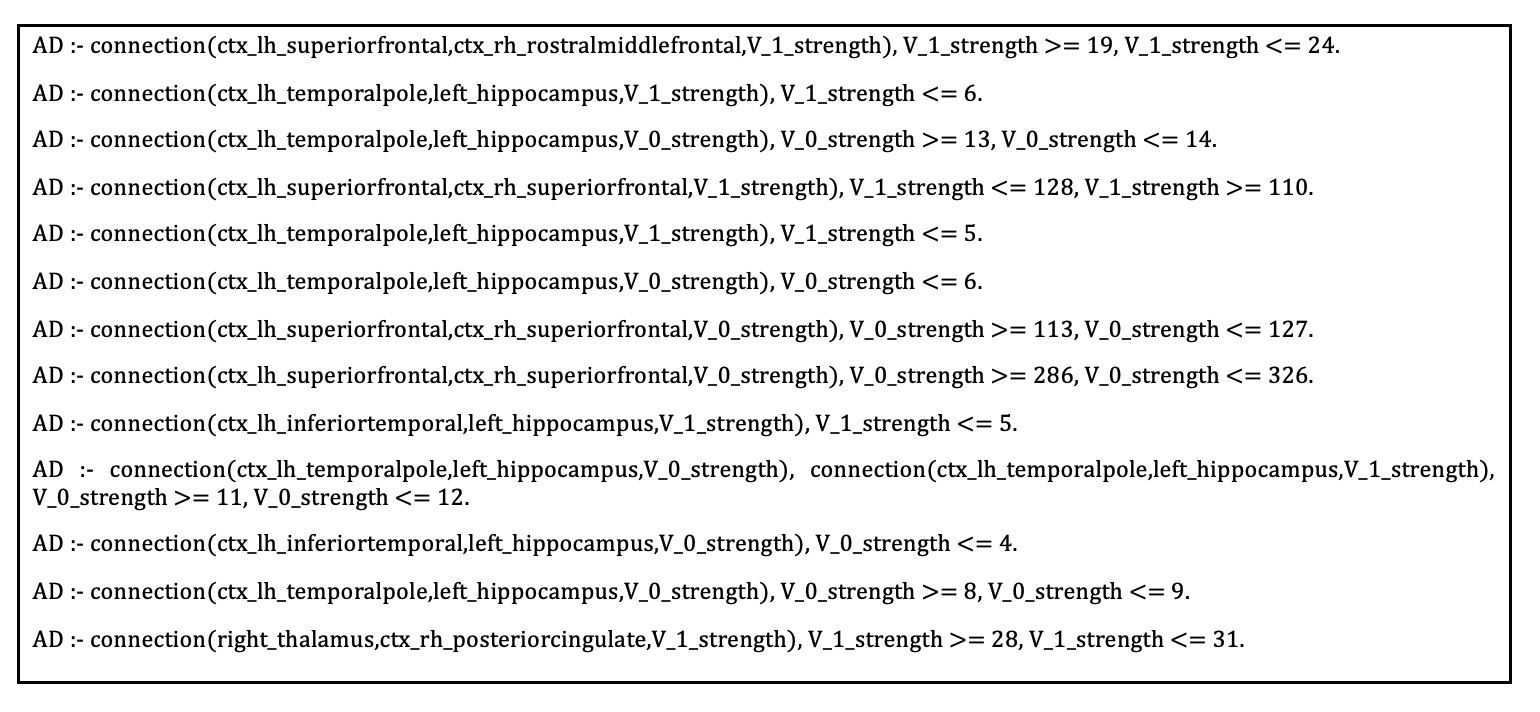

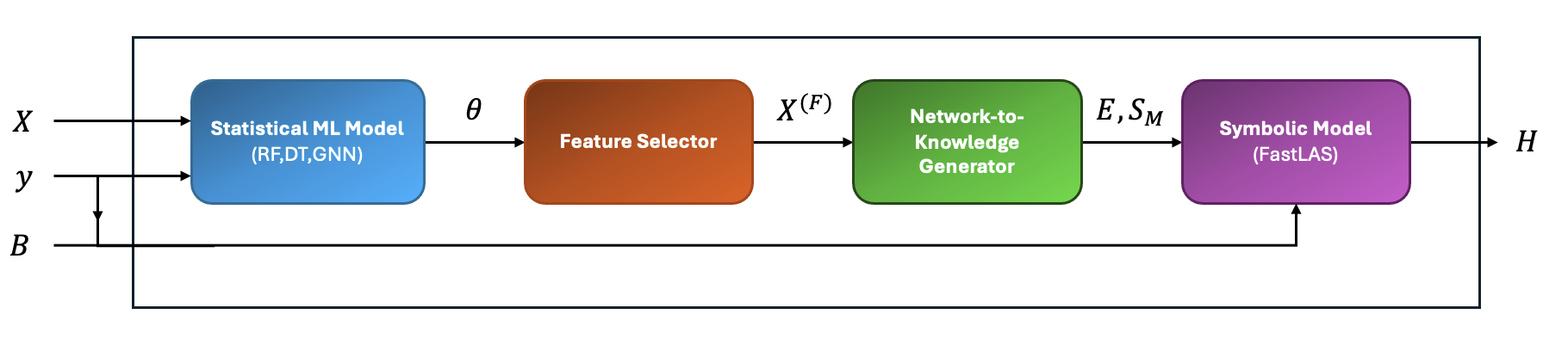

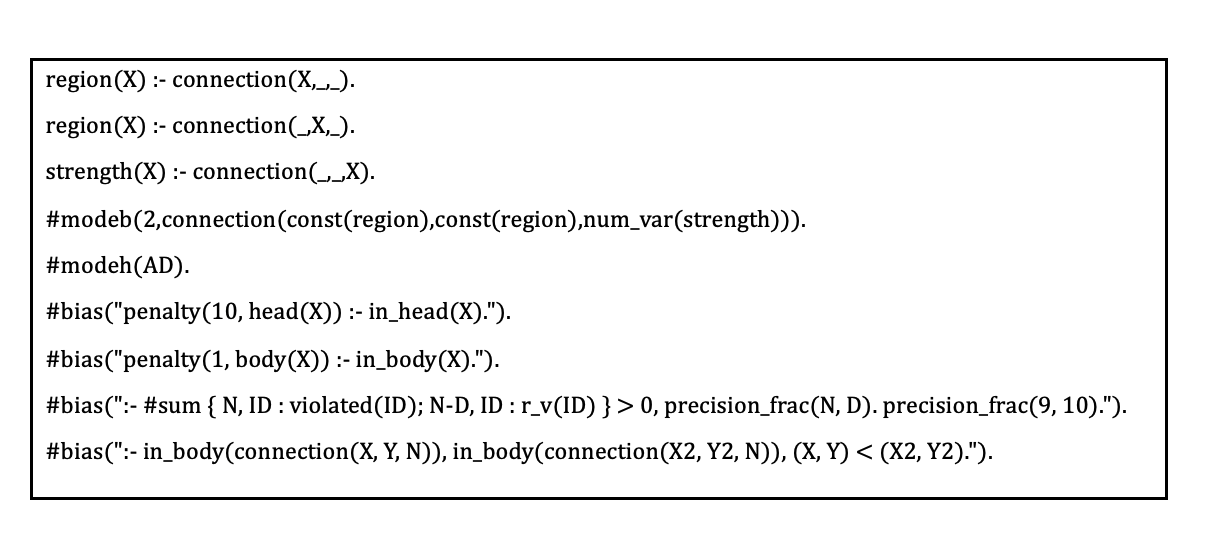

본 연구에서는 LearnAD를 제안한다. 이는 통계적 기계 학습과 심벌릭 학습을 결합한 새로운 뉴로-심볼릭 접근법으로서, 뇌의 구조적 MRI로부터 AD를 예측하기 위한 전역 해석 가능 규칙을 학습한다. 첫째로, 구조적 MRI 데이터에서 추출된 라벨링 특징에 대해 통계적 기계 학습 구성 요소가 훈련된다. 이 훈련 모델로부터 AD 환자의 분류에 가장 관련성이 있는 특징들이 선택된다. 두 번째 단계에서는 FastLAS라는 심벌릭 머신러닝 시스템을 사용한다. 이는 잡음이 있는(구조화되지 않은) 데이터에서 해석 가능 규칙 기반 모델을 학습하는 것으로 알려져 있다. 라벨링 환자 데이터(AD vs CN)로부터 자동으로 생성되는 심벌릭 예들은 첫 번째 단계에서 선택된 관련 특징의 환자 인스턴스 값들을 구조화된 컨텍스트 정보로 표현한다. 선택된 특징은 또한 심벌릭 학습기의 검색 공간을 제약하는 데 사용된다. FastLAS에 의해 생성된 예측 모델은 뇌의 다양한 지역 수준 연결성을 횡단하여 일반화하며, AD와 CN을 구분하는 가장 관련성이 있는 영향받는 뇌 연결성을 결정하고, 이러한 영역에 대한 준모수적 경계를 설정한다.

우리는 세 가지 다른 접근 방식의 인스턴스를 고려하는데, 각각 DT, RF 및 GNN이라는 서로 다른 통계적 기계 학습 모델을 사용하여 가장 관련성이 있는 지역 서브그래프를 학습한다. 이를 통해 이러한 통계적 기계 학습 모델들 중 어느 것이 심벌릭 학습기와 결합될 때 가장 효과적인 특징 선택을 제공하는지 평가한다. 교차 검증을 사용하여 세 가지 다른 인스턴스를 평가하고, DT에서 추출된 특징을 사용한 예측 모델의 정확도가 나머지 두 인스턴스보다 우수함을 보인다. 전체 특징 집합에 대해 훈련된 DT, RF 및 GNN을 기반으로 하는 모델을 사용하여 심벌릭 학습기의 일반화 능력이 제한된 특징 집합에서도 유사한 정확도를 달성할 수 있는지 평가한다.

우리의 결과는 가장 우수한 인스턴스가 DT보다 우월하며, SVM과 동등하고 전체적인 특징 집합에 대해 훈련된 RF 및 GNN보다 약간 열세라는 것을 보여준다. 모든 경우에서 우리의 접근법은 완전히 해석 가능하다. 마지막으로, 결합 뉴로-심볼릭 접근법과 각각의 순수 통계적 기계 학습 방식을 비교하기 위한 아블레이션 연구를 수행한다. GNN이 희소 네트워크에서 훈련될 수 없기 때문에 DT와 RF 모델만 고려한다. 우리의 아블레이션 연구는 결합 뉴로-심볼릭 접근법이 DT보다 우수하고, 동일한 선택된 특징으로 학습된 RF에 대해 약간 열세라는 것을 보여주지만, 심벌릭 학습을 통해 생성된 예측 모델의 해석 가능성은 RF 학습 모델보다 훨씬 높다.

이 논문은 다음과 같이 구성된다. 섹션 2에서는 우리의 접근법에 기반을 두는 기술들을 소개한다.

섹션 3에서는 실험에서 사용하는 ADNI 데이터셋의 사전 처리를 설명하며, 이어서 섹션 4에서는 우리의 뉴로-심볼릭 접근법을 제시한다. 섹션 5에서는 실험 결과를 논의하고,

섹션 6은 AD 예측 분야에서 관련 작업을 요약하며, 마지막으로 섹션 [sec:conclusions]에서는 논문을 결론짓고 향후 연구 방향성을 제안한다.

배경

이 섹션에서는 우리의 접근법을 이해하는 데 필요한 두 가지 주요 주제를 다룬다. 통계적 기계 학습 방법과 Learning from Answer Sets 프레임워크 및 그 현재 최신 상태(SOTA) 시스템인 FastLAS에 대해 간략히 설명한다.

통계적 기계 학습

이 논문에서는 DT, RF 및 GNN을 이용한 이진 분류 작업을 중점으로 다룬다. CART는 가장 널리 사용되는 이진 분류 의사결정 나무 학습 방법들 중 하나이다. 라벨링 데이터셋 $`D=\{(X,y)\}`$가 주어졌을 때, CART 알고리즘은 라벨링 데이터를 커버하는 이진 트리 모델을 학습한다. 내부 노드는 $`X`$의 특징에 대한 의사결정 포인트이다. 학습된 나무의 각 가지는 데이터에서 학습되는 특징들로부터 주어진 라벨링 데이터를 최대한 커버하도록 하는 결정 규칙을 나타낸다.

CART는 재귀적인 이진 알고리즘이며, 각 노드에서는 가장 잘 분리하는 특징과 분할 포인트를 선택한다. Gini 불순도를 줄이기 위해 데이터를 분리한다. Gini 불순도는 해당 노드에서 클래스들이 얼마나 혼합되어 있는지(혹은 얼마나 균일한지) 측정하며, 특히 해당 노드에 따라 라벨링되는 임의로 선택된 샘플이 잘못 분류될 확률을 측정한다. 수식적으로 Gini 불순도는 다음과 같이 정의된다:

\begin{equation}

\label{eq:gini}

I_G = 1 - \sum_{j=1}^{C} {p_j}^2.

\end{equation}

여기서 $`C`$는 클래스 수, 그리고 $`p_j`$는 해당 노드에서 클래스 $`j`$에 속하는 샘플의 비율이다. 알고리즘은 특징 공간을 가능한 한 “순수한” 영역으로 분할하고자 하며(즉, Gini 불순도가 최소화되는), 각 영역이 이상적으로는 하나의 클래스만을 포함하도록 한다.

RF는 DT의 확장이며 여러 개의 DT를 사용하여 $`X`$에서 부트스트랩 서브샘플링된 특징을 학습하고, 예측 정확성을 향상시키기 위해 평균화를 활용한다.

그래프 신경망(GNNs)은 그래프 구조 데이터에서 직접 작동하도록 설계된 딥 러닝 모델의 한 종류이다. 정보는 노드(엔티티)와 에지(관계)로 표현된다. 가장 널리 사용되는 GNN 중 하나는 Graph Convolutional Networks (GCN)이다. GCNs의 목표는 노드 임베딩과 그래프 표현을 학습하여 하류 분류를 수행하는 것이다. GCN은 $`m`$개의 노드와 각 노드에 대한 $`n`$개의 특징이 있는 이진 무방향 그래프이다. 이를 인접 행렬 $`A \in \{0,1\}^{m \times m}`$, 그리고 특징 행렬 $`X \in \mathbb{R}^{m \times n}`$로 표현한다. 가중치 그래프의 경우, 에지 가중치가 실수일 때 인접 행렬은 $`A \in \mathbb{R}^{m \times m}`$으로 확장된다. 학습 중 단일 GCN 계층이 노드 임베딩을 업데이트한다.

\begin{equation}

H^{(l+1)} = \sigma(\tilde{D}^{-1/2}\hat{A}\tilde{D}^{-1/2}H^{(l)}W^{(l)})

\end{equation}

여기서 $`\hat{A}=A+I`$, $`\tilde{D}^{-1/2}`$는 대각도 행렬, $`W^{(l)}`$는 학습 가능한 가중치 행렬이고, $`\sigma`$는 활성화 함수이다. 이 변환은 각 노드에서 그 지역 이웃으로부터 정보를 집계하여 계층별로 업데이트된 노드 임베딩을 생성한다. 최종 분류를 위해 노드 임베딩을 전역 그래프 표현으로 풀링하는 읽기 단계가 수행되고, 멀티레이어 퍼셉트론이 최종 분류를 생산한다.

예측에 중요한 에지를 추출하기 위해 GNNExplainer을 구현한다. GNNExplainer은 간결성, 속도 및 모든 GNN 아키텍처에 적용 가능한 모델-agnostic 설계로 인해 선택되었다. 목표 분류를 가진 그래프 $`G`$에서, GNNExplainer는 중요한 예측을 위한 부분그래프 $`G_s \in G`$, 그리고 특징의 축소된 하위 집합 $`X_s = \{x_i | v_i \in G_s\}`$를 찾고자 한다. 중요성은 상호 정보(MI)에 대한 것으로, GNNExplainer는 함수를 최대화하려고 시도한다:

\begin{equation}

\label{eq:maxgs}

\max_{G_s} (Y,(G_s,X_s)) = H(Y) - H(Y | G = G_s, X = X_s).

\end{equation}

최적화 세부 사항은 원래 논문을 참조하십시오. 현재로서는 최종 결과를 요약하면 다음과 같다: 부분그래프 $`G_s`$에 대한 인접 행렬에 대해 소프트 마스크가 학습된다, $`A_s \in [0,1]^{n \times n}`$.

Answer Set Programming에서 학습

Answer Set Programming(ASP)에서의 학습은 ASP 프로그램을 학습하는 심벌릭 머신러닝 패러다임이다. 먼저 ASP 프로그램에 대해 간략히 설명한다.

ASP는 지식 표현과 추론을 위한 기호 형식화이다. 이 논문에서, ASP 프로그램은 정규 규칙과 제약 조건으로 구성된다. 정규 규칙은 다음과 같은 형태를 가진다: $`h`$ :- $`b_1`$, …, $`b_m`$, not $`c_1`$, …, not $`c_m`$. 여기서 $`h`$는 헤드이고, $`b_1`$, …, $`b_m`$, not $`c_1`$, …, not $`c_m`$은 규칙의 바디를 구성하며, not은 실패에 대한 부정을 나타낸다. 정규 규칙은 “모든 $`b_i`$가 참이고 어떤 $`c_j`$도 참이 증명되지 않으면 $`h`$는 참이다"라는 의미로 해석된다. 제약 조건은 다음과 같은 형태를 가진다: $`:\!-\; b_1,\cdots,b_n`$. 이는 바디가 만족되는 솔루션을 배제한다.

ASP 프로그램의 의미론은 Herbrand 해석에 기반한다. 주어진 프로그램 $`P`$의 Herbrand 해석은 $`P`$에서 나타나는 관계와 객체로부터 구성된 원자 집합이다. ASP 프로그램 $`P`$와 Herbrand 해석 $`I`$가 주어졌을 때, 재덕 프로그램 $`P^I`$는 다음 세 단계를 통해 구축될 수 있다: 1) $`I`$에 나타나는 부정된 원자가 포함된 모든 규칙을 제거한다. 2) 남은 규칙의 바디에서 모든 부정된 원자를 제거한다. 3) 제약 조건 헤드를 $`\perp`$(거짓을 의미함)으로 대체한다. 해석 $`I`$는 프로그램 $`P`$의 해답 집합(즉, 모델)이며, 재덕 프로그램 $`P^I`$의 최소 모델이다. 부분 해석은 다음 형태로 표현된다: $`e_{pi}=\langle e^{inc},e^{exc}\rangle`$, 여기서 $`e^{inc}`$와 $`e^{exc}`$는 각각 포함과 배제를 위한 원자들을 포함한다. 해석 $`I`$가 부분 해석 $`e_{pi}`$를 확장한다고 할 때, $`e^{inc} \subseteq I`$이고 $`e^{exc} \cap I = \emptyset`$이다.

Answer Set Programming에서 학습 작업은 튜플 $`\langle B,S_M,E\rangle`$로 구성되며 여기서 $`B`$는 배경 지식인 ASP 프로그램, $`S_M`$은 규칙의 집합인 가설 공간, 그리고 $`E`$는 예제의 집합이다. 가설 공간은 헤드나 바디에 등장할 수 있는 예언을 정의하는 일련의 모드 선언으로 지정된다. 이 연구에서는 최신 상태(SOTA) LAS 시스템인 FastLAS를 사용한다. FastLAS에서 예제는 가중치 컨텍스트 종속적 부분 해석 (WCDPI)로 알려져 있다. WCDPI는 다음과 같은 형태를 가진다: $`\langle e_{id}, e_{pen}, \langle e^{inc},e^{exc}\rangle,e_{ctx}\rangle`$, 여기서 $`e_{id}`$는 예제의 식별자이고, $`e_{pen}`$은 예제를 커버하지 않는 데 대한 벌금이며, $`\langle e^{inc},e^{exc}\rangle`$는 부분 해석이고 $`e_{ctx}`$는 예제에 특정 정보를 제공하기 위해 사용되는 ASP 프로그램인 컨텍스트이다. 주어진 LAS 작업의 솔루션은 가설이라고 불리며, 그것은 $`H \subseteq S_M`$인 ASP 프로그램이다. $`H`$가 예제 $`e`$를 커버한다고 할 때, $`B \cup e_{\text{ctx}} \cup H`$의 해답 집합 중 하나는 $`e^{inc}`$에 있는 모든 원자를 포함하고 $`e^{exc}`$에 있는 원자 없이 존재해야 한다. 가설 $`H`$의 점수는 $`H`$의 길이(즉, $`H`$에 등장하는 원자의 수)와 커버되지 않은 예제들의 벌금을 더한 값이다. 최적 솔루션은 점수가 최소인 가설 $`H \subset S_M`$이다.

FastLAS의 확장성은 주어진 가설 공간에서 최적 해결책이 존재함을 보장하는 opt-sufficient-subset의 계산에 근거한다.