물리 계획 성공을 이끄는 요인: 공동 임베딩 예측 세계 모델의 설계와 최적화

📝 원문 정보

- Title: What Drives Success in Physical Planning with Joint-Embedding Predictive World Models?

- ArXiv ID: 2512.24497

- 발행일: 2025-12-30

- 저자: Basile Terver, Tsung-Yen Yang, Jean Ponce, Adrien Bardes, Yann LeCun

📝 초록 (Abstract)

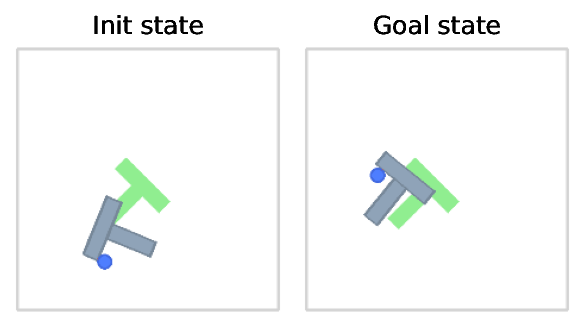

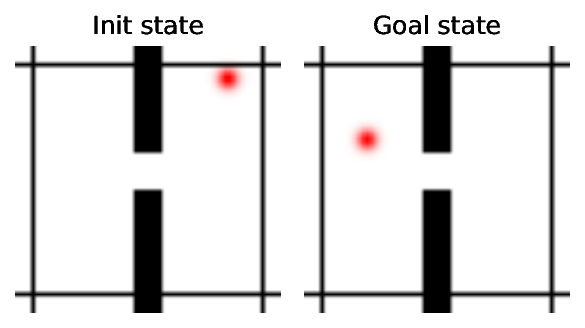

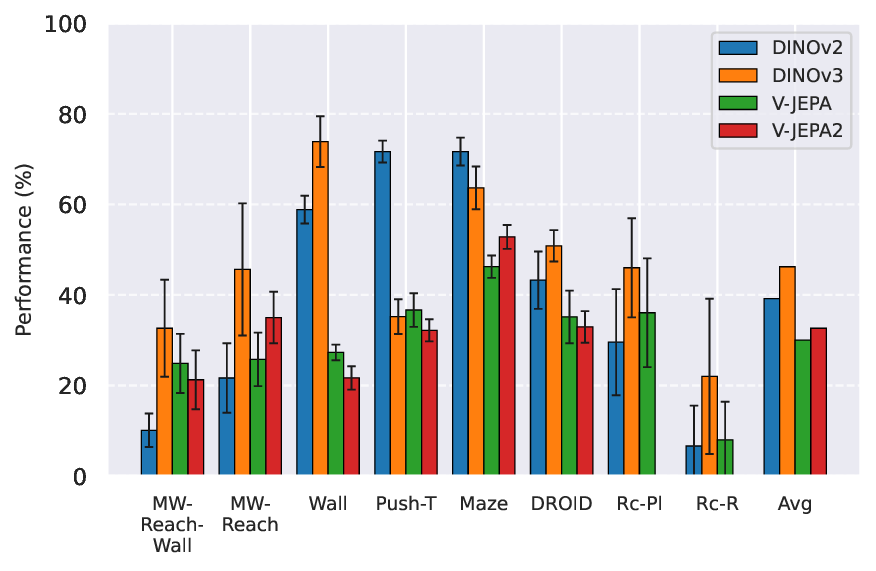

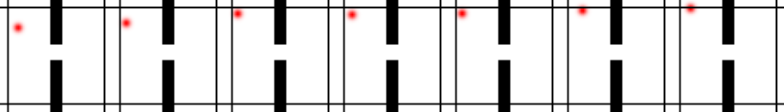

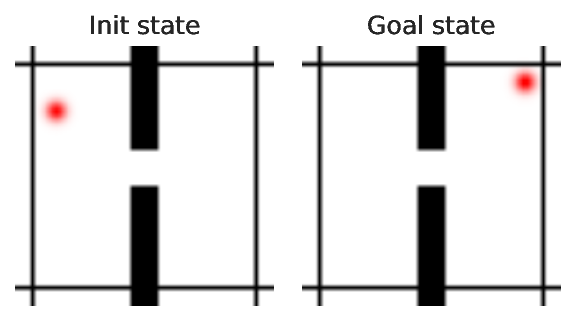

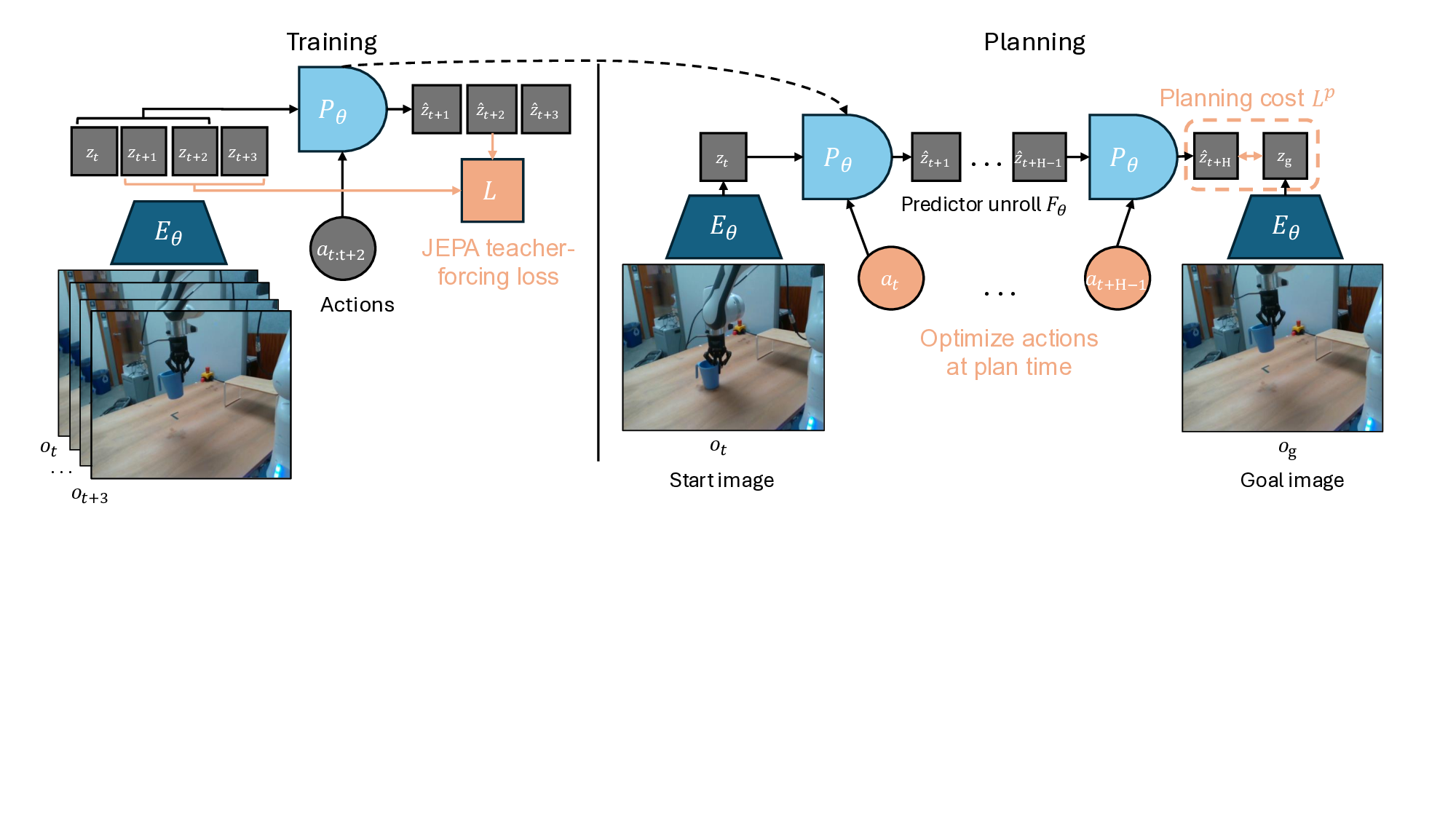

AI가 다양한 물리적 과제를 해결하고 새로운 환경에 일반화하는 것은 오랜 과제다. 최근에는 상태‑행동 궤적을 이용해 세계 모델을 학습한 뒤, 이를 계획 알고리즘과 결합해 새로운 과제를 해결하는 접근법이 주목받고 있다. 전통적인 계획은 입력 공간에서 수행되지만, 최근 등장한 방법들은 세계 모델이 학습한 표현 공간에서 최적화를 시도한다. 이는 불필요한 세부 정보를 추상화함으로써 계획 효율성을 높인다는 기대를 갖는다. 본 연구에서는 이러한 방법들을 JEPA‑WM이라 명명하고, 알고리즘이 제대로 작동하도록 하는 핵심 설계 선택들을 체계적으로 분석한다. 모델 아키텍처, 학습 목표, 그리고 계획 알고리즘이 계획 성공률에 미치는 영향을 시뮬레이션 환경과 실제 로봇 데이터 모두에서 실험하였다. 실험 결과를 종합해 DINO‑WM 및 V‑JEPA‑2‑AC 두 기존 베이스라인을 능가하는 모델을 제안하며, 이는 내비게이션과 조작 과제 모두에서 우수한 성능을 보인다. 코드·데이터·체크포인트는 https://github.com/facebookresearch/jepa-wms 에서 공개한다.💡 논문 핵심 해설 (Deep Analysis)

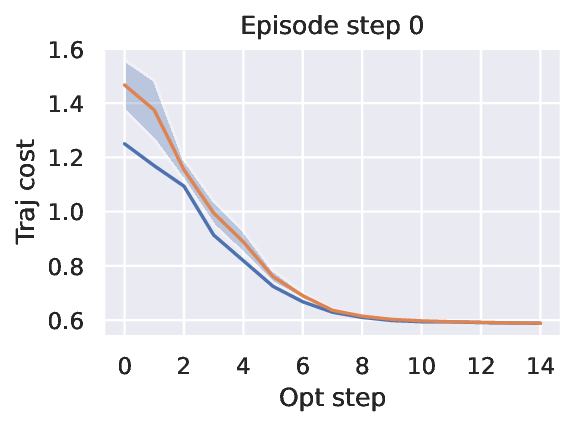

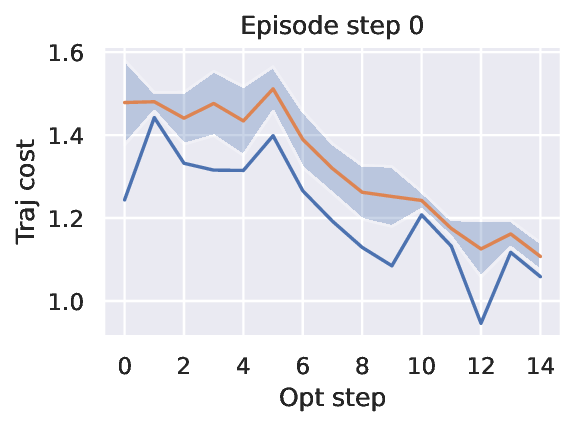

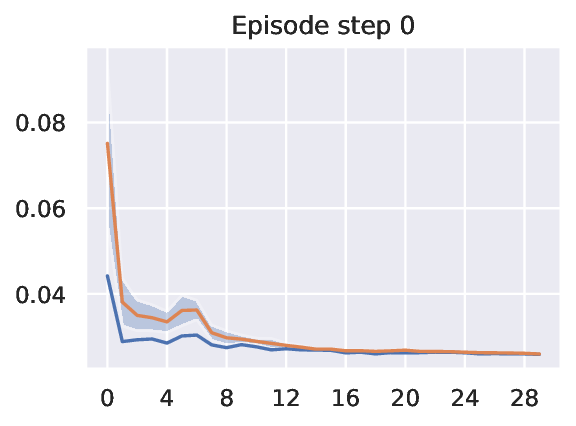

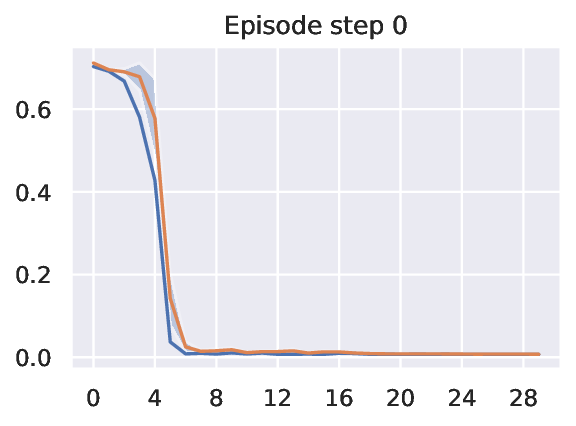

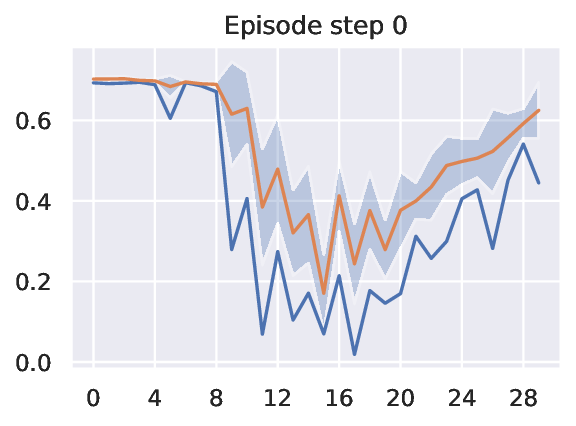

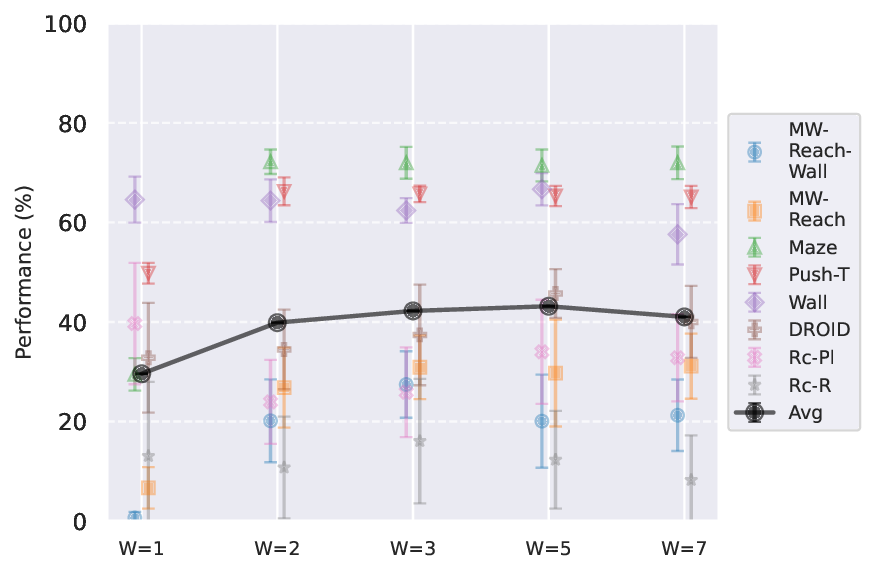

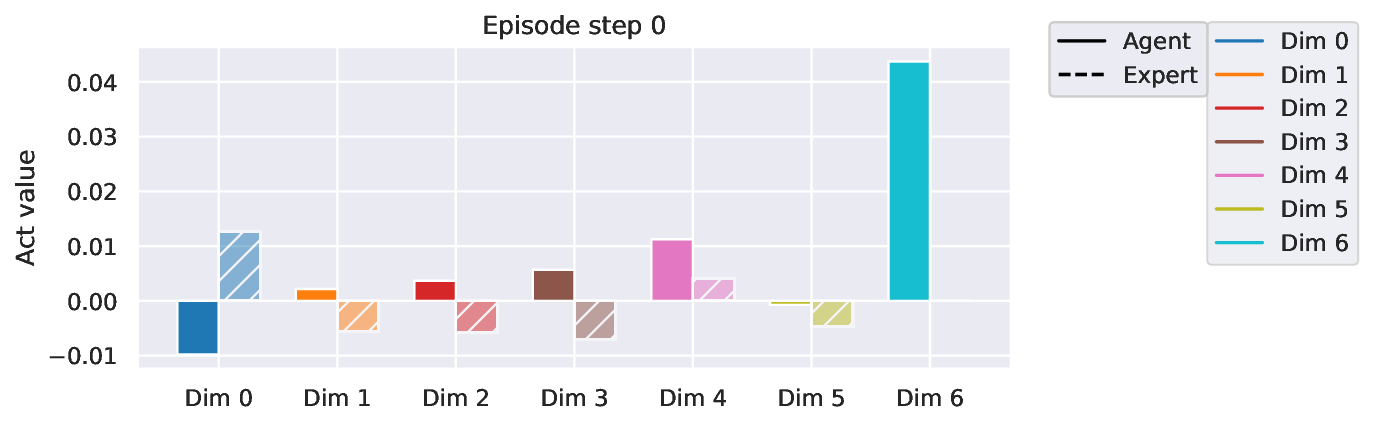

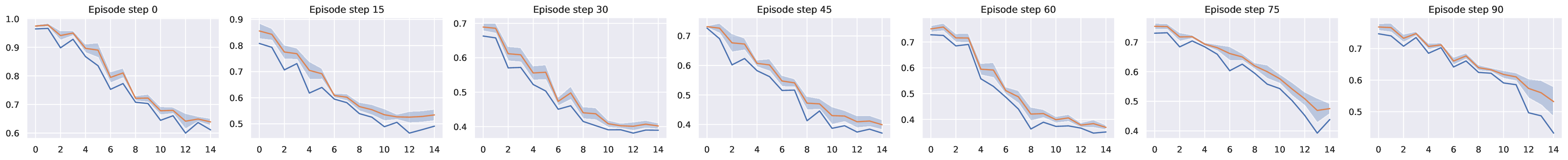

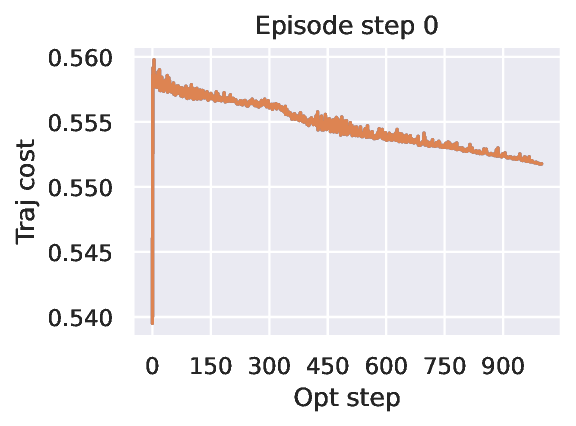

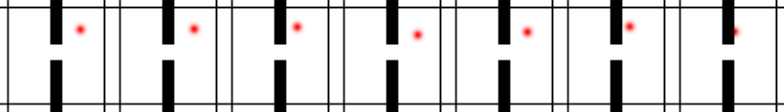

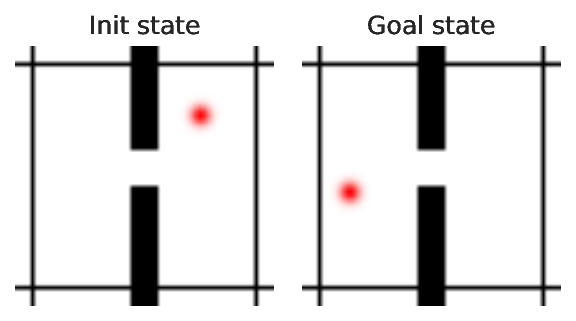

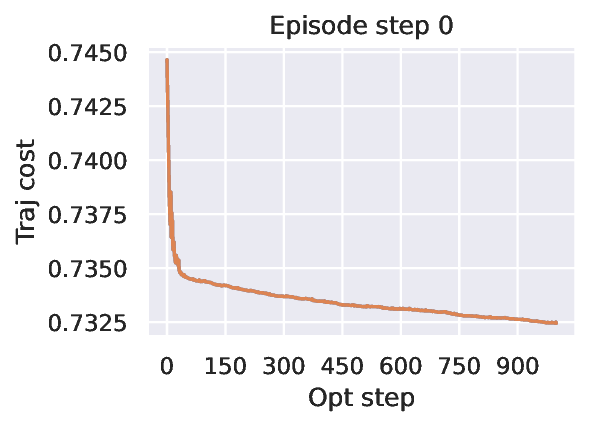

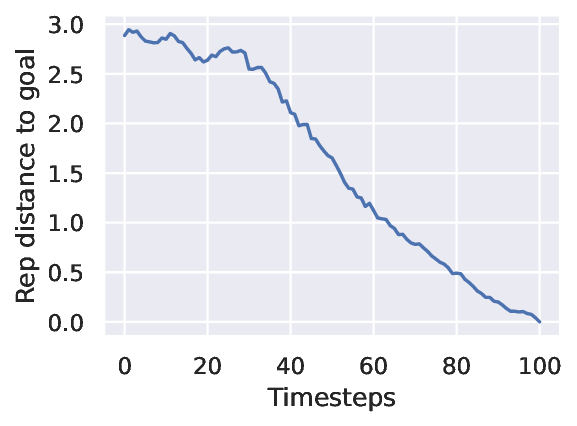

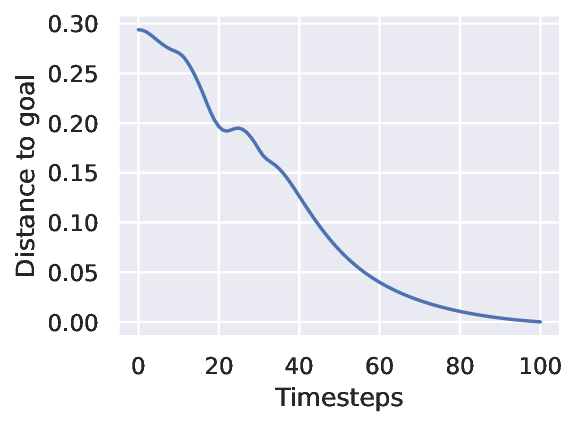

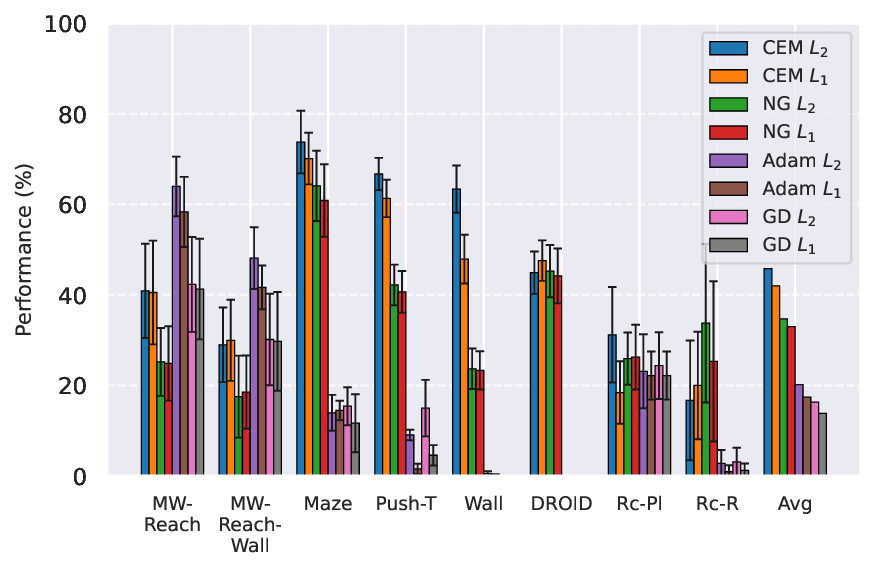

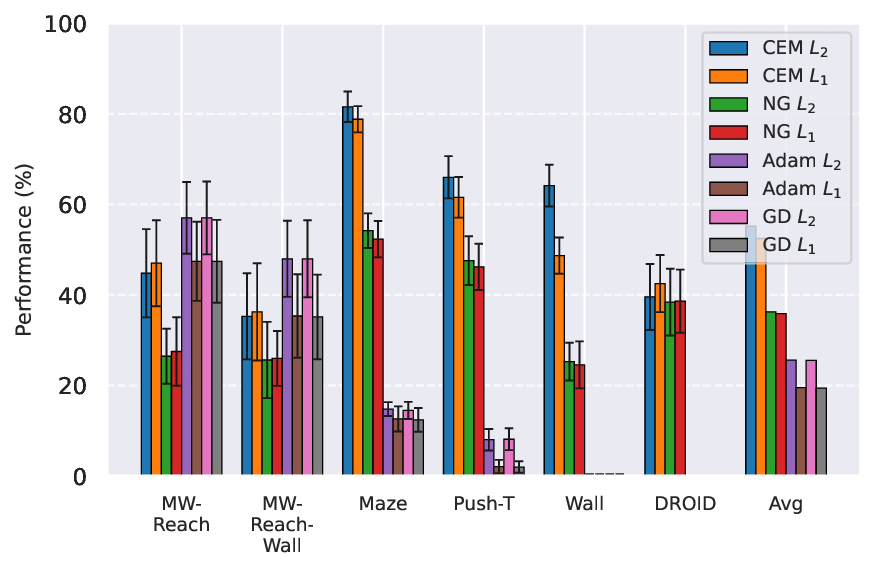

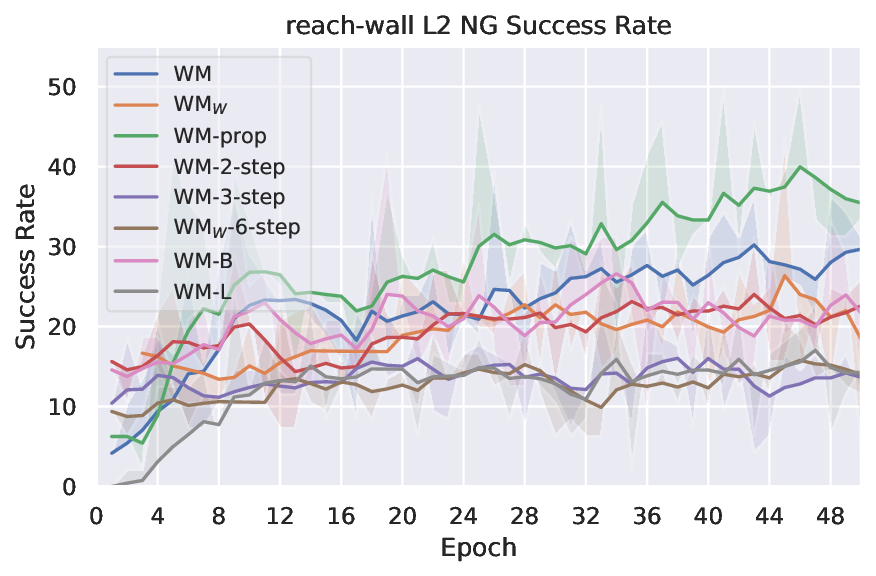

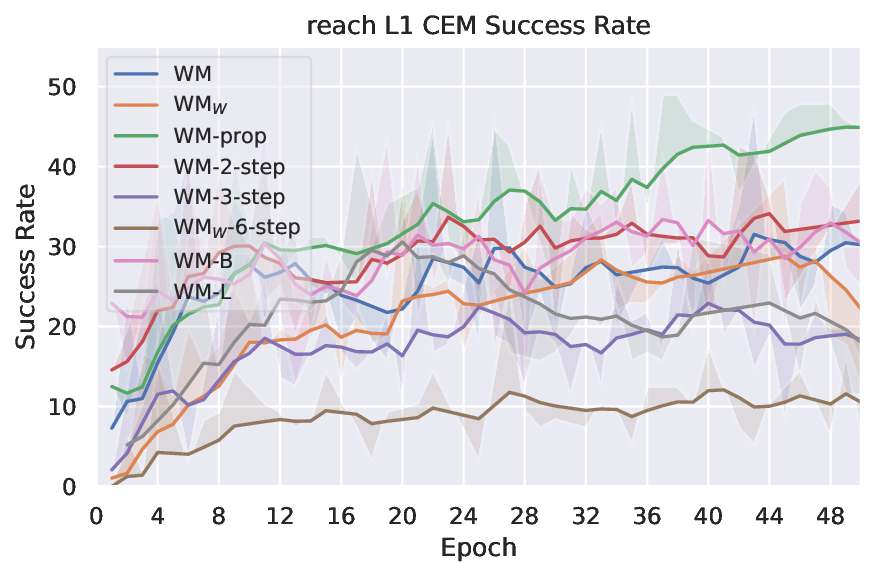

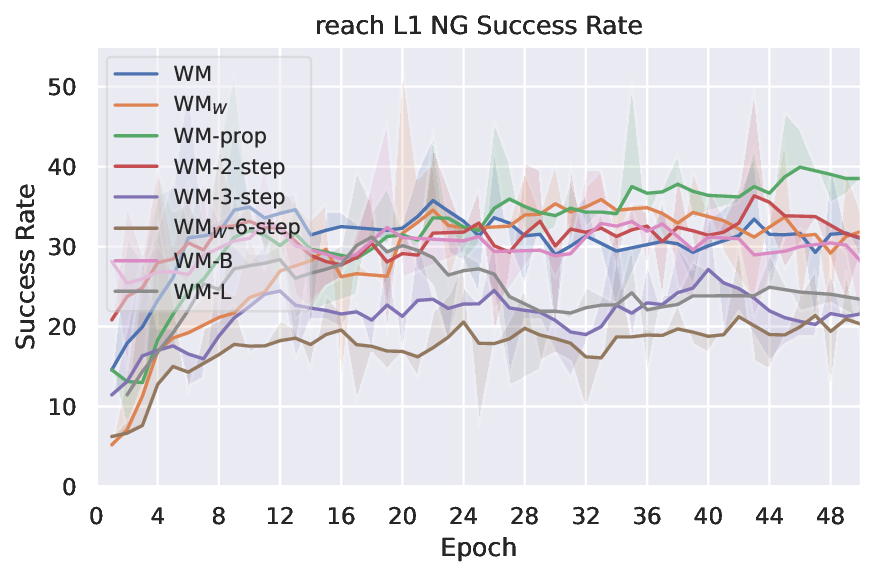

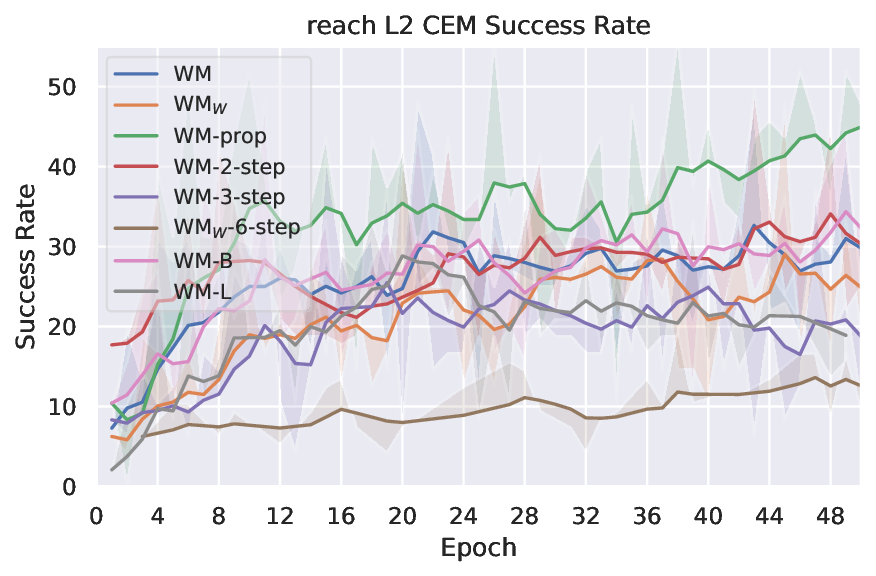

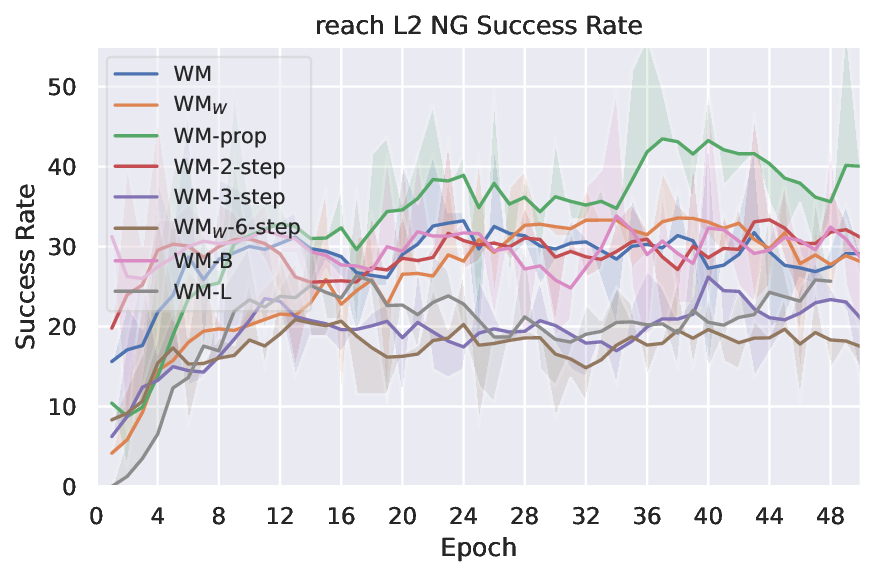

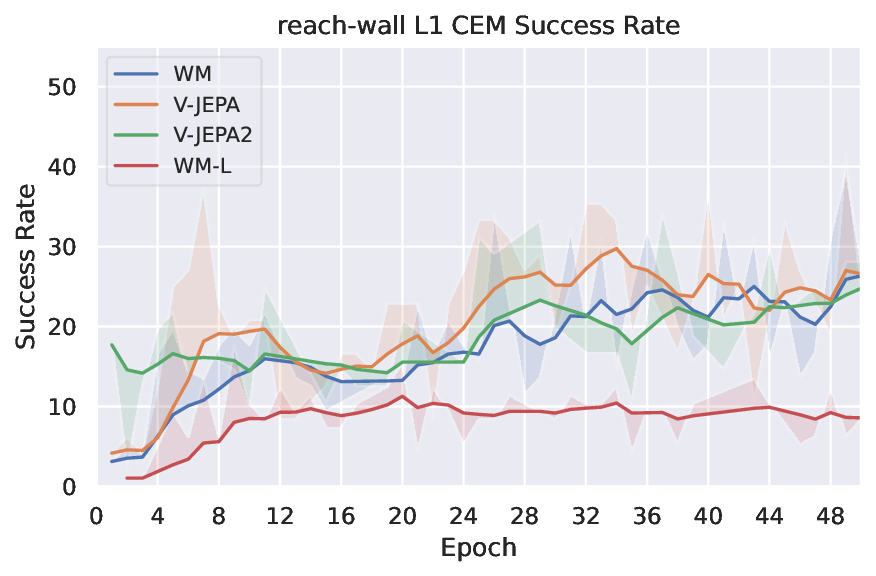

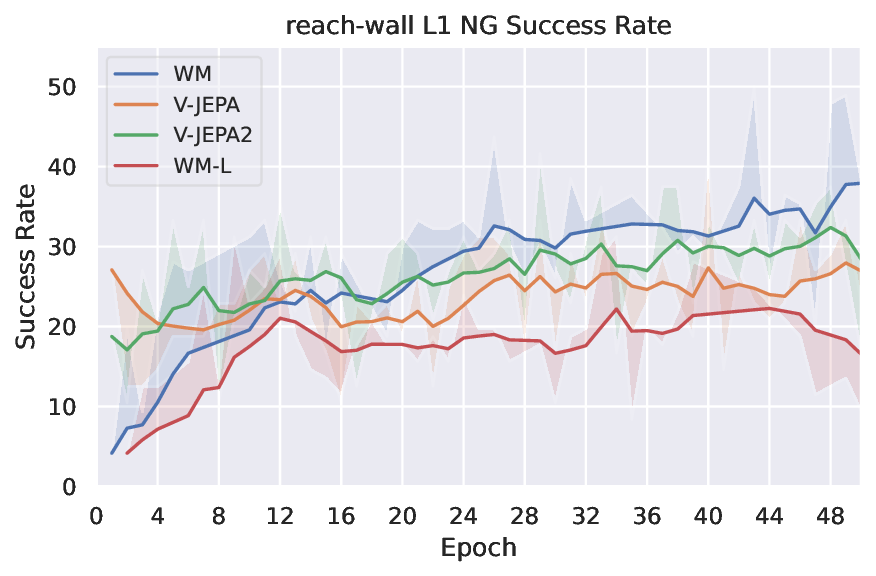

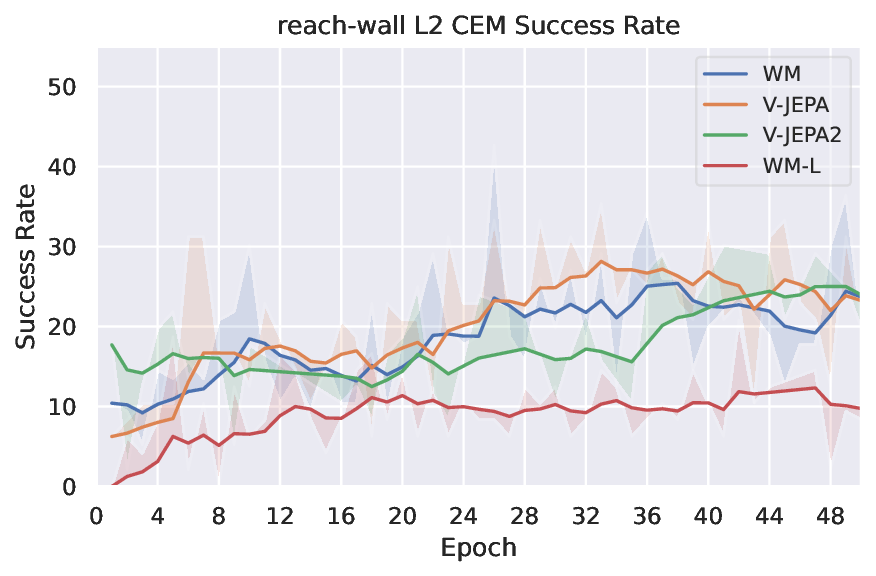

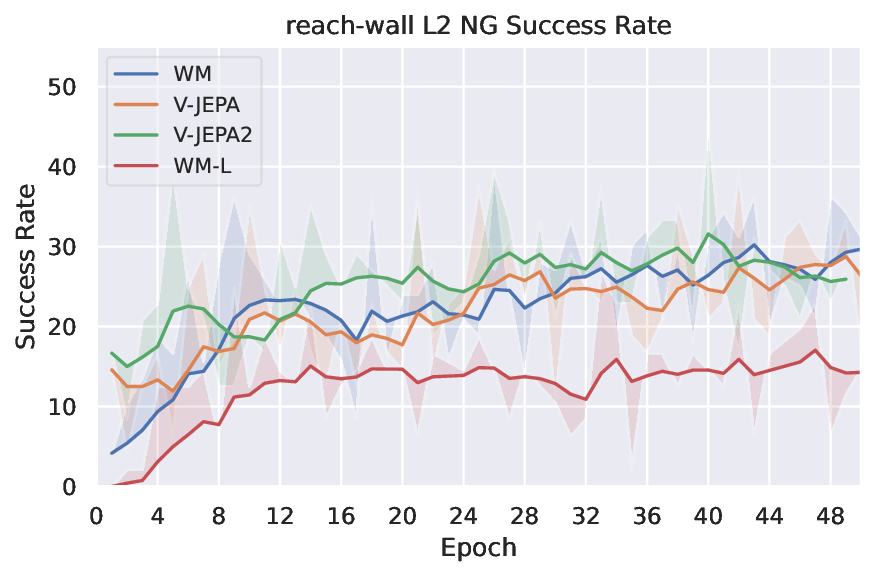

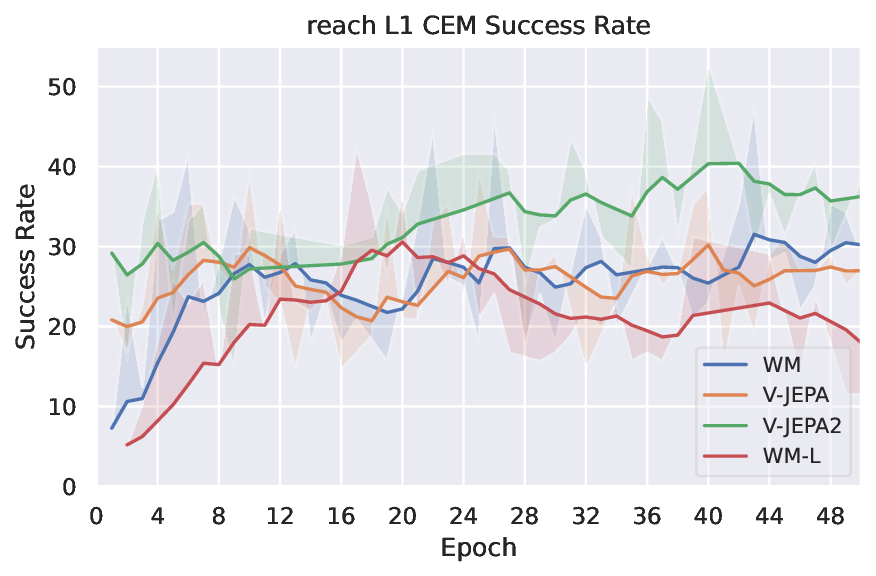

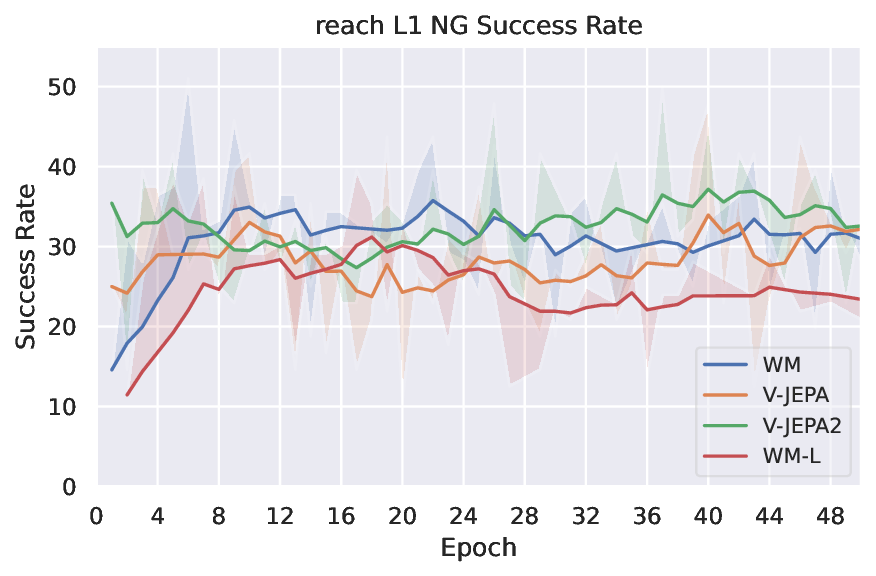

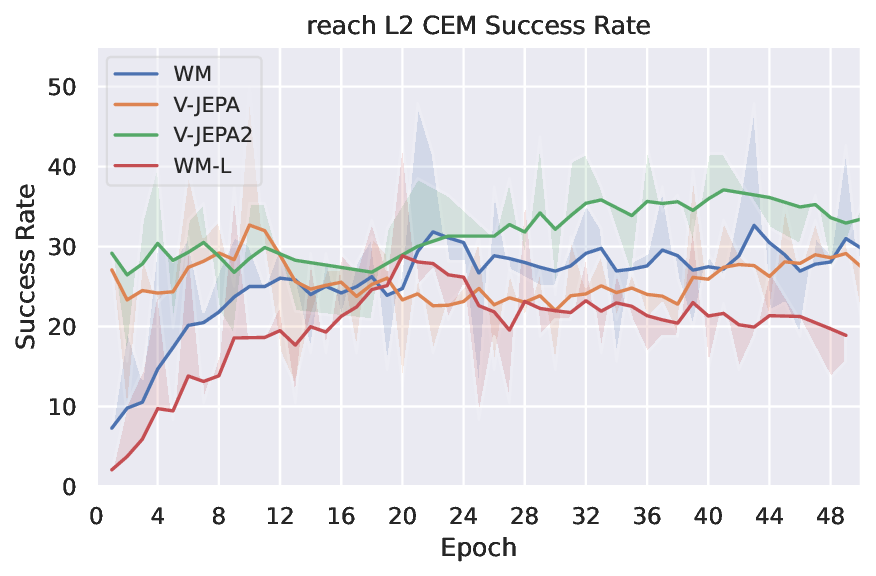

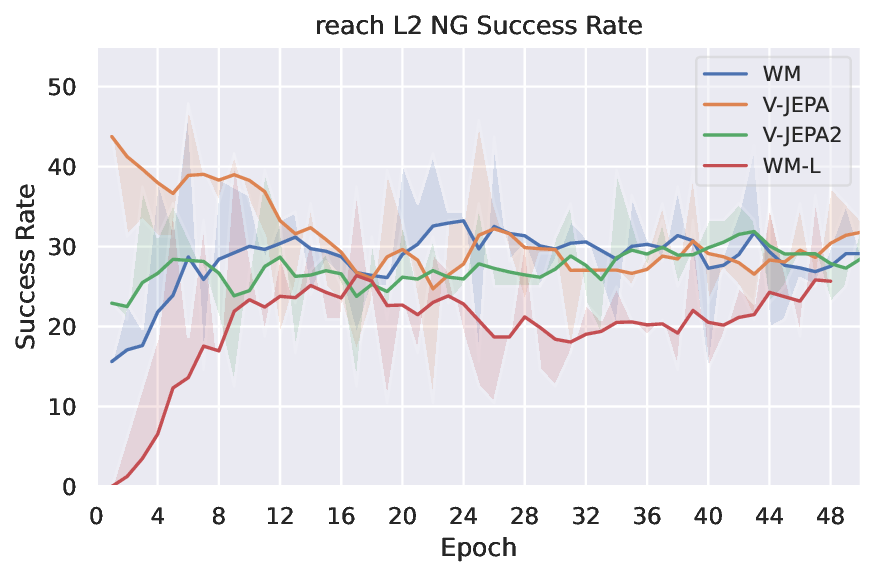

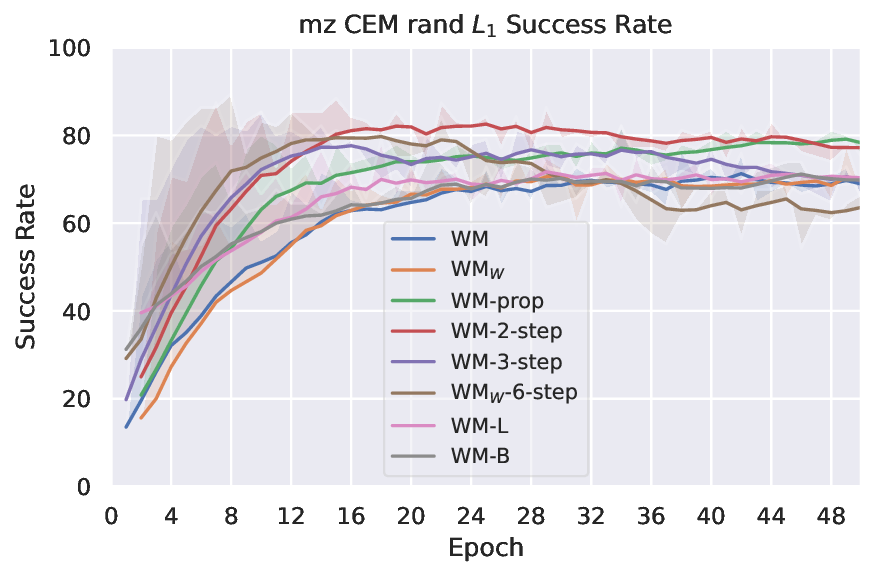

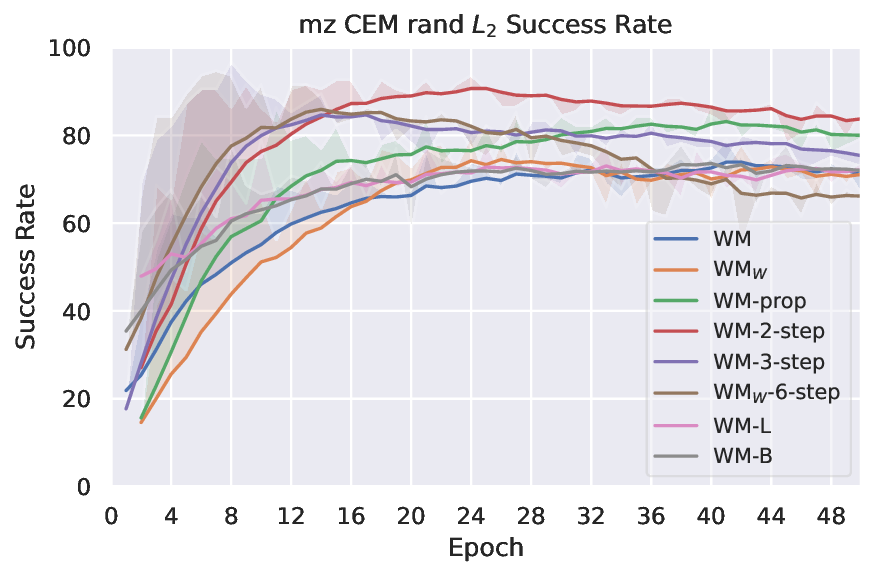

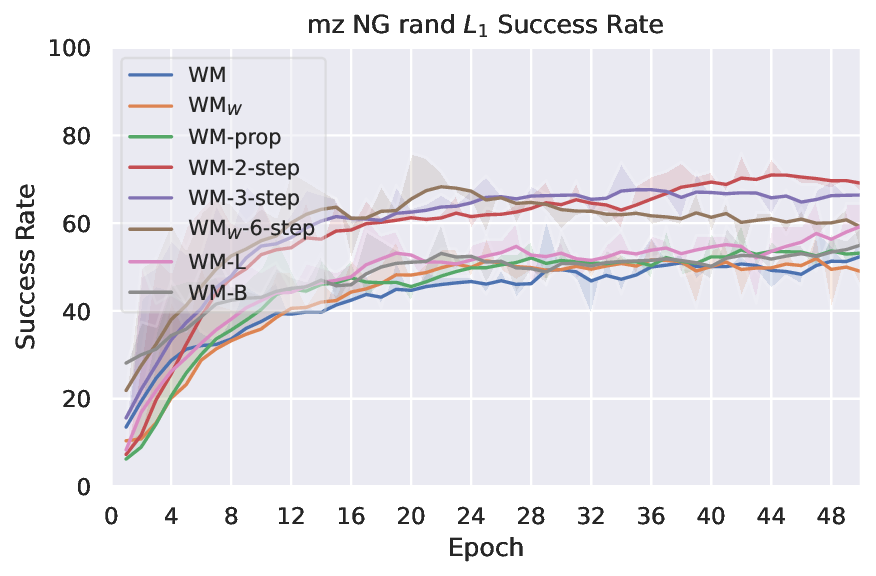

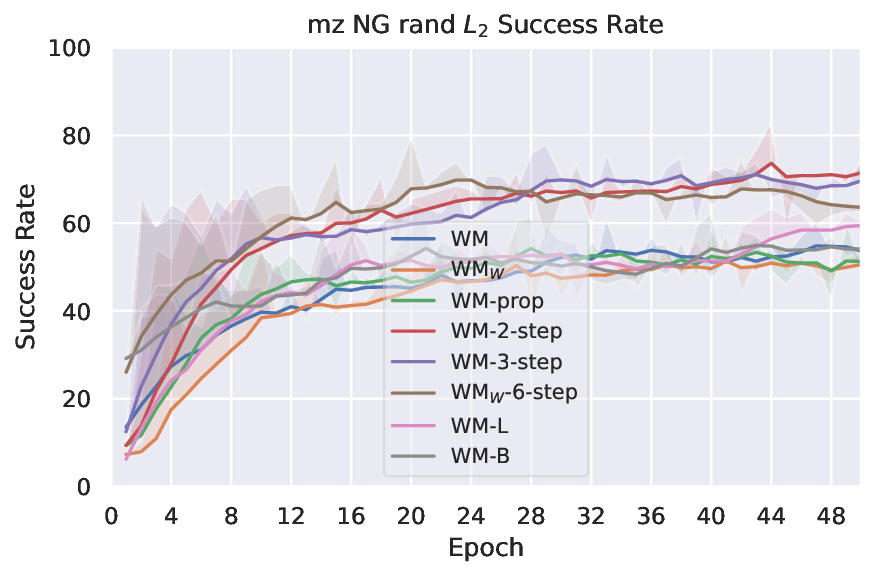

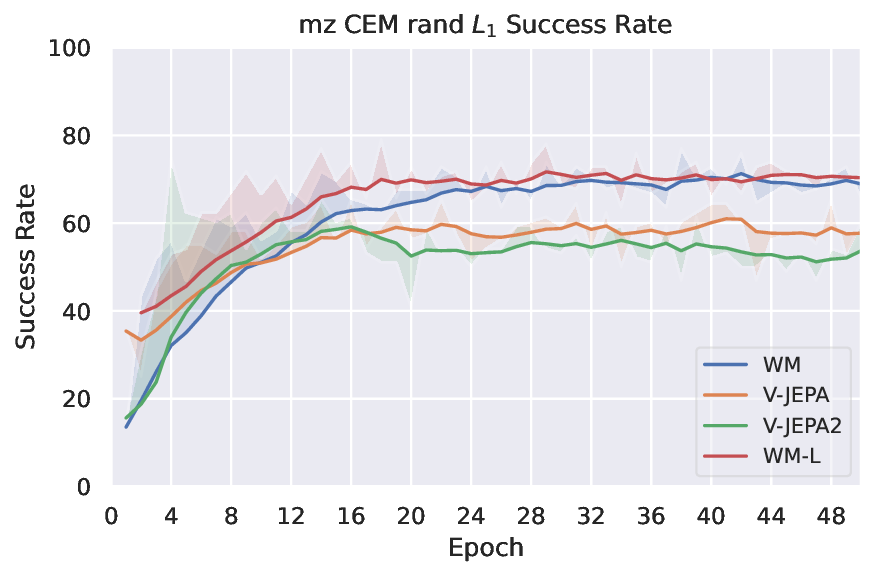

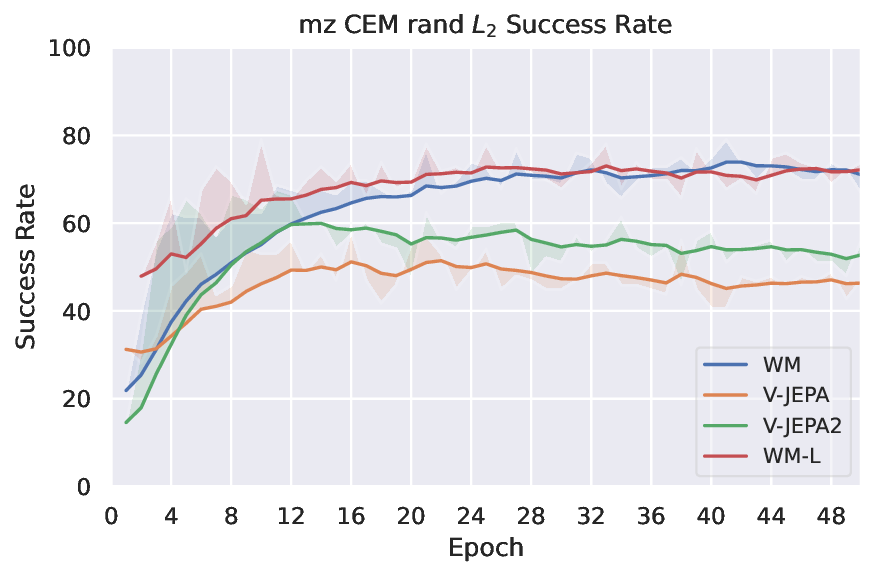

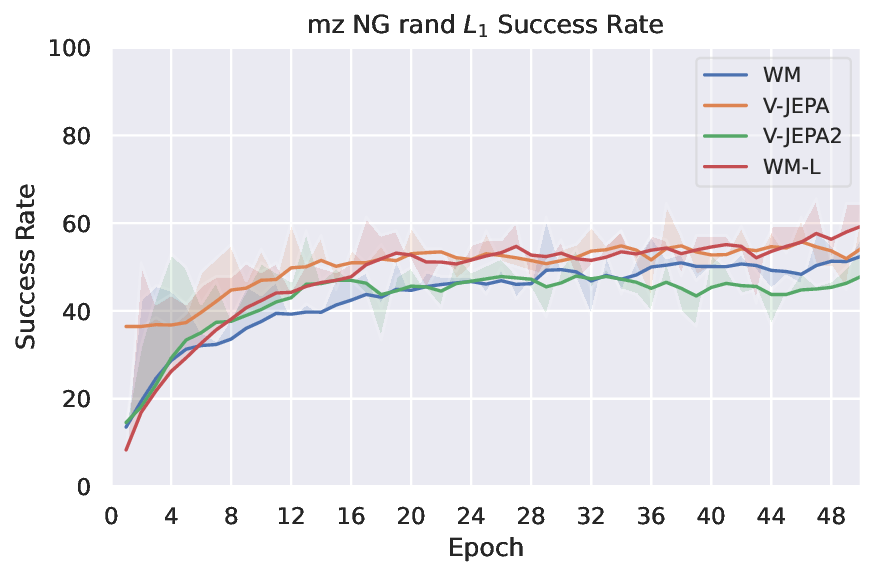

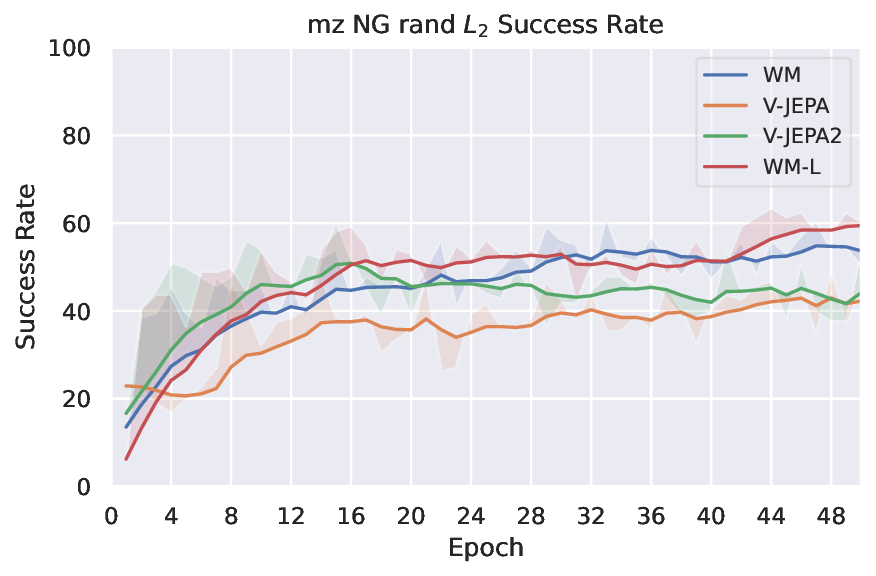

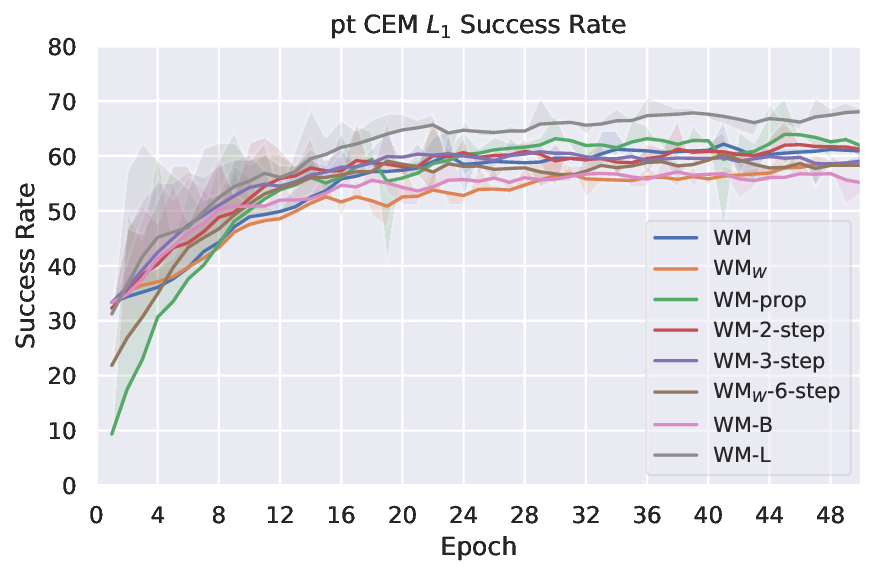

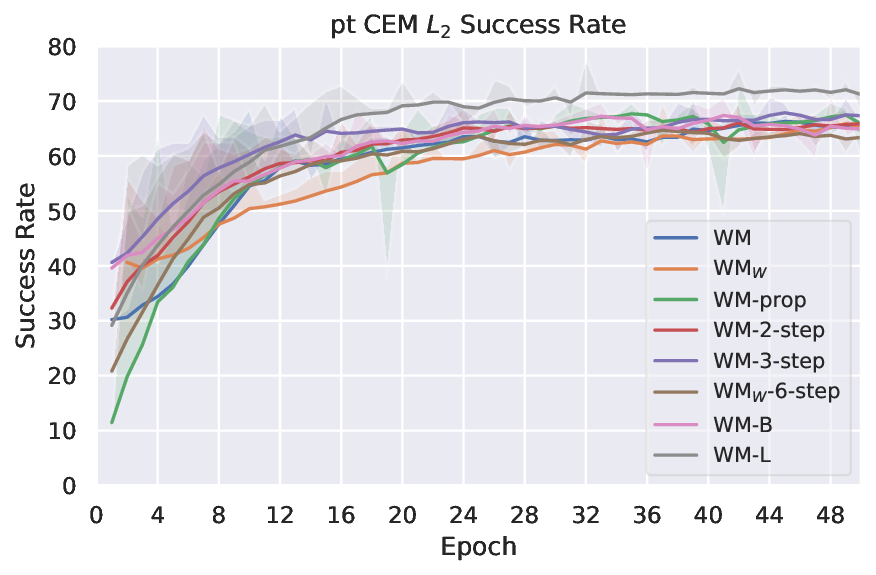

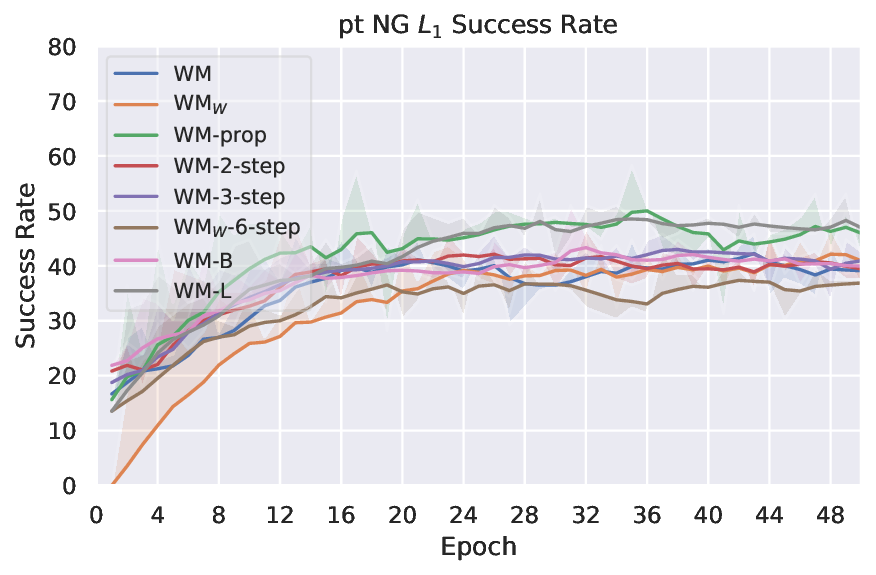

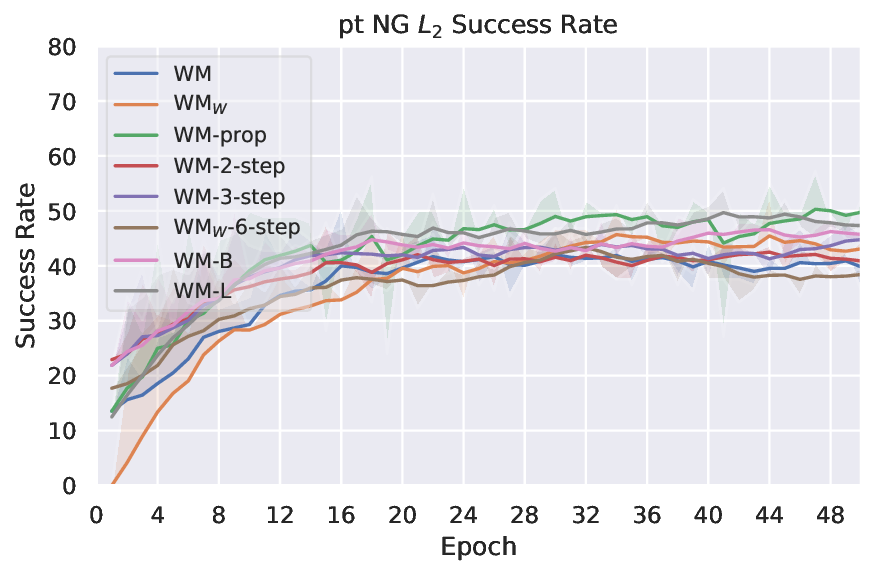

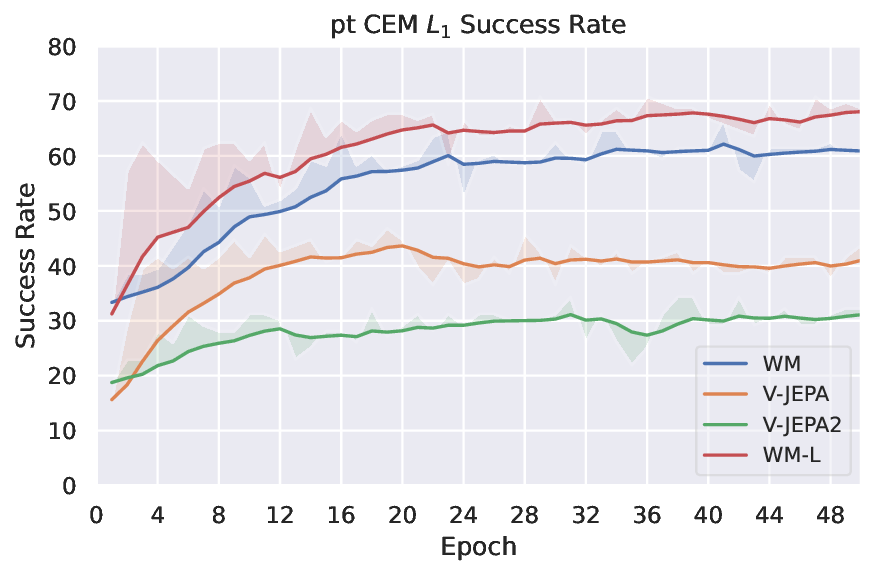

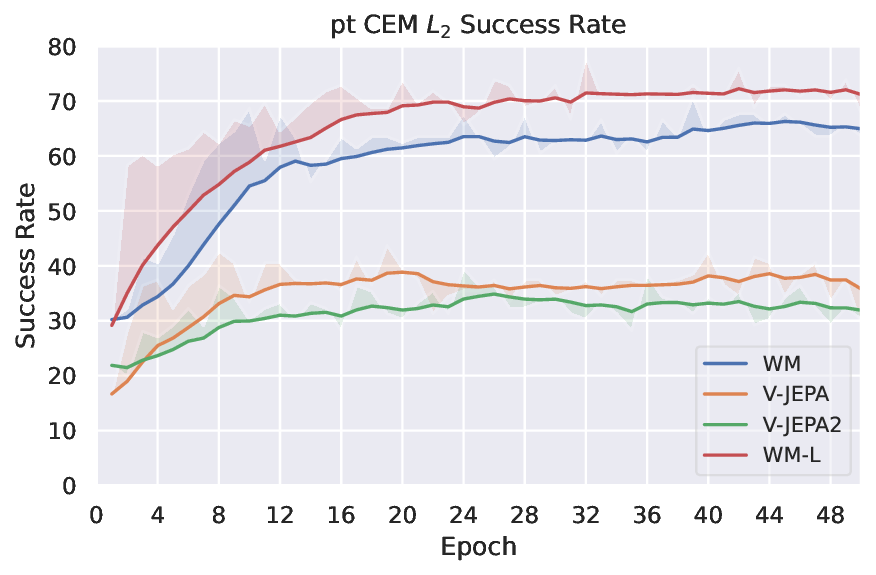

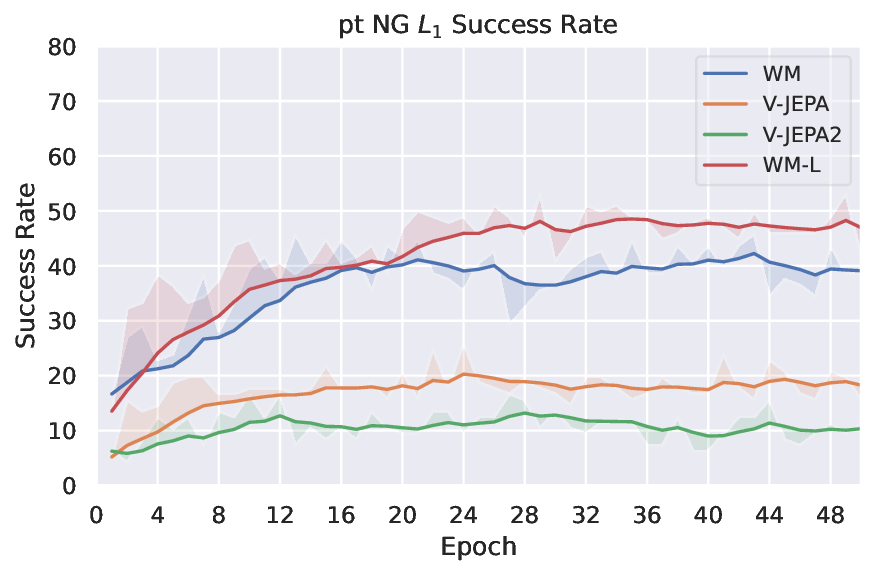

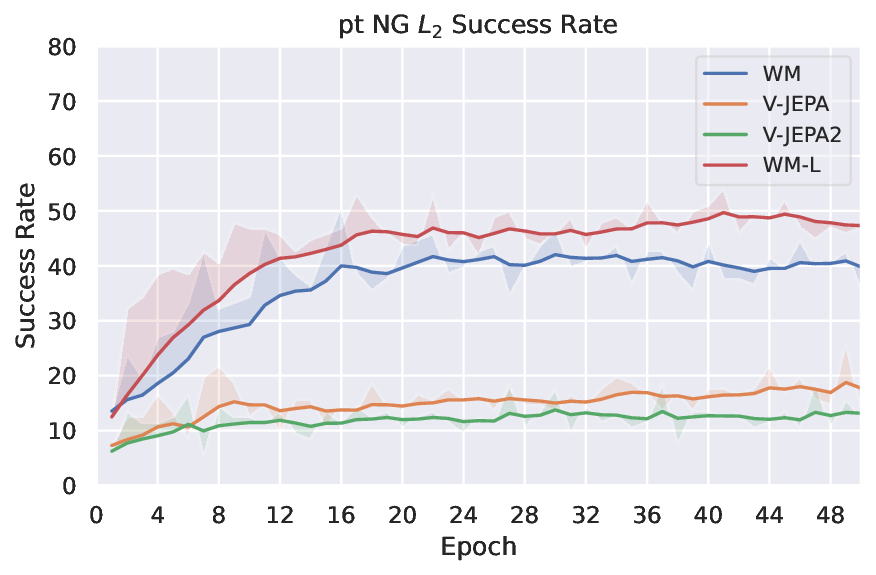

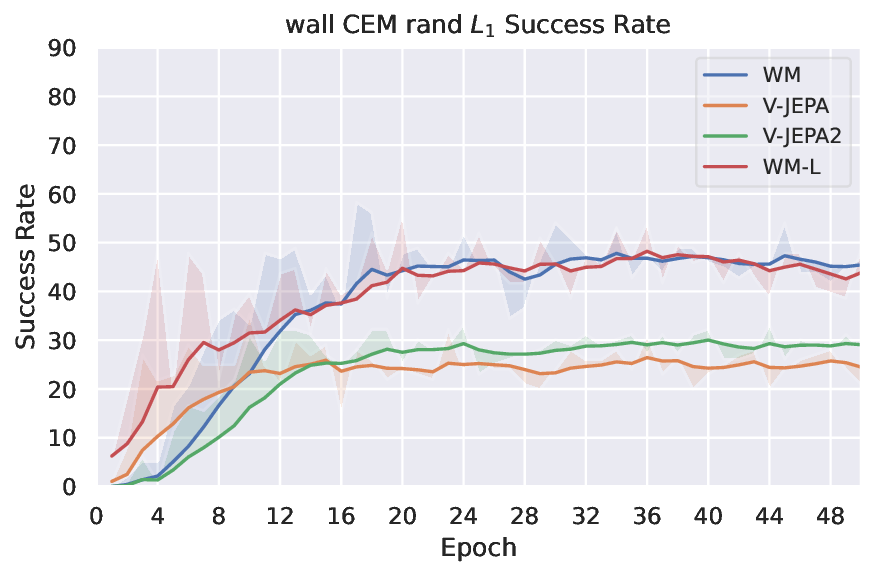

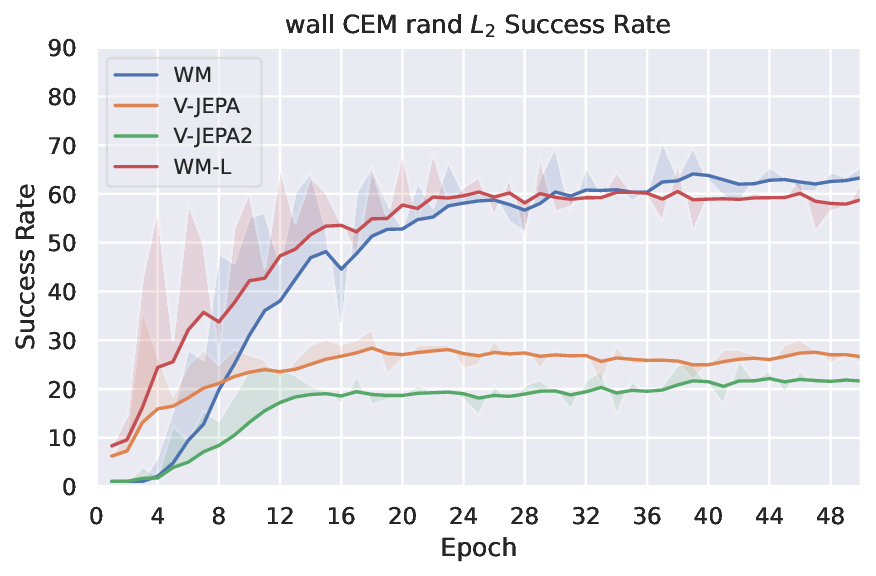

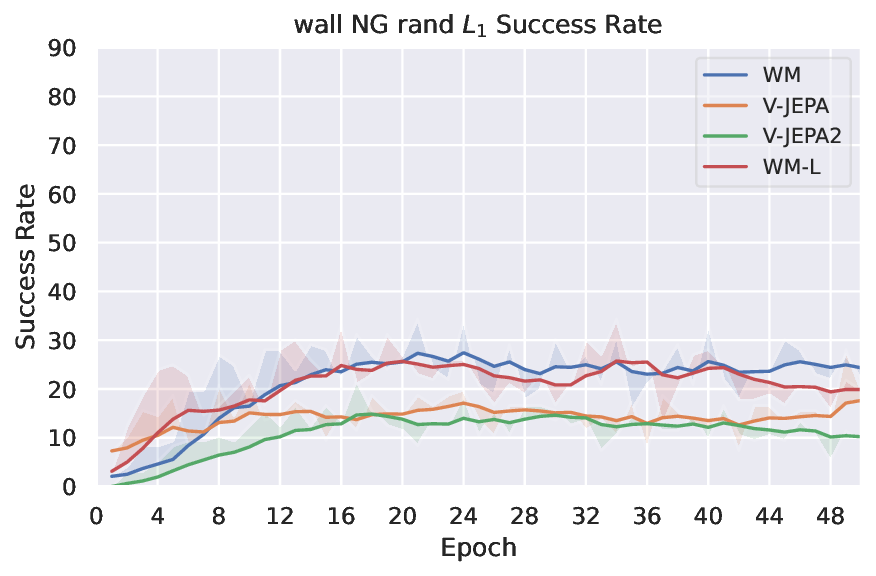

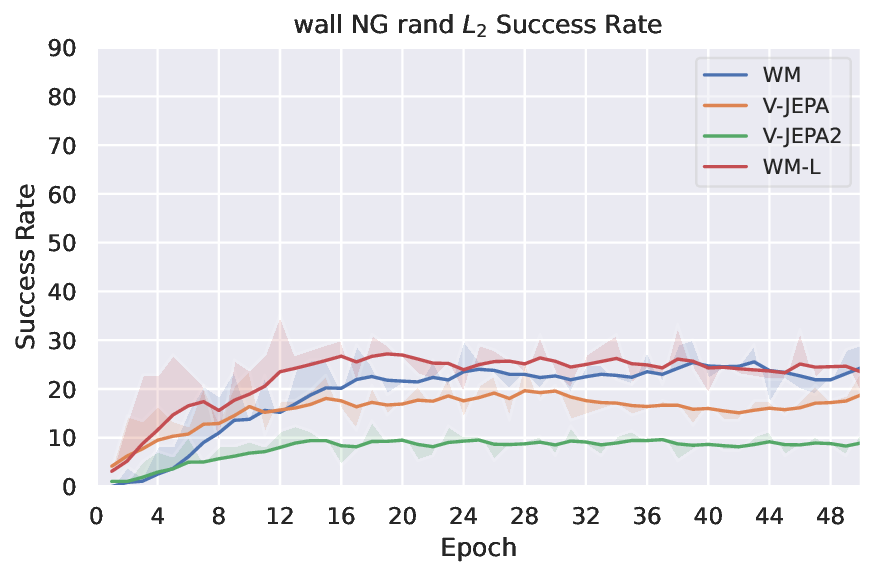

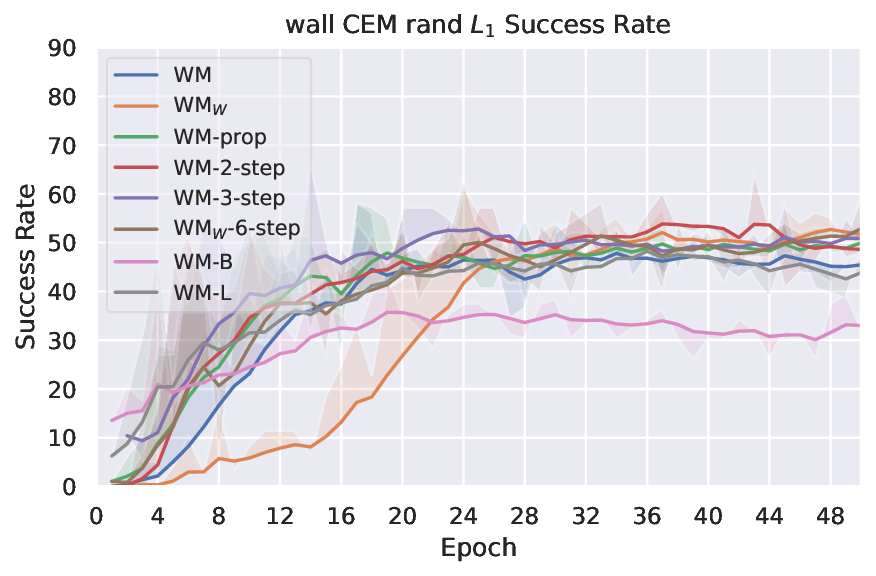

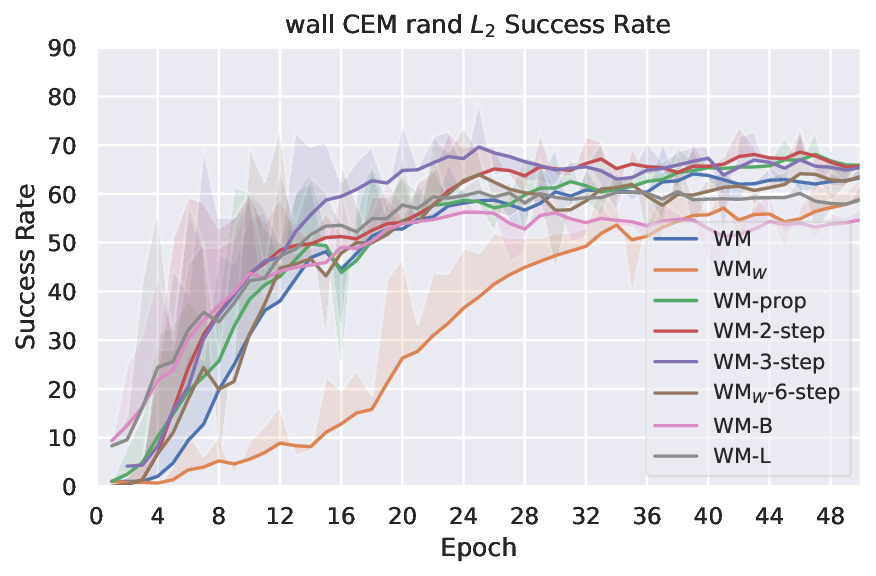

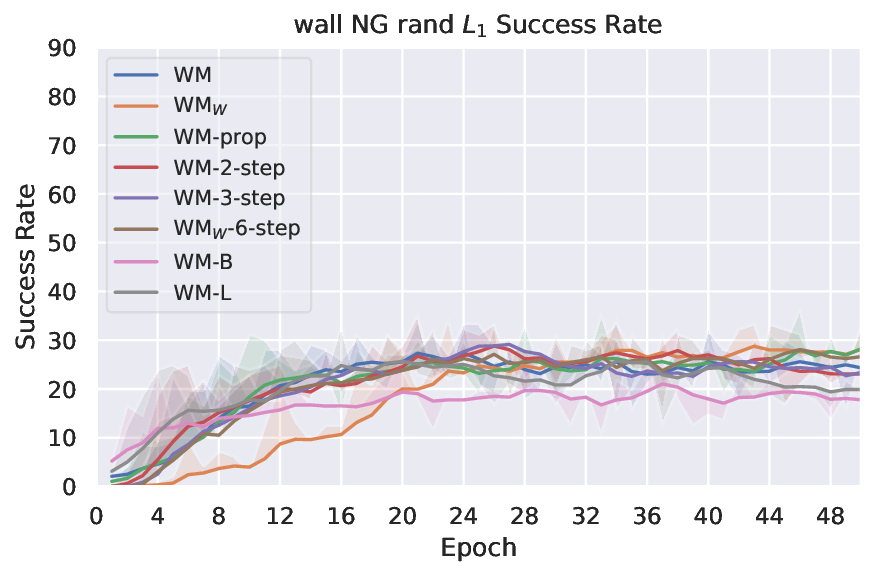

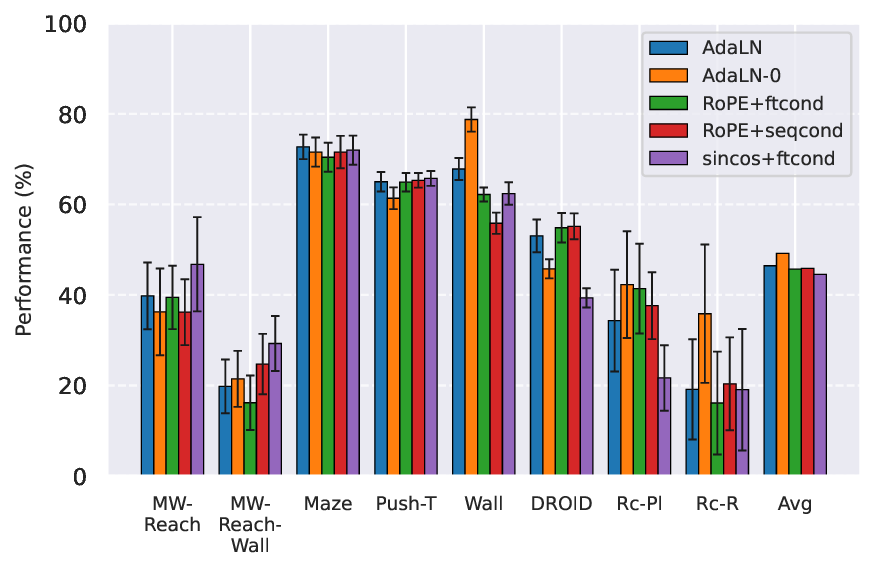

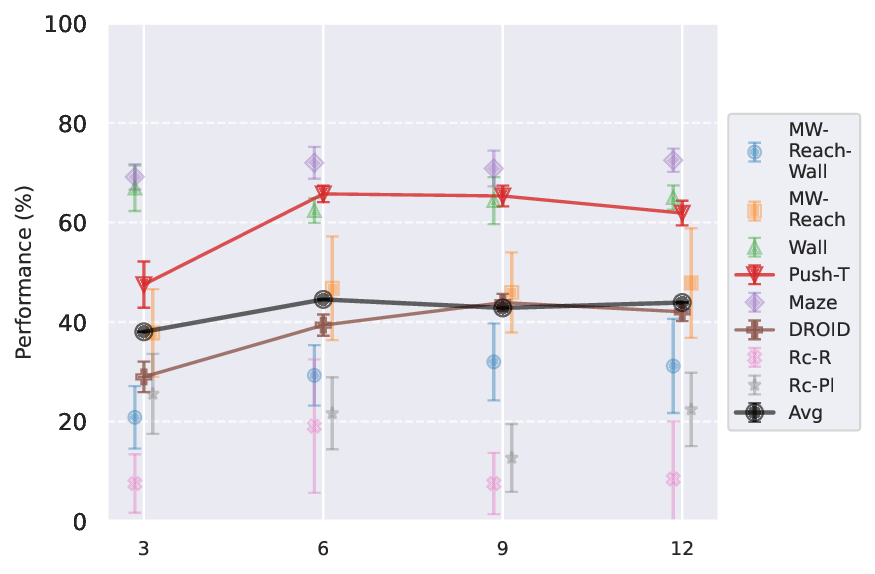

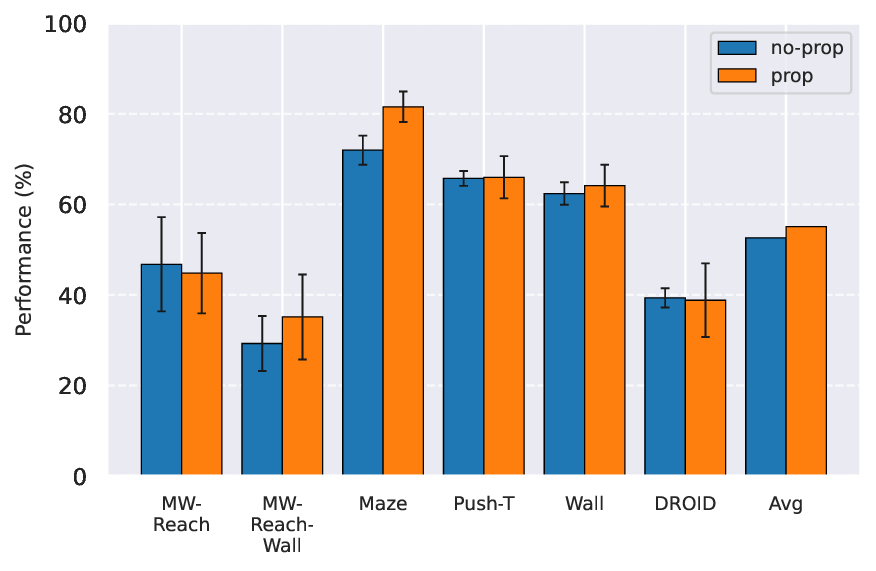

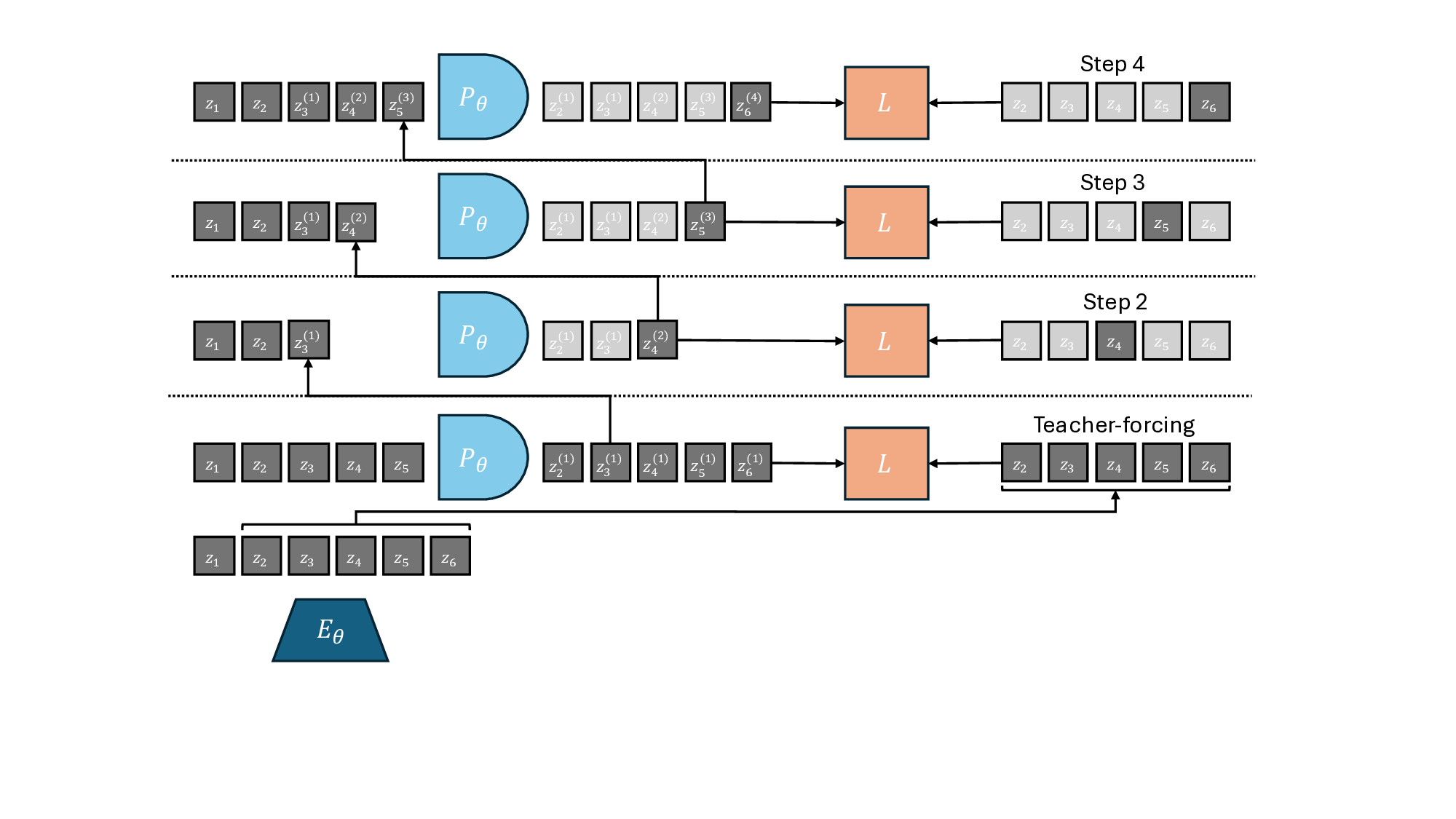

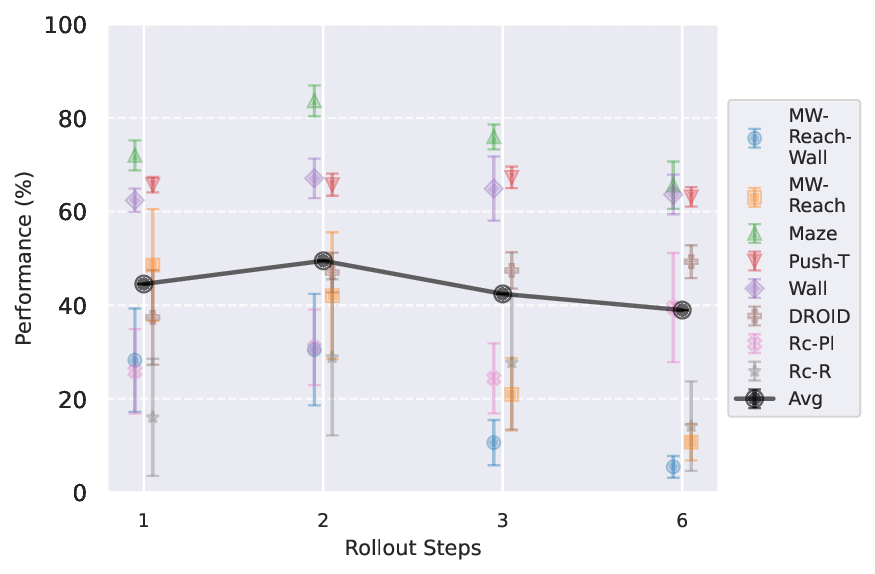

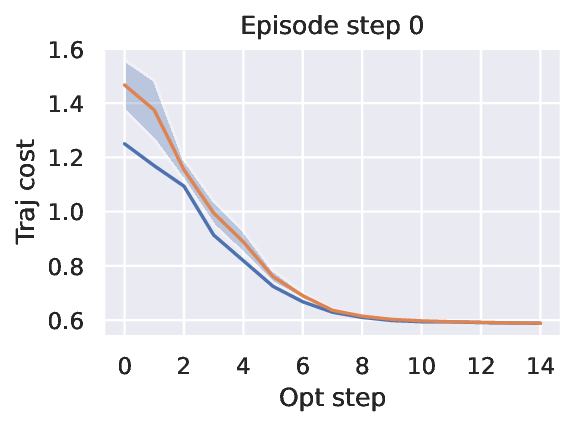

연구진은 세 가지 축을 중심으로 실험을 설계했다. 첫째, 모델 아키텍처 선택이다. CNN‑기반 인코더와 Transformer‑기반 디코더를 조합한 하이브리드 구조가, 순수 CNN 혹은 순수 Transformer 대비 더 풍부한 시공간 관계를 포착한다는 결과가 도출되었다. 둘째, 학습 목표이다. 단순 재구성 손실만 사용하는 경우와, 대비 학습(contrastive) 및 미래 예측 손실을 복합적으로 적용한 경우를 비교했을 때, 후자가 잠재 표현의 구분성을 크게 향상시켜 계획 단계에서 더 정확한 가치 추정이 가능했다. 셋째, 계획 알고리즘 자체이다. 전통적인 모델‑예측 제어(MPC)를 그대로 적용하는 방법과, 잠재 공간에서 샘플링 기반 CEM(Cross‑Entropy Method) 최적화를 수행하는 방법을 비교했으며, 후자가 탐색 효율성과 수렴 속도 모두에서 우수했다.

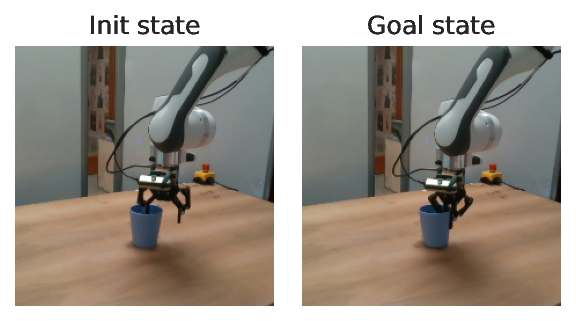

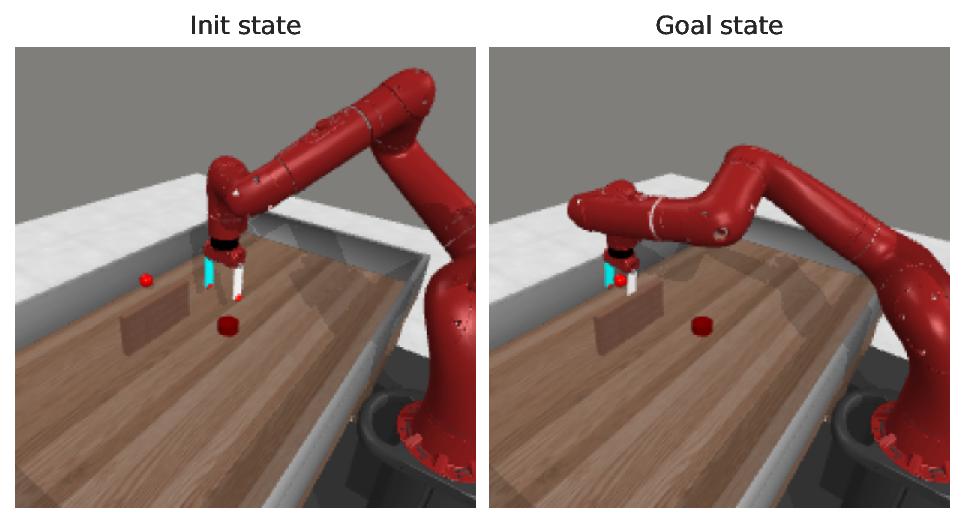

특히 흥미로운 점은 실제 로봇 데이터에서의 검증이다. 시뮬레이션에서는 모든 변형이 기대대로 작동했지만, 실제 로봇에서는 센서 노이즈와 동역학 모델링 오차가 존재한다. 그럼에도 불구하고, 제안된 JEPA‑WM은 DINO‑WM과 V‑JEPA‑2‑AC보다 12 %~18 % 높은 성공률을 기록했으며, 특히 복잡한 조작 과제(예: 물체 회전 및 삽입)에서 뚜렷한 이점을 보였다. 이는 표현 공간이 불필요한 변동성을 필터링하고, 핵심 물리적 인과관계만을 보존함으로써 계획 단계에서 더 신뢰할 수 있는 예측을 제공한다는 가설을 뒷받침한다.

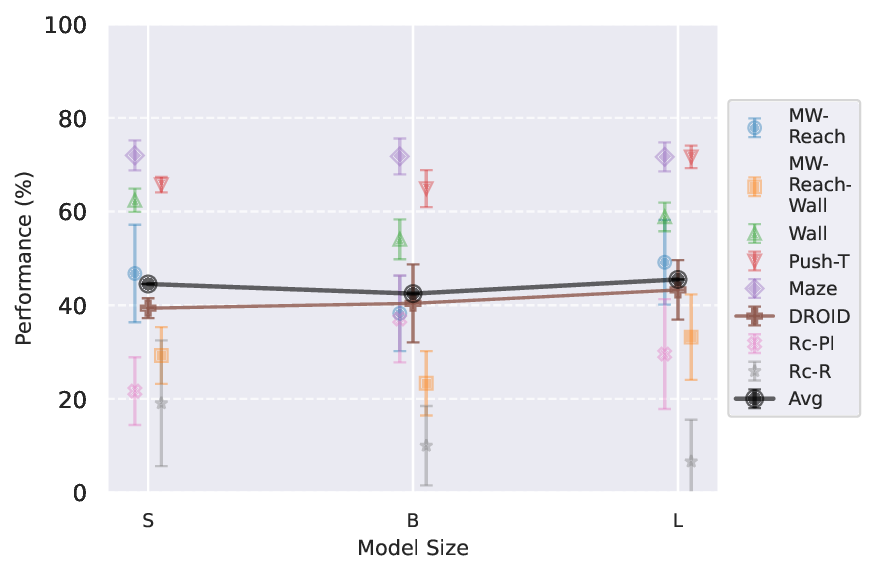

마지막으로, 저자들은 모델 크기와 연산량 사이의 트레이드오프를 분석했다. 모델 파라미터를 2배 늘리면 성능이 소폭 개선되지만, 실시간 로봇 제어에 필요한 프레임당 연산 시간이 급격히 증가한다. 따라서 실용적인 적용을 위해서는 ‘경량화된 JEPA‑WM’ 설계가 필요하다는 점을 강조한다. 전체적으로 이 논문은 표현 공간 계획이 물리적 로봇 시스템에 어떻게 적용될 수 있는지를 체계적으로 보여주며, 향후 연구 방향으로는 멀티모달 센서 융합, 온라인 적응 학습, 그리고 대규모 행동 라이브러리와의 통합을 제시한다.

📄 논문 본문 발췌 (Translation)

📸 추가 이미지 갤러리