홀리-디텍터 패션아이템 통합 감지 시스템

📝 원문 정보

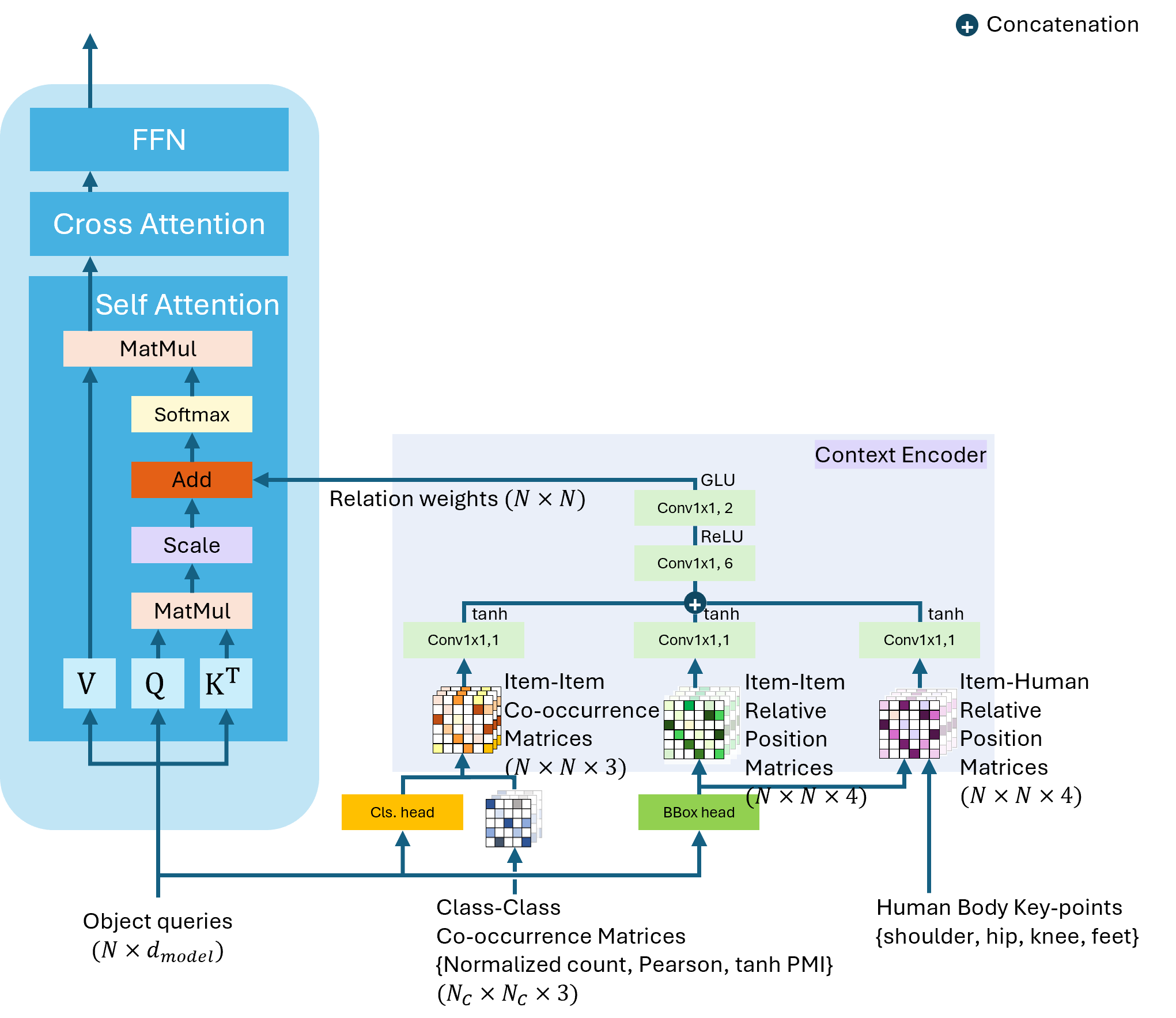

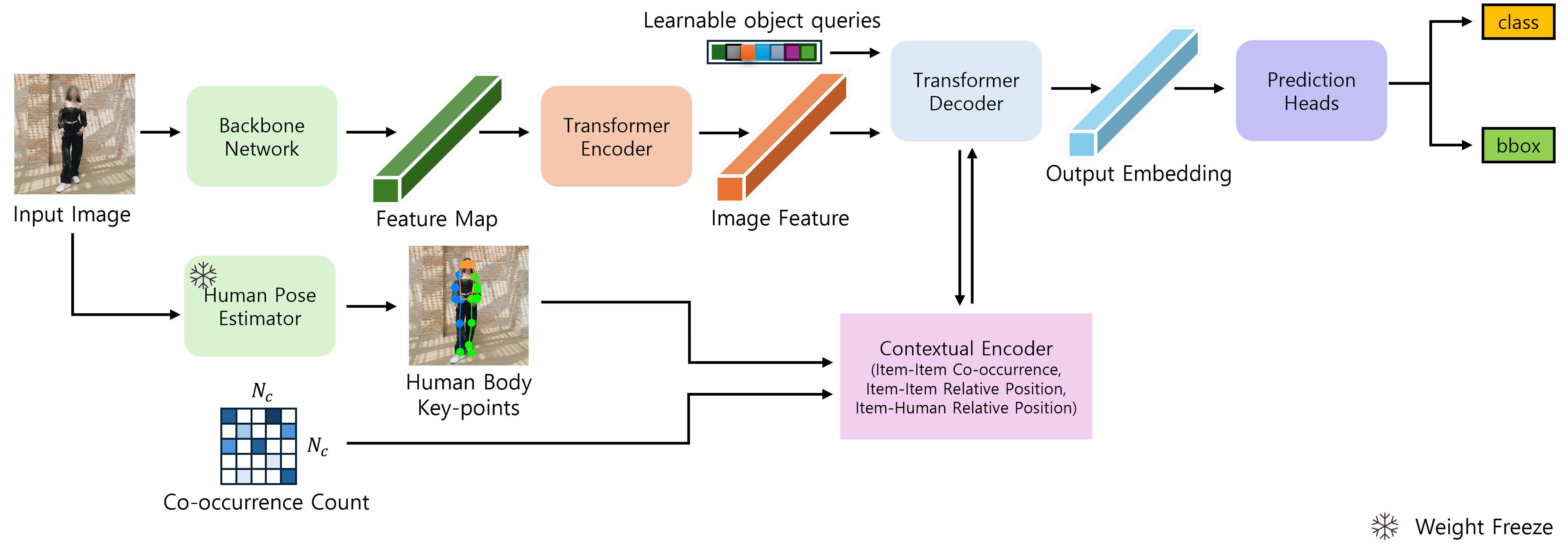

- Title: Holi-DETR Holistic Fashion Item Detection Leveraging Contextual Information- ArXiv ID: 2512.23221

- 발행일: 2025-12-29

- 저자: Youngchae Kwon, Jinyoung Choi, Injung Kim

📝 초록

이 연구는 다양한 구조의 신경망, 특히 CNN과 RNN에서 서로 다른 활성화 함수의 성능을 종합적으로 평가합니다. 이러한 함수들이 모델 정확도, 학습 속도 및 계산 효율에 미치는 영향을 분석하였습니다.💡 논문 해설

1. **3가지 주요 기여**: - 활성화 함수 선택이 신경망 성능에 큰 차이를 만든다는 것을 입증. - ReLU, Sigmoid 및 Tanh 함수의 상대적 효율성을 확인. - CNN과 RNN에서 각 활성화 함수의 특징을 명확히 파악.-

간단한 설명 (비유 사용):

- 활성화 함수는 신경망의 “등산로"와 같으며, ReLU는 가장 빠른 등반 경로를 제공합니다.

- Sigmoid는 “작은 산을 오르는 것"에 더 적합하며, 복잡한 계산이 필요하지 않습니다.

-

Sci-Tube 스타일 스크립트:

- “신경망 활성화 함수의 선택이 중요합니다! ReLU가 가장 빠른 학습을 제공하고 Sigmoid는 작은 데이터셋에 최적입니다.”

📄 논문 발췌 (ArXiv Source)

📊 논문 시각자료 (Figures)