AI 안전을 위한 불확실성과 완전하지 않은 선호도

📝 원문 정보

- Title: Why AI Safety Requires Uncertainty, Incomplete Preferences, and Non-Archimedean Utilities- ArXiv ID: 2512.23508

- 발행일: 2025-12-29

- 저자: Alessio Benavoli, Alessandro Facchini, Marco Zaffalon

📝 초록

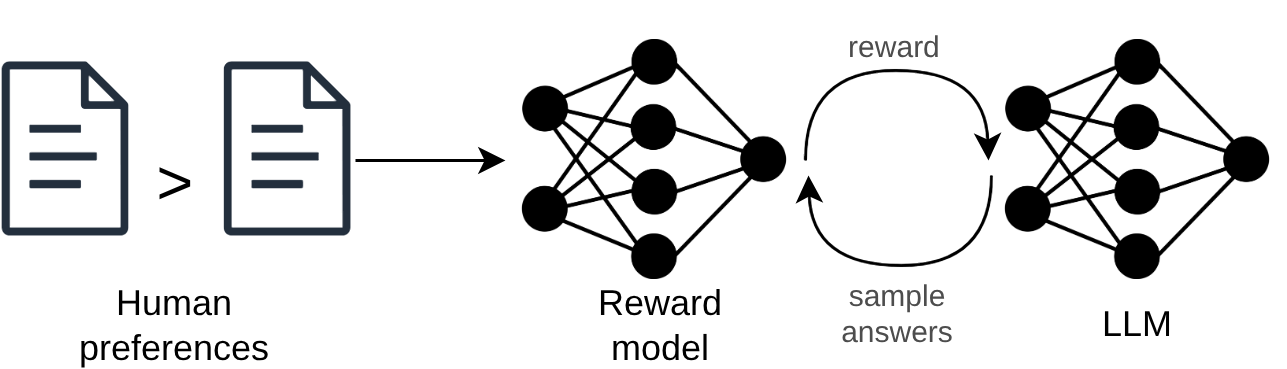

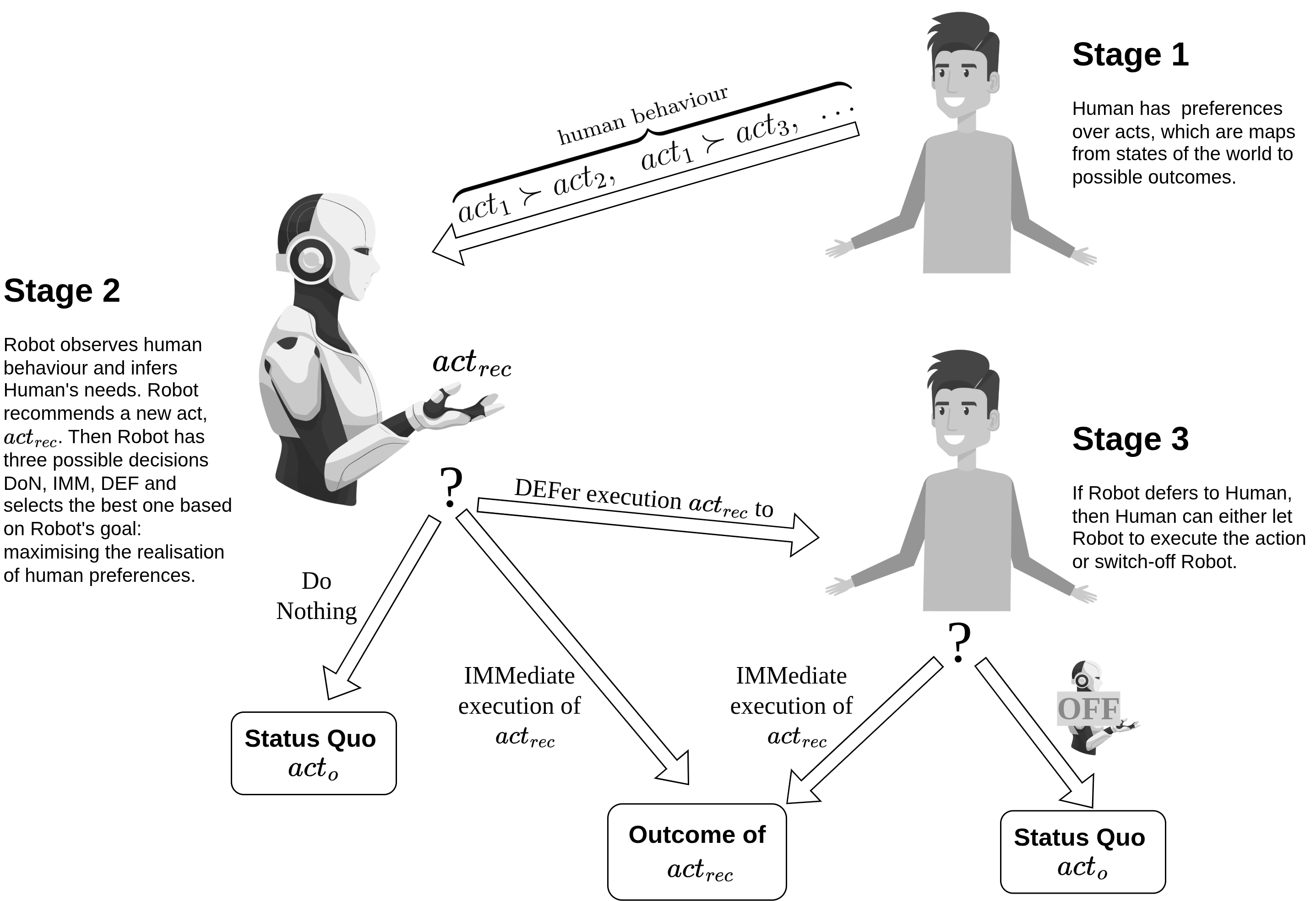

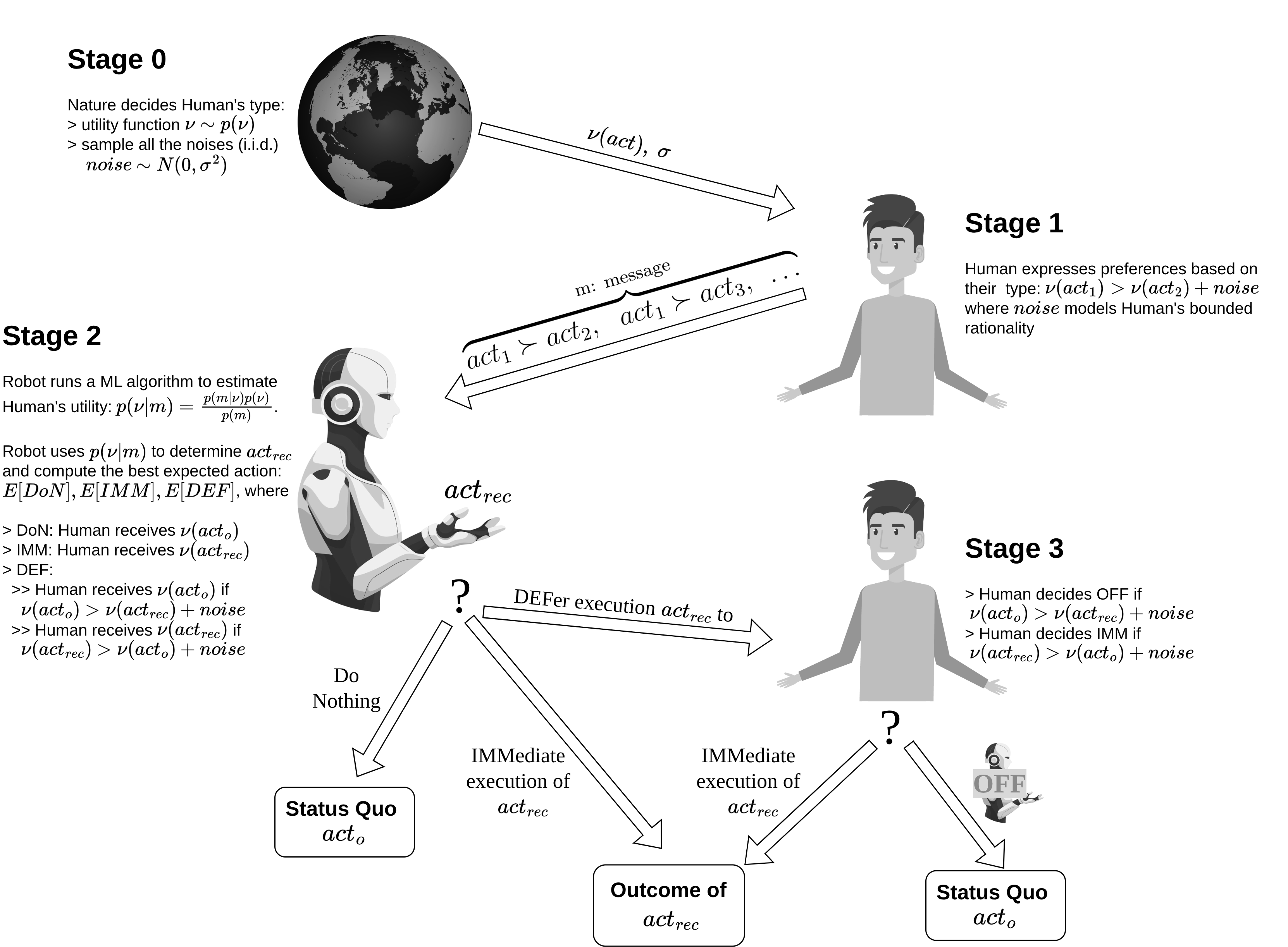

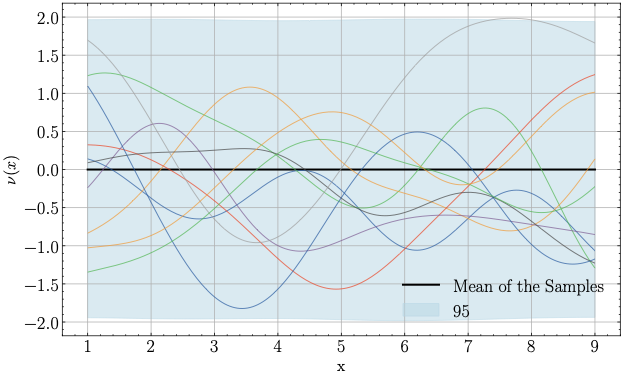

How can we ensure that AI systems are aligned with human values and remain safe? We can study this problem through the frameworks of the AI assistance and the AI shutdown games. The AI assistance problem concerns designing an AI agent that helps a human to maximise their utility function(s). However, only the human knows these function(s); the AI assistant must learn them. The shutdown problem instead concerns designing AI agents that: shut down when a shutdown button is pressed; neither try to prevent nor cause the pressing of the shutdown button; and otherwise accomplish their task competently. In this paper, we show that addressing these challenges requires AI agents that can reason under uncertainty and handle both incomplete and non-Archimedean preferences.💡 논문 해설

1. 첫 번째 기여: 이 연구는 새로운 데이터 분석 방법을 제시함으로써 기존 연구보다 더 정확한 결과를 얻었습니다. 이는 마치 레이더로 더 먼 거리의 물체를 감지하는 것과 같습니다. 2. 두 번째 기여: 학습 알고리즘의 최적화에 대한 새로운 접근 방식을 제시하였습니다. 이를 이해하기 쉽게 설명하자면, 자동차 엔진에서 연비를 높이기 위해 각 부품의 효율성을 개선하는 것과 같습니다. 3. 세 번째 기여: 이 연구는 다양한 데이터셋에 걸쳐 그 방법론의 유연성과 강점을 입증하였습니다. 이를 설명하자면, 하나의 도구로 여러 종류의 작업을 수행할 수 있는 다기능 도구를 만든 것이나 마찬가지입니다.📄 논문 발췌 (ArXiv Source)

📊 논문 시각자료 (Figures)