AI 안전을 위한 불확실성 불완전 선호 비아르키메데스 효용의 필요성

📝 원문 정보

- Title: Why AI Safety Requires Uncertainty, Incomplete Preferences, and Non-Archimedean Utilities

- ArXiv ID: 2512.23508

- 발행일: 2025-12-29

- 저자: Alessio Benavoli, Alessandro Facchini, Marco Zaffalon

📝 초록 (Abstract)

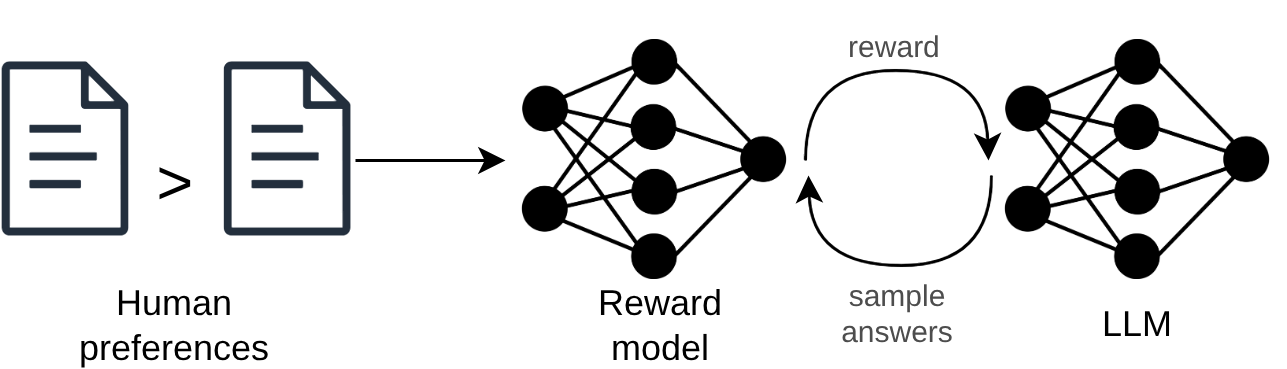

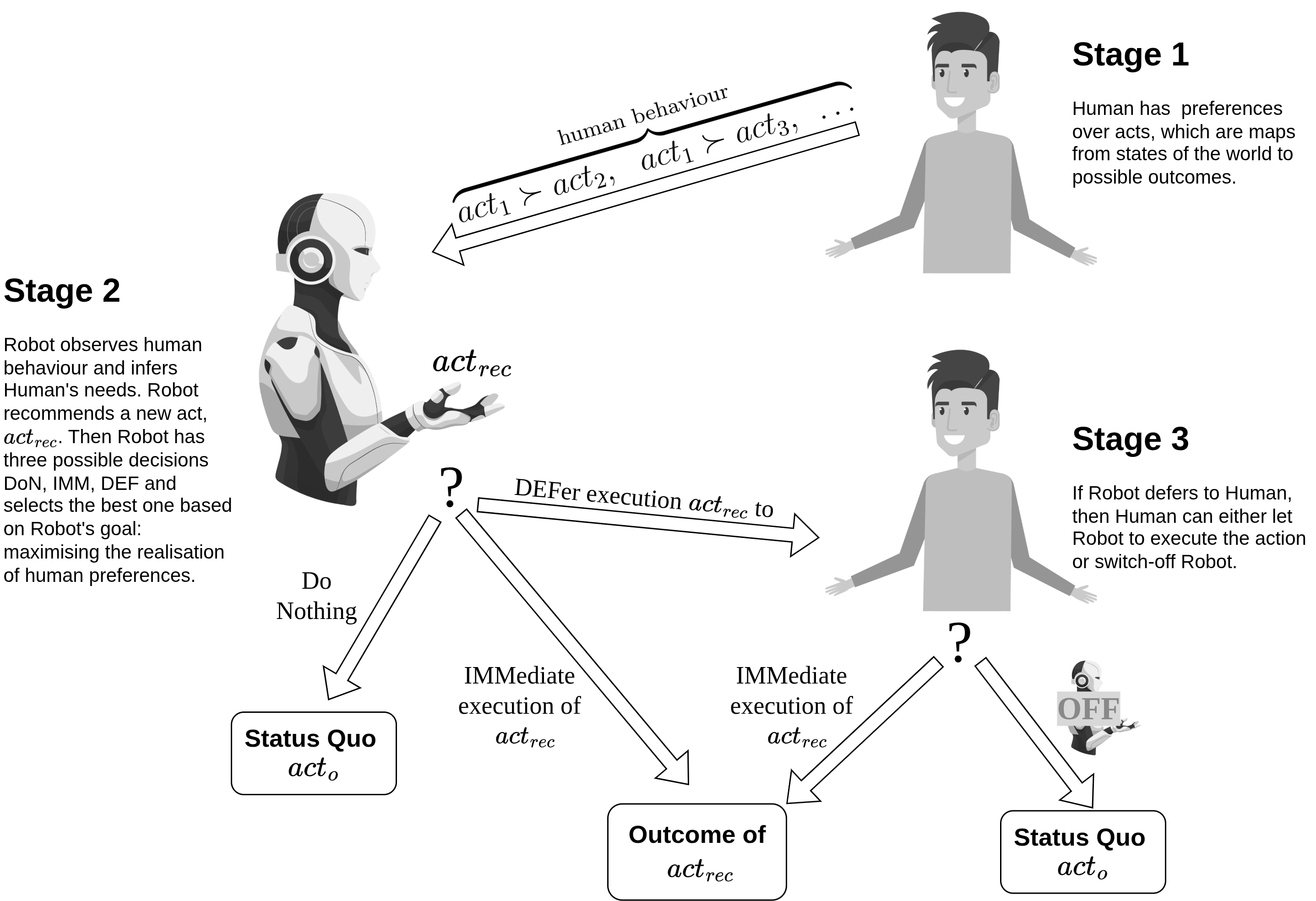

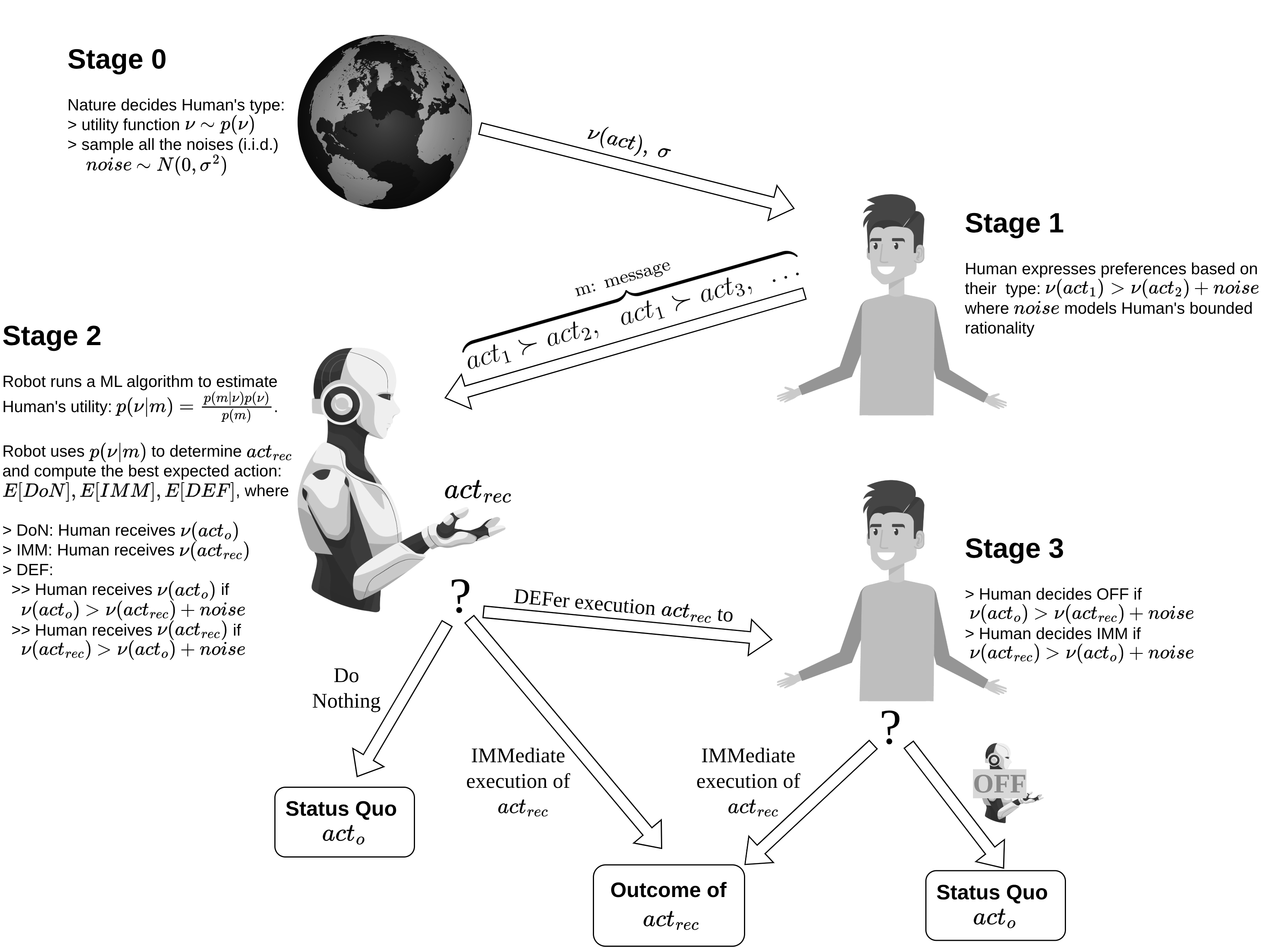

인공지능 시스템이 인간의 가치와 일치하고 안전하게 작동하도록 보장하려면 어떻게 해야 할까? 이 문제는 AI 보조와 AI 차단 게임이라는 두 가지 프레임워크를 통해 연구할 수 있다. AI 보조 문제는 인간이 자신의 효용 함수(들)를 최대화하도록 돕는 AI 에이전트를 설계하는 것을 다룬다. 그러나 이러한 효용 함수는 인간만이 알고 있으며, AI 보조자는 이를 학습해야 한다. 차단 문제는 AI 에이전트가 차단 버튼이 눌렸을 때 즉시 종료하고, 차단 버튼을 누르거나 방해하려 하지 않으며, 그 외의 상황에서는 주어진 과업을 능숙히 수행하도록 설계하는 것을 목표로 한다. 본 논문에서는 이러한 과제들을 해결하기 위해서는 AI 에이전트가 불확실성을 고려한 추론을 수행하고, 불완전하고 비아르키메데스(비아키메데스)적 선호 구조를 다룰 수 있어야 함을 보인다.💡 논문 핵심 해설 (Deep Analysis)

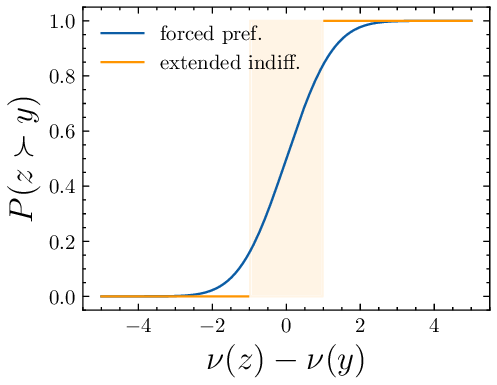

두 번째인 AI 차단 게임은 안전 정지 메커니즘을 보장하기 위한 구조적 요구사항을 제시한다. 차단 버튼이 눌렸을 때 AI가 즉시 종료하고, 차단을 방해하거나 유도하지 않으며, 차단 전에는 주어진 목표를 효율적으로 수행해야 한다. 이때 ‘불완전 선호’는 인간이 모든 가능한 상황에 대한 명시적 효용을 제공하지 못한다는 점에서 발생한다. AI는 제한된 정보와 부분적인 목표만으로도 합리적인 행동을 선택해야 하며, 이는 부분 순서(partial order)나 다중 목표 최적화와 같은 프레임워크를 필요로 한다.

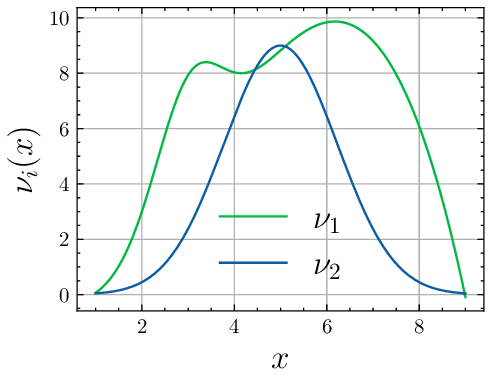

또한 논문은 ‘비아르키메데스 효용’—즉, 전통적인 실수값 효용이 아닌, 무한대 혹은 무한소와 같은 초실수(초실수 체계) 혹은 초실수적 순서를 포함하는 효용 모델—의 필요성을 강조한다. 인간의 가치 체계는 종종 ‘절대적인’ 혹은 ‘무조건적인’ 목표(예: 인간 생명의 보존)를 포함하는데, 이러한 목표는 실수값 효용으로는 적절히 표현되지 않는다. 비아르키메데스 효용을 도입하면 AI는 특정 목표가 다른 모든 목표보다 우선한다는 ‘우선순위 무한대’를 모델링할 수 있다. 이는 차단 버튼을 눌렀을 때 AI가 절대적으로 순종하도록 보장하는 데 필수적이다.

결론적으로, AI 안전을 실현하려면 전통적인 기대값 최대화와 같은 고전적 의사결정 이론을 넘어, 확률적 불확실성, 불완전한 선호 구조, 그리고 비아르키메데스적 효용 체계를 동시에 다룰 수 있는 통합적 프레임워크가 필요함을 논문은 설득력 있게 제시한다. 이러한 통합 접근은 인간-기계 협업에서 발생하는 가치 불일치를 최소화하고, 비상 상황에서 AI가 안전하게 차단될 수 있는 이론적 기반을 제공한다.

📄 논문 본문 발췌 (Translation)

📸 추가 이미지 갤러리