일반화된 정규화 증거 기반 딥러닝 모델: 이론과 포괄적 평가

📝 원문 정보

- Title: Generalized Regularized Evidential Deep Learning Models: Theory and Comprehensive Evaluation

- ArXiv ID: 2512.23753

- 발행일: 2025-12-27

- 저자: Deep Shankar Pandey, Hyomin Choi, Qi Yu

📝 초록 (Abstract)

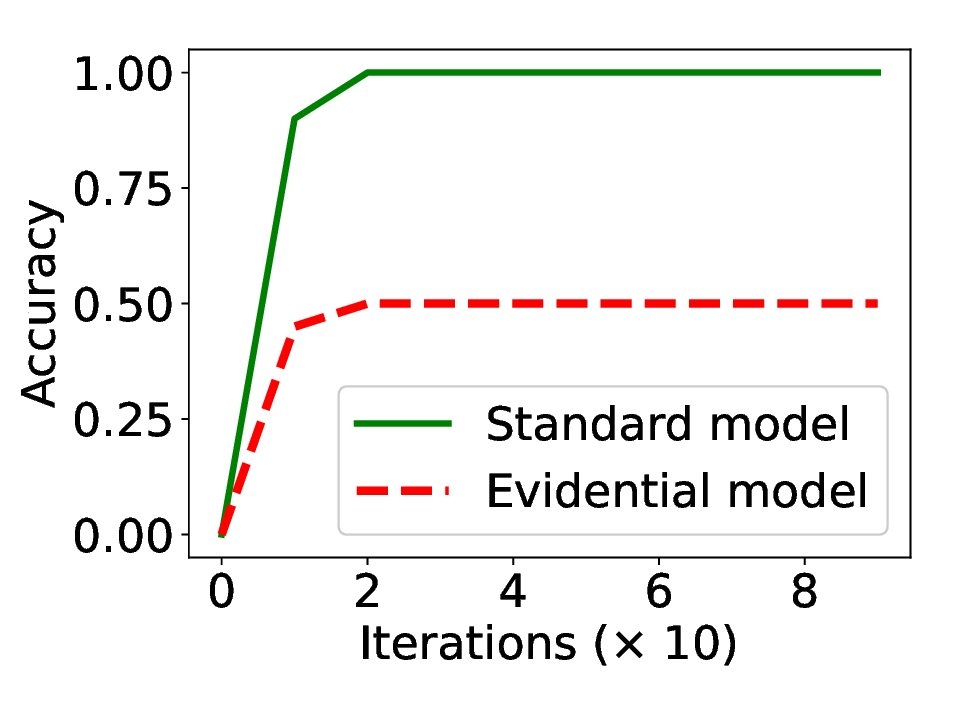

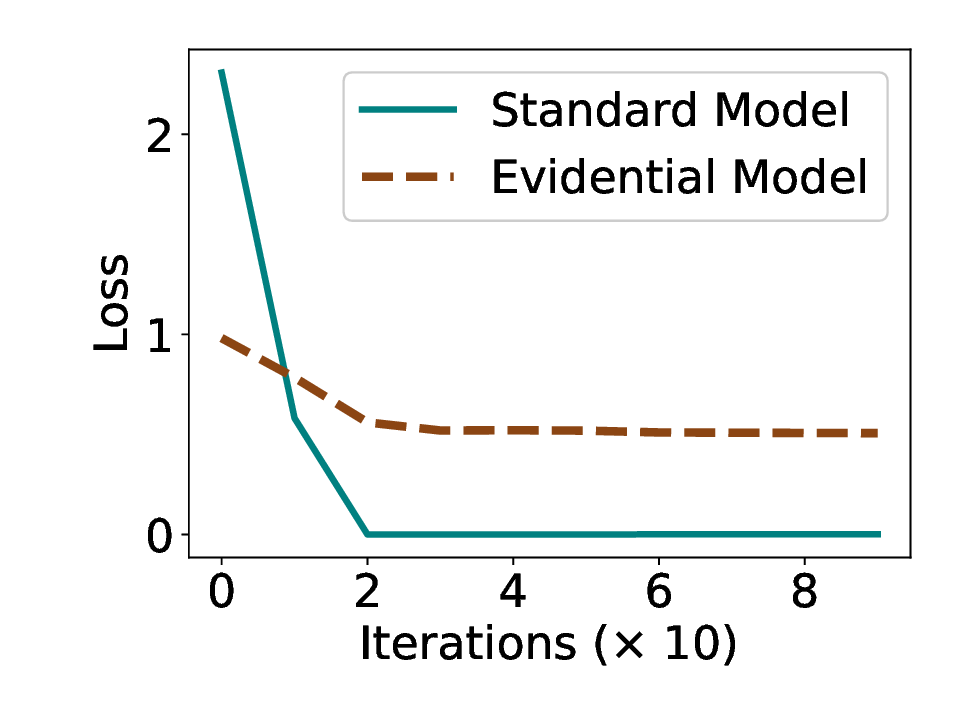

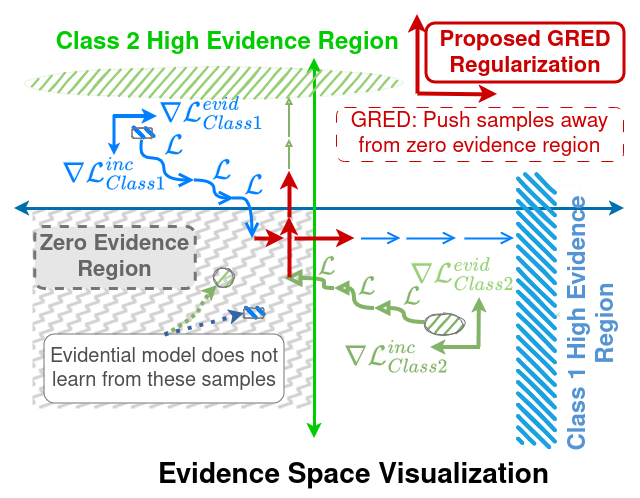

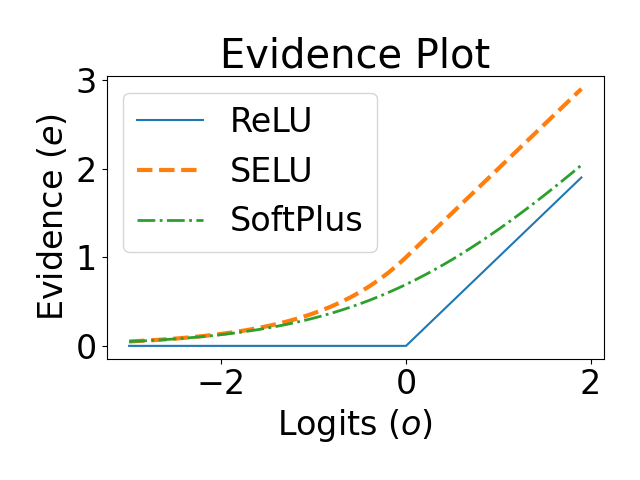

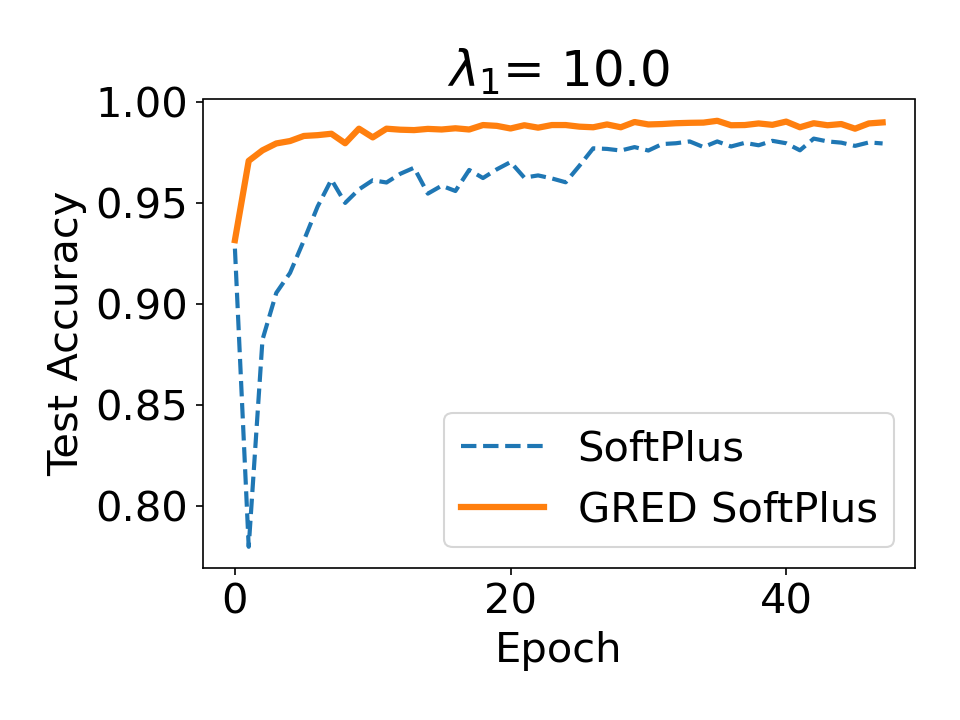

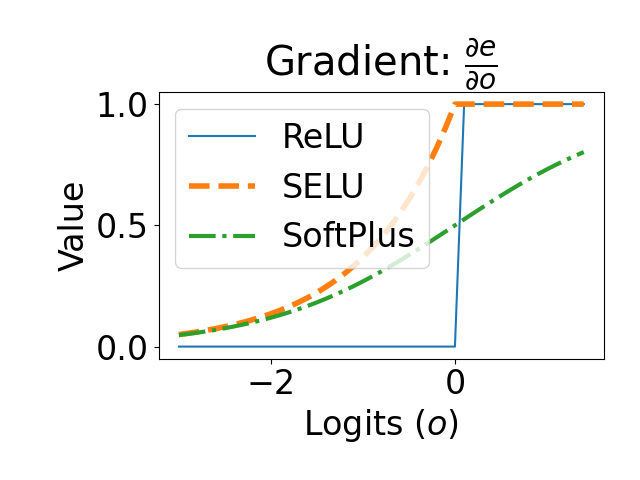

증거 기반 딥러닝(EDL) 모델은 주관적 논리(Subjective Logic)를 기반으로, 결정적 신경망에 불확실성 인식을 효율적으로 부여한다. 학습된 증거를 통해 미세한 불확실성을 정량화할 수 있지만, 주관적 논리 프레임워크는 증거를 비음수로 제한하므로 특수한 활성화 함수가 필요하다. 이러한 활성화 함수의 기하학적 특성은 낮은 증거 영역으로 매핑된 샘플에 대해 기울기가 급격히 감소하는 ‘학습 고정(learning‑freeze)’ 현상을 초래한다. 본 논문은 이 현상을 이론적으로 규명하고, 다양한 증거 활성화가 학습 역학에 미치는 영향을 분석한다. 분석 결과를 토대로, 활성화 구간 전반에 걸쳐 일관된 증거 업데이트를 가능하게 하는 일반화된 활성화 함수군과 대응하는 증거 정규화 항을 설계하였다. MNIST, CIFAR‑10, CIFAR‑100, Tiny‑ImageNet 네 가지 분류 벤치마크와 두 개의 few‑shot 분류 과제, 그리고 블라인드 얼굴 복원 문제에 대한 광범위한 실험을 통해 제안된 이론과 모델의 유효성을 입증하였다.💡 논문 핵심 해설 (Deep Analysis)

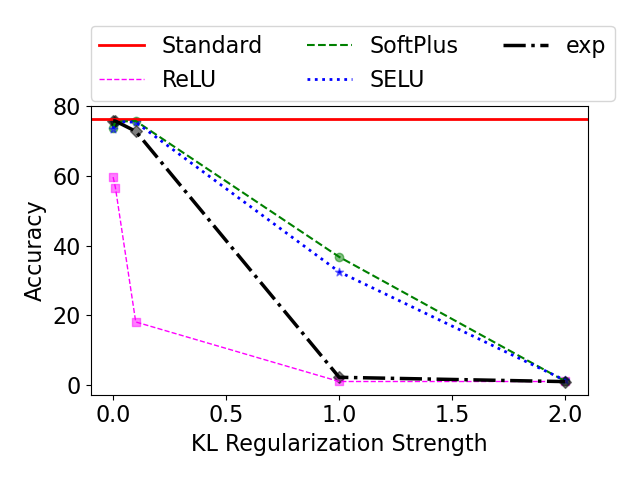

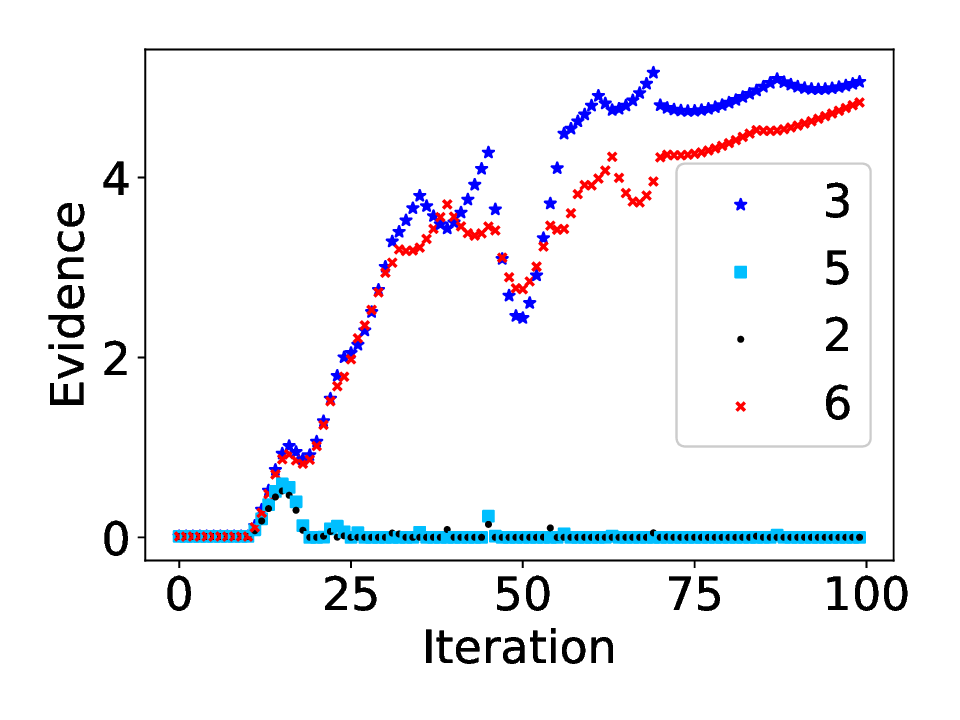

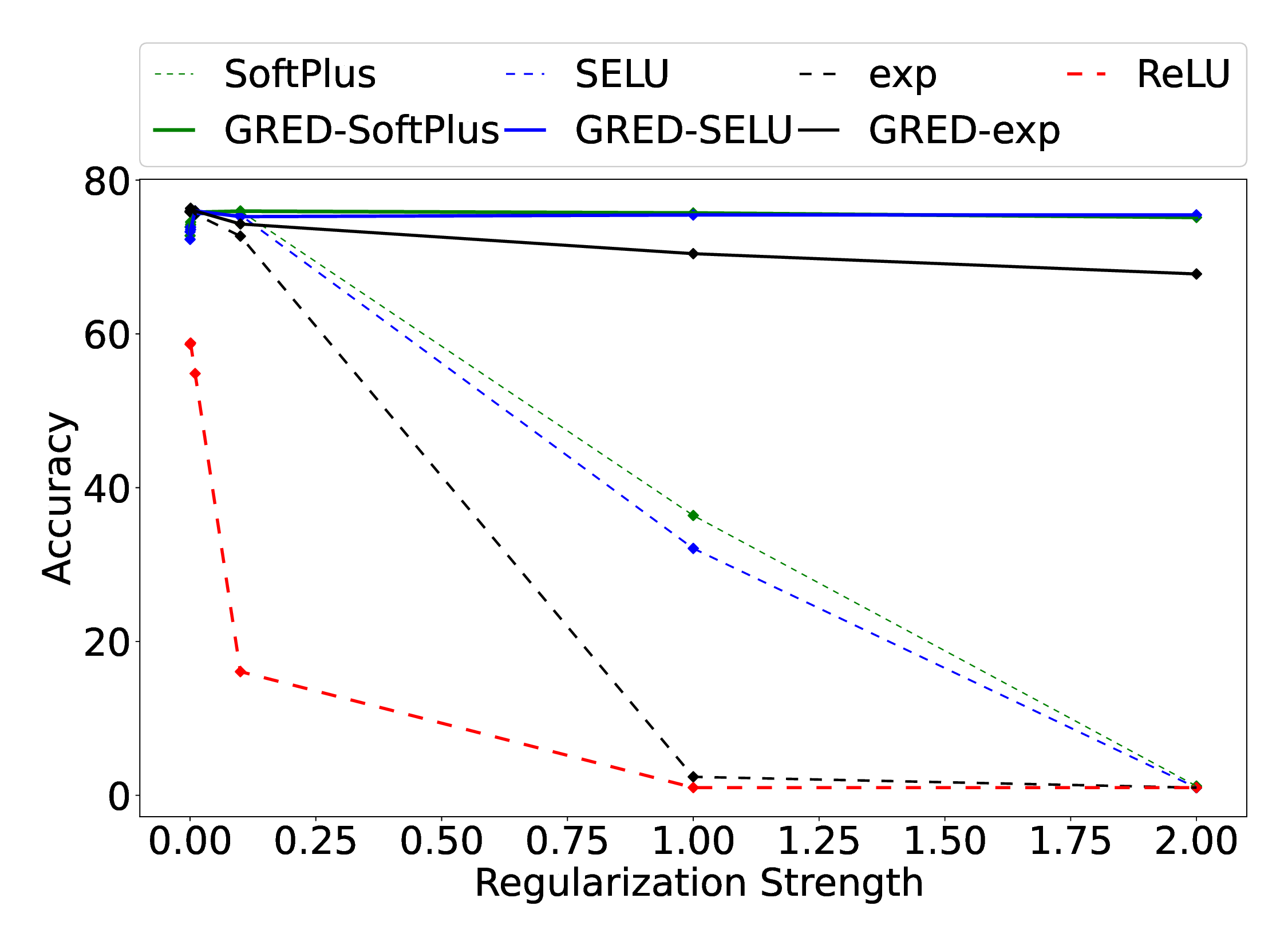

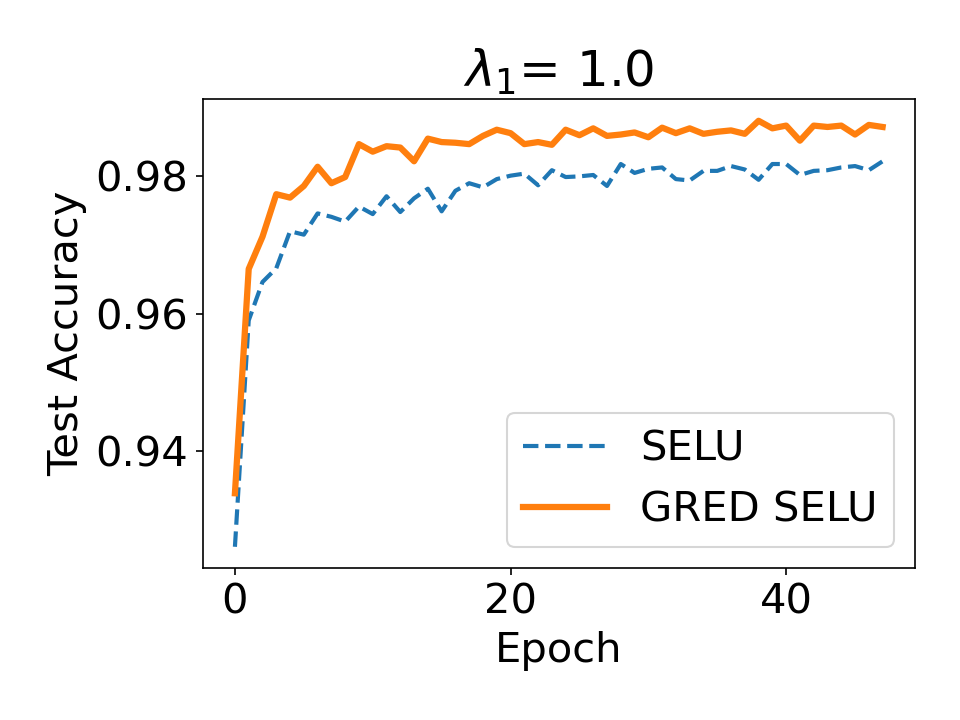

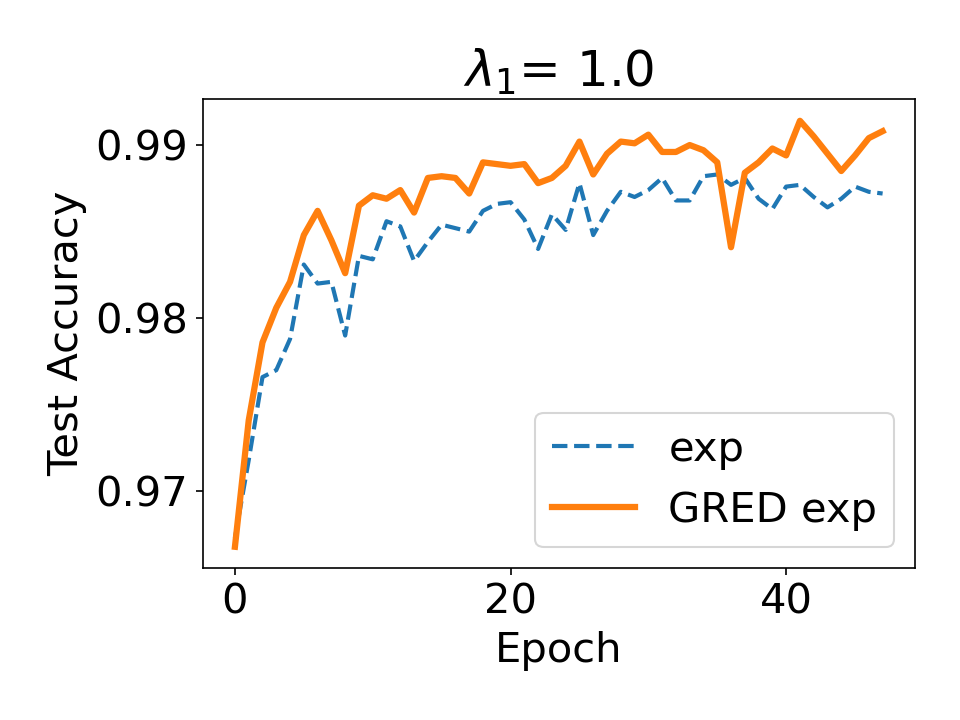

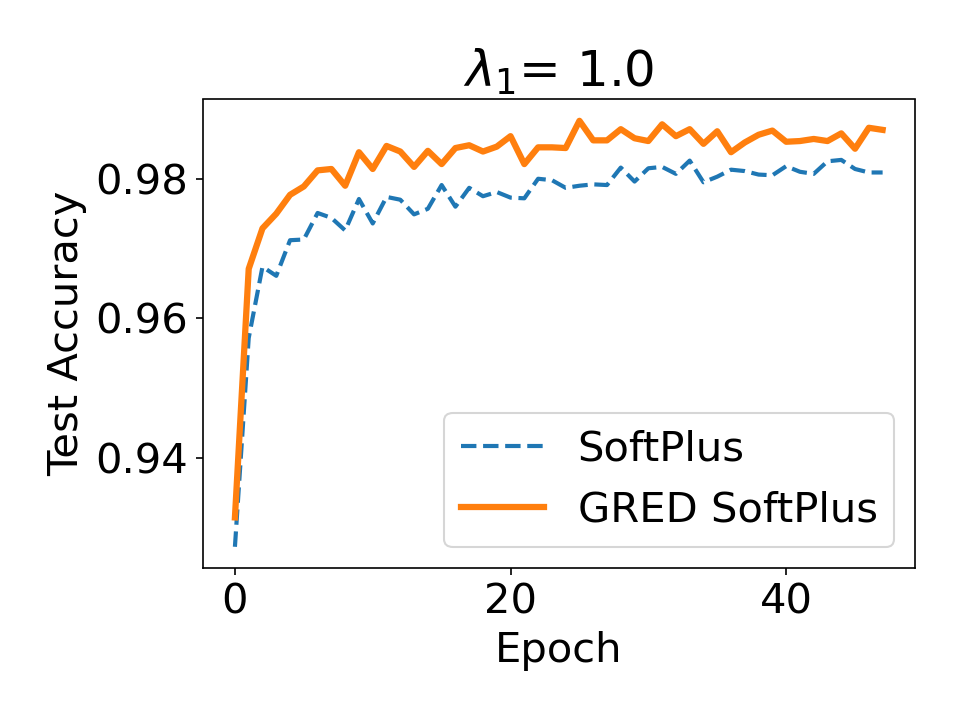

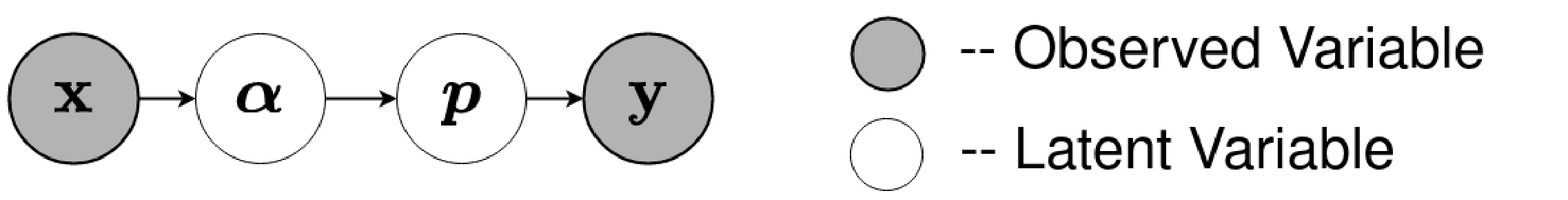

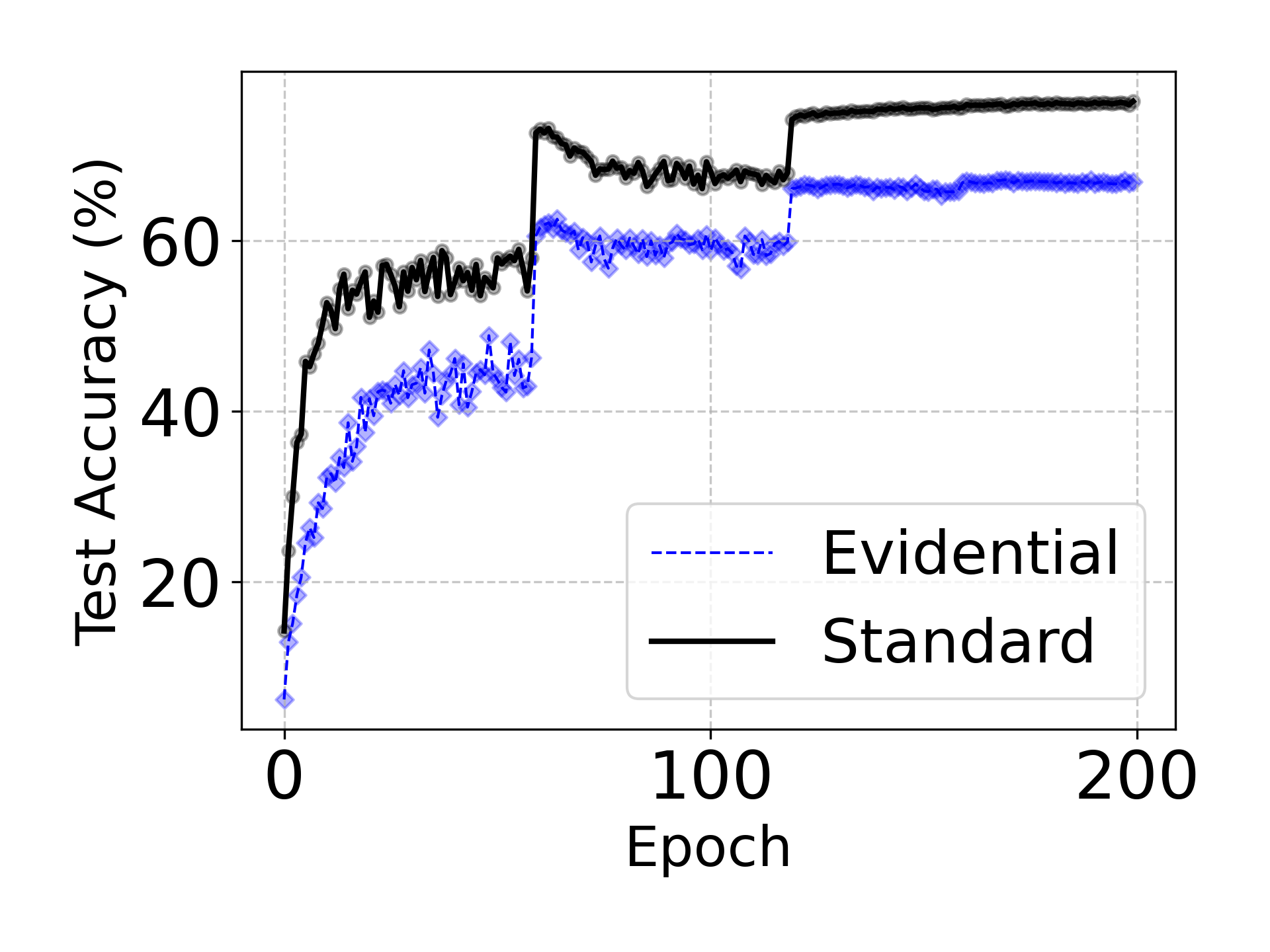

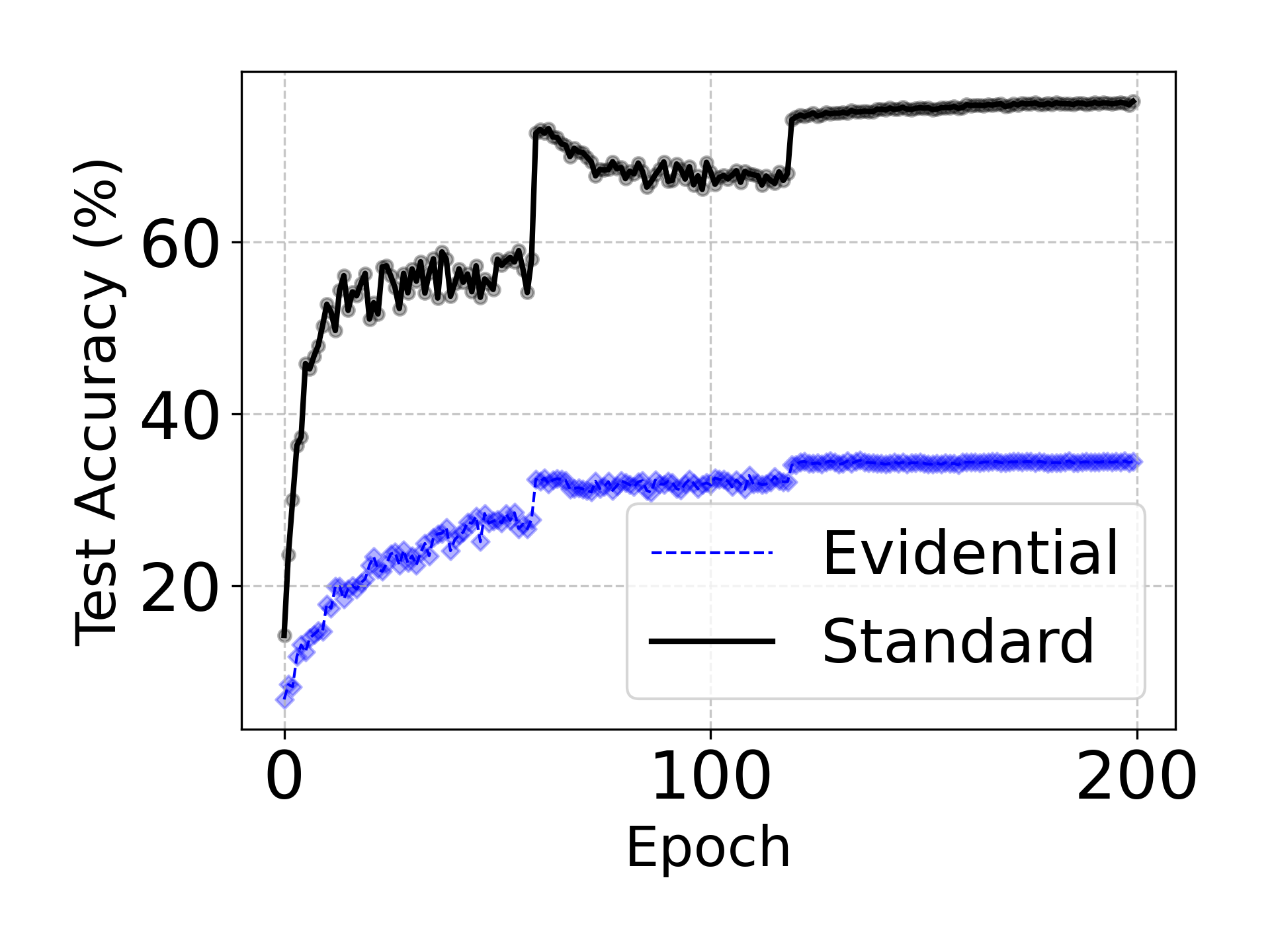

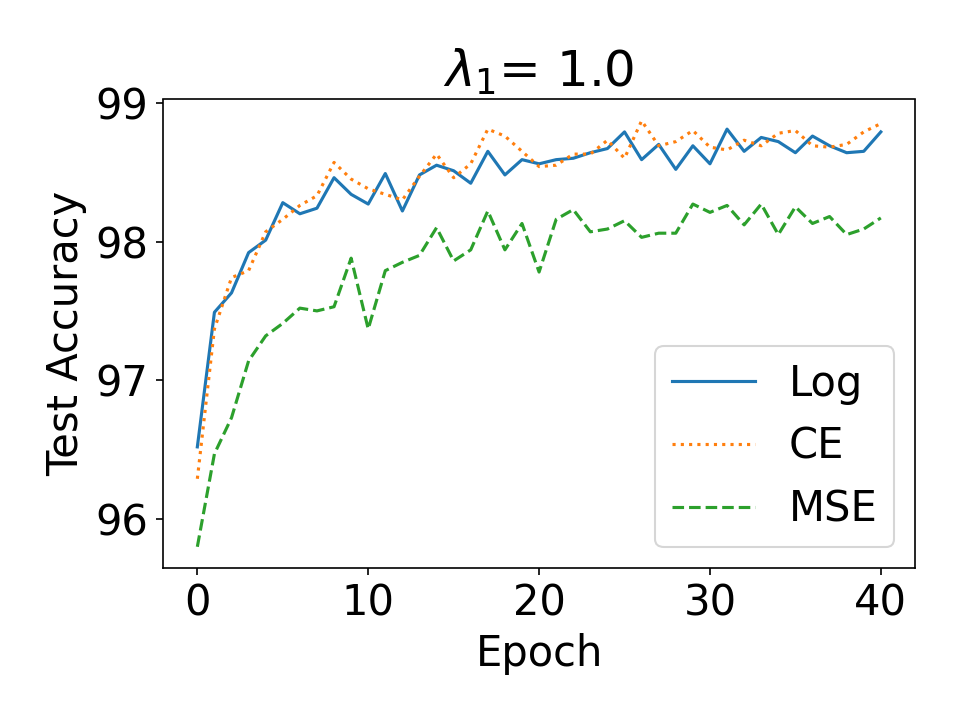

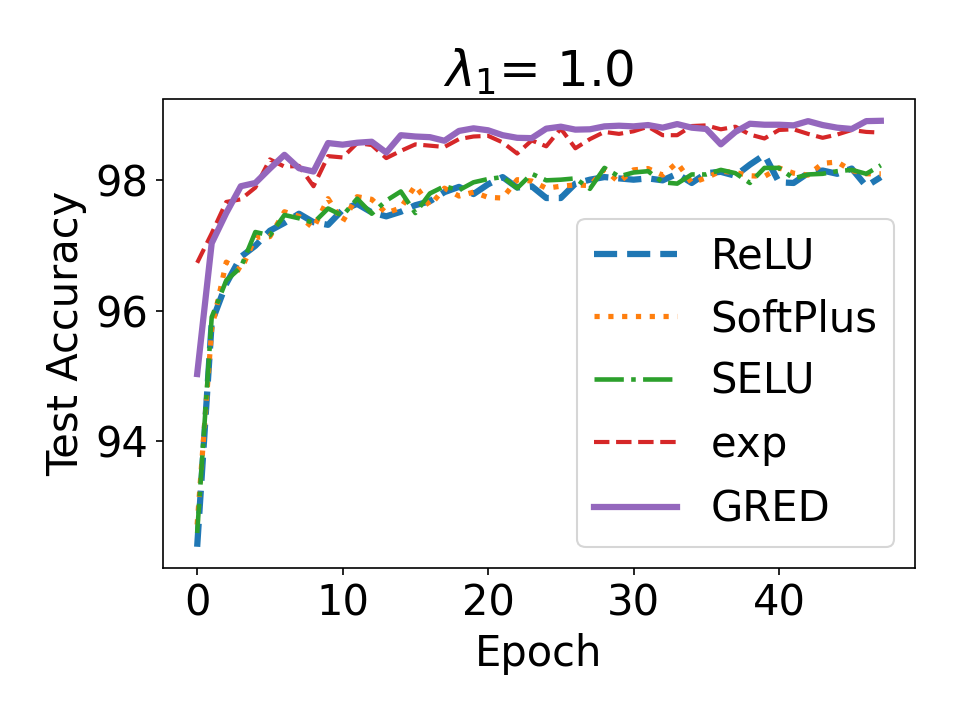

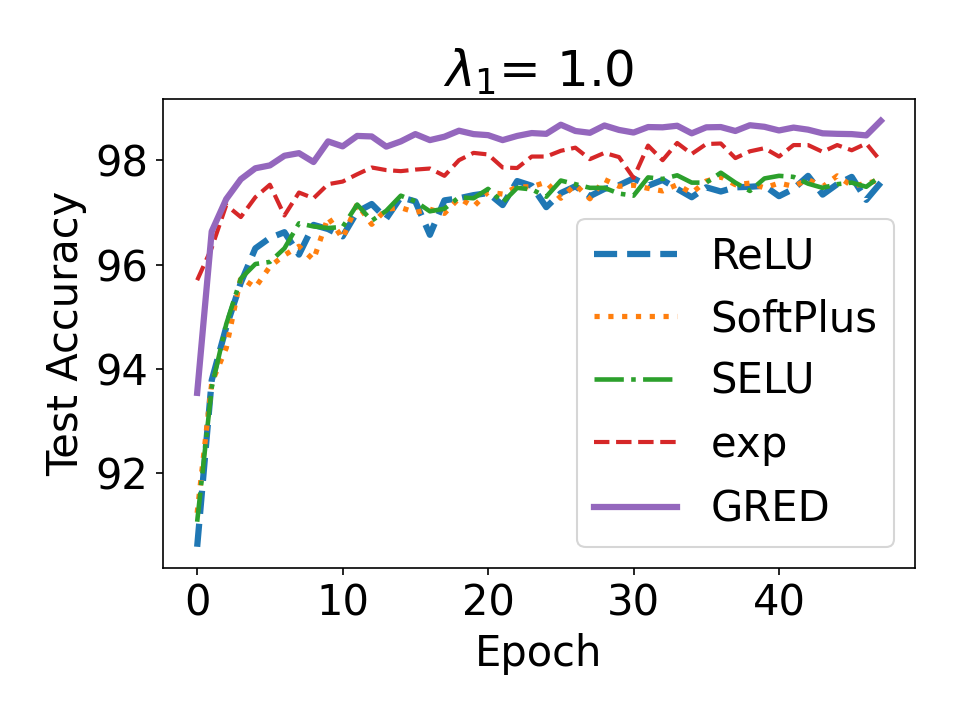

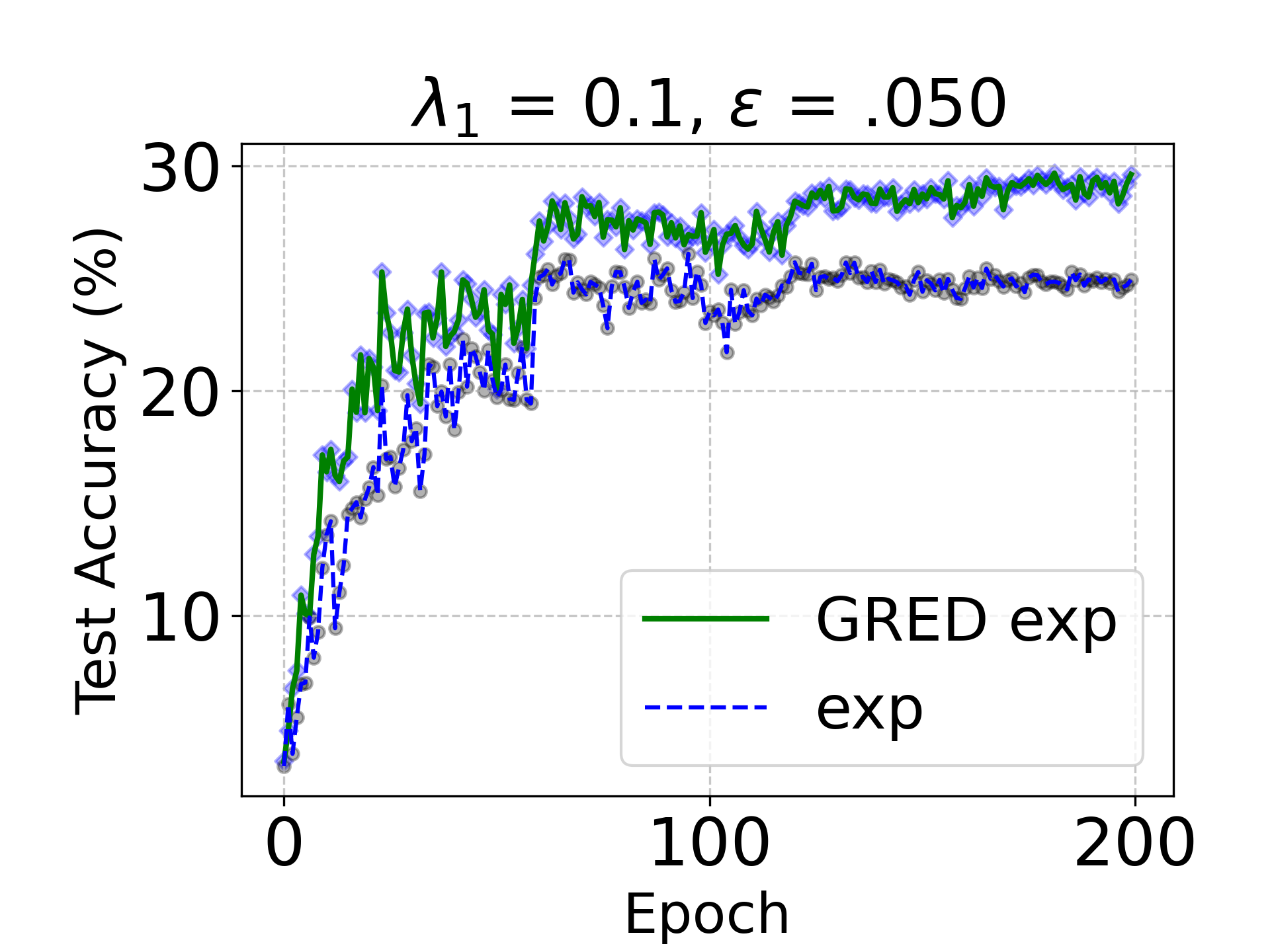

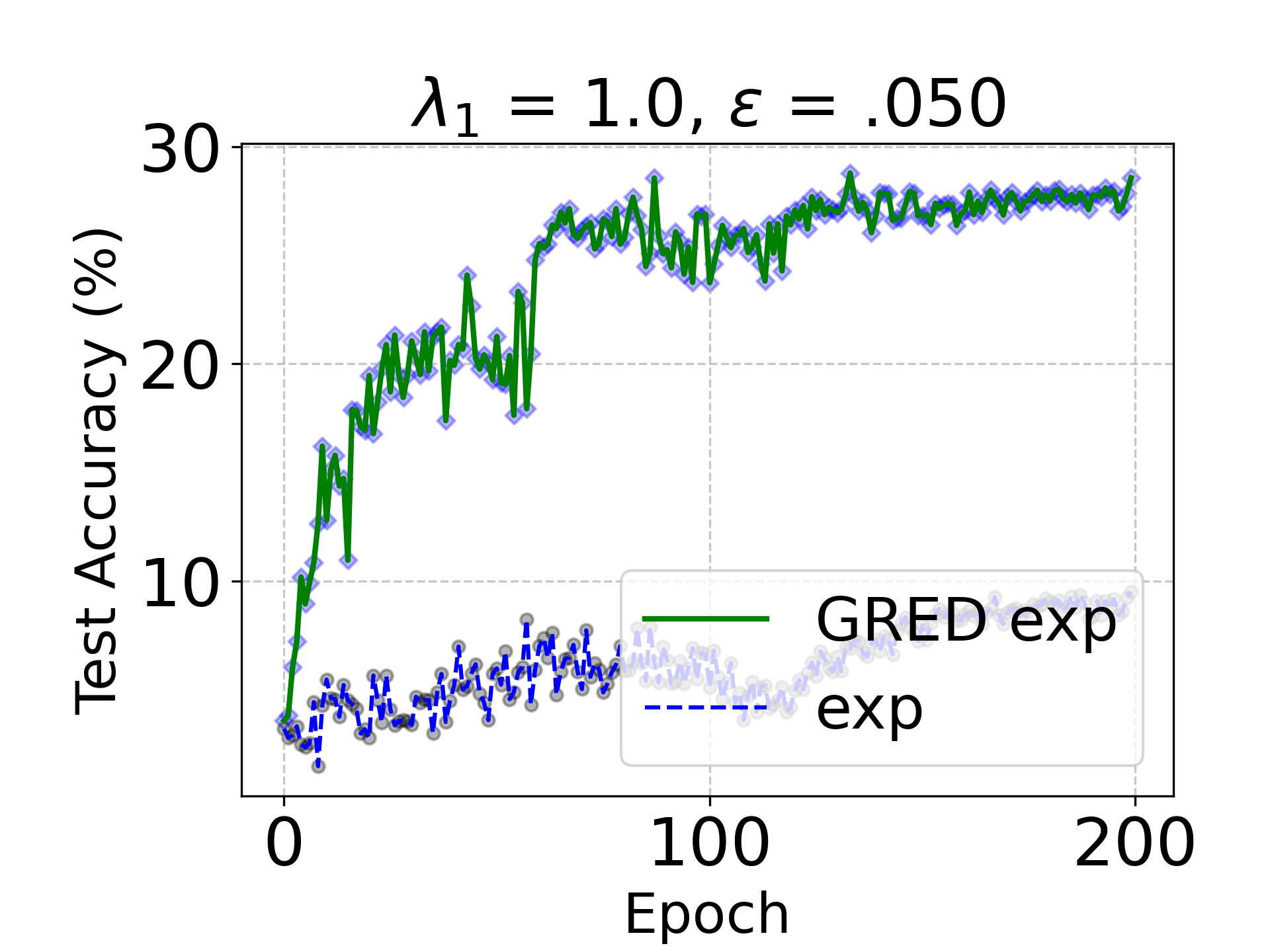

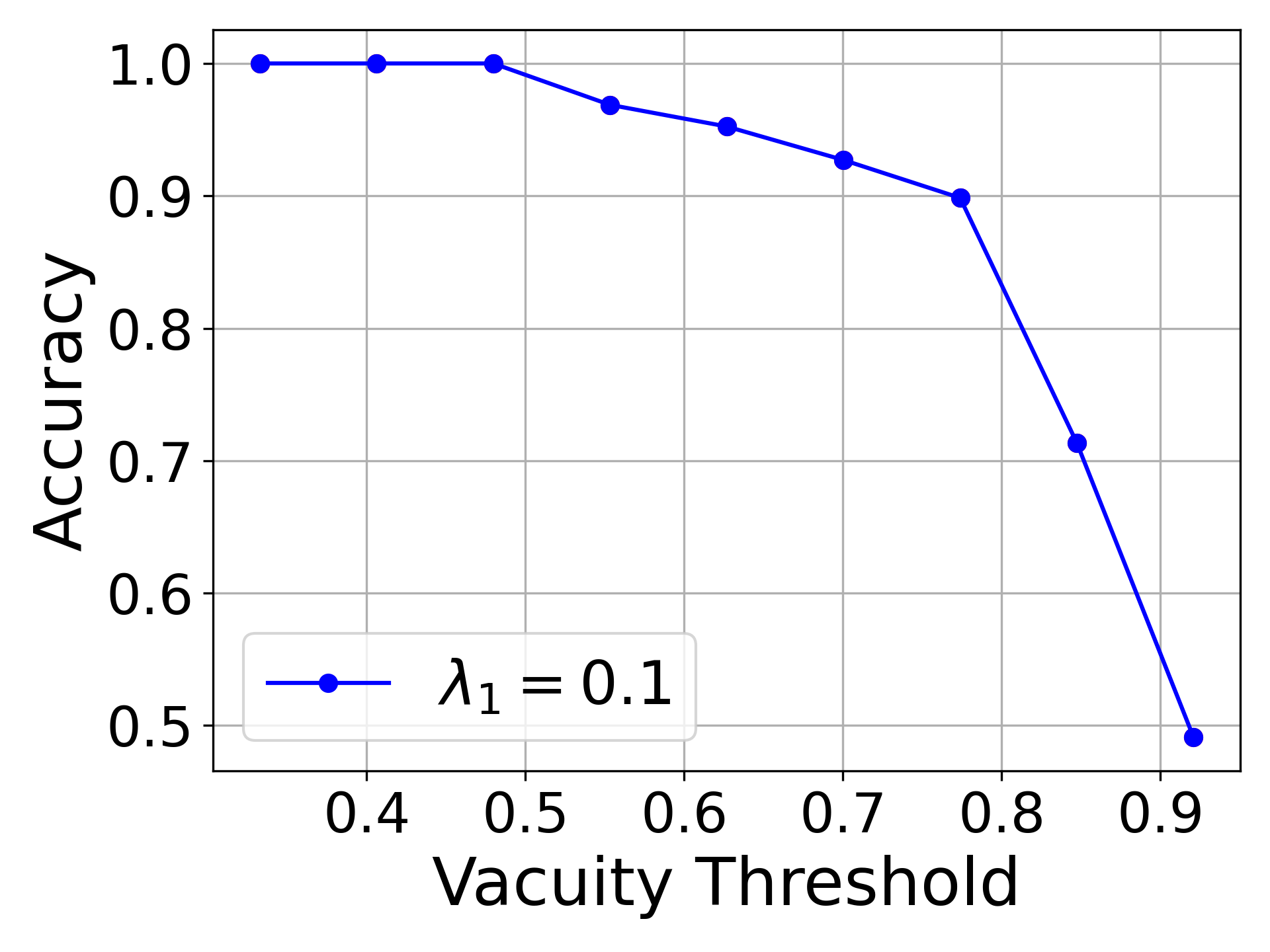

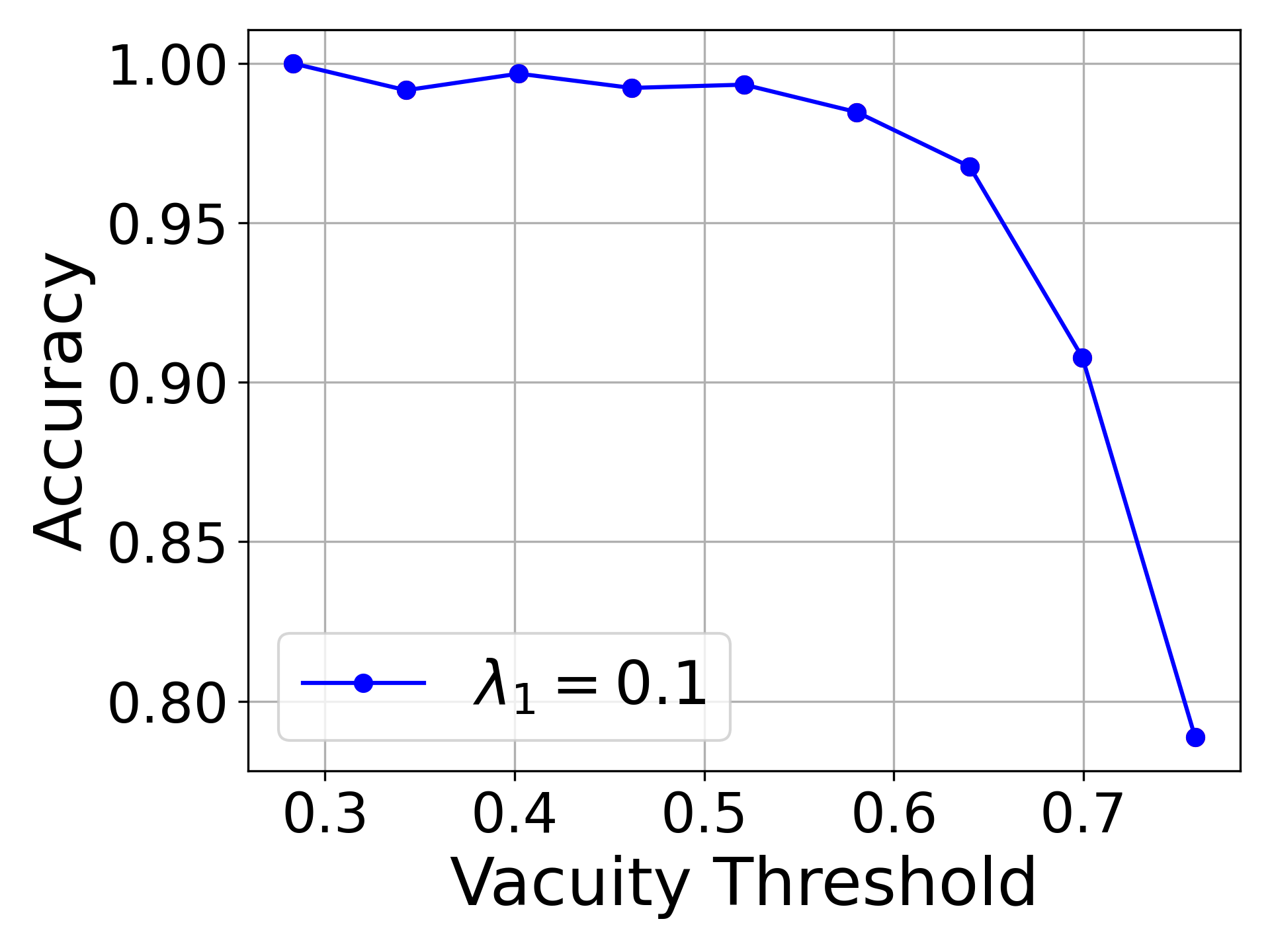

다음으로 저자들은 다양한 활성화 함수가 증거 분포와 학습 역학에 미치는 영향을 실험적으로 비교한다. 실험 결과, 급격한 포화 구간을 갖는 함수는 학습 초기에 빠른 수렴을 보이지만, 이후 증거가 낮은 영역에 도달하면 학습이 멈추는 반면, 완만한 기울기를 유지하는 함수는 초기 수렴이 느리지만 전체 학습 과정에서 보다 안정적인 증거 업데이트를 가능하게 한다는 점을 확인한다.

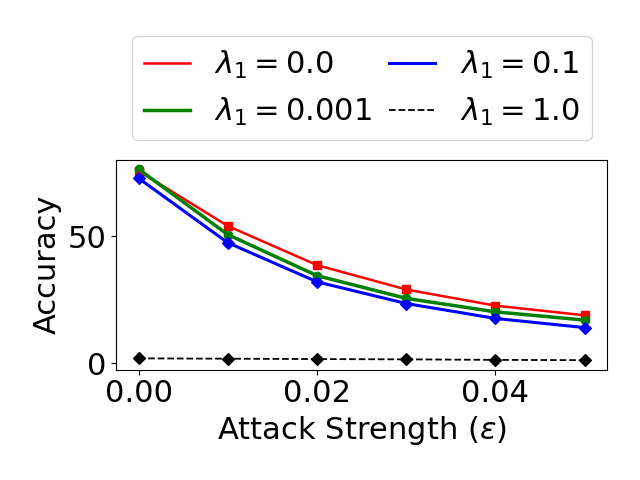

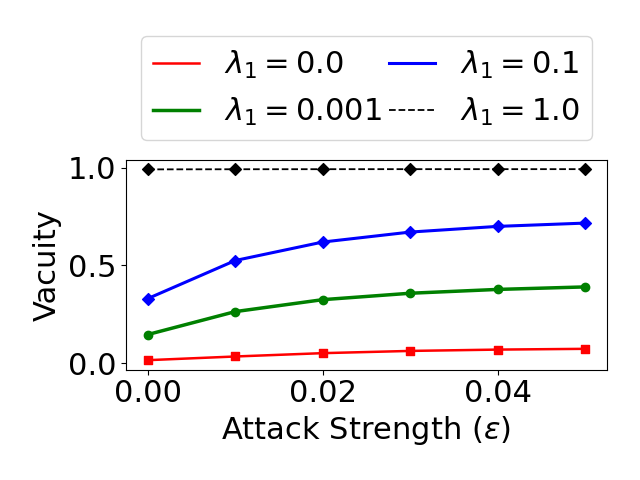

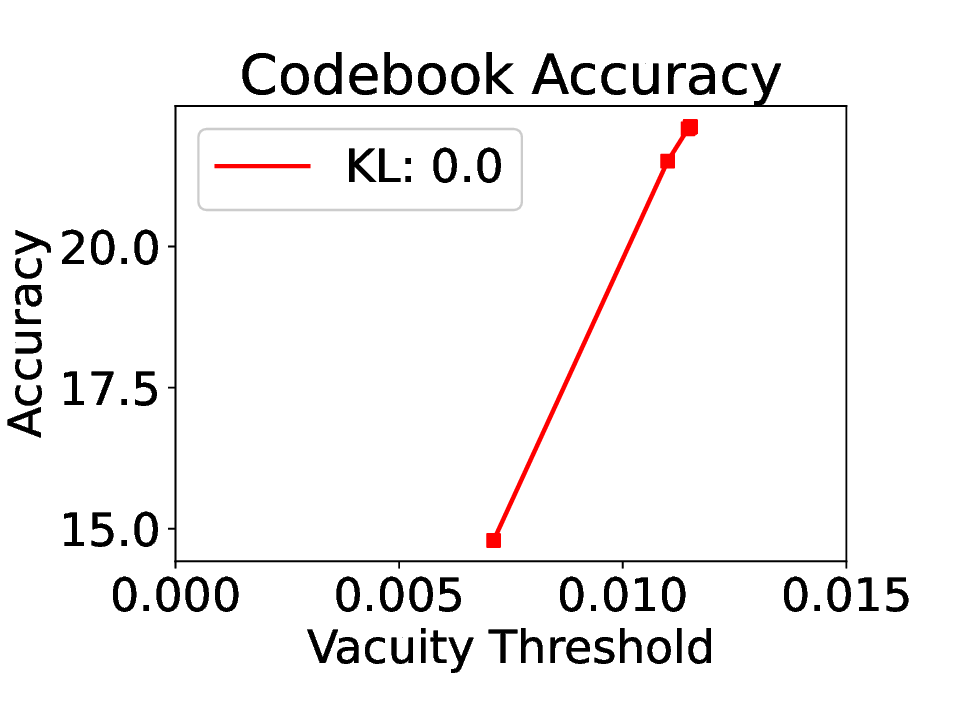

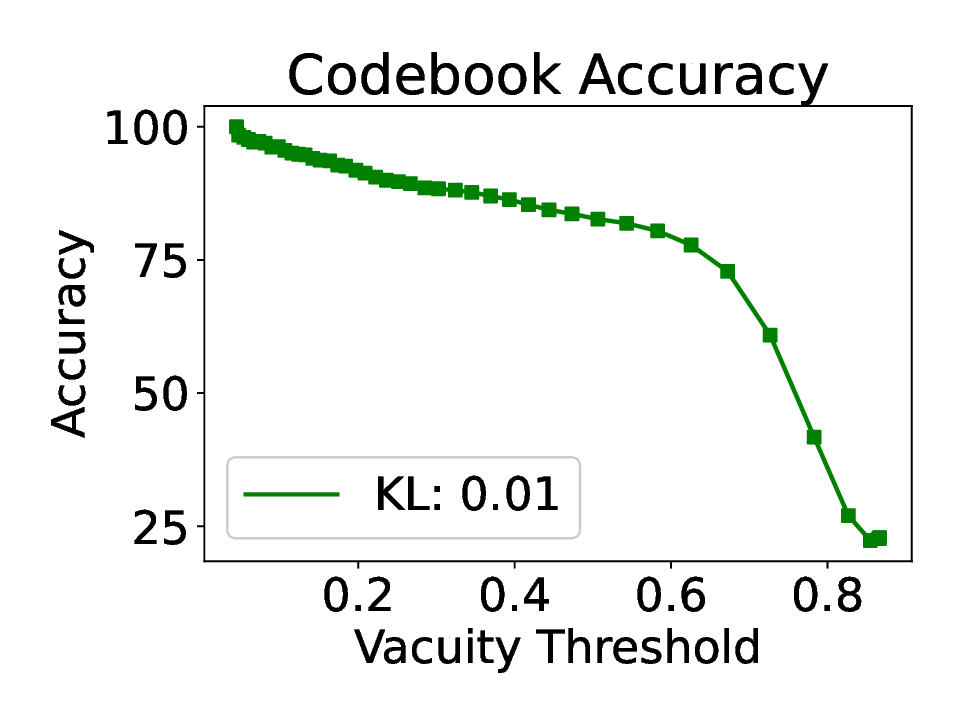

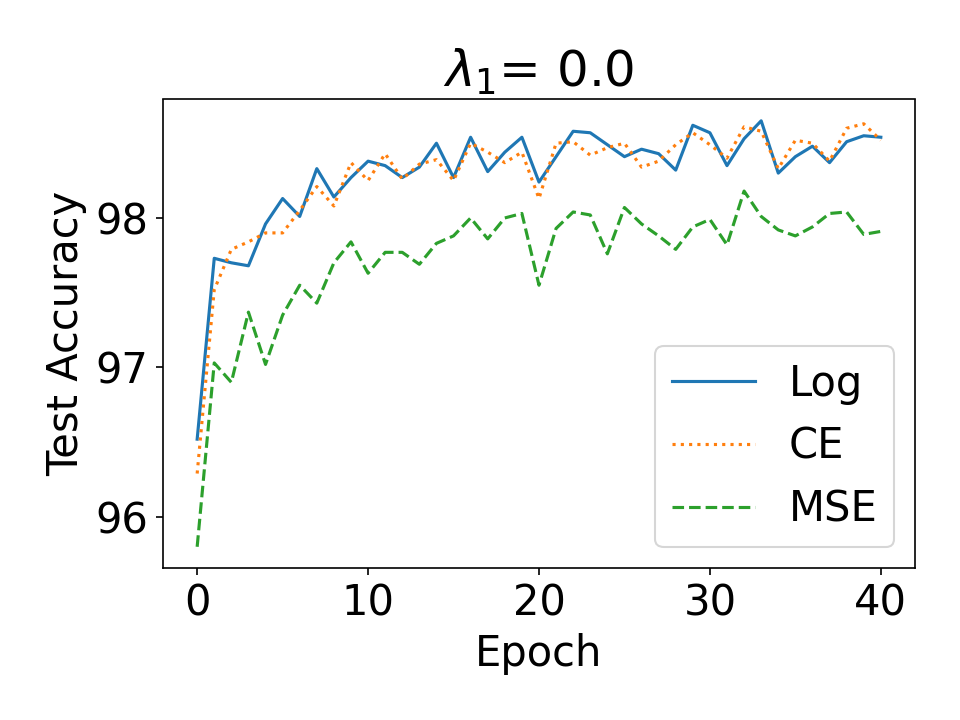

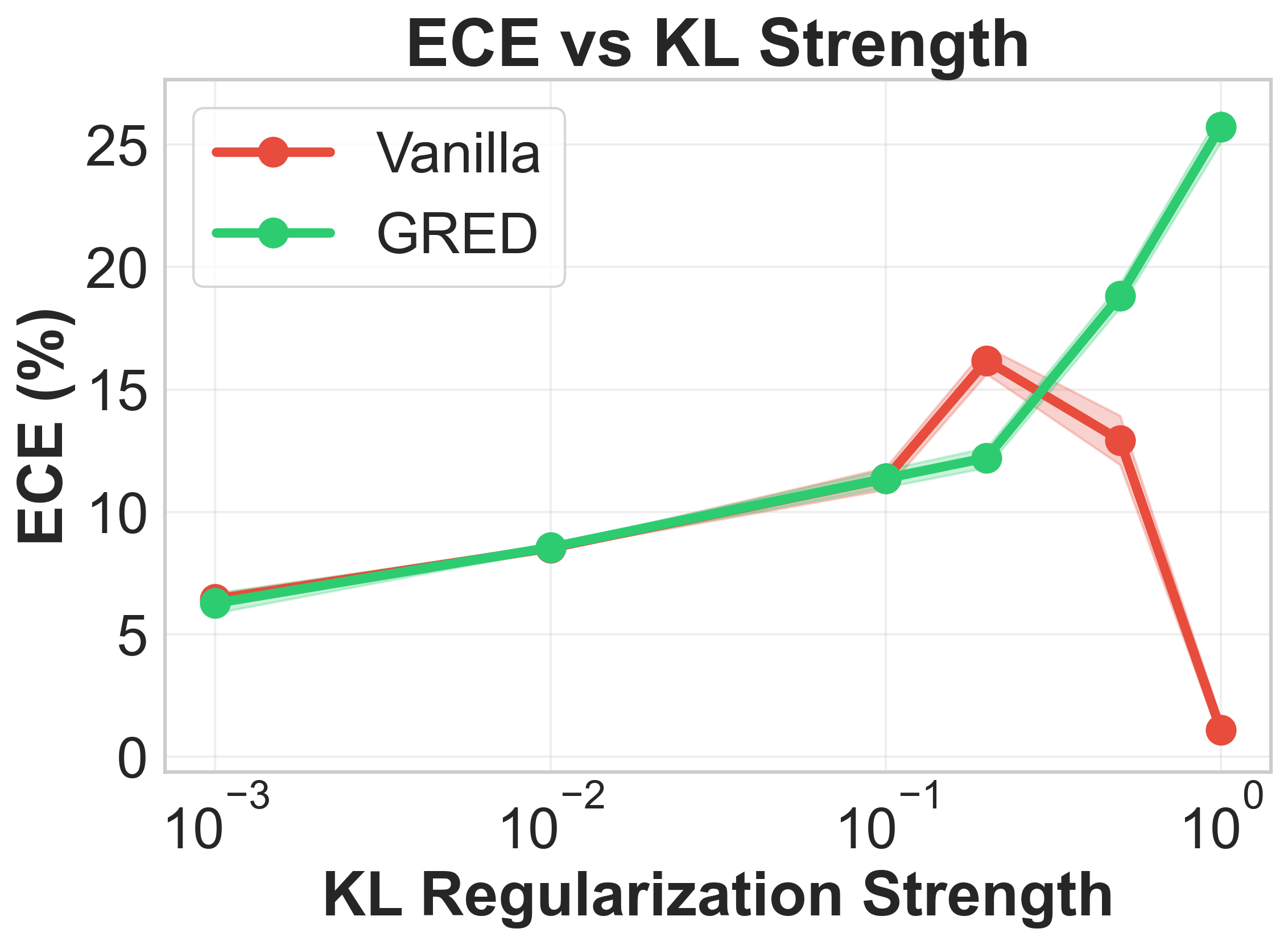

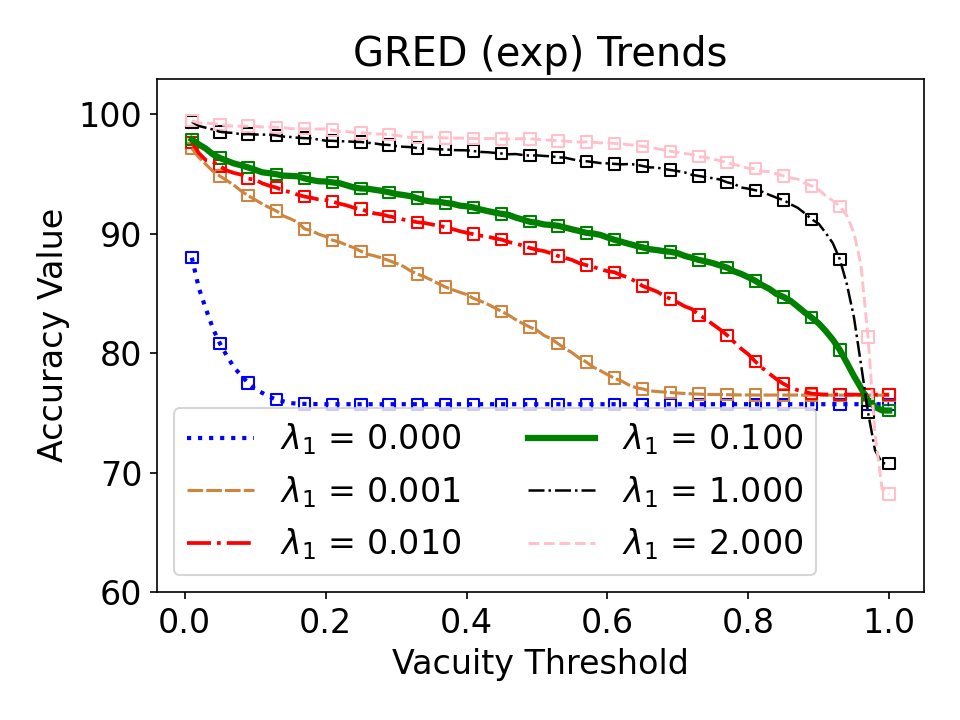

이러한 분석을 바탕으로 제안된 ‘일반화된 정규화 증거 활성화(Generalized Regularized Evidential Activation)’는 두 가지 핵심 아이디어를 결합한다. 첫째, 활성화 함수 자체를 파라미터화하여 학습 과정에서 최적의 형태를 스스로 찾게 함으로써, 증거가 0에 수렴하는 구간을 최소화한다. 둘째, 증거 정규화 항을 활성화 함수의 출력 범위에 맞게 설계하여, 증거가 충분히 작은 경우에도 손실이 충분히 큰 값을 제공하도록 한다. 이 정규화 항은 기존 EDL에서 사용되는 KL‑다이버전스 기반 정규화와는 달리, 활성화 함수의 기하학적 특성을 직접 반영한다.

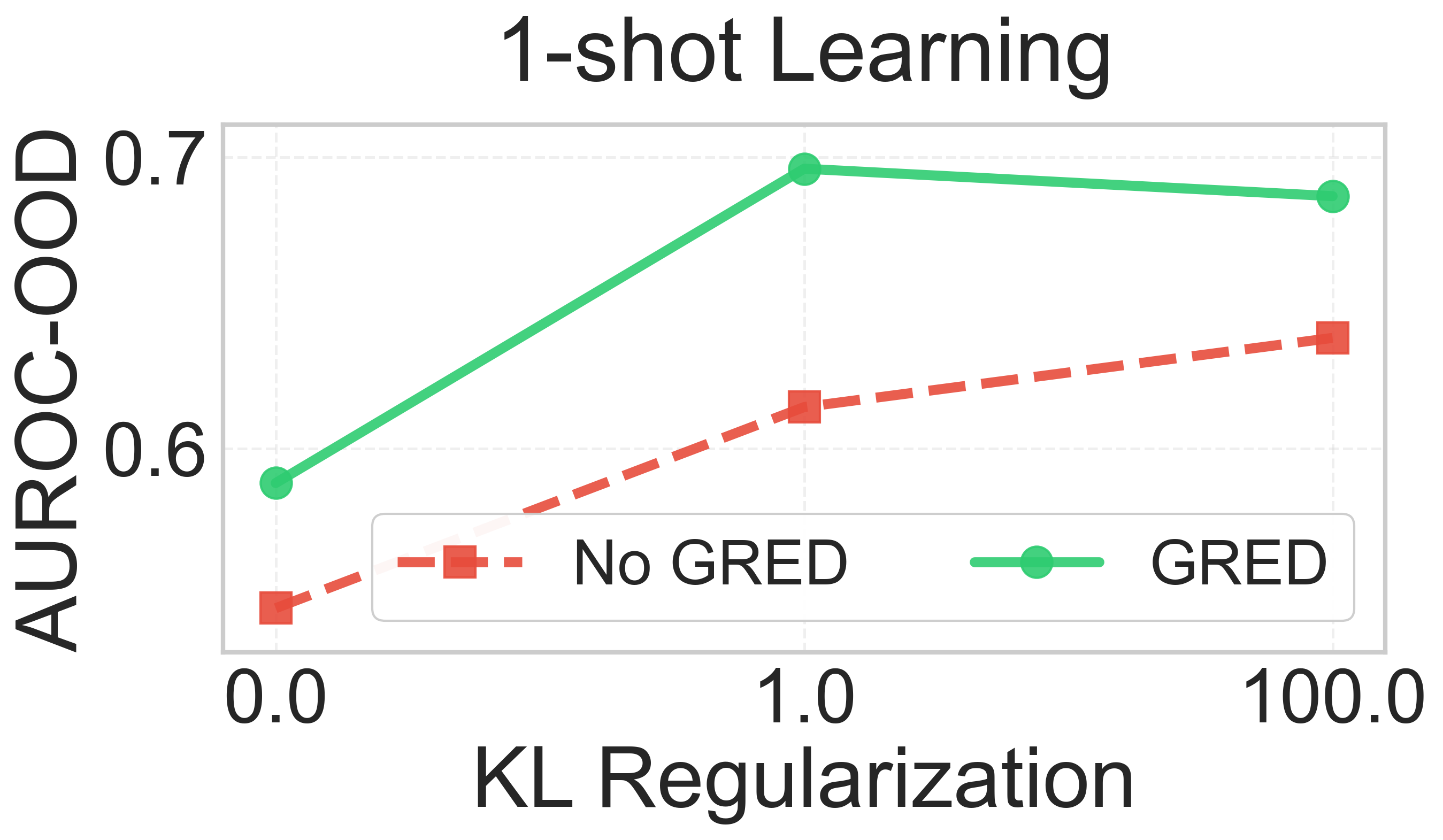

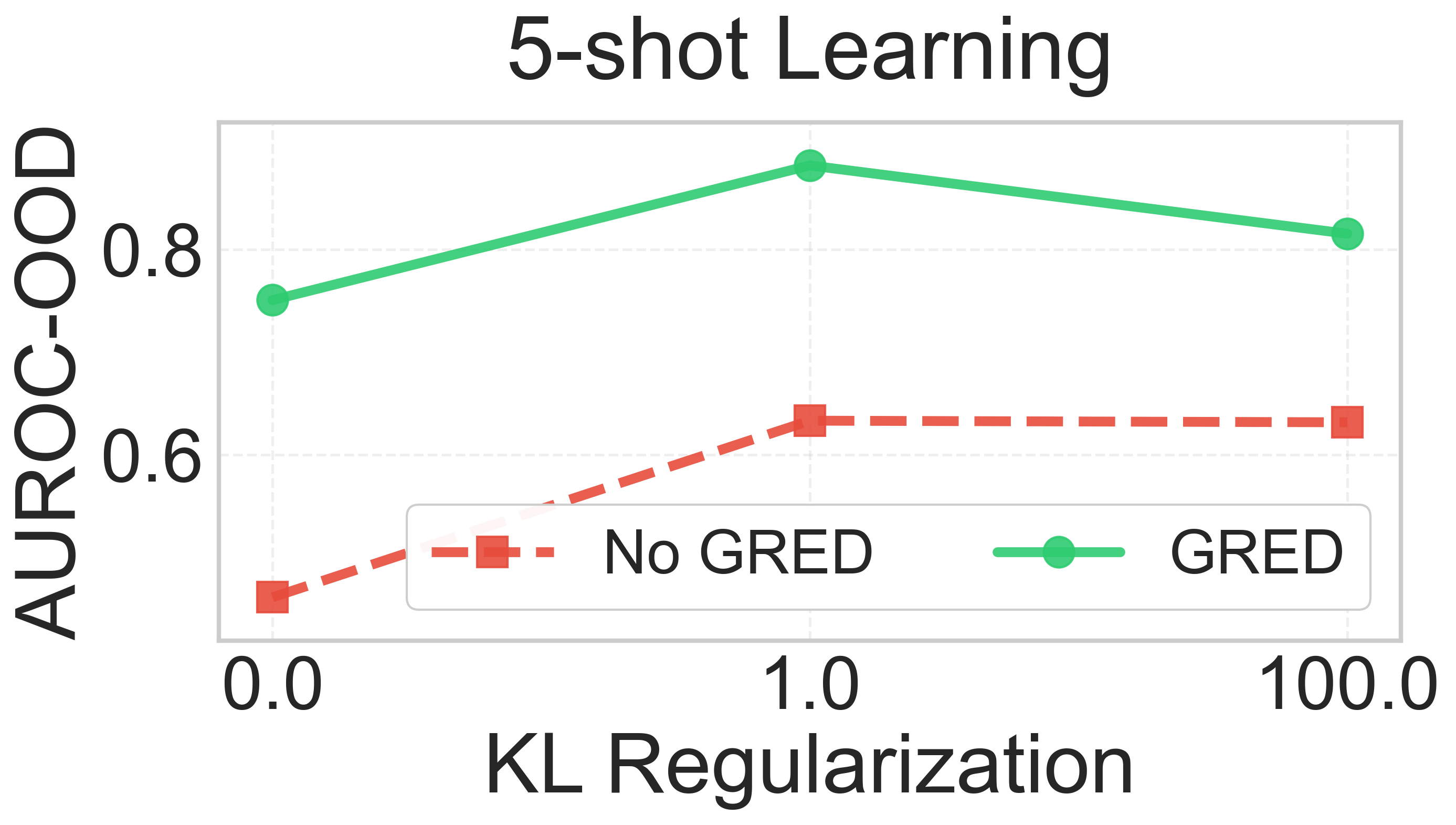

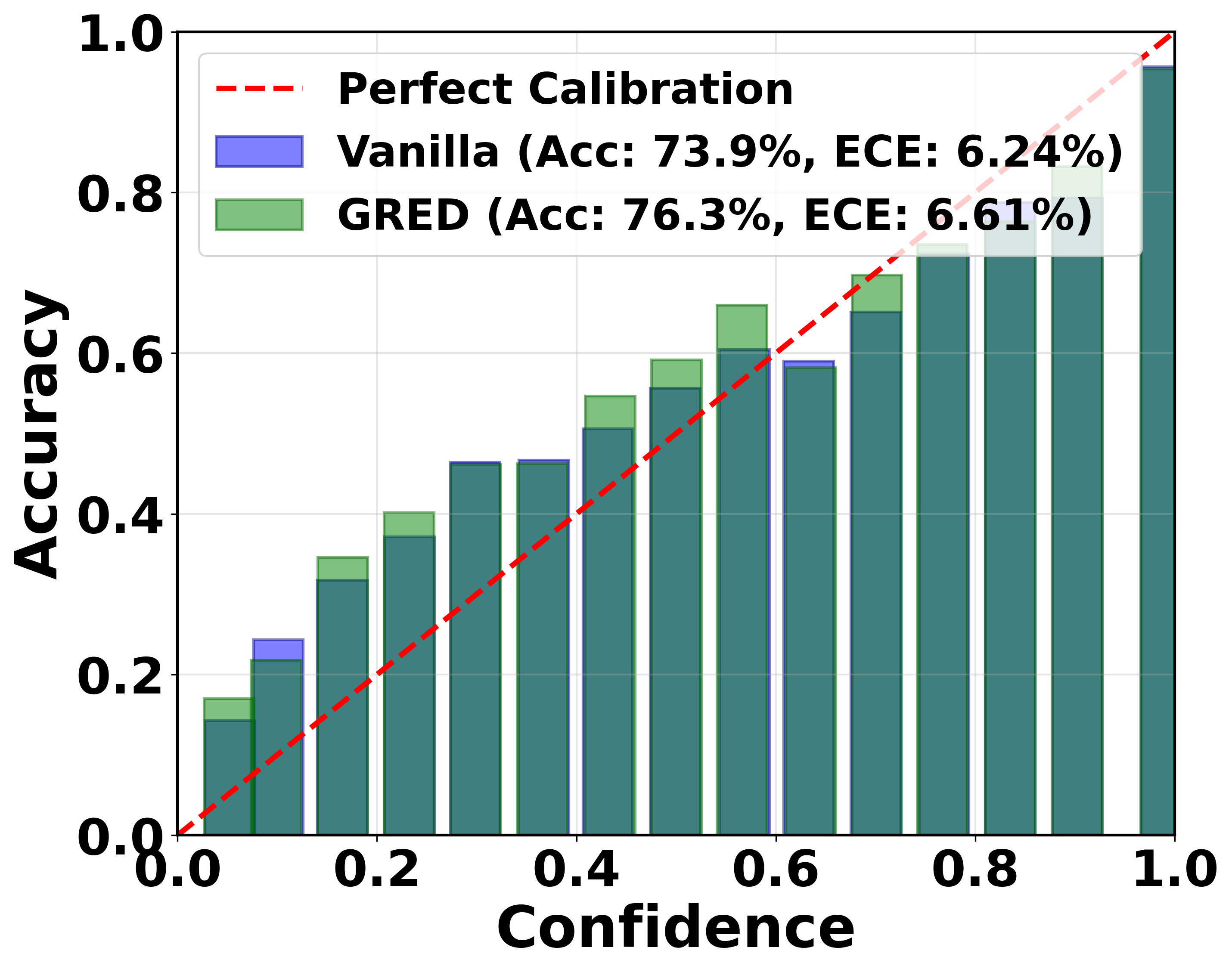

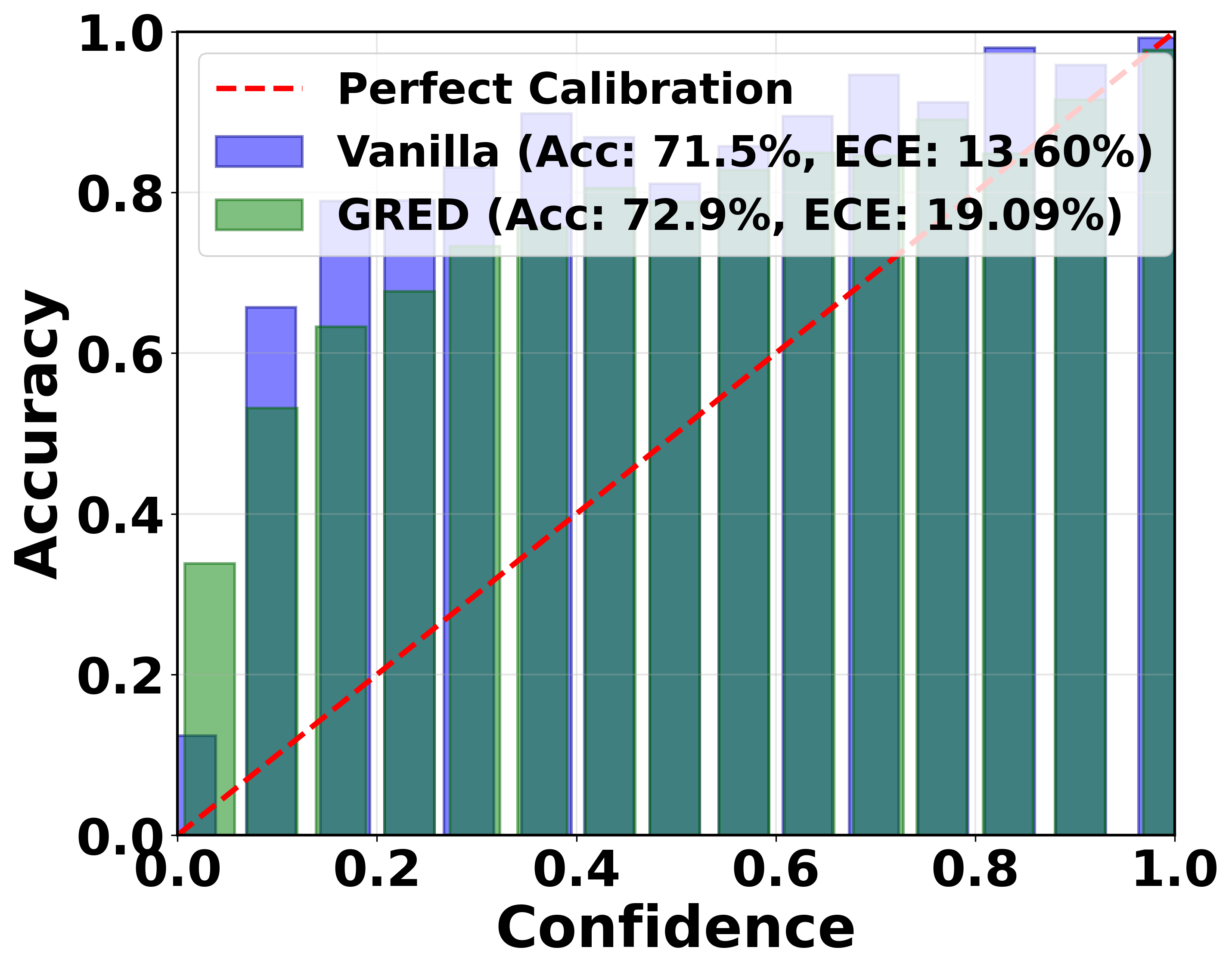

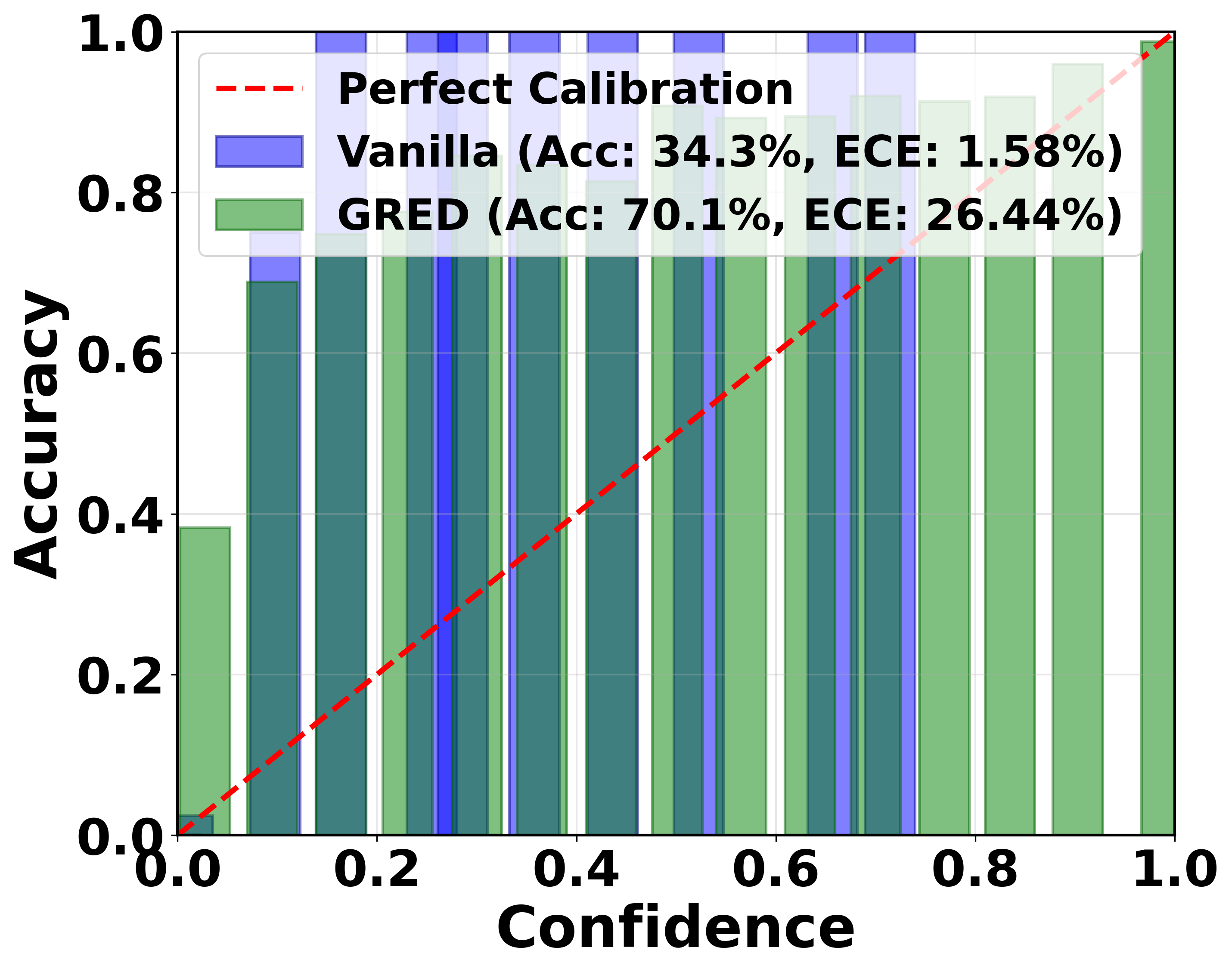

제안된 모델은 네 가지 표준 이미지 분류 벤치마크와 두 개의 few‑shot 학습 시나리오, 그리고 블라인드 얼굴 복원이라는 비전 분야의 실용적 문제에 적용되었다. 실험 결과, 기존 EDL 모델 대비 정확도와 불확실성 추정의 캘리브레이션이 모두 향상되었으며, 특히 데이터가 제한된 few‑shot 상황에서 과적합을 방지하고 보다 신뢰할 수 있는 예측을 제공한다는 점이 강조된다. 또한, 블라인드 얼굴 복원 실험에서는 증거 기반 불확실성 추정이 복원 품질을 정량화하는 새로운 메트릭으로 활용될 수 있음을 보여준다.

전반적으로 이 논문은 EDL의 이론적 한계를 명확히 규명하고, 활성화 함수와 정규화 전략을 통합한 일반화된 프레임워크를 제시함으로써, 불확실성 인식 딥러닝 모델의 실용성을 크게 확장시킨다. 향후 연구에서는 제안된 활성화 함수의 파라미터를 메타러닝이나 베이지안 최적화와 결합하거나, 시계열·자연어 처리와 같은 다른 도메인에 적용하는 방향이 기대된다.

📄 논문 본문 발췌 (Translation)

📸 추가 이미지 갤러리