PerfCoder 대규모 언어 모델을 활용한 해석 가능한 코드 성능 최적화

📝 원문 정보

- Title: PerfCoder: Large Language Models for Interpretable Code Performance Optimization

- ArXiv ID: 2512.14018

- 발행일: 2025-12-16

- 저자: Jiuding Yang, Shengyao Lu, Hongxuan Liu, Shayan Shirahmad Gale Bagi, Zahra Fazel, Tomasz Czajkowski, Di Niu

📝 초록 (Abstract)

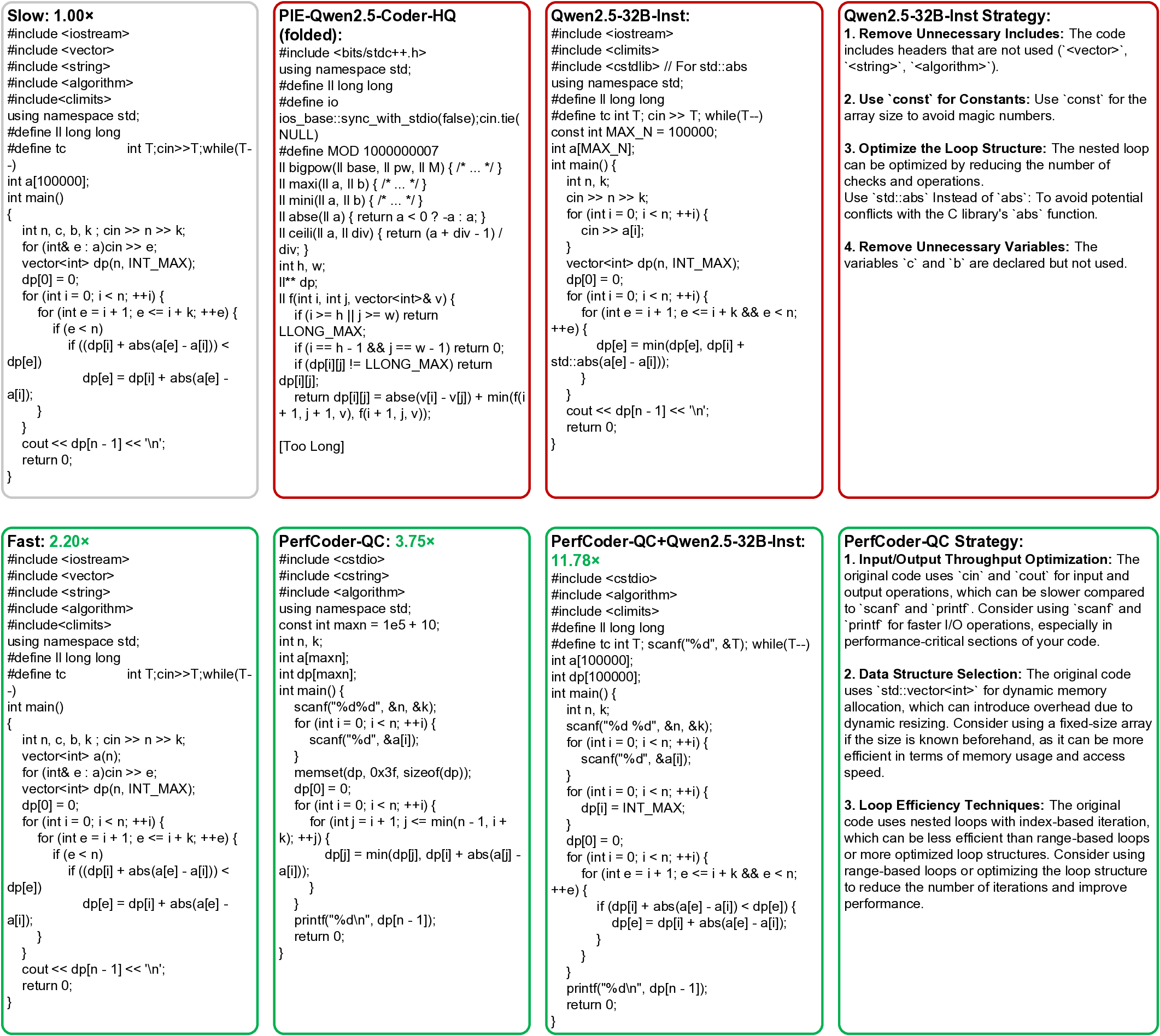

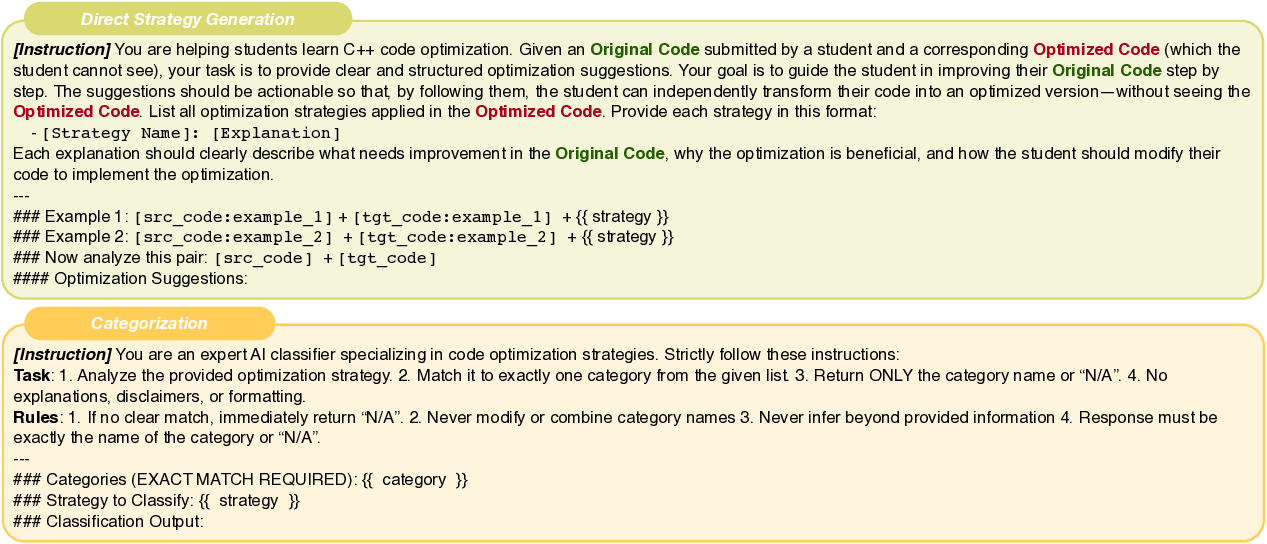

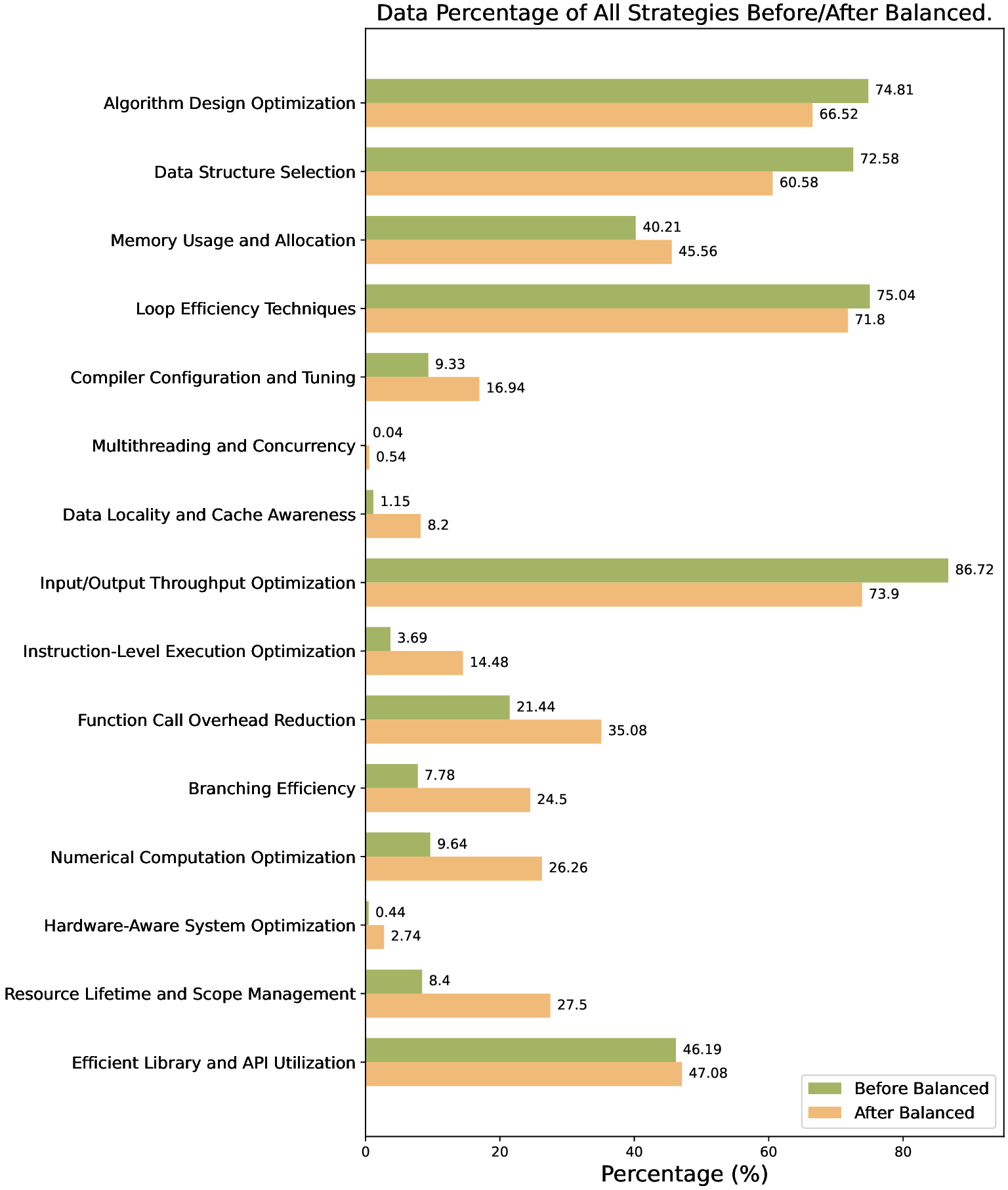

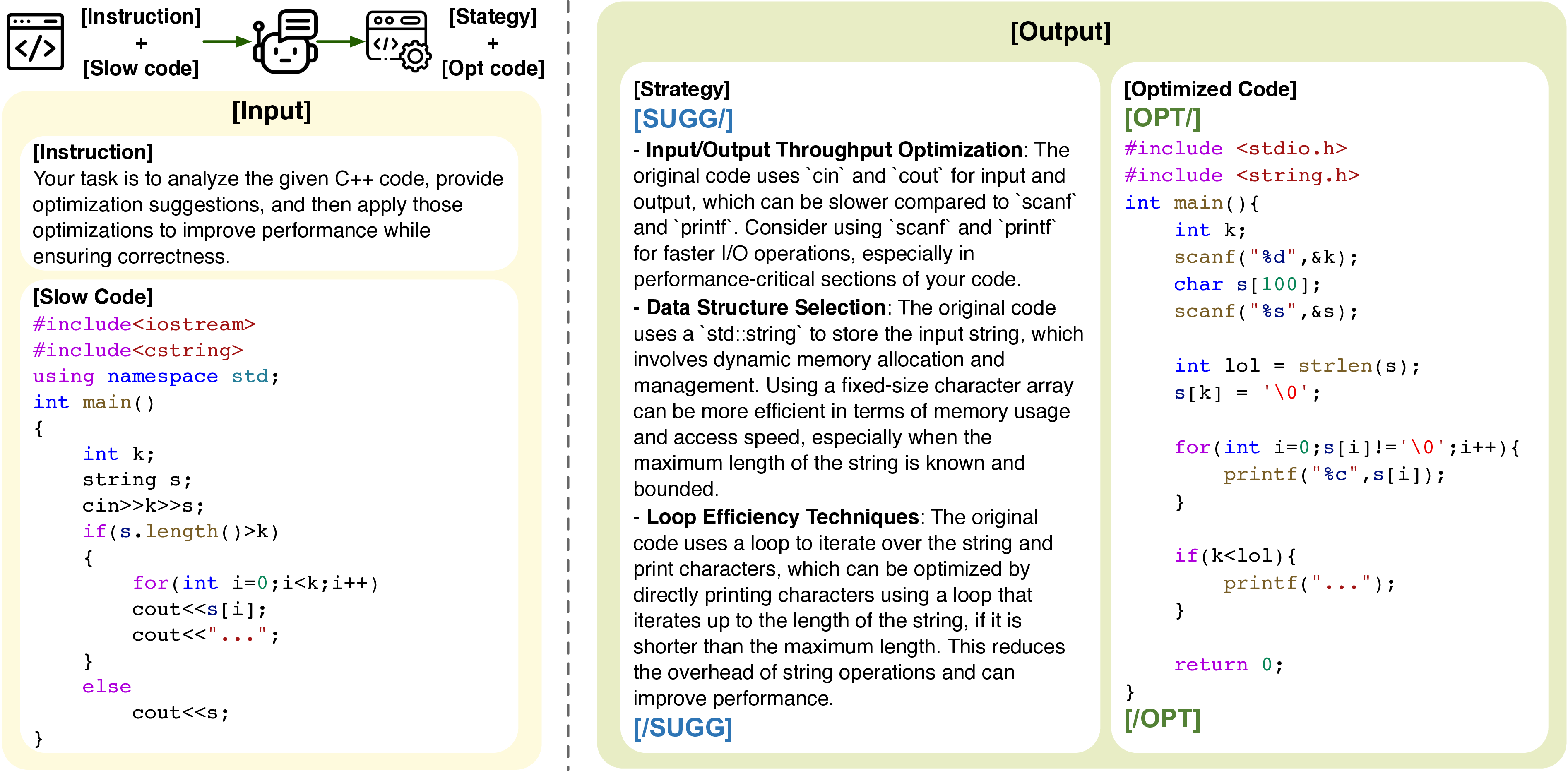

대규모 언어 모델(LLM)은 자동 코드 생성 분야에서 눈부신 성과를 보여왔지만, 실제 소프트웨어 시스템에서 필수적인 고성능 코드를 생산하는 능력은 아직 제한적이다. 기존 LLM이 성능 향상에 어려움을 겪는 이유는 데이터 부족뿐 아니라, 해석 가능하고 효과적인 성능 개선을 유도하는 감독 신호가 부족하기 때문이다. 본 연구에서는 소스 코드를 입력받아 해석 가능한 맞춤형 최적화를 수행하도록 설계된 LLM 패밀리인 PerfCoder를 제안한다. PerfCoder는 인간이 읽을 수 있는 주석이 포함된 실제 최적화 궤적을 정제하여 파인튜닝하고, 런타임 측정값을 이용한 강화 학습(RL) 기반 선호 정렬을 통해 입력별 최적화 전략을 제시하고 직접 적용한다. 반복적인 정제 과정 없이도 최적화를 수행한다. PIE 코드 성능 벤치마크에서 PerfCoder는 기존 모든 모델을 능가하는 실행 시간 가속도와 효율적인 최적화 비율을 기록했으며, 성능 최적화는 단순히 모델 규모에 의존할 수 없고, 최적화 전략에 대한 인식이 필요함을 입증한다. 또한 PerfCoder는 소스 코드에 대한 해석 가능한 피드백을 생성할 수 있는데, 이를 플래너‑옵티마이저 협업 워크플로우에서 더 큰 LLM에 입력으로 제공하면 성능을 추가로 향상시킬 수 있다. 구체적으로 32B 규모 모델과 GPT‑5의 코드 최적화 성능을 크게 끌어올려 기존 성능을 크게 초과한다.💡 논문 핵심 해설 (Deep Analysis)

두 번째로 제시된 해결책은 “해석 가능한 최적화 궤적”을 활용한 감독 학습이다. 저자들은 실제 개발자들이 수행한 최적화 과정을 단계별 주석과 함께 수집하고, 이를 데이터셋으로 정제했다. 이러한 데이터는 단순히 “전/후 코드” 쌍을 넘어서, 왜 특정 변환이 적용됐는지, 어떤 하드웨어 특성이 고려됐는지 등을 명시한다. 이를 통해 모델은 “전략적 사고”를 학습하고, 새로운 입력에 대해 어떤 최적화가 유효한지 논리적으로 추론할 수 있게 된다.

세 번째 핵심은 강화 학습 기반의 선호 정렬(preference‑aligned RL)이다. 런타임 측정값을 보상 신호로 사용해 모델이 제안한 최적화가 실제 성능 향상을 가져오는지를 직접 검증한다. 이 과정에서 모델은 “성능‑우선” 정책을 내재화하게 되며, 단순히 문법적으로 올바른 변환을 넘어 실제 실행 효율을 극대화하는 방향으로 파라미터를 조정한다.

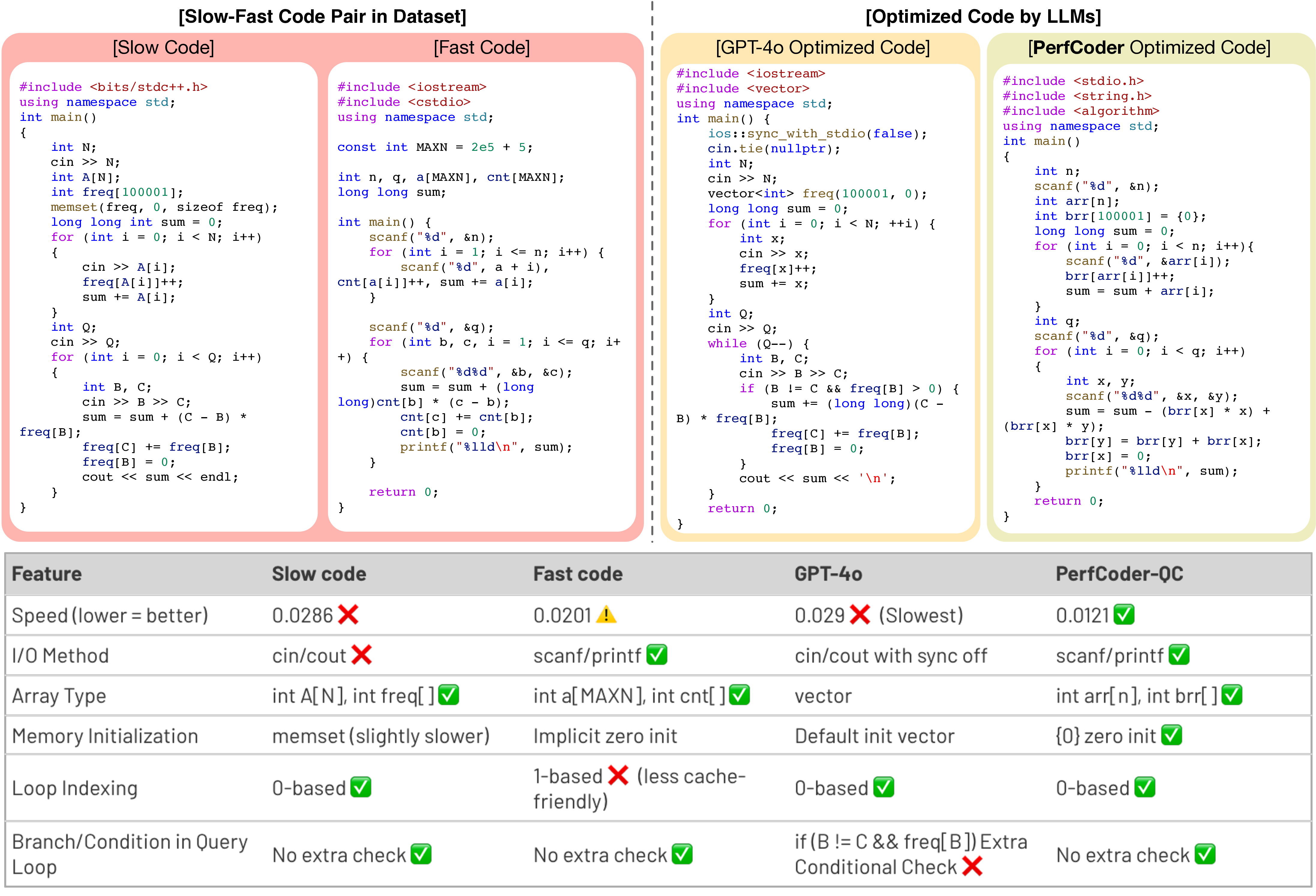

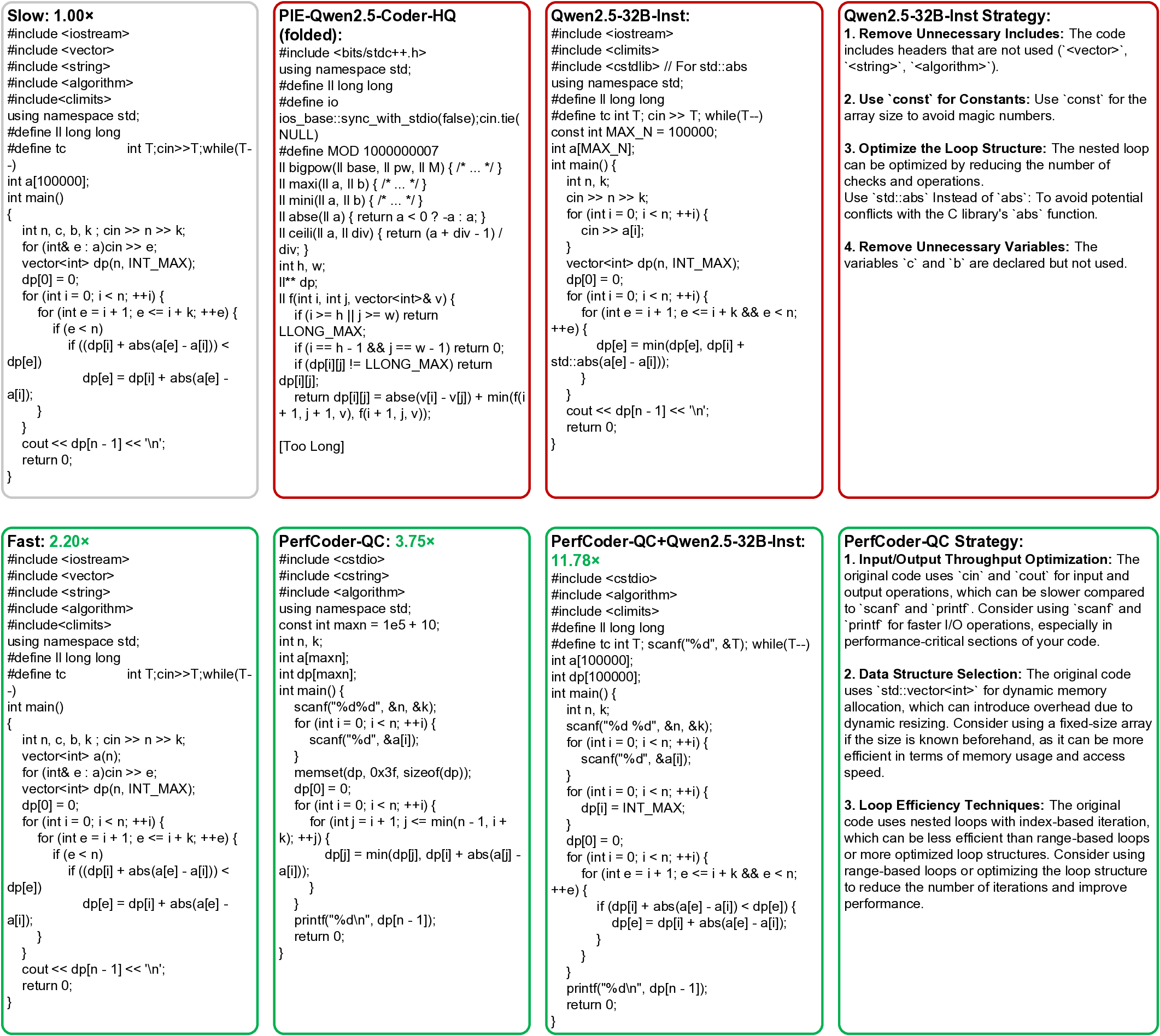

실험 결과는 PIE(Code Performance Improvement) 벤치마크에서 PerfCoder가 기존 최첨단 모델들을 모두 앞선다는 점에서 설득력을 얻는다. 특히 “효과적인 최적화 비율(effective optimization rate)”이 높다는 것은 모델이 제안한 변환 중 실제로 성능 향상을 일으킨 비율이 높다는 의미이며, 이는 실무 적용 가능성을 크게 높인다.

또한 PerfCoder가 생성하는 “해석 가능한 피드백”을 다른 대형 LLM에 전달하는 협업 워크플로우는 흥미로운 메타‑학습 전략이다. 작은 특화 모델이 전략을 제시하고, 큰 모델이 이를 기반으로 코드를 재작성하거나 추가 최적화를 수행함으로써, 모델 규모와 전문성을 상호 보완한다는 점은 향후 멀티‑모델 협업 연구에 중요한 시사점을 제공한다.

마지막으로, 32B 모델과 GPT‑5에 대한 성능 향상이 “실제 코드 최적화”라는 구체적 작업에서 크게 개선되었다는 점은, LLM이 단순히 텍스트 생성기를 넘어 시스템 수준 최적화 도구로 진화할 가능성을 보여준다. 다만, 현재 연구는 최적화 대상이 주로 CPU‑bound 혹은 메모리‑bound 작업에 국한돼 있어, GPU, FPGA, 혹은 분산 환경에 대한 확장 가능성은 추후 연구 과제로 남는다. 전반적으로 PerfCoder는 LLM 기반 코드 최적화 분야에 새로운 패러다임을 제시하며, 데이터·학습·피드백 삼위일체 접근법이 성능 향상의 핵심임을 입증한다.

📄 논문 본문 발췌 (Translation)

📸 추가 이미지 갤러리