시각질문응답 신뢰성 향상을 위한 이중 평가: 자기반성 및 교차모델 검증

읽는 시간: 2 분

...

📝 원문 정보

- Title: Improving VQA Reliability: A Dual-Assessment Approach with Self-Reflection and Cross-Model Verification

- ArXiv ID: 2512.14770

- 발행일: 2025-12-16

- 저자: Xixian Wu, Yang Ou, Pengchao Tian, Zian Yang, Jielei Zhang, Peiyi Li, Longwen Gao

📝 초록 (Abstract)

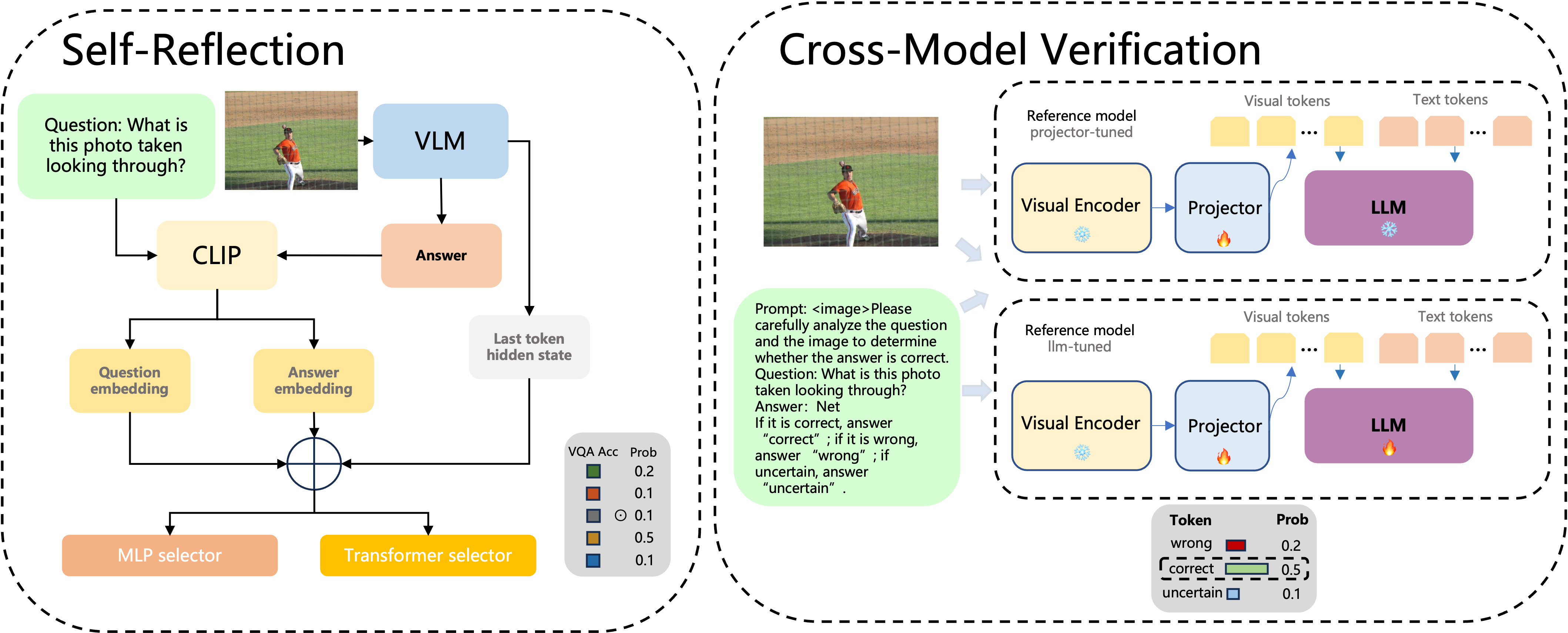

시각‑언어 모델(VLM)은 시각 질문 응답(VQA) 분야에서 큰 잠재력을 보여주고 있다. 그러나 VLM은 환각 현상에 취약해 자신감 있게 잘못된 답변을 제시함으로써 답변 신뢰성을 크게 저하시킨다. 이를 해결하고자 우리는 Dual‑Assessment for VLM Reliability(DAVR)라는 새로운 프레임워크를 제안한다. DAVR은 자기반성(Self‑Reflection)과 교차모델 검증(Cross‑Model Verification)을 결합한 포괄적인 불확실성 추정 방식을 제공한다. 프레임워크는 두 개의 경로로 구성된다. 첫 번째 경로는 VLM의 잠재 특징과 질문‑답변 임베딩을 융합하는 이중 선택자 모듈을 통해 응답 신뢰성을 평가한다. 두 번째 경로는 외부 참조 모델을 활용해 사실성을 교차 검증함으로써 환각을 완화한다. ICCV‑CLVL 2025 Reliable VQA Challenge에서 DAVR은 Φ100 점수 39.64와 100‑AUC 97.22를 기록하며 1위를 차지, VLM 응답의 신뢰성 향상에 효과적임을 입증하였다.💡 논문 핵심 해설 (Deep Analysis)