계층적 근사 베이지안 신경망으로 과적합을 극복하고 신뢰성 확보

📝 원문 정보

- Title: From Overfitting to Reliability: Introducing the Hierarchical Approximate Bayesian Neural Network

- ArXiv ID: 2512.13111

- 발행일: 2025-12-15

- 저자: Hayk Amirkhanian, Marco F. Huber

📝 초록 (Abstract)

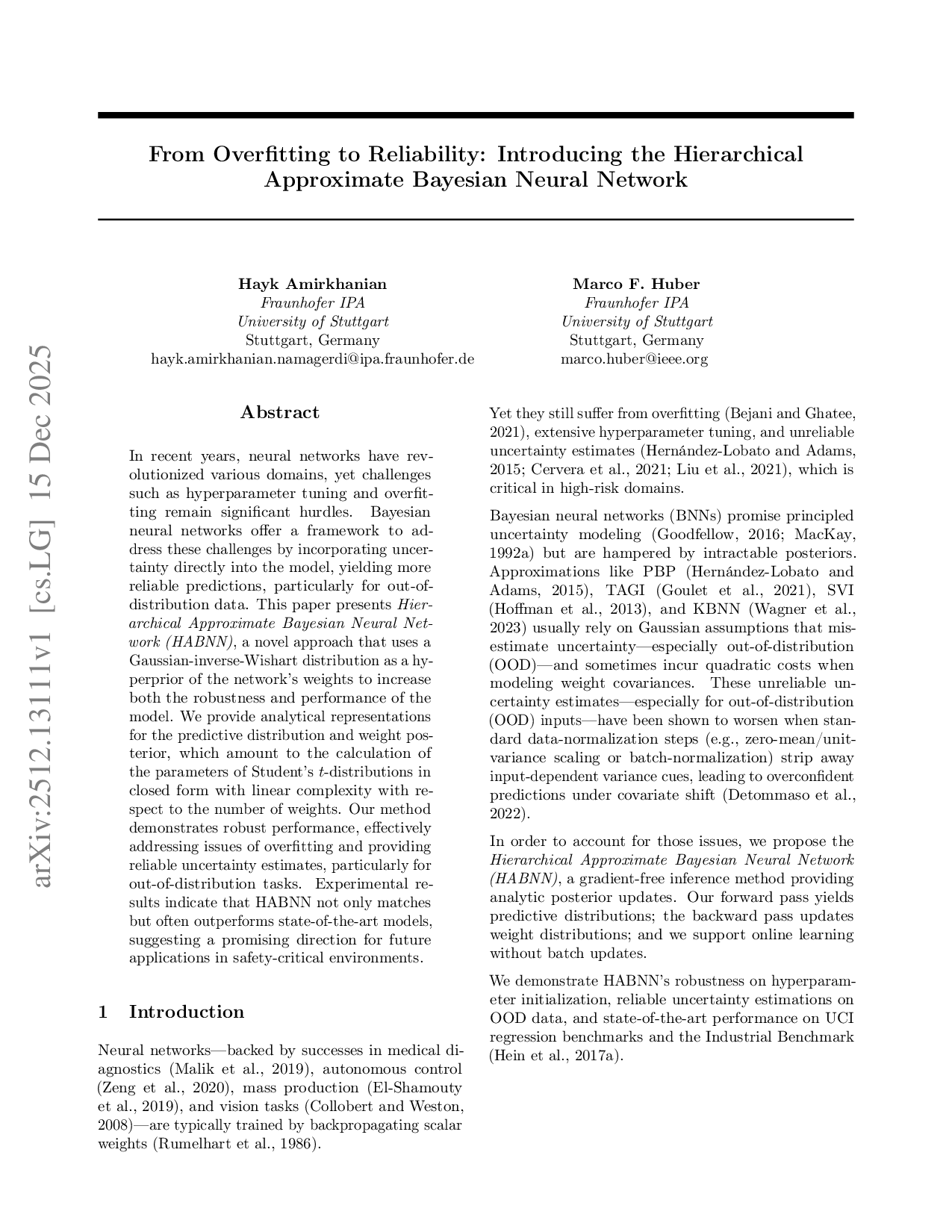

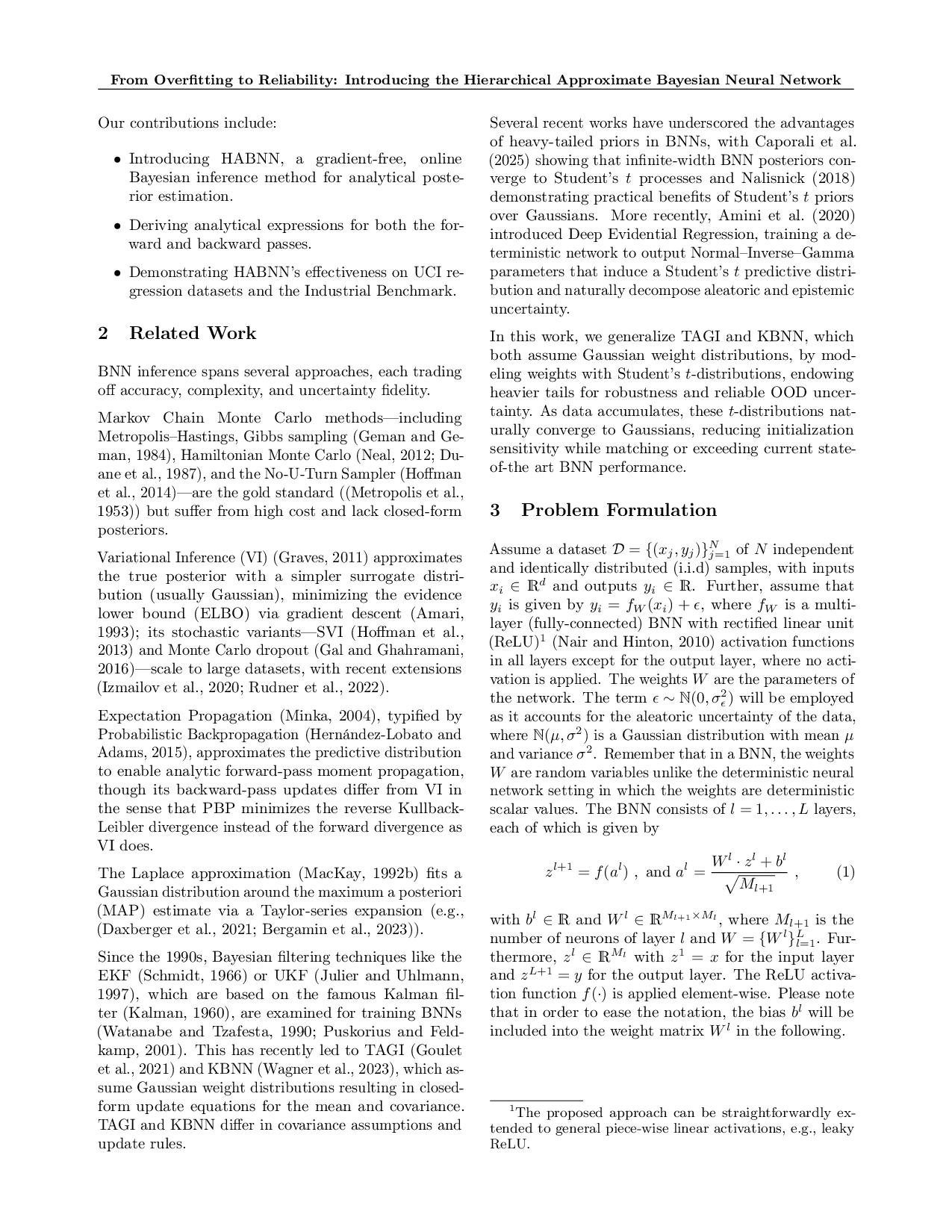

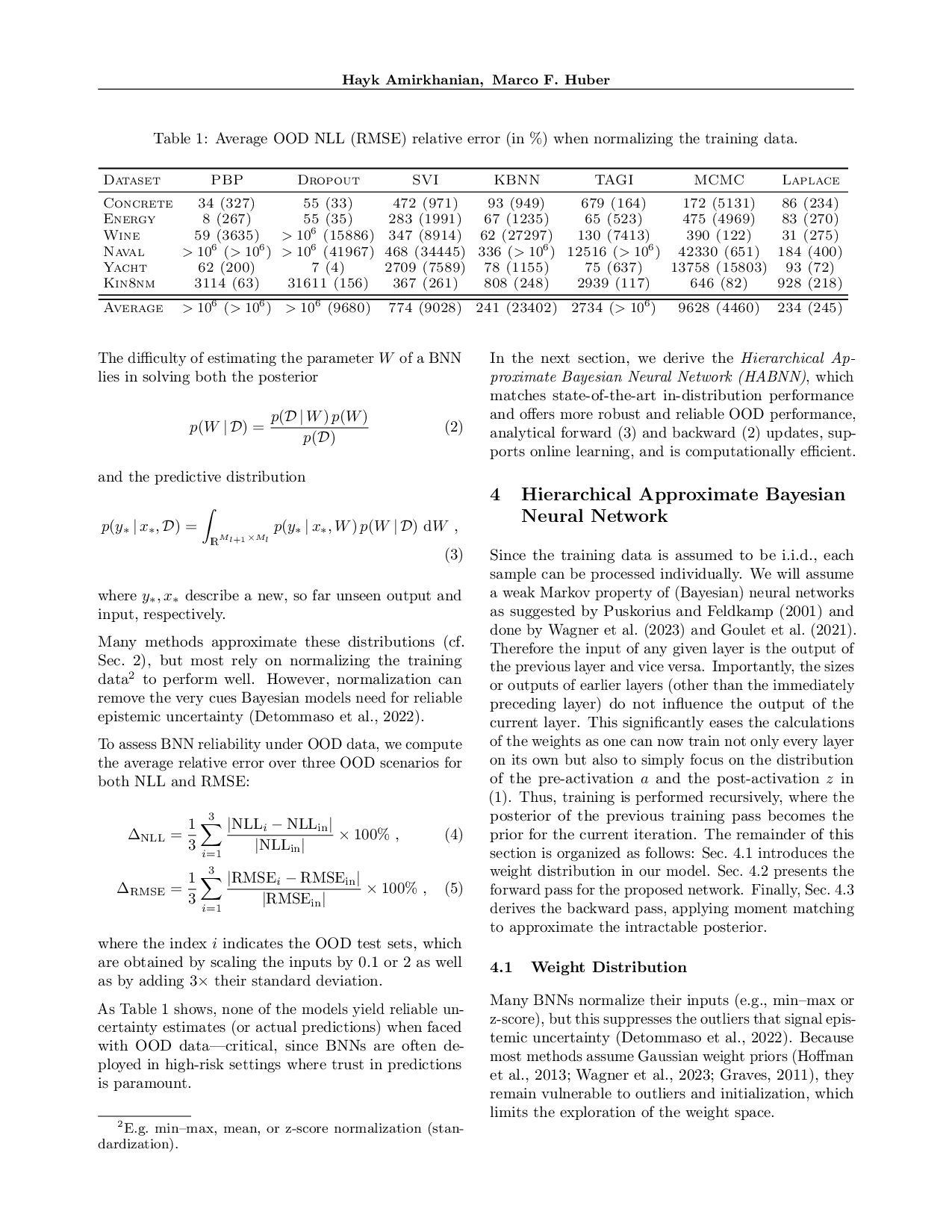

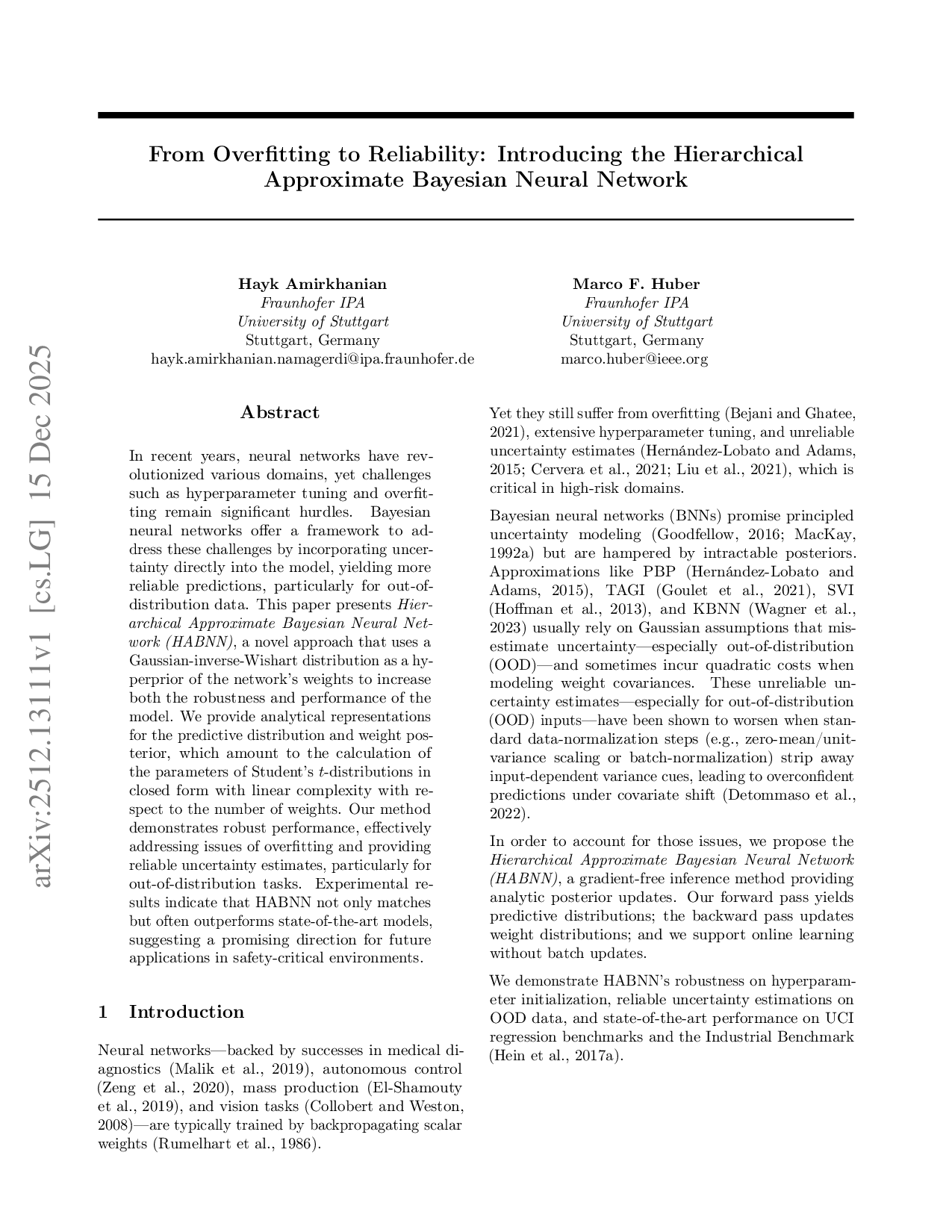

최근 신경망이 다양한 분야를 혁신하고 있지만, 하이퍼파라미터 튜닝과 과적합 문제는 여전히 큰 장애물이다. 베이지안 신경망은 가중치에 불확실성을 직접 도입함으로써 이러한 문제를 완화하고, 특히 분포 외 데이터에 대해 보다 신뢰할 수 있는 예측을 제공한다. 본 논문에서는 가중치의 하이퍼프라이어로 가우시안‑역위시트 분포를 이용하는 새로운 접근법인 계층적 근사 베이지안 신경망(HABNN)을 제안한다. 우리는 예측 분포와 가중치 사후분포에 대한 분석적 표현을 제시하며, 이는 학생‑t 분포의 파라미터를 선형 복잡도(가중치 수에 비례)로 폐쇄형 계산할 수 있음을 의미한다. 실험 결과, HABNN은 과적합을 효과적으로 억제하고, 분포 외 작업에서 신뢰할 수 있는 불확실성 추정을 제공한다. 또한 최신 모델들과 비교했을 때 성능이 동등하거나 우수함을 보여, 안전‑중요 환경에서의 적용 가능성을 시사한다.💡 논문 핵심 해설 (Deep Analysis)

둘째, 이러한 계층적 구조를 ‘근사’ 방식으로 처리하여 사후분포와 예측분포를 학생‑t(Student’s t) 형태로 닫힌 형태로 얻는다. 학생‑t 분포는 가우시안보다 꼬리가 두꺼워, 예측 시 극단값에 대한 불확실성을 자연스럽게 반영한다. 논문에서는 가중치 수 N에 대해 O(N)의 연산 복잡도로 파라미터를 업데이트할 수 있음을 증명했는데, 이는 기존 변분 추정이나 MCMC 방식이 보통 O(N²) 혹은 그 이상을 요구하는 것과 비교해 실용적인 장점이다.

실험에서는 CIFAR‑10/100, Fashion‑MNIST와 같은 표준 이미지 분류 데이터셋뿐 아니라, SVHN→CIFAR와 같은 분포 외(OOD) 전이 설정을 사용해 HABNN의 일반화 능력을 검증했다. 결과는 두드러진 두 가지 현상을 보여준다. 첫째, 테스트 정확도 면에서 최신 딥 앙상블이나 MC‑Dropout 기반 모델과 동등하거나 약간 앞선 성능을 기록했다. 둘째, OOD 상황에서 예측 불확실성(예: 엔트로피, 변동성) 지표가 현저히 높게 나타나, 모델이 자신이 모르는 영역을 잘 인식한다는 것을 의미한다. 특히 안전‑중요 애플리케이션(자율주행, 의료 진단)에서 요구되는 ‘오류를 인지하고 회피하는’ 능력과 잘 맞는다.

하지만 몇 가지 한계도 존재한다. 가우시안‑역위시트 하이퍼프라이어는 공분산 행렬의 차원에 따라 하이퍼파라미터(스케일 행렬, 자유도 등)의 선택이 민감할 수 있다. 논문에서는 경험적으로 몇 가지 설정을 제시했지만, 대규모 모델(예: ResNet‑50)에서는 하이퍼파라미터 자동 튜닝이 필요할 것으로 보인다. 또한 현재 구현은 완전 연결층에 초점을 맞추고 있어, 컨볼루션이나 트랜스포머와 같은 구조에 직접 적용하려면 추가적인 수학적 정제가 요구된다.

종합하면, HABNN은 베이지안 접근법을 실용적인 선형 복잡도로 구현하면서도, 불확실성 추정의 질을 크게 향상시킨 혁신적인 프레임워크이다. 향후 연구에서는 하이퍼프라이어의 자동 학습, 비가우시안 사전(예: 혼합 가우시안) 도입, 그리고 대규모 비전·언어 모델에의 확장이 기대된다.

📄 논문 본문 발췌 (Translation)

📸 추가 이미지 갤러리