역방향 사고가 대형 언어 모델의 누락 정보 탐지를 향상시킨다

📝 원문 정보

- Title: Reverse Thinking Enhances Missing Information Detection in Large Language Models

- ArXiv ID: 2512.10273

- 발행일: 2025-12-11

- 저자: Yuxin Liu, Chaojie Gu, Yihang Zhang, Bin Qian, Shibo He

📝 초록 (Abstract)

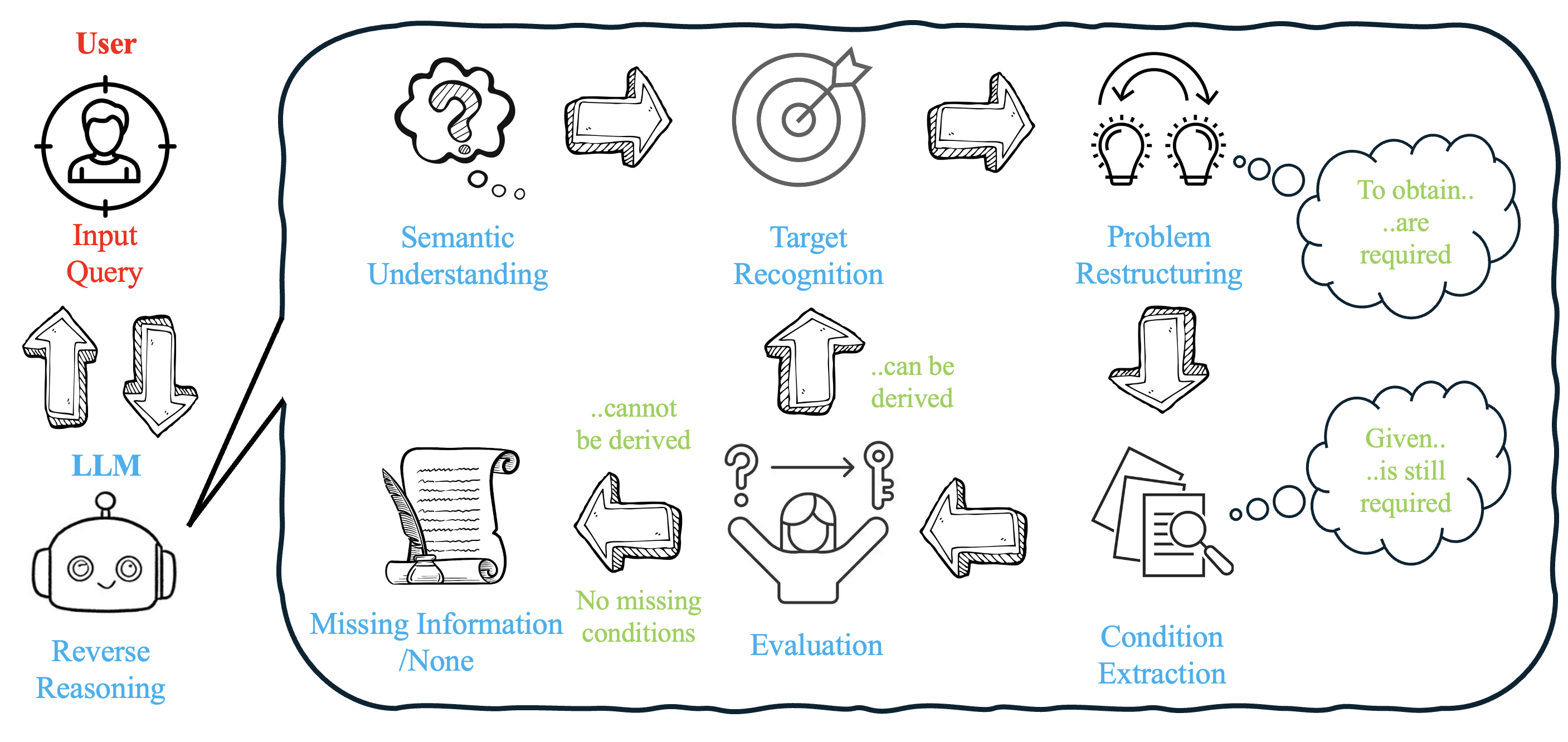

대형 언어 모델(LLM)은 다양한 추론 과제에서 뛰어난 성능을 보이지만, 누락된 정보를 포함한 문제에서는 답변이 불완전하거나 사실 오류, 환각 현상이 발생하는 경우가 많다. 기존의 순방향 추론 기법인 Chain‑of‑Thought(Cot)와 Tree‑of‑Thought(ToT)는 구조화된 문제 해결에 효과적이지만, 누락된 정보를 체계적으로 식별하고 복구하는 데는 한계가 있다. 본 연구는 역방향 사고(reverse thinking)를 활용해 LLM이 누락된 정보를 탐지하도록 유도하는 새로운 프레임워크를 제안한다. 최근의 역추론 연구를 토대로, 모델이 목표 결과에서 출발해 필요한 전제 조건을 역으로 추론하도록 설계함으로써 누락된 요소를 효과적으로 찾아낸다. 실험 결과, 제안된 역방향 사고 방식이 전통적인 순방향 추론 방법에 비해 정확도에서 큰 폭의 향상을 보였으며, LLM의 논리적 완전성과 추론 견고성을 강화하는 유망한 방향임을 확인하였다.💡 논문 핵심 해설 (Deep Analysis)

논문이 제시하는 핵심 아이디어는 ‘역방향 사고’를 통해 문제를 뒤집어 보는 것이다. 구체적으로, 모델에게 최종 목표(예: 정답 혹은 결론)를 먼저 제시하고, 그 목표를 달성하기 위해 반드시 만족해야 하는 전제 조건을 역으로 도출하도록 유도한다. 이 과정은 두 단계로 구성된다. 첫 번째 단계에서는 “이 결과가 옳다면 어떤 전제가 필요할까?”라는 질문을 LLM에 던져, 가능한 전제들의 집합을 생성한다. 두 번째 단계에서는 생성된 전제들을 원 질문과 비교해 누락된 요소를 식별한다. 이렇게 하면 누락된 정보가 …