워크플로우가 전부다 고엔트로피 정보 탐색과 적대적 페이싱으로 통계적 스무딩 함정 탈피

📝 원문 정보

- Title: Workflow is All You Need: Escaping the ‘Statistical Smoothing Trap’ via High-Entropy Information Foraging and Adversarial Pacing

- ArXiv ID: 2512.10121

- 발행일: 2025-12-10

- 저자: Zhongjie Jiang

📝 초록 (Abstract)

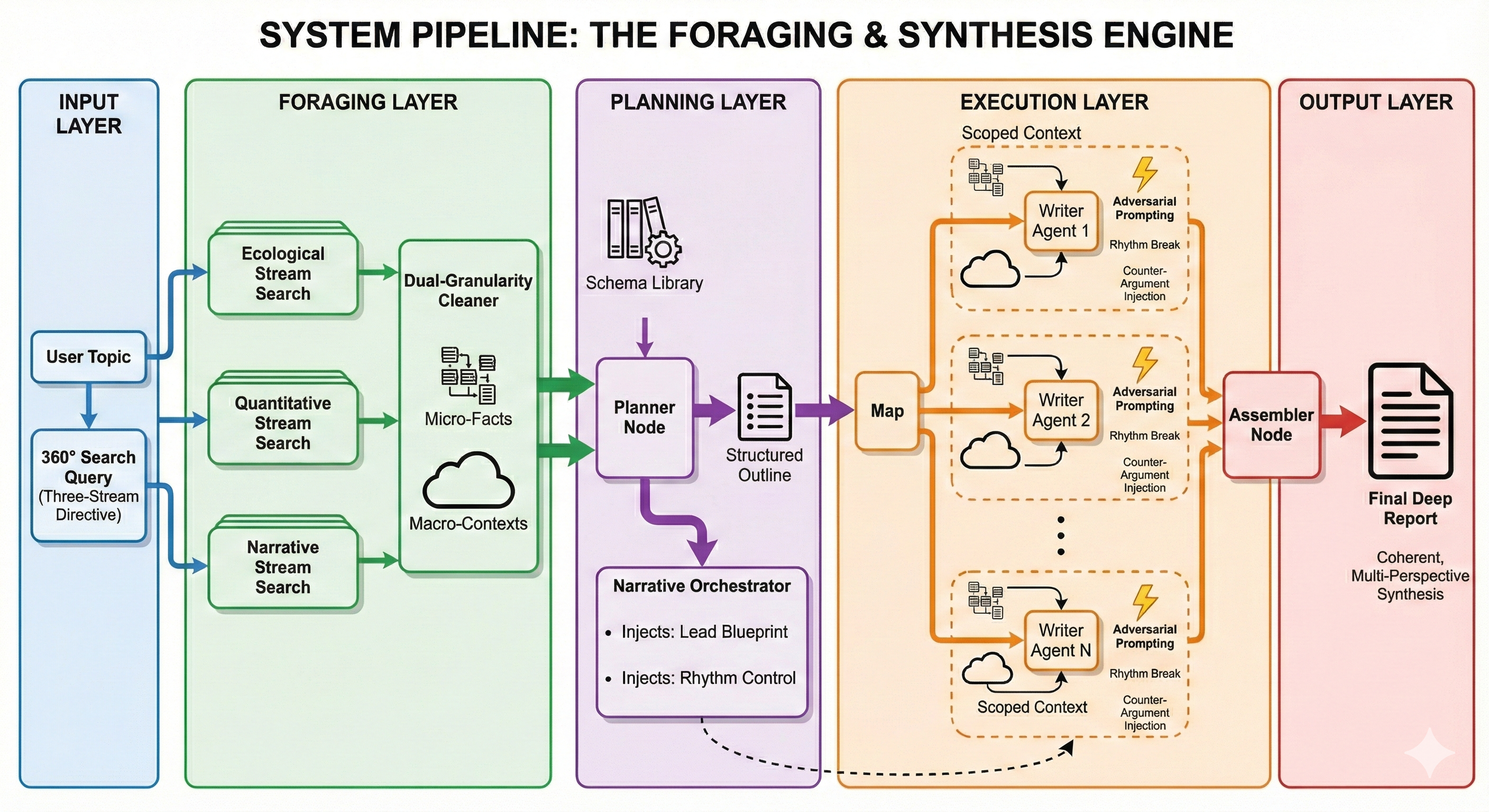

본 논문은 “통계적 스무딩 함정”이라 불리는, 대량의 고엔트로피 텍스트 데이터를 단순히 통계적 평균화 기법에 의존해 처리함으로써 발생하는 정보 손실 문제를 지적한다. 저자들은 이를 극복하기 위해 10대 1 비율의 “에이전트 기반 워크플로우”를 제안한다. 이 워크플로우는 초기 30 000 토큰 규모의 고엔트로피 잡음을 단계별로 고밀도 정보로 전환하며, 고엔트로피 정보 포식(high‑entropy information foraging)과 적대적 페이싱(adversarial pacing) 메커니즘을 결합한다. 실험 결과, 제안된 프로세스는 기존 통계적 스무딩 대비 인사이트의 정확도와 깊이를 현저히 향상시켰으며, 특히 뉴스 요약과 같은 고속 정보 흐름 환경에서 뛰어난 성능을 보였다.💡 논문 핵심 해설 (Deep Analysis)

저자들은 이를 해결하기 위해 두 가지 혁신적인 전략을 도입한다. 첫 번째는 **고엔트로피 정보 포식(high‑entropy information foraging)**이다. 이는 단순히 빈도 기반 샘플링을 넘어, 엔트로피가 높은 구간을 의도적으로 탐색하고, 해당 구간에서 추출된 토큰을 우선적으로 처리한다는 개념이다. 구체적으로는 엔트로피 측정값을 실시간으로 계산하고, 그 값이 임계치를 초과하는 구간을 “핵심 정보 영역”으로 지정한다. 이 영역은 이후 단계에서 인간‑에이전트 혹은 강화학습 기반 에이전트가 집중적으로 분석한다.

두 번째는 **적대적 페이싱(adversarial pacing)**이다. 여기서는 정보 흐름을 일정하게 유지하기 위해, 에이전트가 스스로 난이도와 속도를 조절한다. 즉, 초기에는 낮은 난이도의 텍스트를 빠르게 처리해 전반적인 구조를 파악하고, 점차 난이도가 높은 고엔트로피 구간을 삽입함으로써 에이전트가 “정보의 함정”에 빠지지 않도록 한다. 이 과정은 마치 적대적 학습(adversarial training)…