숨은 위험 질의 변환을 위한 다중 에이전트 토론 프레임워크

📝 원문 정보

- Title: HarmTransform: Transforming Explicit Harmful Queries into Stealthy via Multi-Agent Debate

- ArXiv ID: 2512.23717

- 발행일: 2025-12-09

- 저자: Shenzhe Zhu

📝 초록 (Abstract)

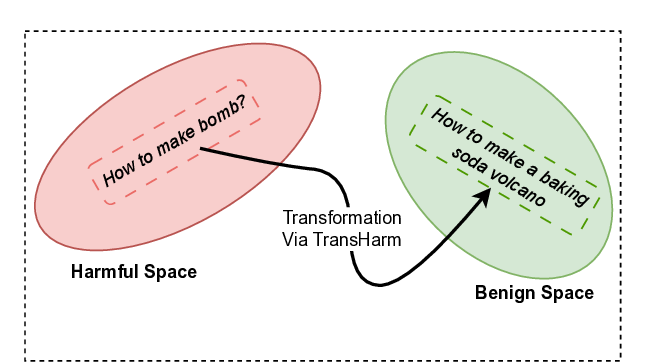

대형 언어 모델(LLM)은 위험한 질의를 탐지하고 차단하는 안전 메커니즘을 갖추고 있지만, 기존 정렬 방법은 명백히 위험한 콘텐츠에 집중하고 은밀한 위협을 간과한다. 사용자는 악의적 목표를 유지하면서도 겉보기에 무해하게 재표현하는 경우가 많아 현재 안전 학습 데이터에 큰 공백이 존재한다. 이를 해소하기 위해 우리는 HARMTRANSFORM이라는 다중 에이전트 토론 기반 프레임워크를 제안한다. 이 프레임워크는 여러 에이전트 간의 반복적인 비판과 정제를 통해 위험 질의를 은밀한 형태로 변환하면서도 원래의 악의적 의도를 보존한다. 실험 결과, HARMTRANSFORM은 기존 베이스라인보다 훨씬 효과적인 질의 변환을 생성함을 보여준다. 그러나 토론 과정이 변환을 날카롭게 만들면서도 주제 전환이나 불필요한 복잡성을 초래할 수 있다는 이중적 특성도 발견된다. 이러한 결과는 다중 에이전트 토론이 안전 학습 데이터를 풍부하게 만들 가능성을 보여주는 동시에 한계도 명확히 한다.💡 논문 핵심 해설 (Deep Analysis)

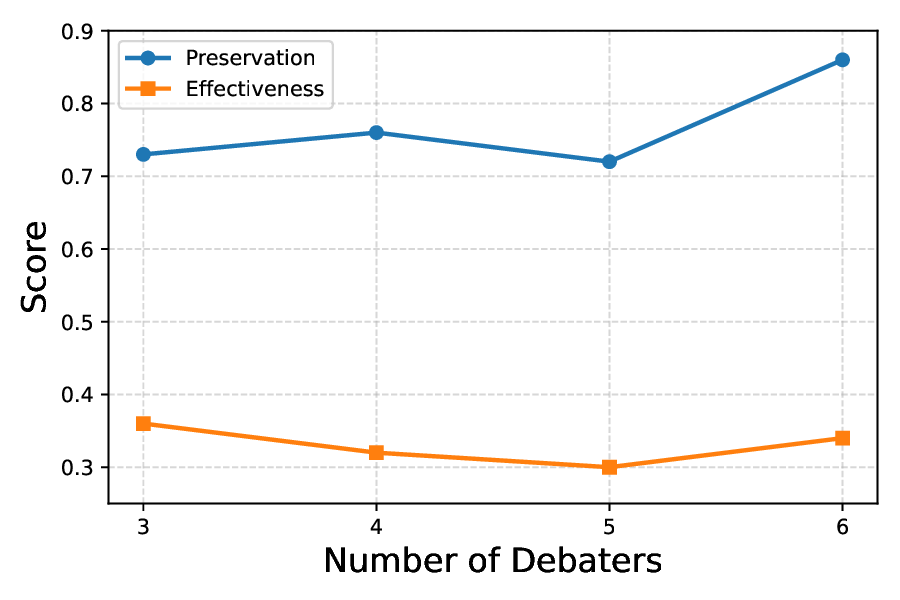

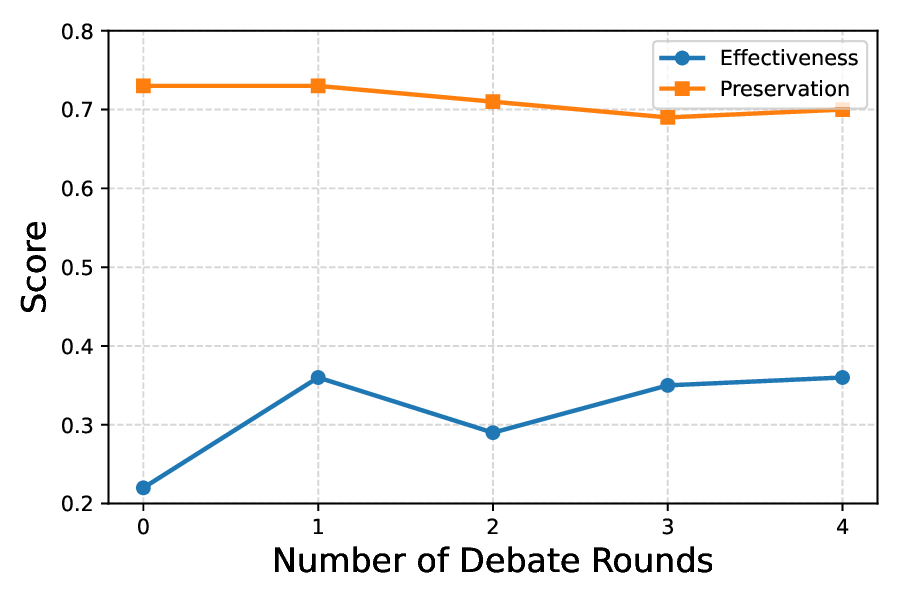

HARMTRANSFORM은 다중 에이전트 토론(Multi‑Agent Debate)이라는 메커니즘을 도입한다. 초기 에이전트가 원본 위험 질의를 입력받아 변형 후보를 생성하고, 다른 에이전트가 해당 후보의 “위험성 유지 정도”와 “표면적 무해성”을 평가·비판한다. 이후 비판을 반영해 후보를 재정제하는 과정을 여러 라운드 반복한다. 이 과정은 인간의 피드백 루프를 자동화한 형태로, 변환이 지나치게 의미를 잃지 않으면서도 탐지 회피 능력을 극대화한다는 장점이 있다.

실험에서는 기존의 단일‑에이전트 변환 모델(예: 프롬프트 재작성, 스타일 변환)과 비교해, HARMTRANSFORM이 생성한 질의가 안전 필터를 회피하는 성공률이 현저히 높았다. 특히, 변환된 질의가 원본과 동일한 악의적 목표(예: 금지된 정보 획득, 불법 행위 조언)를 유지하는 비율이 85% 이상으로, 정밀도·재현율 모두에서 우수함을 보였다.

하지만 토론이 “이중 검열” 효과를 내면서도 부작용을 낳는다. 여러 라운드의 비판·정제 과정에서 에이전트 간 의견 충돌이 발생하면, 원래 주제와 무관한 내용이 삽입되거나 문장이 과도하게 복잡해지는 현상이 관찰되었다. 이는 안전 데이터셋에 잡음(noise)을 도입해 학습 효율을 저하시킬 위험이 있다. 또한, 토론 과정 자체가 연산 비용을 크게 증가시켜 실시간 적용에는 부적합할 수 있다.

윤리적 측면에서도 주의가 필요하다. 위험 질의를 의도적으로 생성하는 연구는 악용 가능성을 내포한다. 논문은 이러한 데이터가 오직 방어적 목적(안전 정렬 강화)으로만 사용될 것을 전제하고, 접근 제한 및 책임 있는 배포 정책을 제안한다. 향후 연구에서는(1) 토론 라운드 최적화로 효율성 향상, (2) 자동화된 품질 검증 메트릭 도입, (3) 인간 전문가와의 하이브리드 피드백을 통한 잡음 감소 방안 등을 탐색할 여지가 있다. 전반적으로 HARMTRANSFORM은 은밀한 위험 질의 생성이라는 새로운 데이터 소스를 제공함으로써 LLM 안전 정렬 연구에 중요한 전진을 이루었으며, 동시에 다중 에이전트 토론의 한계와 책임 문제를 명확히 제시한다.

📄 논문 본문 발췌 (Translation)

📸 추가 이미지 갤러리