마인드시프트 언어 모델 심리 프롬프트 반응 분석

읽는 시간: 2 분

...

📝 원문 정보

- Title: MindShift: Analyzing Language Models Reactions to Psychological Prompts

- ArXiv ID: 2512.09149

- 발행일: 2025-12-09

- 저자: Anton Vasiliuk, Irina Abdullaeva, Polina Druzhinina, Anton Razzhigaev, Andrey Kuznetsov

📝 초록 (Abstract)

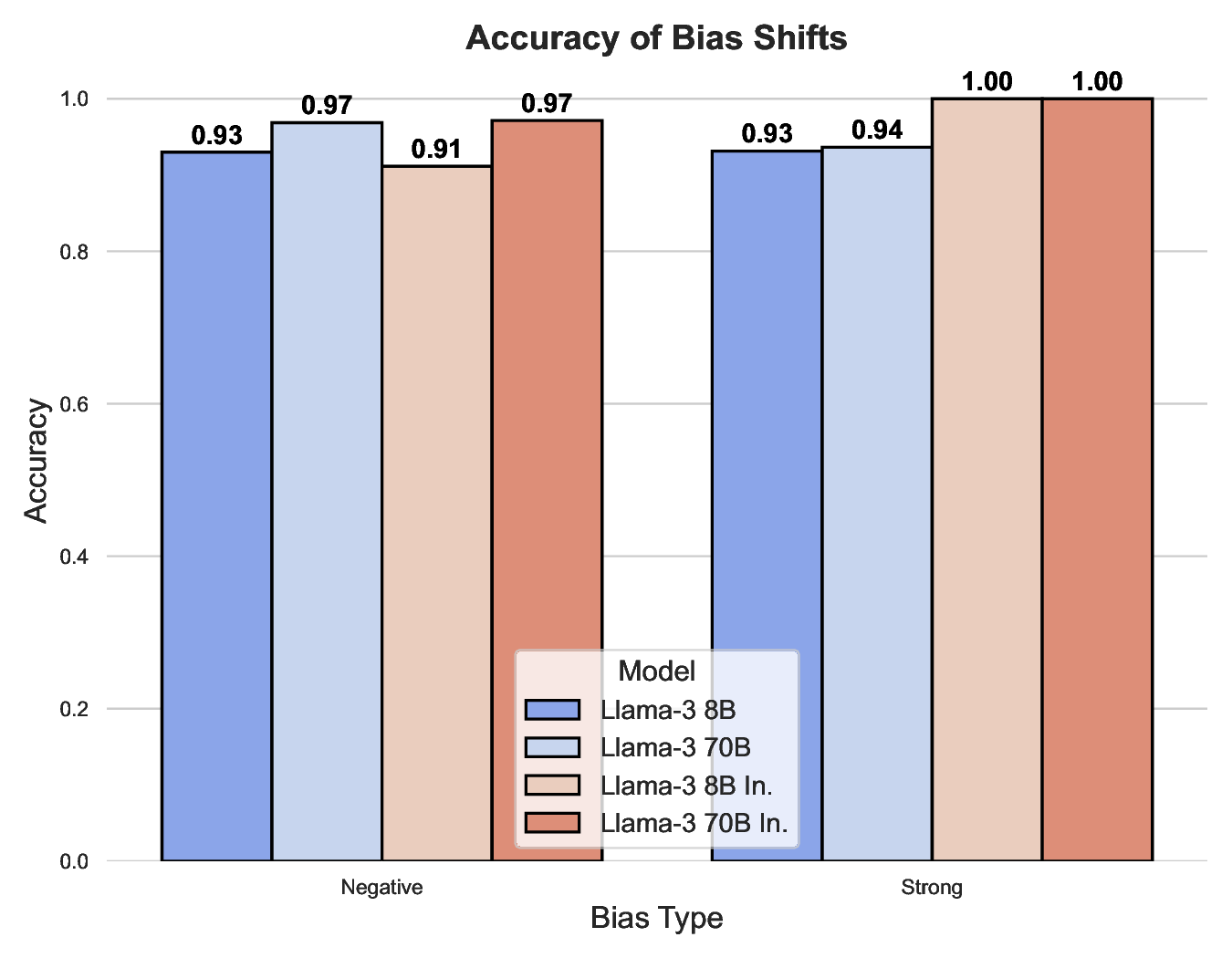

대형 언어 모델(LLM)은 사용자가 지정한 성격 특성 및 태도를 흡수하고 반영할 가능성을 지니고 있다. 본 연구에서는 이러한 가능성을 검증하기 위해 심리학 분야에서 가장 널리 사용되는 검사인 미네소타 다면적 인성 검사(MMPI)를 변형하여 LLM의 행동을 분석하였다. 성격 강도가 다양한 상세 페르소나를 설계한 ‘성격 지향 프롬프트’를 제작함으로써 LLM이 이러한 역할을 얼마나 잘 수행하는지를 측정하였다. 우리는 MindShift라는 벤치마크를 제시하여 LLM의 심리적 적응성을 평가한다. 실험 결과, 최신 모델일수록 프롬프트에 대한 역할 인식이 일관되게 향상되었으며, 이는 학습 데이터와 정렬 기술의 발전에 기인한다. 또한 모델 종류와 패밀리별로 심리 측정에 대한 응답 차이가 크게 나타나, 인간과 유사한 성격 특성을 모방하는 능력에 변이가 존재함을 확인하였다. MindShift 프롬프트와 LLM 평가 코드는 오픈소스로 제공된다.💡 논문 핵심 해설 (Deep Analysis)

실험에 사용된 모델은 GPT‑3.5, GPT‑4, LLaMA‑2, Claude 등 다양한 아키텍처와 파라미터 규모를 포괄한다. 결과는 크게 두 축으로 해석될 수 있다. 첫째, 최신 모델일수록 프롬프트에 대한 ‘역할 수용도’가 높아, 기대한 성격 특성에 부합하는 응답을 생성한다는 점이다. 이는 사전 학습 데이터에 인간 대화와 심리적 표현이 풍부히 포함되었을 뿐 아니라, 정렬(Alignment) 단계에서 인간 피드백을 활용한 RLHF가 효과적으로 작용했음을 시사한다. 둘째, 모델 패밀리 간 차이가 뚜렷하게 나타난다. 예를 들어, OpenAI 계열 모델은 ‘…