컨포멀 인컨텍스트 학습으로 효율적인 텍스트 분류 구현

📝 원문 정보

- Title: Efficient Text Classification with Conformal In-Context Learning

- ArXiv ID: 2512.05732

- 발행일: 2025-12-05

- 저자: Ippokratis Pantelidis, Korbinian Randl, Aron Henriksson

📝 초록 (Abstract)

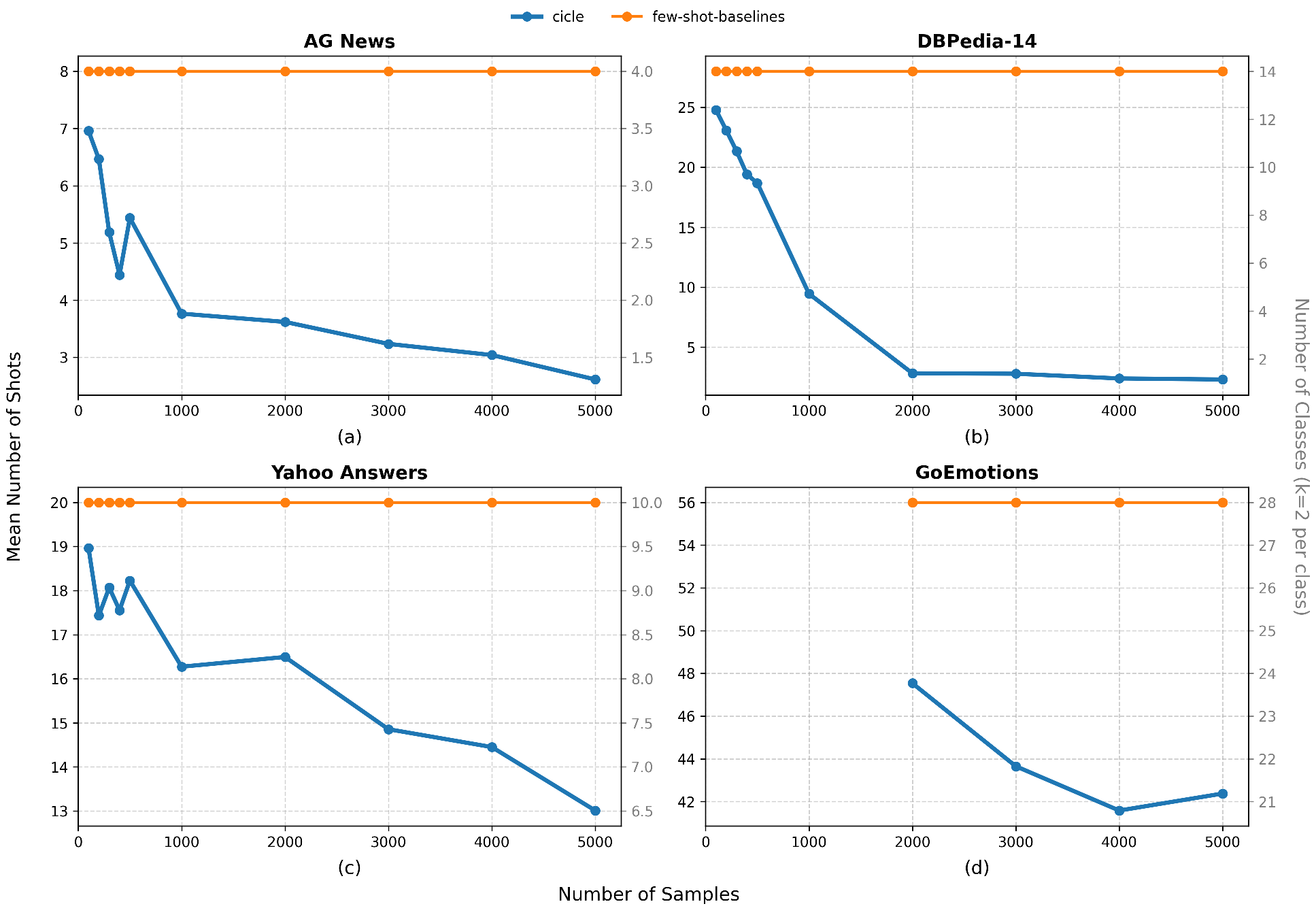

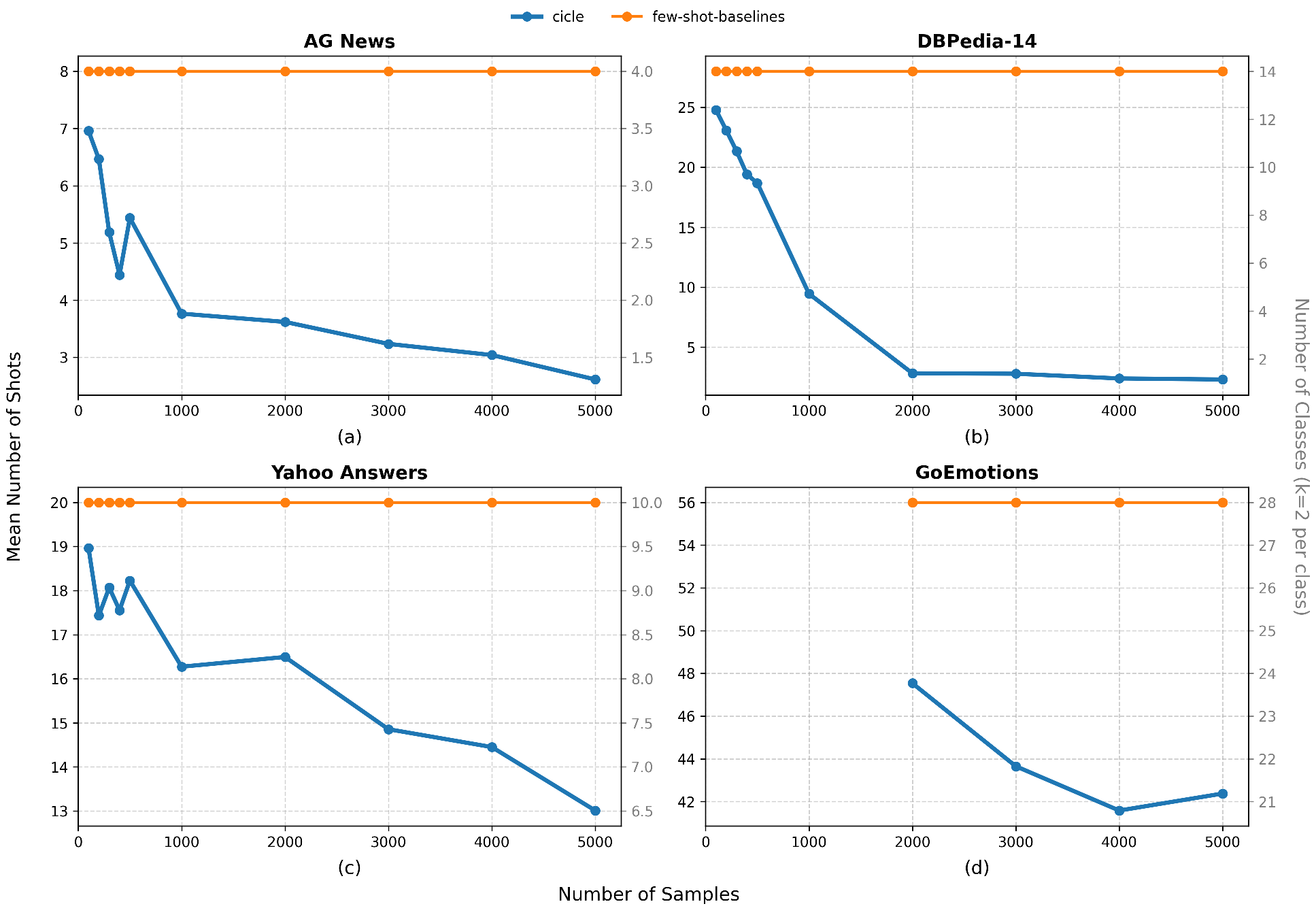

대형 언어 모델(LLM)은 인컨텍스트 학습 능력이 뛰어나지만, 텍스트 분류 성능은 프롬프트 설계에 크게 좌우되고 계산 비용도 많이 소모된다. 이를 해결하기 위해 경량 베이스 분류기와 컨포멀 예측을 결합해 LLM 프롬프트를 적응적으로 조정하고 후보 클래스 집합을 축소하는 자원 효율적 프레임워크인 Conformal In‑Context Learning(CICLe)이 제안되었다. 그러나 CICLe가 단일 도메인을 넘어선 적용 가능성과 효율성 이점은 체계적으로 검증되지 않았다. 본 연구에서는 다양한 NLP 분류 벤치마크에 걸쳐 CICLe를 종합적으로 평가한다. 실험 결과, 충분한 샘플이 있어 베이스 분류기를 학습시킬 수 있는 경우 CICLe가 베이스 분류기보다 일관적으로 성능을 향상시키고, few‑shot 프롬프트 기반 베이스라인을 능가한다. 데이터가 부족한 저데이터 환경에서는 비교 수준의 성능을 유지한다. 효율성 측면에서는 샷 수와 프롬프트 길이를 각각 최대 34.45%와 25.16% 감소시키며, 더 작은 모델을 사용해도 경쟁력 있는 성능을 달성한다. 특히 클래스 불균형이 심한 텍스트 분류 작업에서 CICLe의 장점이 두드러진다. 이러한 결과는 전통적인 분류기의 견고함과 LLM의 적응성을 결합한 CICLe가 데이터와 계산 효율성 측면에서 실용적이고 확장 가능한 텍스트 분류 접근법임을 강조한다.💡 논문 핵심 해설 (Deep Analysis)

실험 설계는 다양한 도메인(뉴스 기사, 감성 분석, 법률 문서 등)과 여러 규모의 데이터셋을 포함한다. 각 데이터셋에 대해 베이스 분류기만 사용한 경우, 전통적인 few‑shot 프롬프트(예: 5‑shot, 10‑shot)만 사용한 경우, 그리고 CICLe를 적용한 경우의 성능을 비교하였다. 주요 평가지표는 정확도, F1 점수, 그리고 효율성 지표(샷 수 감소율, 프롬프트 토큰 수 감소율)이다.

결과는 다음과 같이 요약된다. (1) 충분한 학습 샘플이 존재할 때, 베이스 분류기가 어느 정도 수준의 성능을 보이지만, CICLe를 적용하면 평균 2~4%p의 정확도 향상이 관찰된다. 이는 LLM이 베이스 분류기의 “가능성 있는” 후보에 집중함으로써 오류 전파를 최소화한 결과로 해석된다. (2) 저데이터 상황(예: 100개 이하 샘플)에서는 베이스 분류기의 학습이 제한적이지만, 컨포멀 예측을 통해 후보 집합을 보수적으로 확장함으로써 LLM이 충분히 정보를 활용할 수 있어, 기존 few‑shot 대비 비슷하거나 약간 높은 성능을 유지한다. (3) 효율성 측면에서, 평균 34.45%의 샷 수 감소와 25.16%의 프롬프트 길이 감소가 보고되었으며, 이는 GPU 메모리 사용량과 추론 시간에 직접적인 절감 효과를 가져온다. 특히, 큰 LLM(예: GPT‑3.5) 대신 중간 규모 모델(예: LLaMA‑7B)을 사용해도 CICLe는 경쟁력 있는 결과를 제공한다. (4) 클래스 불균형이 심한 데이터셋(예: 의료 진단 라벨)에서는 컨포멀 예측이 높은 신뢰 구간을 가진 소수 클래스에 대해 과도하게 후보를 배제하지 않도록 설계돼, 전체적인 macro‑F1 점수가 크게 개선된다.

한계점도 존재한다. 컨포멀 예측을 위한 오류 허용 수준 α를 어떻게 설정하느냐에 따라 후보 집합의 크기가 크게 변동하며, 최적 α값을 찾기 위한 별도 검증 과정이 필요하다. 또한, 베이스 분류기의 품질이 매우 낮은 경우(예: 무작위 추정)에는 후보 집합이 지나치게 넓어져 LLM의 효율성 이점이 사라진다. 향후 연구에서는 자동 α 튜닝, 베이스 분류기와 LLM 간의 공동 학습, 그리고 멀티라벨 혹은 계층형 라벨링 문제에 대한 확장을 모색할 수 있다.

종합하면, CICLe는 전통적인 경량 분류기의 견고함과 LLM의 유연성을 결합해, 데이터와 계산 자원이 제한된 실제 서비스 환경에서 실용적인 텍스트 분류 솔루션을 제공한다는 점에서 큰 의미를 가진다.

📄 논문 본문 발췌 (Translation)

📸 추가 이미지 갤러리