감정 이해를 위한 모달리티 중요도 기반 추론: 신뢰성 향상 방안

📝 원문 정보

- Title: Learning What to Attend First: Modality-Importance-Guided Reasoning for Reliable Multimodal Emotion Understanding

- ArXiv ID: 2512.02699

- 발행일: 2025-12-02

- 저자: Hyeongseop Rha, Jeong Hun Yeo, Junil Won, Se Jin Park, Yong Man Ro

📝 초록 (Abstract)

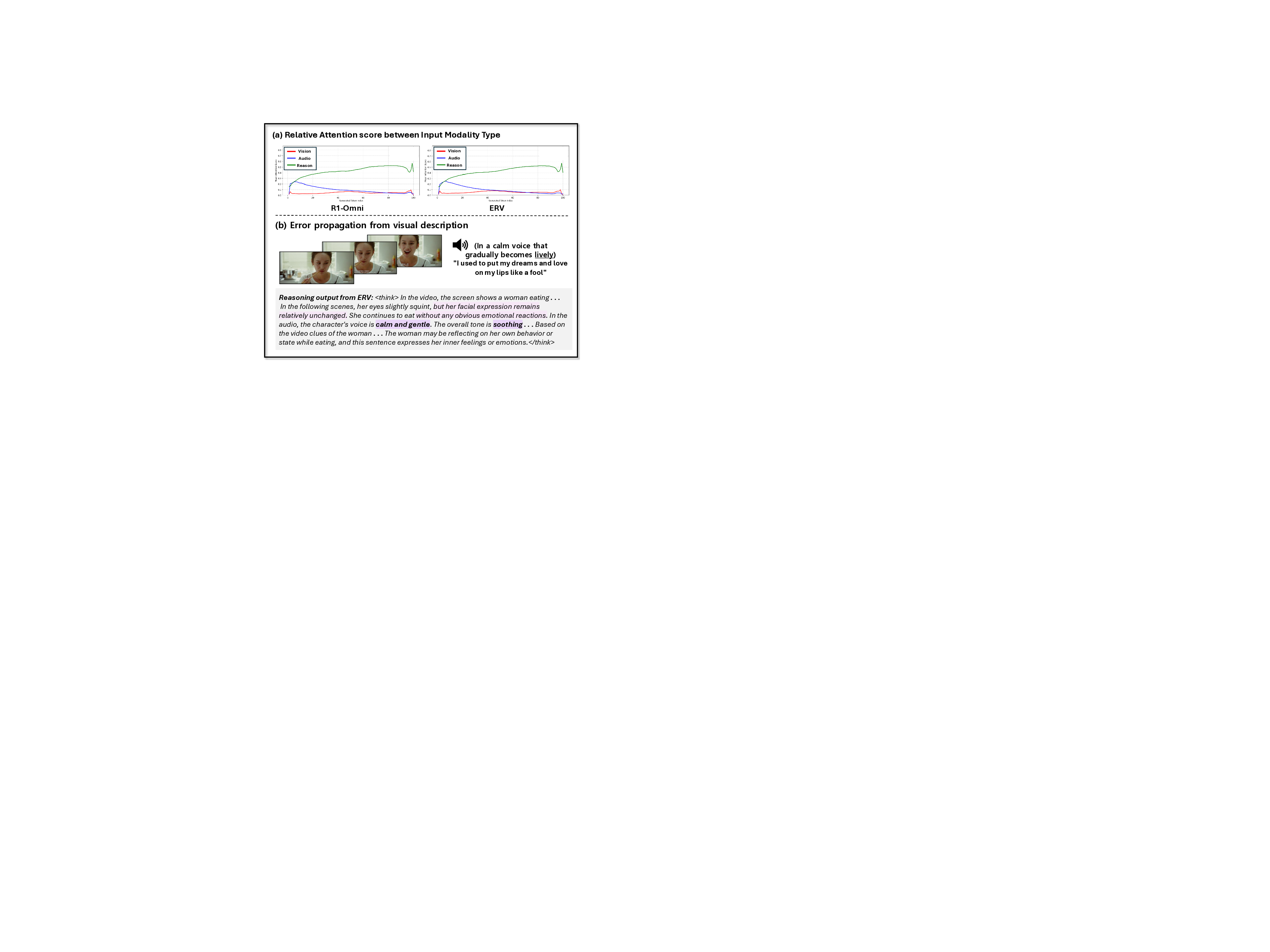

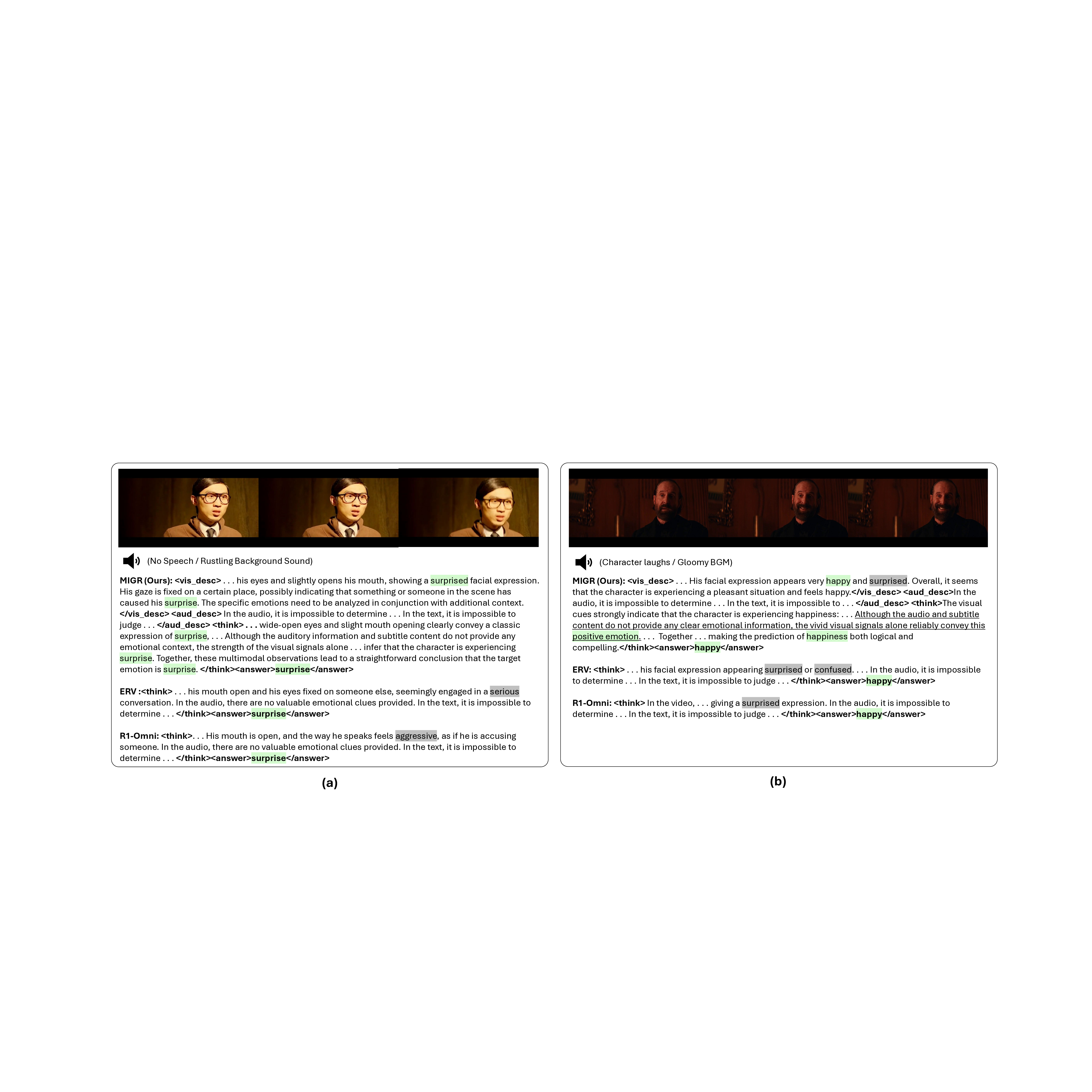

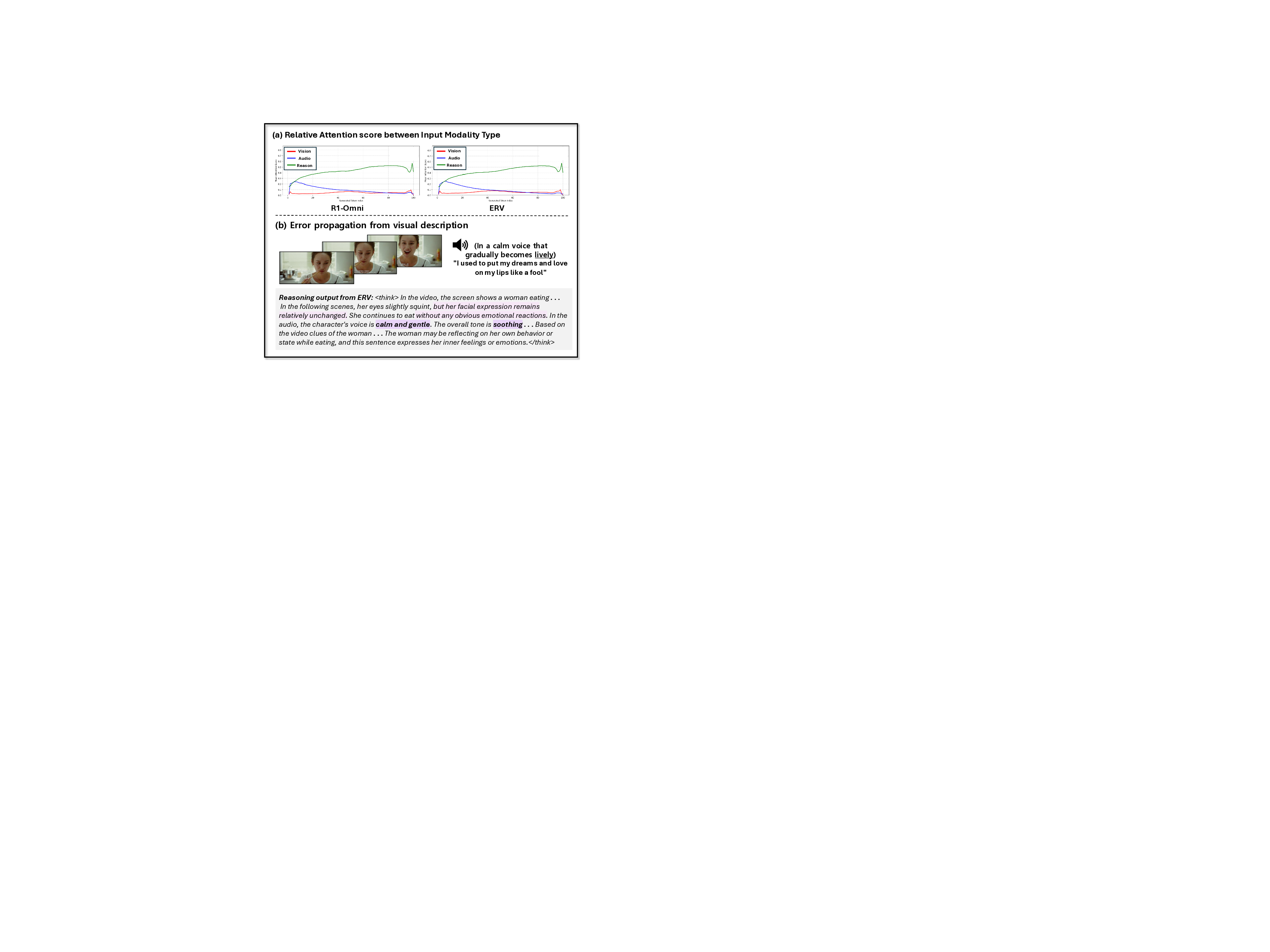

본 논문에서는 멀티모달 대형 언어 모델의 감정 이해에서 추론 신뢰성을 높이기 위해 Modality‑Importance‑Guided Reasoning(MIGR) 프레임워크를 제안한다. 기존 방법들은 감정 인식 성능을 향상시켰지만, 모델이 점차 자체 생성 텍스트에 의존해 멀티모달 근거를 무시하는 ‘추론 드리프트’와, 시각 정보를 중심으로 한 편향된 추론 경로 때문에 설명이 감정과 일치하지 않는 문제가 있었다. 이를 해결하기 위해 감정에 가장 큰 영향을 미치는 모달리티를 식별하는 Modality Importance(MI) 메커니즘을 도입한다. MI를 활용해 MIGR은 설명을 감정‑주도 모달리티부터 시작하도록 추론 순서를 재구성함으로써, 덜 유의미한 단서에 의해 초기 추론이 오도되는 것을 방지한다. 프레임워크는 (1) 모달리티 정렬 감독 미세조정과 (2) 모달리티 인식 보상 최적화의 두 단계로 구성되어, 모델이 감정에 근거하고 인과관계가 명확하며 일관성을 유지하는 설명을 생성하도록 유도한다. DFEW 벤치마크 실험 결과, MIGR은 올바른 예측 뒤에 감정과 불일치하는 설명이 발생하는 비율을 18.10%에서 7.37%로 크게 낮추어 추론 신뢰성을 크게 향상시켰다. 이러한 결과는 감정‑주도 모달리티에서 추론을 시작하는 것이 설명의 일관성과 신뢰성을 높이는 데 효과적임을 입증한다.💡 논문 핵심 해설 (Deep Analysis)

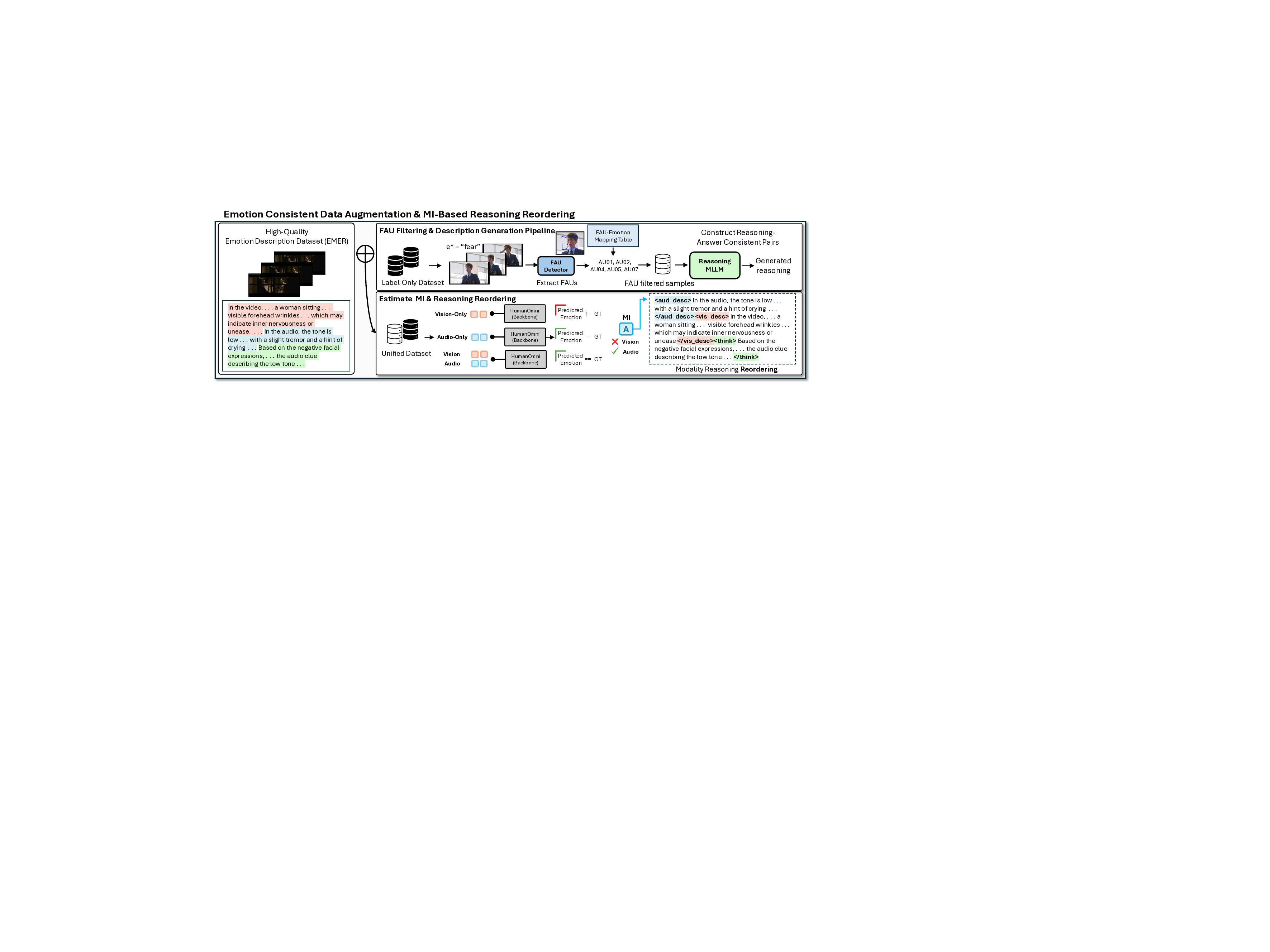

MIGR은 이러한 문제를 근본적으로 해결하기 위해 ‘Modality Importance(MI)’라는 메커니즘을 도입한다. MI는 각 모달리티가 목표 감정에 기여하는 정도를 정량화하는 가중치이며, 이를 위해 사전 학습된 감정‑특화 어텐션 모듈이나 교차‑모달리티 상관관계 분석을 활용한다. MI가 높은 모달리티를 ‘감정‑주도 모달리티’로 지정하고, 모델의 추론 순서를 해당 모달리티 → 보조 모달리티 → 최종 결합 순으로 재배열한다. 이렇게 하면 초기 단계에서 가장 신뢰할 수 있는 근거를 바탕으로 감정을 판단하고, 이후 단계에서 보조 정보를 보강하게 된다.

프레임워크는 두 단계로 구성된다. 첫 번째 단계인 ‘Modality‑Aligned Supervised Fine‑Tuning’에서는 각 모달리티별 라벨링된 감정 데이터와 함께 MI를 라벨로 제공해, 모델이 모달리티별 중요도를 학습하도록 한다. 두 번째 단계인 ‘Modality‑Aware Reward Optimization’에서는 강화학습 기반 보상 함수를 설계한다. 보상은 (1) 감정 예측 정확도, (2) 설명의 감정 일관성, (3) 인과관계 명시성, (4) 텍스트·이미지·음성 간의 일관성 유지 등을 종합적으로 평가한다. 특히 MI에 기반한 가중치를 보상에 반영함으로써, 감정‑주도 모달리티에서 시작된 추론이 보상받고, 반대로 비주도 모달리티에 과도히 의존하는 경우 페널티를 부여한다.

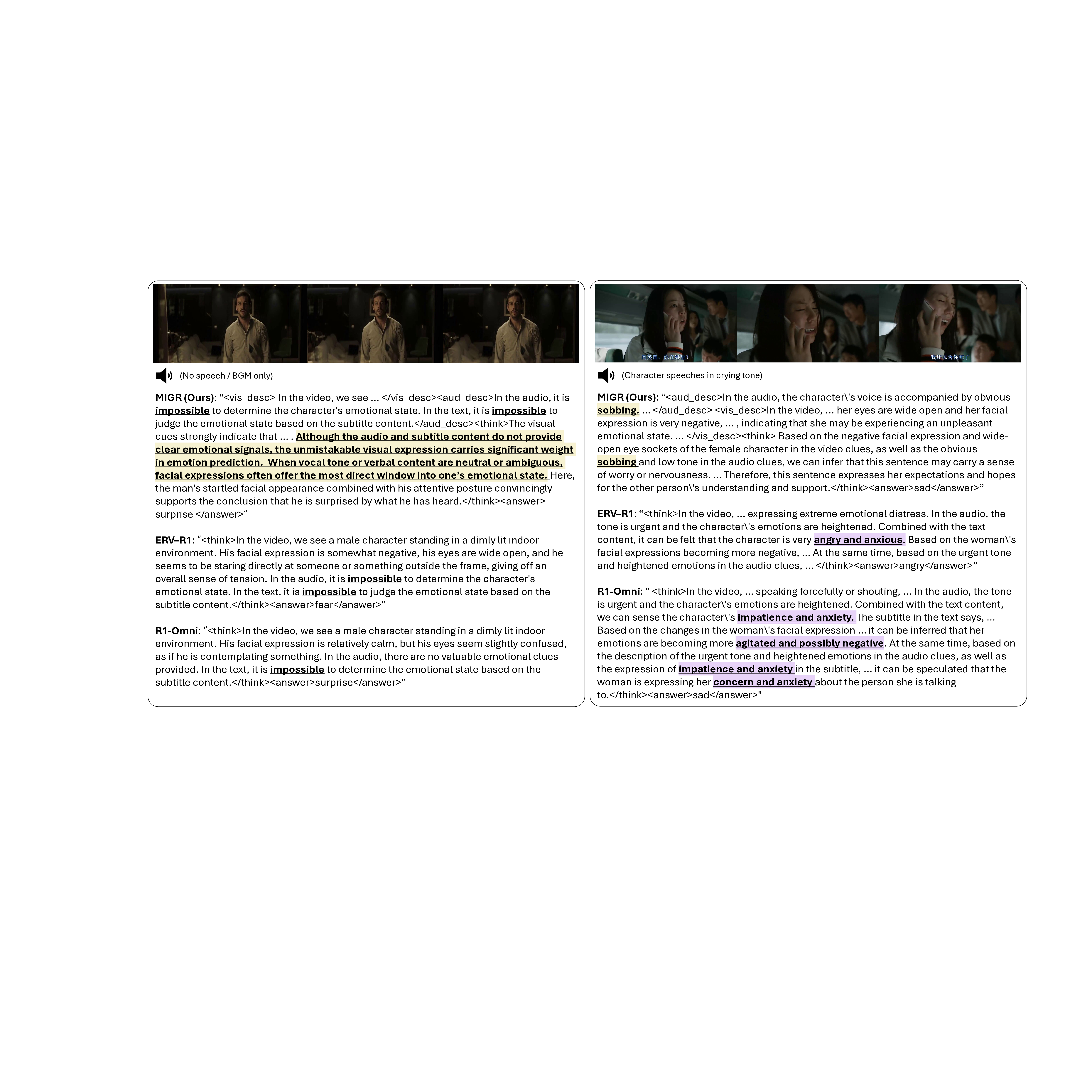

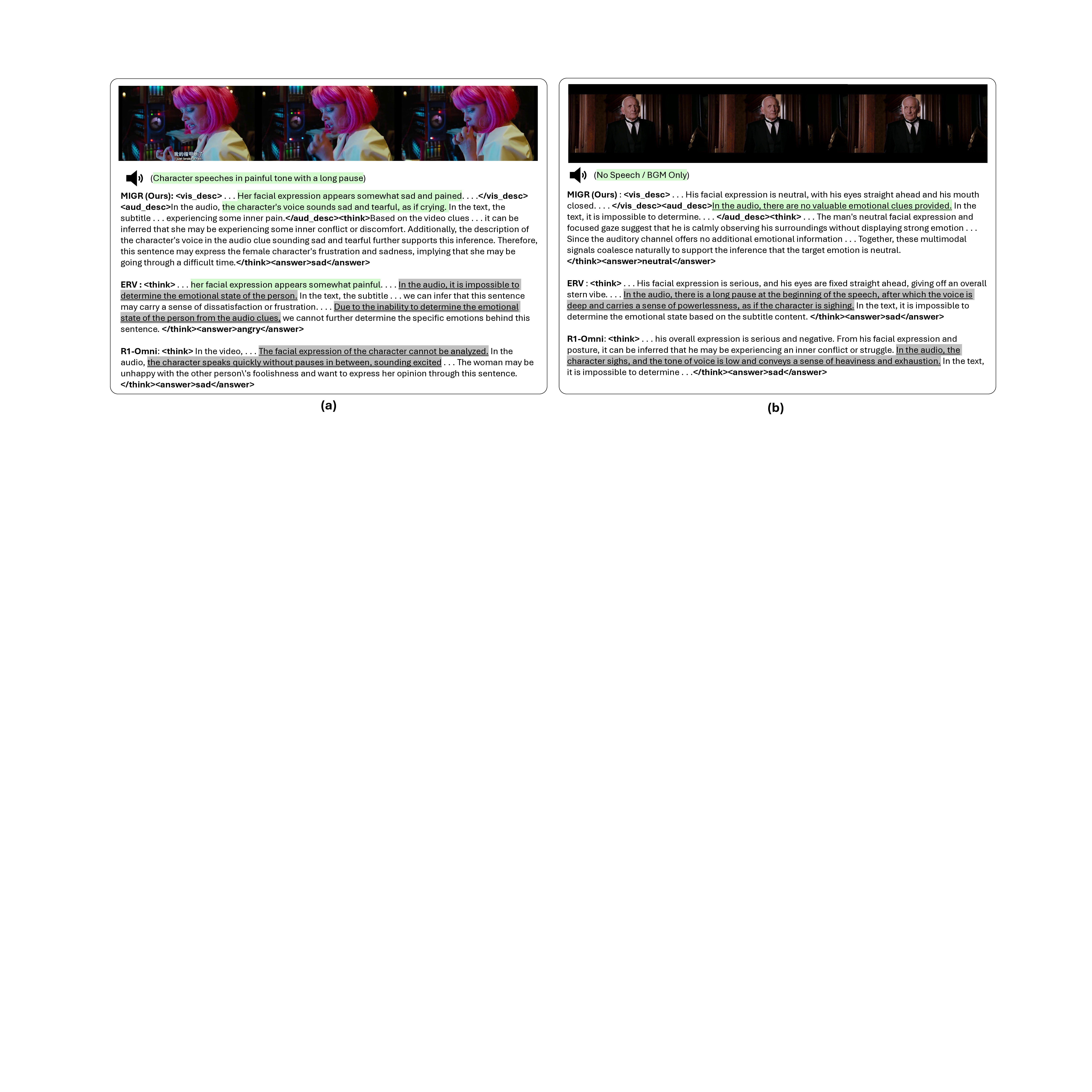

실험은 감정 인식에 특화된 DFEW(Deep Facial Expression in the Wild) 벤치마크를 사용했다. 기존 최첨단 모델 대비 MIGR은 전체 정확도에서는 미미한 차이(≈0.5%p)만 보였지만, ‘정확하지만 감정과 불일치하는 설명’ 비율을 18.10%에서 7.37%로 크게 감소시켰다. 이는 모델이 정답을 맞추더라도 설명이 감정적 근거와 일치하지 않는 경우가 현저히 줄어들었음을 의미한다.

의의는 두 가지로 요약된다. 첫째, 감정 인식에서 모달리티 간 중요도 차이를 명시적으로 고려함으로써 ‘왜 이 감정인가’에 대한 설명 가능성을 크게 향상시켰다. 둘째, 보상 최적화 단계에서 모달리티‑인식 보상을 도입함으로써, 멀티모달 LLM이 단순히 텍스트 기반 추론에 회귀하는 현상을 효과적으로 억제했다.

한계점으로는 MI를 계산하기 위한 추가 어텐션 모듈이 모델 복잡성을 증가시킨다는 점과, 현재 실험이 정적인 이미지·텍스트 데이터에 국한돼 있어 실시간 영상·음성 스트림에 대한 일반화 검증이 부족하다는 점을 들 수 있다. 향후 연구에서는 경량화된 MI 추정 방법, 멀티스테이지 대화형 감정 추론, 그리고 문화·언어 다양성을 반영한 다국어 멀티모달 감정 데이터셋 구축을 통해 프레임워크를 확장할 필요가 있다.

📄 논문 본문 발췌 (Translation)

📸 추가 이미지 갤러리