사회 편향 완화를 위한 모델 병합 알고리즘 실증 조사

📝 원문 정보

- Title: An Empirical Survey of Model Merging Algorithms for Social Bias Mitigation

- ArXiv ID: 2512.02689

- 발행일: 2025-12-02

- 저자: Daiki Shirafuji, Tatsuhiko Saito, Yasutomo Kimura

📝 초록 (Abstract)

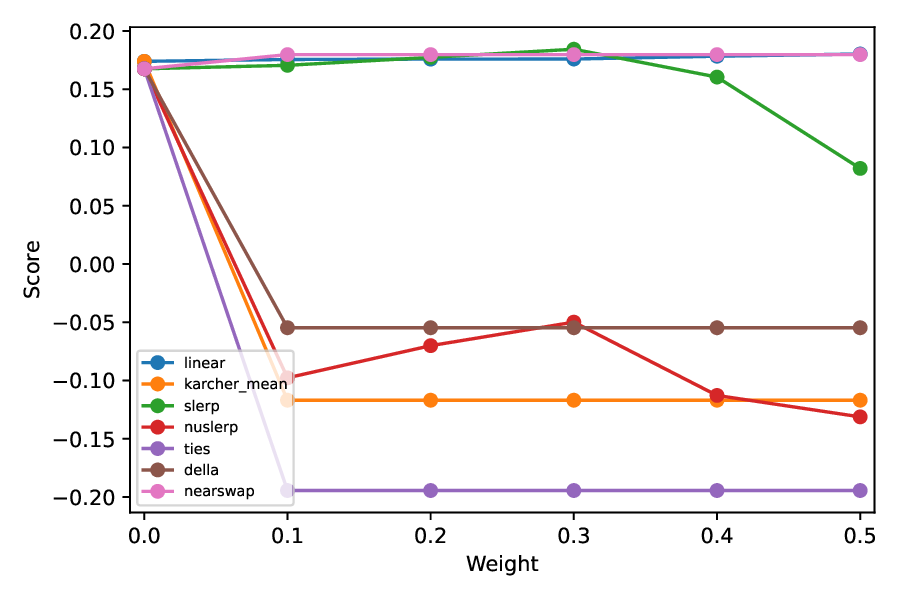

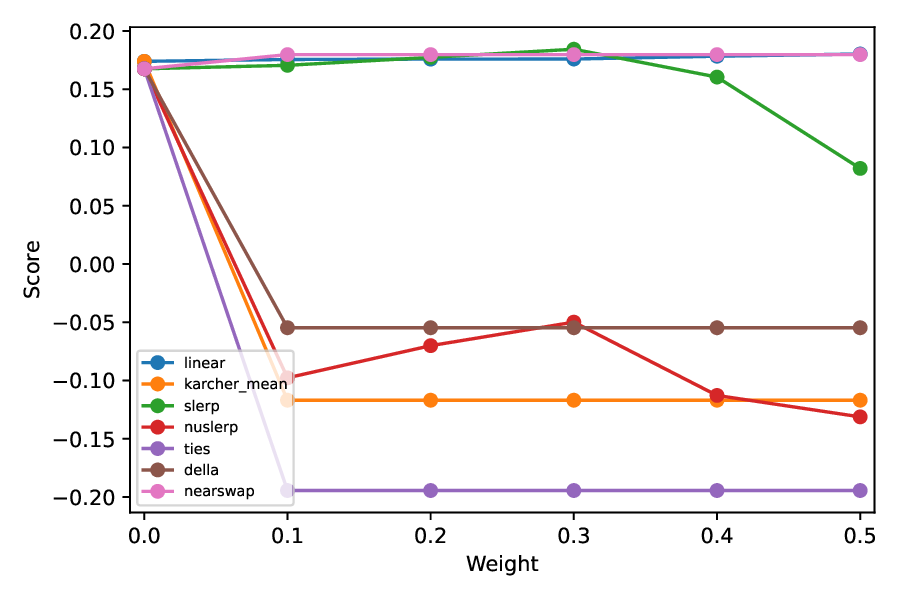

대형 언어 모델(LLM)은 사전 학습 데이터에 내재된 사회적 편향을 그대로 물려받거나 증폭시켜 공정성과 사회적 신뢰를 위협한다. 최근 연구에서는 모델 파라미터를 “편집”하여 편향을 완화하는 모델 병합 접근법을 탐색했지만, 알고리즘 간 실증적 비교는 부족했다. 본 연구는 Linear, Karcher Mean, SLERP, NuSLERP, TIES, DELLA, Nearswap 등 일곱 가지 병합 알고리즘을 GPT, LLaMA, Qwen 계열의 13개 공개 가중치 모델에 적용해 체계적으로 조사한다. BBQ, BOLD, HONEST 세 편향 데이터셋을 이용해 편향 감소 정도를 평가하고, SuperGLUE 벤치마크의 다운스트림 과제에서 성능 변화를 측정한다. 결과는 편향 감소와 다운스트림 성능 사이에 트레이드오프가 존재함을 보여준다: 편향을 크게 완화할수록 특히 독해·상식·인과 추론 과제에서 정확도가 떨어진다. 병합 알고리즘별로는 Linear, SLERP, Nearswap이 편향을 감소시키면서 전반적인 성능을 유지하는 경향을 보였으며, 중간 보간 가중치를 적용한 SLERP가 가장 균형 잡힌 선택으로 나타났다. 이 연구는 모델 병합 알고리즘이 편향 완화에 잠재력을 지니지만, 과도한 디바이싱이나 부적절한 병합 방식은 언어 능력 저하를 초래할 수 있음을 강조한다.💡 논문 핵심 해설 (Deep Analysis)

편향 평가에는 BBQ, BOLD, HONEST라는 세 가지 대표적인 편향 데이터셋을 사용하였다. BBQ는 인종·성별·연령 등 교차 교차 편향을, BOLD는 언어·문화적 편향을, HONEST는 사실성·정확성 편향을 측정한다. 각 병합 결과물에 대해 이들 데이터셋을 통해 편향 점수를 산출하고, 동시에 SuperGLUE 벤치마크(BoolQ, RTE, WiC, COPA 등)에서 정확도와 F1 점수를 측정하였다. 이렇게 두 축을 동시에 고려함으로써 “편향 감소 vs. 언어 능력 유지”라는 트레이드오프를 정량화했다.

실험 결과는 몇 가지 중요한 인사이트를 제공한다. 첫째, 모든 병합 방법이 어느 정도 편향을 감소시키지만, 편향 감소 폭이 클수록 특히 독해와 상식 추론(COPA, RTE)에서 성능 저하가 뚜렷했다. 이는 파라미터를 크게 이동시킬 경우 모델이 학습한 미세한 언어 패턴까지 손실될 가능성을 시사한다. 둘째, Linear, SLERP, Nearswap은 비교적 보수적인 보간을 수행해 편향을 완화하면서도 원래 모델의 성능을 크게 손상시키지 않았다. 특히 SLERP는 구면 상에서의 보간 특성 덕분에 중간 가중치(예: α=0.4~0.6)에서 가장 높은 편향 감소와 최소 성능 손실을 동시에 달성했다. 반면 Karcher Mean과 NuSLERP는 수학적으로는 더 정교하지만, 실제 적용 시 계산 복잡도와 수렴 문제로 인해 일관된 이점을 보이지 못했다. TIES와 DELLA는 다중 모델 간의 상호 보완성을 활용하려 했으나, 편향 감소 효과는 미미했고, 일부 경우에는 오히려 편향이 증가하는 역효과도 관찰되었다.

이러한 결과는 모델 병합이 “전역적인 파라미터 이동”이 아닌, 특정 편향 차원을 타깃으로 하는 정밀 조정이 필요함을 암시한다. 향후 연구에서는 편향 특성을 사전 탐지하고, 해당 차원에만 선택적으로 병합을 적용하는 메타-학습 프레임워크가 유망할 것으로 보인다. 또한, 편향 감소와 성능 유지 사이의 최적 균형점을 찾기 위해 다중 목표 최적화 기법을 도입하거나, 인간 피드백을 활용한 강화 학습 기반의 병합 전략을 탐구할 여지가 크다. 궁극적으로 이 연구는 모델 병합이 편향 완화 도구로서 실용성을 갖추기 위해서는 알고리즘 선택, 보간 가중치 설정, 그리고 평가 기준의 다각적 고려가 필수적임을 강조한다.

📄 논문 본문 발췌 (Translation)

📸 추가 이미지 갤러리