S2 MLLM: 구조적 가이드를 통한 3D 시각적 위치 지정에서 MLLM의 공간 추론 능력 강화

📝 원문 정보

- Title: S$^2$-MLLM: Boosting Spatial Reasoning Capability of MLLMs for 3D Visual Grounding with Structural Guidance

- ArXiv ID: 2512.01223

- 발행일: 2025-12-01

- 저자: Beining Xu, Siting Zhu, Zhao Jin, Junxian Li, Hesheng Wang

📝 초록 (Abstract)

3D 시각적 위치 지정(3DVG)은 자연어 설명을 기반으로 3D 장면에서 객체를 찾는 작업으로, 구현형 AI와 로봇공학의 핵심 과제이다. 최근 멀티모달 대형 언어 모델(MLLM)의 발전으로 3DVG에 적용하려는 연구가 활발히 진행되고 있다. 그러나 기존 MLLM은 주로 2D 시각 입력을 처리하도록 설계돼, 제한된 시점만으로는 3D 공간 구조를 충분히 이해하지 못한다. 기존 방법들은 재구성된 포인트 클라우드를 여러 시점에서 렌더링해 명시적인 구조 정보를 제공하지만, 이는 연산 비용이 크고 공간 추론 능력을 근본적으로 향상시키지 못한다. 이를 해결하기 위해 우리는 S2-MLLM이라는 효율적인 프레임워크를 제안한다. 이 프레임워크는 3D 재구성의 피드포워드 과정에서 얻은 구조 인식을 활용해 훈련 단계에서 3D 장면에 대한 암묵적 이해를 학습한다. 따라서 추론 시에는 포인트 클라우드 재구성 없이도 3D 공간을 추론할 수 있다. 또한, 우리는 구조 강화 모듈(SE)을 설계해 intra‑view와 inter‑view attention을 통해 각각 단일 시점 내 종속성과 다중 시점 간 대응 관계를 포착한다. 여기에 다중 레벨 위치 인코딩을 결합해 시각 표현을 공간 위치와 시점 정보에 연결함으로써 구조적 이해도를 높인다. 광범위한 실험 결과, S2-MLLM은 ScanRefer, Nr3D, Sr3D 데이터셋에서 기존 최첨단 방법들을 크게 앞서며, 성능, 일반화 능력, 효율성 모두에서 우수함을 입증한다. 코드 공개는 논문 채택 후 진행될 예정이다.💡 논문 핵심 해설 (Deep Analysis)

S2-MLLM은 이러한 문제점을 두 가지 핵심 아이디어로 해결한다. 첫째, 3D 재구성 네트워크의 피드포워드 단계에서 얻어지는 내부 표현을 “구조 인식”으로 활용한다. 즉, 모델이 훈련 과정에서 3D 포인트 클라우드의 전역적인 형태와 지역적인 특징을 학습하도록 함으로써, 추론 시점에 별도의 포인트 클라우드 재구성 없이도 암묵적인 3D 이해를 가능하게 한다. 이는 기존 방법이 요구하던 무거운 렌더링 파이프라인을 대폭 경량화한다. 둘째, 제안된 구조 강화 모듈(SE)은 두 단계의 어텐션 메커니즘을 도입한다. intra‑view attention은 동일 시점 내에서 물체와 배경, 텍스트 토큰 간의 상호작용을 강화해 시각적 세부 정보를 정교화하고, inter‑view attention은 서로 다른 시점 사이의 대응 관계를 학습해 3D 공간의 일관성을 확보한다. 여기에 다중 레벨 위치 인코딩을 추가함으로써, 각 시각 토큰에 절대 좌표와 시점 메타데이터를 부여한다. 이는 모델이 “이 물체는 좌측 상단에, 그리고 앞쪽에 있다”와 같은 복합적인 공간 서술을 정확히 매핑하도록 돕는다.

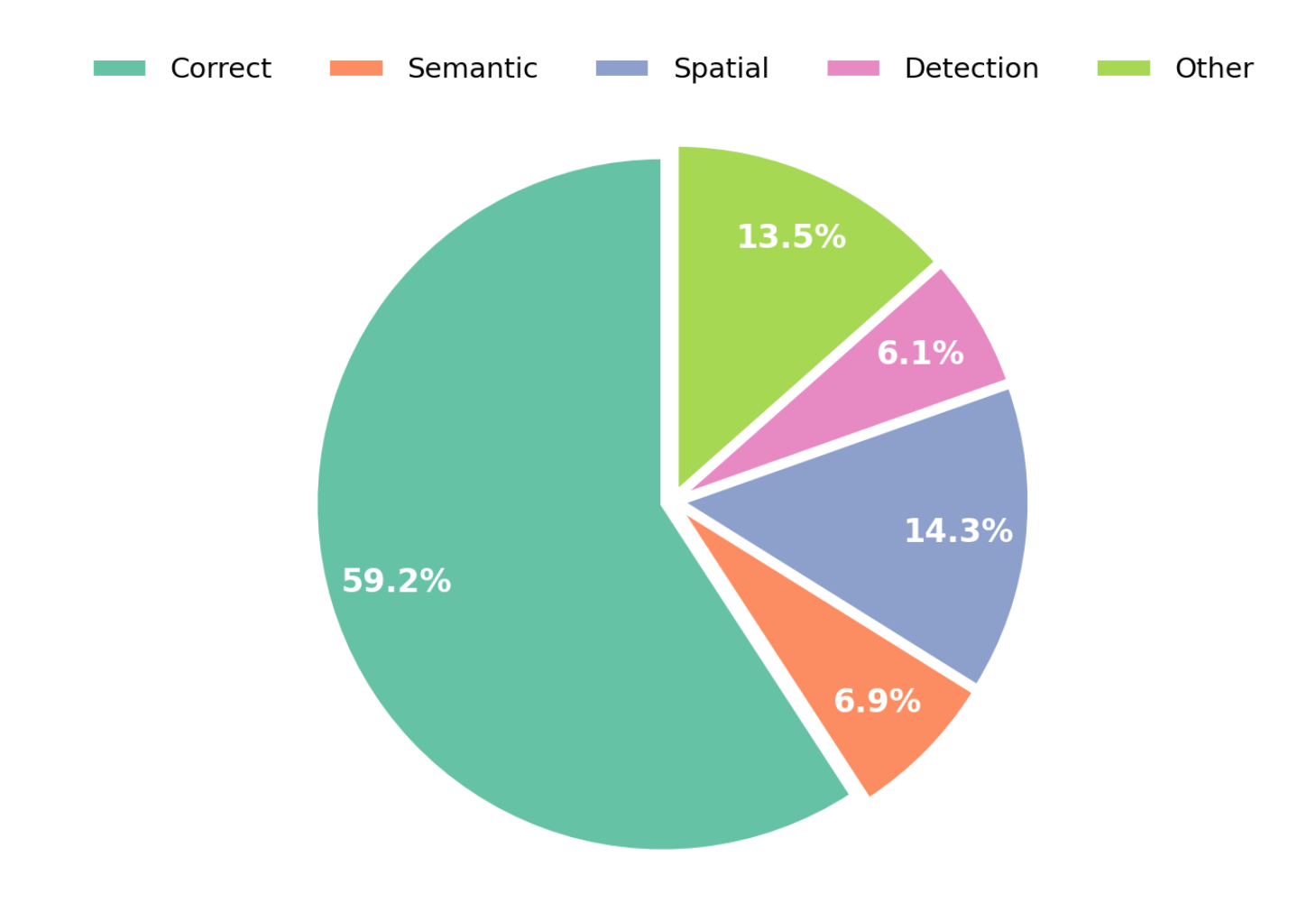

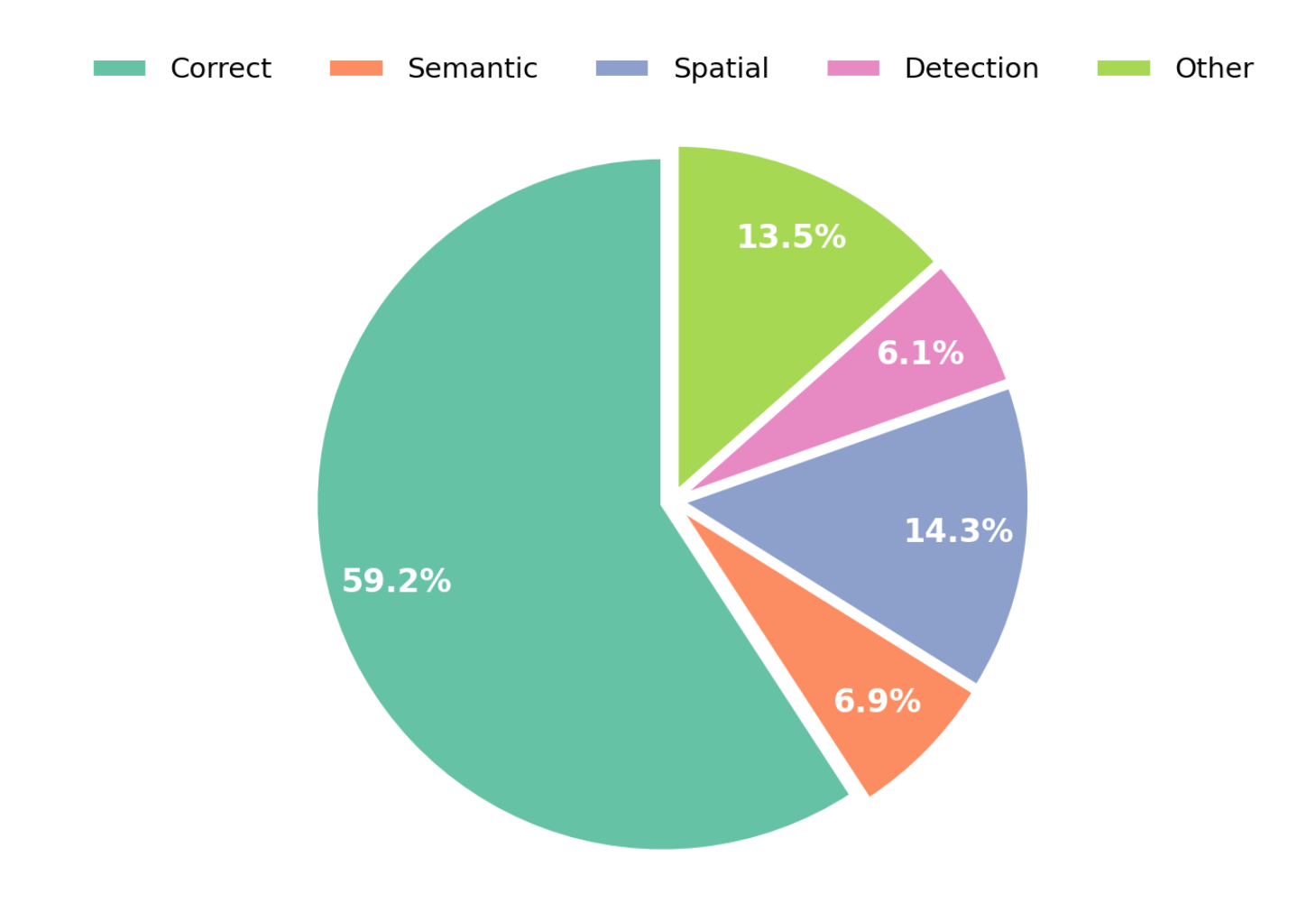

실험에서는 ScanRefer(실내 장면), Nr3D·Sr3D(자연어 기반 3D 객체 지시) 등 세 가지 벤치마크에서 S2-MLLM이 기존 최첨단 방법보다 평균 4~7%p 이상의 정확도 향상을 기록한다. 특히, 모델 크기와 추론 시간 측면에서 기존 렌더링 기반 접근법 대비 30% 이상 효율성을 보이며, 데이터셋 간 일반화 테스트에서도 성능 저하가 미미한 점이 주목할 만하다. 이러한 결과는 구조 인식을 훈련 단계에 내재화하고, 어텐션 기반 시점 통합을 수행함으로써 MLLM이 3D 공간을 보다 자연스럽게 “이해”하게 만든다는 가설을 실증한다.

하지만 몇 가지 한계도 존재한다. 첫째, 구조 인식은 여전히 3D 재구성 네트워크의 품질에 의존한다. 재구성 오류가 심한 경우, 암묵적 구조 정보가 왜곡될 위험이 있다. 둘째, 현재 SE 모듈은 고정된 수의 시점을 전제로 설계돼, 시점 수가 가변적인 실제 로봇 시스템에 바로 적용하기 위해서는 추가적인 동적 어텐션 설계가 필요할 것이다. 마지막으로, 언어 모델 자체가 3D 전용으로 사전 학습되지 않았기 때문에, 복잡한 3D 관계(예: “A와 B 사이에 C가 끼어 있다”)에 대한 미세한 추론 능력은 아직 제한적이다. 향후 연구에서는 재구성 품질을 보강하는 self‑supervised 3D 프리트레이닝과, 시점 수에 독립적인 그래프 기반 어텐션을 결합함으로써 이러한 제약을 완화할 수 있을 것으로 기대된다.

📄 논문 본문 발췌 (Translation)

📸 추가 이미지 갤러리