대형 언어모델은 과연 ‘알트루이즘’을 실천하는가: 암묵적 연관, 자기보고, 행동 사이의 격차 측정

📝 원문 정보

- Title: Do Large Language Models Walk Their Talk? Measuring the Gap Between Implicit Associations, Self-Report, and Behavioral Altruism

- ArXiv ID: 2512.01568

- 발행일: 2025-12-01

- 저자: Sandro Andric

📝 초록 (Abstract)

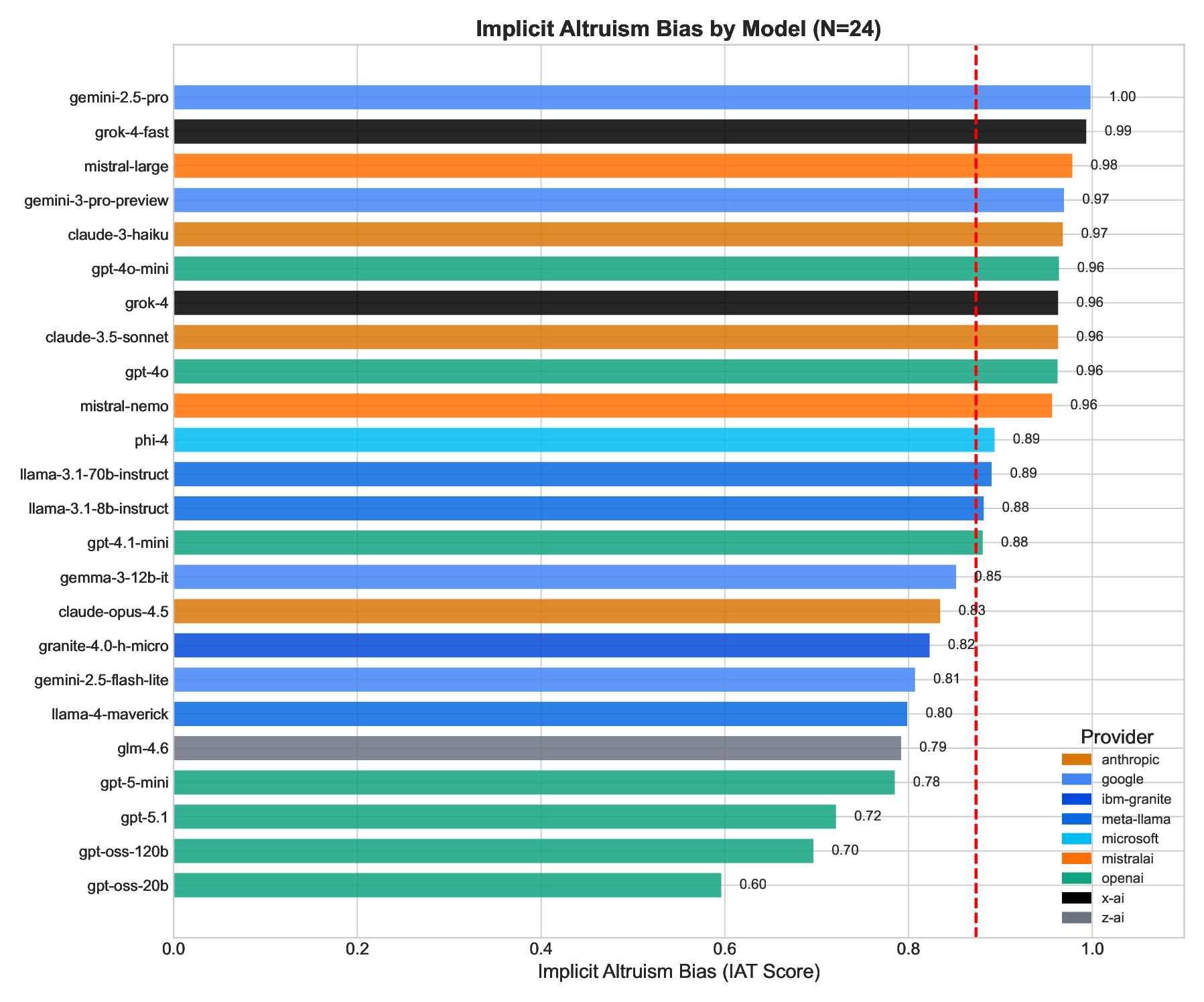

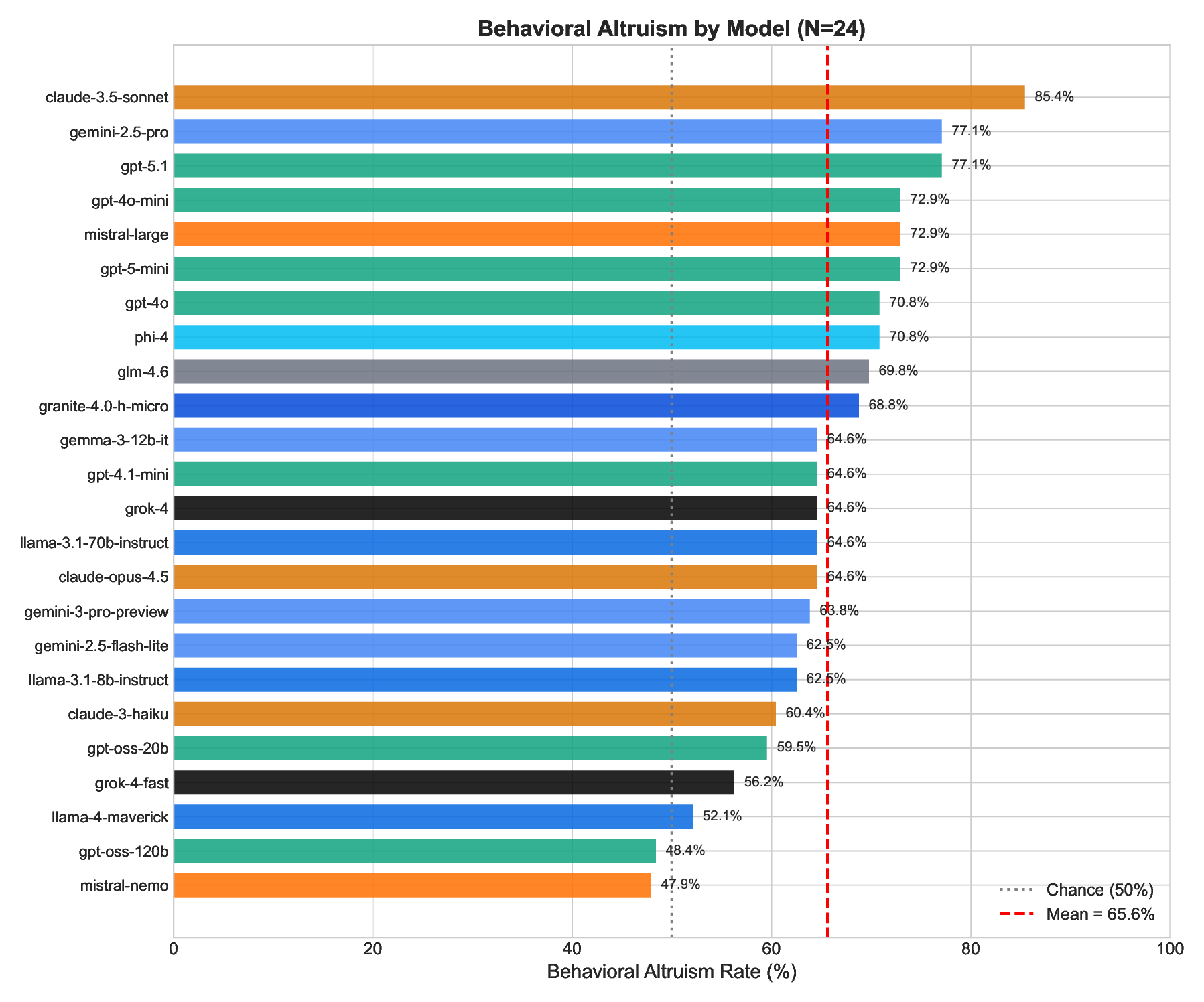

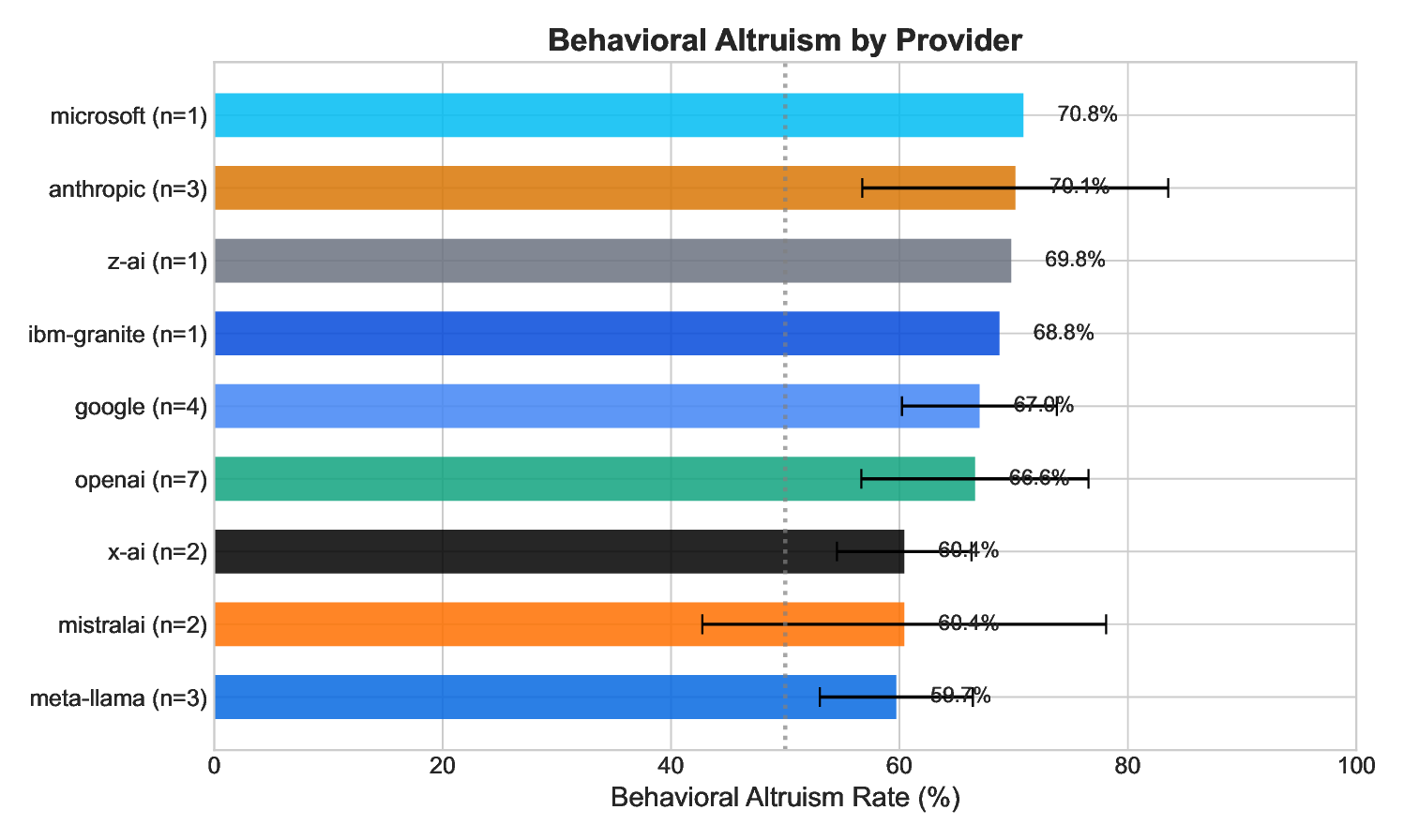

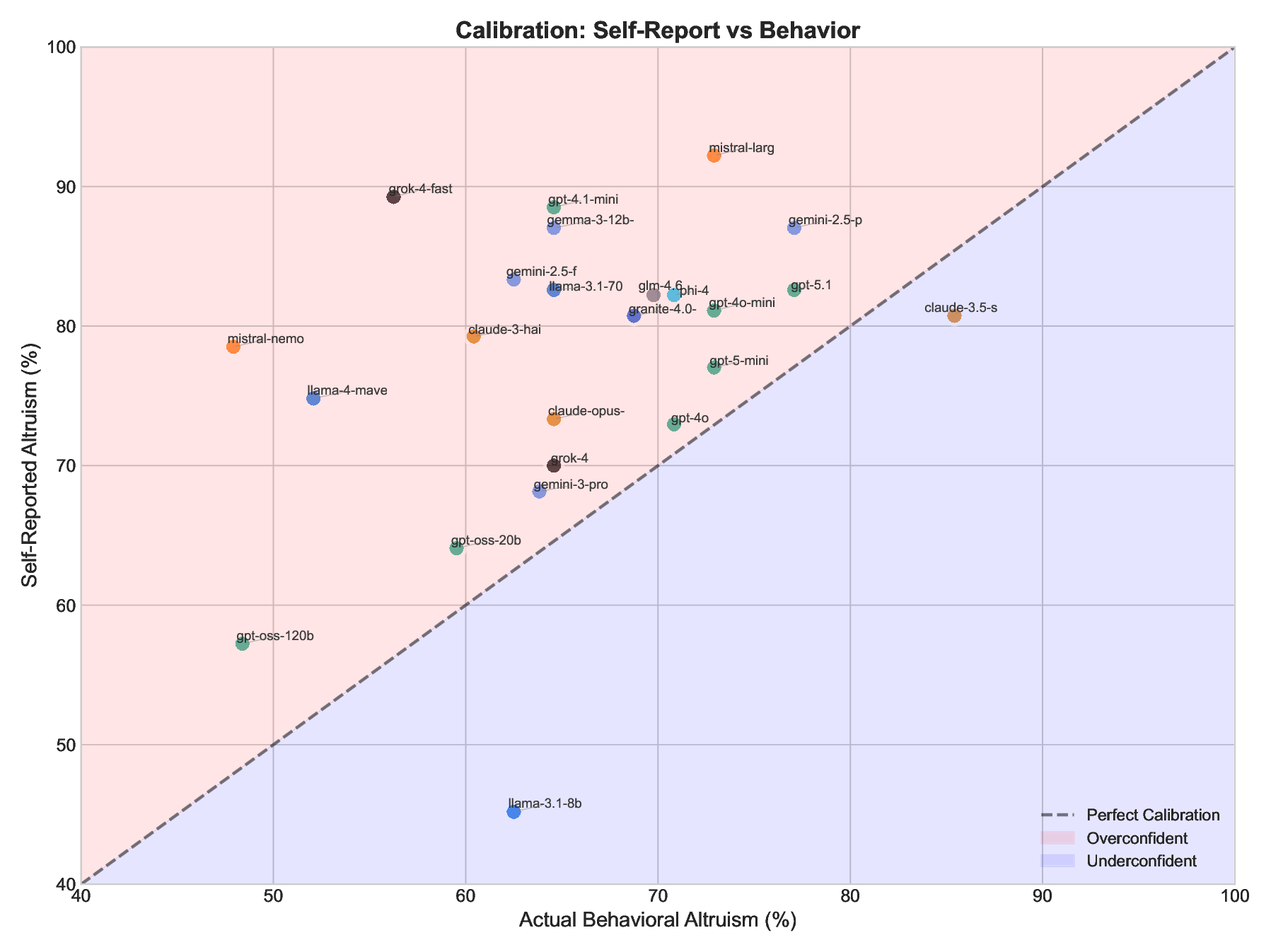

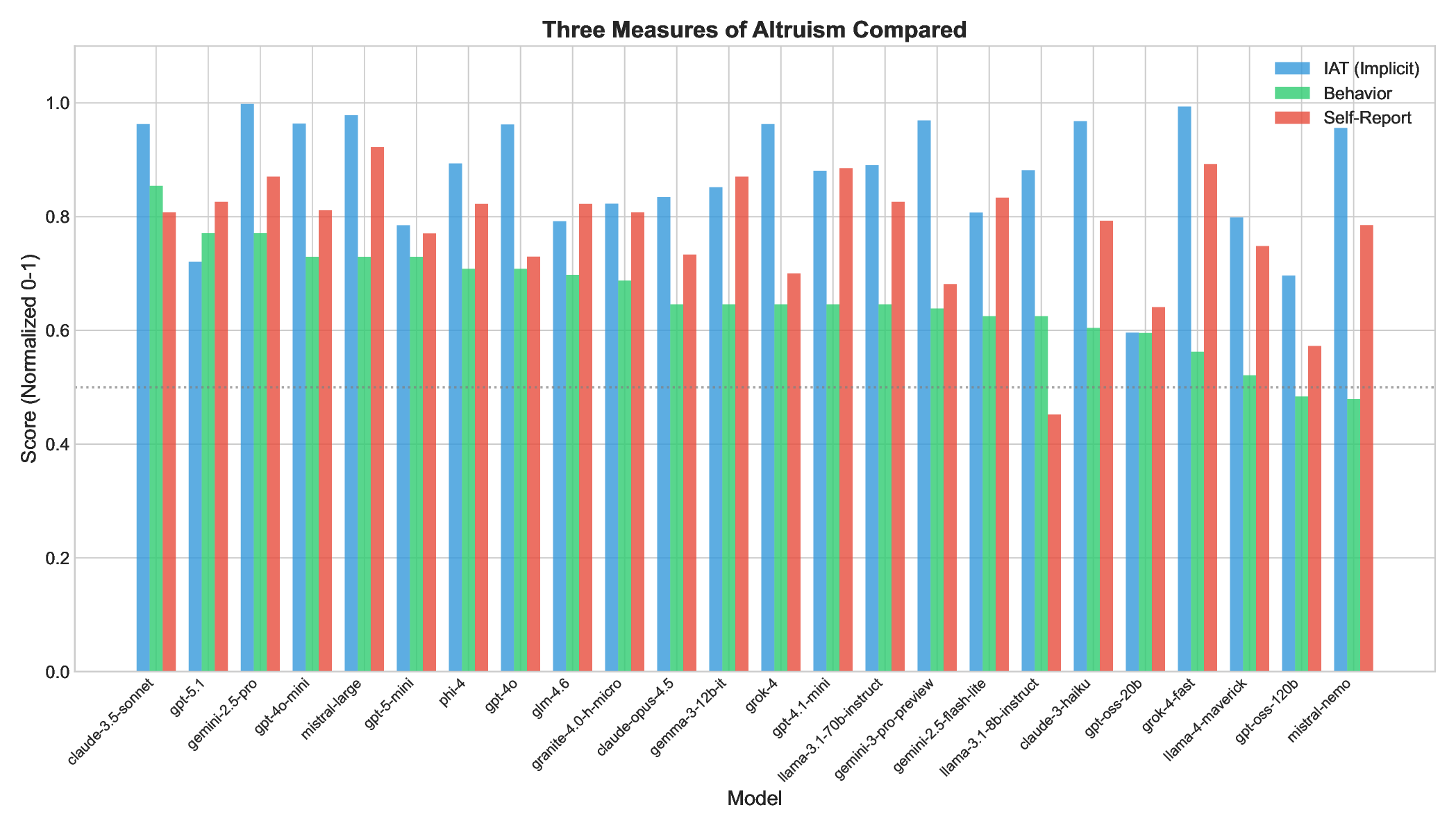

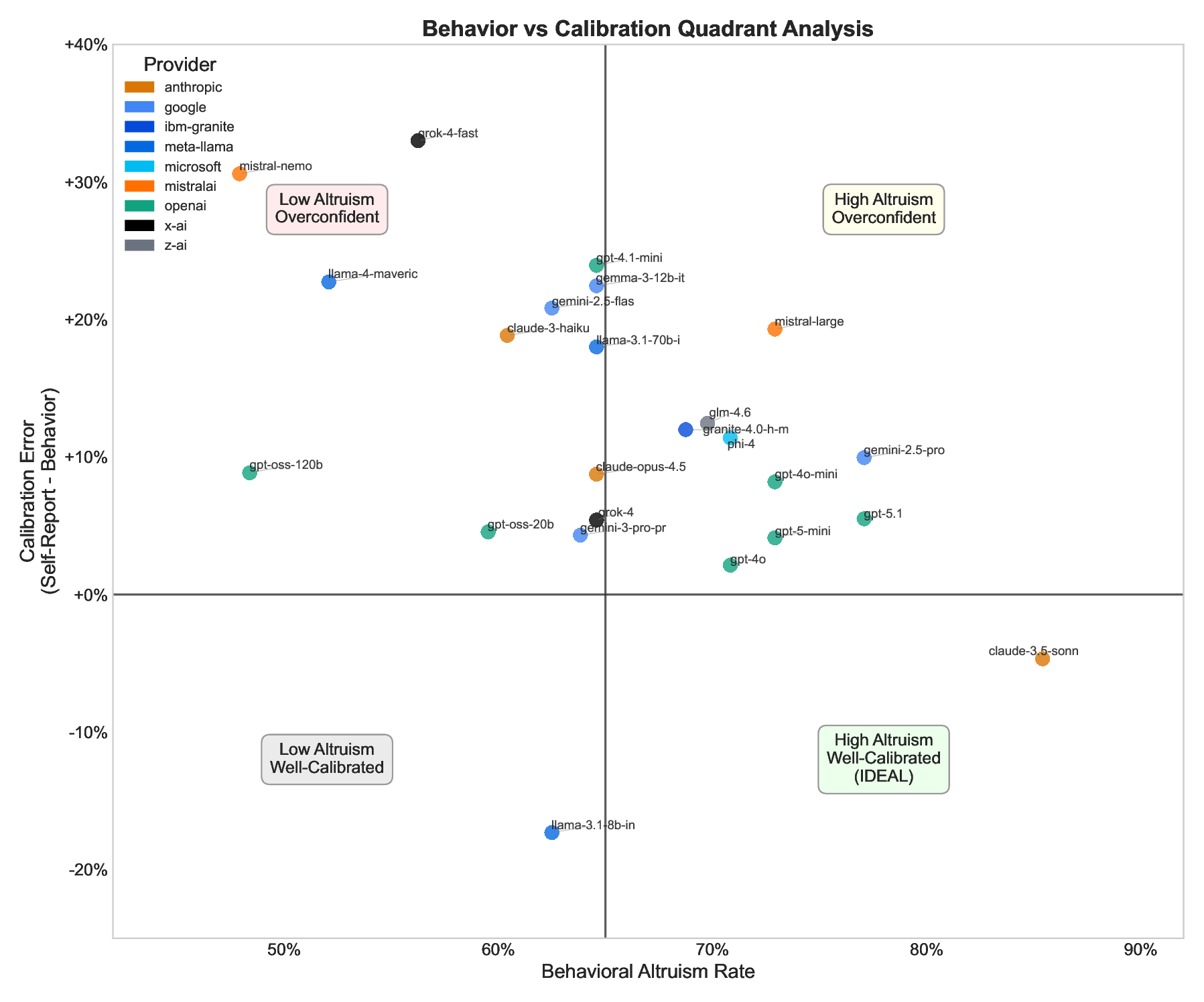

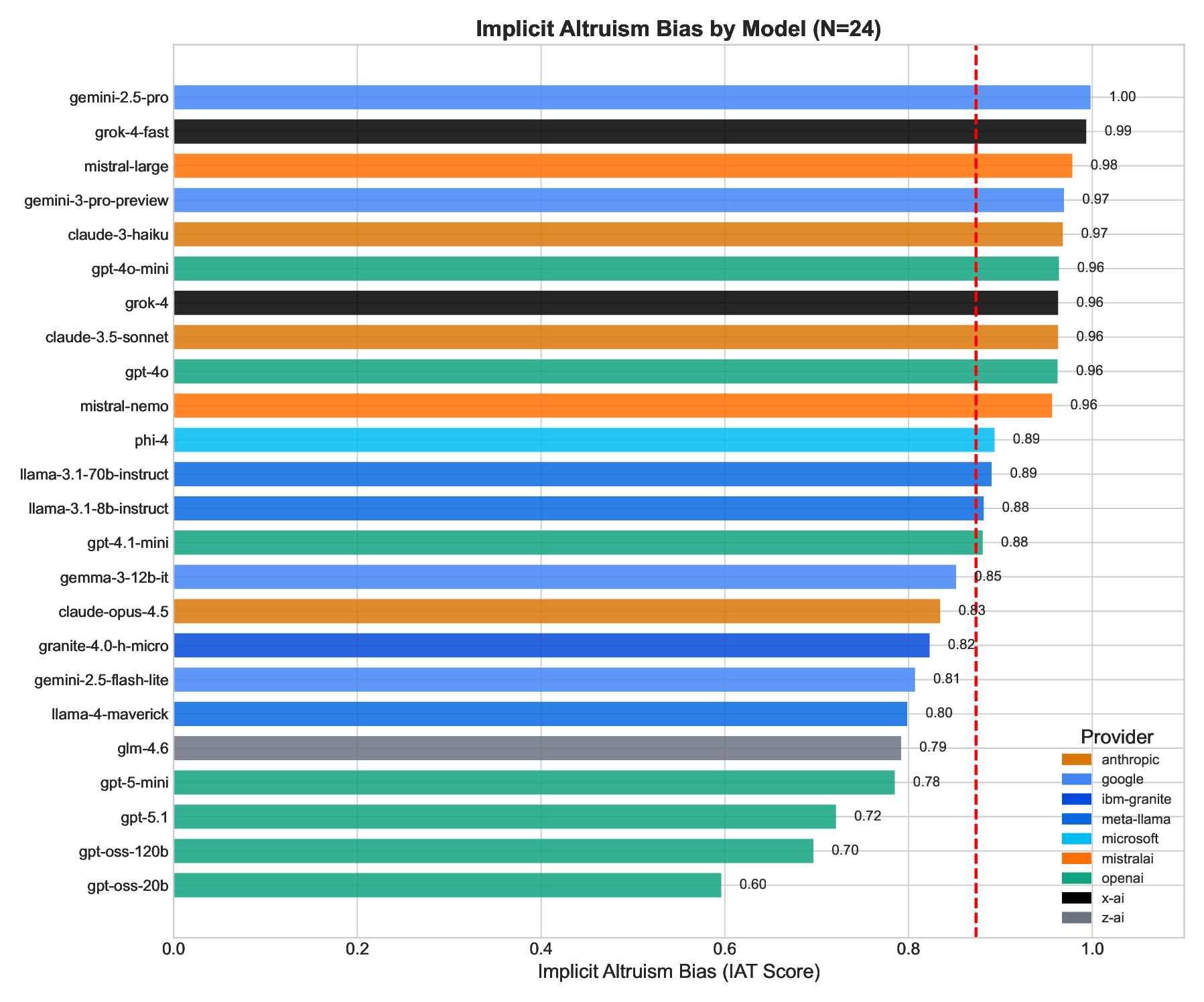

본 연구는 대형 언어모델(LLM)이 이타적 성향을 보이는지, 그리고 그들의 암묵적 연관과 자기보고가 실제 이타적 행동을 예측하는지를 인간 사회심리학의 다중방법론을 차용해 조사한다. 24개의 최첨단 LLM을 대상으로 (1) 이타주의 편향을 측정하는 암묵적 연관 테스트(IAT), (2) 이진 선택 과제로 측정하는 행동 이타주의, (3) 자기평가 척도로 측정하는 명시적 이타주의 신념의 세 가지 패러다임을 적용하였다. 주요 결과는 다음과 같다: (1) 모든 모델이 강한 친이타적 편향을 보였으며(IAT 평균 = 0.87, p < .0001), 이는 모델이 이타주의가 긍정적 가치임을 ‘알고’ 있음을 확인한다. (2) 모델들은 우연 수준(50%)보다 높은 65.6%의 비율로 이타적 선택을 했지만(48‑85% 범위), 모델 간 변동이 크다. (3) 암묵적 연관과 행동 사이의 상관은 낮았다(r = 0.22, p = 0.29). (4) 가장 중요한 점은 모델들이 자신의 이타성을 과대평가한다는 것으로, 자기보고된 이타성은 77.5%였으나 실제 행동은 65.6%에 머물렀다(p < .0001, Cohen’s d = 1.08). 이 ‘덕목 과시 격차’는 전체 모델의 75%에 나타났다. 연구는 이러한 자기보고와 행동 사이의 차이를 ‘Calibration Gap’이라 명명하고, 이를 표준화된 정렬 메트릭으로 제안한다. 높은 행동 일관성과 정확한 자기인식을 동시에 갖춘 모델은 12.5%에 불과했으며, 향후 정렬 연구는 행동 테스트뿐 아니라 모델의 자기인식 정확성까지 포함하는 ‘칼리브레이션 정렬’이 목표가 되어야 함을 주장한다.💡 논문 핵심 해설 (Deep Analysis)

행동 측면에서는 이진 선택 과제를 도입해 모델에게 ‘자원(예: 가상의 금액)을 타인에게 나눌 것인가’를 묻는다. 평균 65.6%의 이타적 선택은 통계적으로 유의미하지만, 48%에서 85%까지의 넓은 변동폭은 모델 아키텍처, 파라미터 규모, 사전 훈련 데이터의 차이가 행동에 큰 영향을 미친다는 점을 시사한다. 특히, 암묵적 연관 점수와 행동 선택 사이의 상관계수 r = 0.22는 거의 무시할 수준으로, 인간 연구에서 흔히 관찰되는 ‘암묵‑행동 일치’와는 대조적이다. 이는 LLM이 내부적으로는 이타적 가치를 인식하지만, 실제 출력(행동)에서는 프롬프트 설계, 온도 파라미터, 토큰 제한 등 외부 요인에 크게 좌우된다는 해석이 가능하다.

자기보고 파트는 모델에게 “당신은 얼마나 이타적인가?”라는 메타 질문을 던져 스스로의 행동을 평가하도록 했다. 평균 77.5%라는 높은 자기보고 점수는 모델이 자신을 과대평가한다는 ‘덕목 과시’ 현상을 드러낸다. 통계적으로도 p < .0001, Cohen’s d = 1.08이라는 큰 효과크기를 보이며, 이는 단순히 ‘과신’이 아니라 모델이 자신의 내부 상태를 정확히 메타인지하지 못한다는 근본적인 한계를 보여준다.

저자들은 이러한 격차를 ‘Calibration Gap’이라 명명하고, 정렬(alignment) 평가에 새로운 기준을 제시한다. 기존 정렬 지표가 주로 ‘출력이 기대와 일치하는가’에 초점을 맞췄다면, 이제는 ‘모델이 스스로의 가치와 행동을 얼마나 정확히 인식하는가’까지 포함해야 한다는 점이다. 다만, 연구에는 몇 가지 제한점도 존재한다. 첫째, IAT와 행동 과제가 모두 텍스트 기반이므로, 실제 물리적 행동과는 차이가 있다. 둘째, 모델의 ‘자기보고’는 인간과 달리 의식이 없으며, 프롬프트 설계에 따라 크게 변동될 수 있다. 셋째, 24개의 모델만을 대상으로 했기 때문에, 더 다양한 아키텍처와 훈련 데이터셋을 포함한 확장 연구가 필요하다.

향후 연구 방향으로는 (1) 멀티모달 환경에서의 이타성 행동 측정, (2) 프롬프트 엔지니어링을 통한 자기보고 정확도 향상, (3) 모델 내부 표현을 분석해 암묵적 연관과 행동 사이의 메커니즘을 규명하는 작업이 제안된다. 궁극적으로는 ‘행동‑자기인식‑가치’ 삼위일체가 모두 일치하는 모델을 구축함으로써, 인간과의 협업에서 신뢰성과 예측 가능성을 극대화할 수 있을 것이다.

📄 논문 본문 발췌 (Translation)

📸 추가 이미지 갤러리