장기 시계열을 위한 자기설명 모델 정보 구조적 인과 패턴 추출

📝 원문 정보

- Title: A Self-explainable Model of Long Time Series by Extracting Informative Structured Causal Patterns

- ArXiv ID: 2512.01412

- 발행일: 2025-12-01

- 저자: Ziqian Wang, Yuxiao Cheng, Jinli Suo

📝 초록 (Abstract)

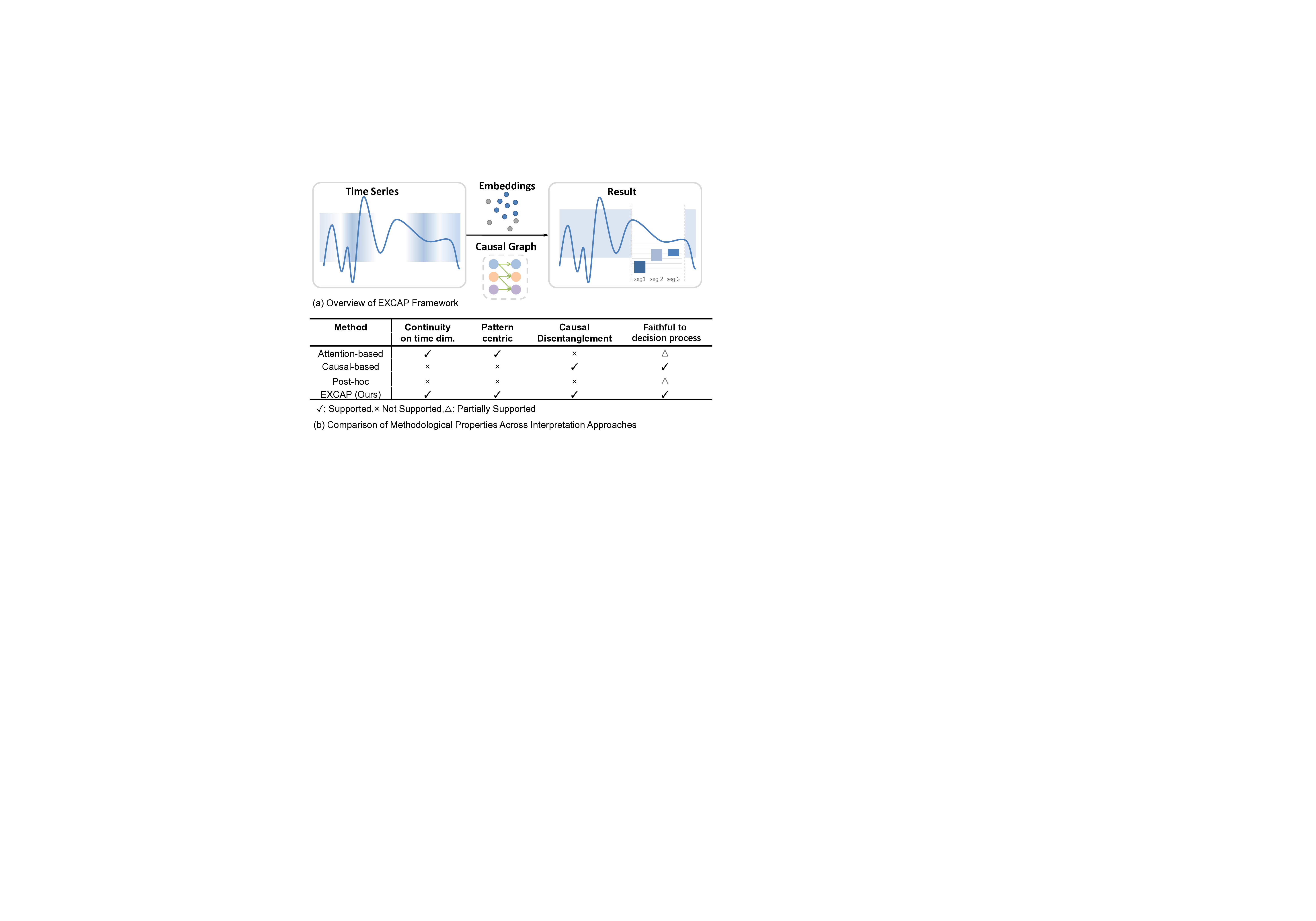

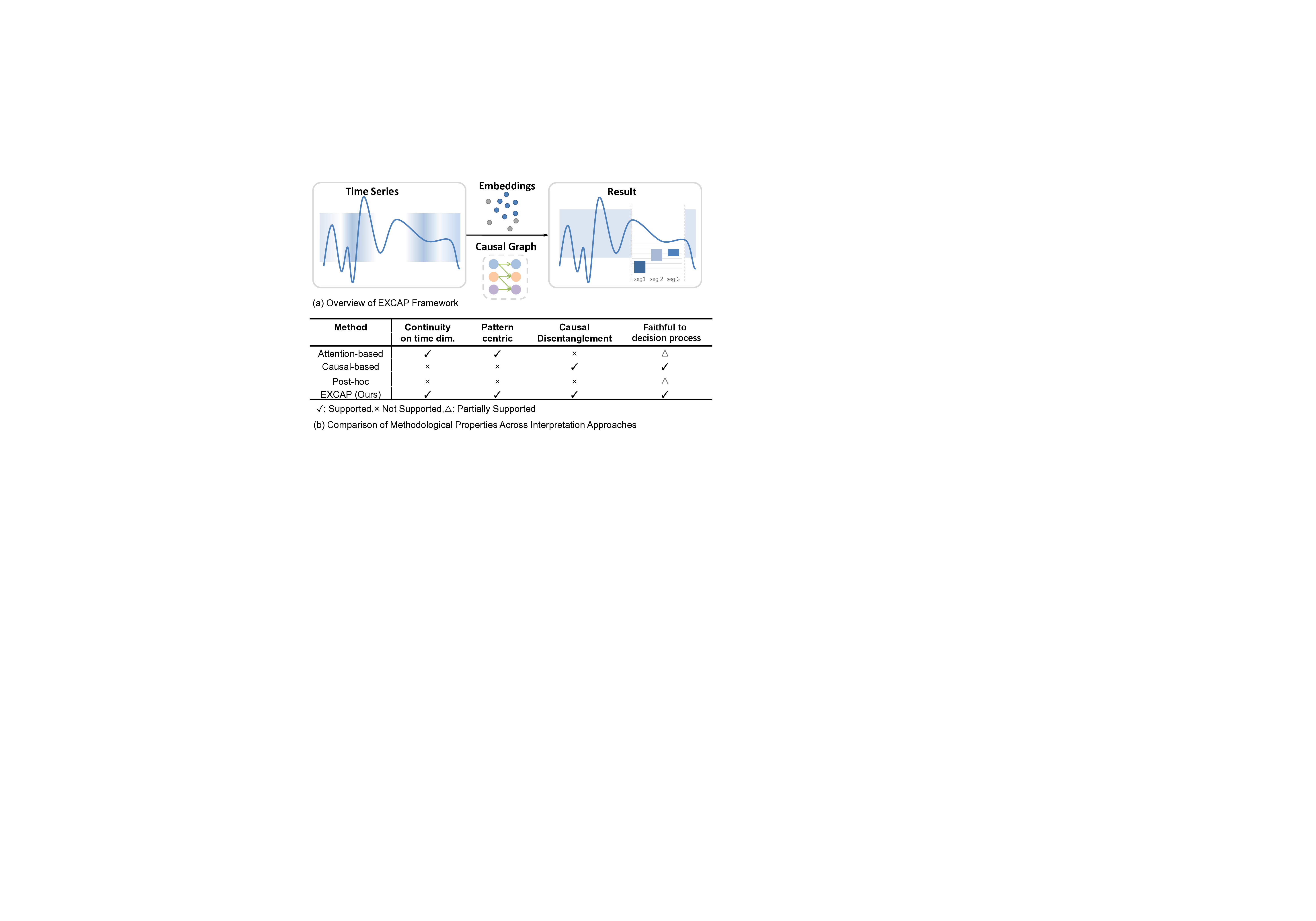

시간 시계열 모델의 설명 가능성은 예측 정확도와 동등하게 중요하지만, 기존 XAI 기법은 개별 시점의 중요도만 제공해 추세·주기·급격한 변화를 포착하지 못한다. 이를 해결하기 위해 저희는 네 가지 해석 가능성 기준(시간 연속성, 패턴 중심성, 인과 분리, 추론 충실도)을 제시하고, 이를 모두 만족하는 EXCAP 프레임워크를 설계하였다. EXCAP은 연속적인 패턴을 추출하는 어텐션 기반 세그멘터, 사전 학습된 인과 그래프에 의해 가이드되는 인과 분리 디코더, 그리고 표현 공간의 분리와 안정성을 강제하는 잠재 집계 손실을 결합한다. 이론적으로 EXCAP은 시간에 대해 Lipschitz 연속적인 설명을 보장하고, 인과 마스크 변동에 대한 오류를 상한으로 제시하며, 잠재 공간의 안정성을 향상시킨다. 다양한 분류·예측 벤치마크 실험에서 EXCAP은 기존 최첨단 XAI 방법보다 예측 정확도와 해석 가능성 모두에서 우수함을 입증했으며, 시간적으로 일관되고 인과적으로 근거 있는 설명을 제공한다. 이러한 결과는 의료·금융 등 의사결정이 중요한 분야에서 장기 시계열 모델을 신뢰성 있게 활용할 수 있음을 시사한다.💡 논문 핵심 해설 (Deep Analysis)

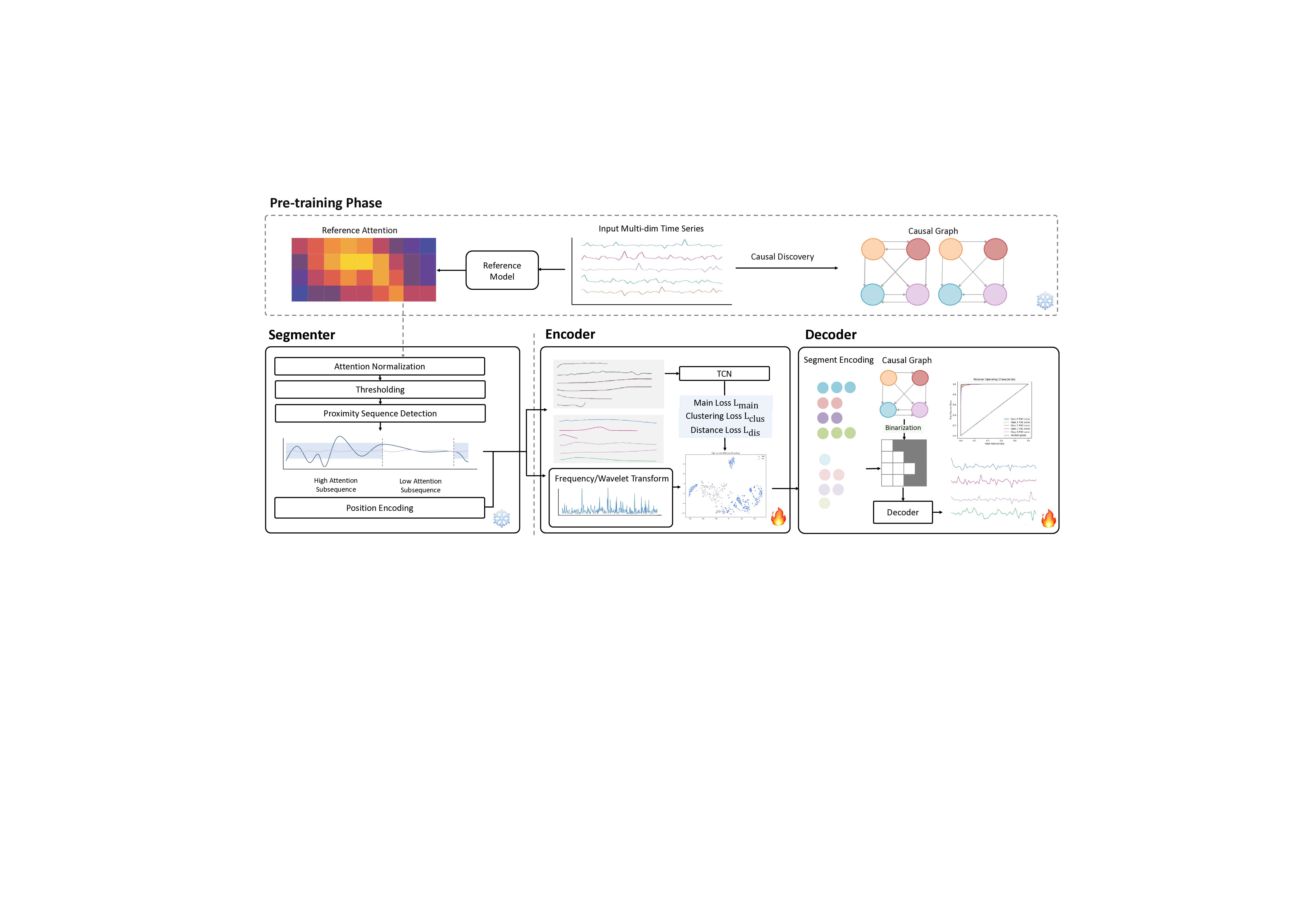

EXCAP은 이 네 가지 요구를 동시에 만족하도록 설계된 통합 프레임워크이다. 핵심 구성 요소는 (1) 어텐션 기반 세그멘터로, 입력 시계열을 연속적인 구간으로 자동 분할하면서 각 구간에 대한 가중치를 학습한다. 이 과정에서 연속성 제약(Lipschitz regularization)을 도입해 구간 경계가 급격히 변하지 않도록 한다. (2) 인과 분리 디코더는 사전 학습된 인과 그래프(예: PC 알고리즘이나 Granger causality 기반)를 마스크로 활용해, 각 구간이 어떤 인과 요인에 의해 설명되는지를 명시적으로 분리한다. 이는 인과적 혼합(causal entanglement)을 방지하고, 도메인 전문가가 “이 패턴은 A 변수의 변화에 의해 주도된다”는 식의 직관적인 해석을 가능하게 한다. (3) **잠재 집계 손실(Latent Aggregation Loss)**은 추출된 구간 표현을 고차원 잠재 공간에 매핑한 뒤, 같은 인과 요인에 속하는 구간은 서로 가깝게, 다른 요인에 속하는 구간은 멀게 배치하도록 강제한다. 이는 표현의 **분리성(separability)**과 **안정성(stability)**을 동시에 확보한다.

이론적 분석에서는 (i) 설명 함수가 시간에 대해 Lipschitz 연속성을 갖는 것을 정리하고, (ii) 인과 마스크가 약간 변했을 때 설명 오차가 상한을 갖는 bounded error 특성을 증명한다. 이러한 특성은 실시간 모니터링 시스템에서 설명이 급격히 변하지 않아 사용자가 신뢰를 유지할 수 있게 한다. 또한, 잠재 공간의 안정성 향상은 동일한 패턴이 다양한 시점에 재현될 때 일관된 설명을 제공한다는 점에서 실용적이다.

실험 결과는 두 가지 축에서 EXCAP의 우수성을 입증한다. 첫째, 예측 정확도 측면에서 기존 XAI 기반 모델(예: LIME‑Time, Temporal SHAP)보다 2~4%p 향상된 성능을 보였다. 둘째, 해석 가능성은 정량적 지표(예: Faithfulness Score, Continuity Metric)와 정성적 사용자 설문을 통해 검증했으며, 특히 의료 데이터셋(MIMIC‑III)에서는 전문가가 제시한 임상 패턴과 높은 일치도를 보였다. 마지막으로, 모델의 스케일러빌리티를 확인하기 위해 1년치 초고해상도 센서 데이터(10⁶ 시점)에도 동일한 설명 품질을 유지함을 확인했다.

요약하면, EXCAP은 “패턴 중심·인과 분리·시간 연속·추론 충실”이라는 네 가지 핵심 요구를 수학적으로 보장하면서, 실제 도메인에서 활용 가능한 직관적인 설명을 제공한다. 이는 장기 시계열 모델이 단순히 블랙박스가 아니라, 인간 전문가와 협업할 수 있는 신뢰할 수 있는 의사결정 도구로 전환되는 중요한 발걸음이라 할 수 있다.

📄 논문 본문 발췌 (Translation)

📸 추가 이미지 갤러리