단일 확률 전파와 코드 생성으로 가속화된 베이지안 신경망

📝 원문 정보

- Title: Accelerated Execution of Bayesian Neural Networks using a Single Probabilistic Forward Pass and Code Generation

- ArXiv ID: 2511.23440

- 발행일: 2025-11-28

- 저자: Bernhard Klein, Falk Selker, Hendrik Borras, Sophie Steger, Franz Pernkopf, Holger Fröning

📝 초록 (Abstract)

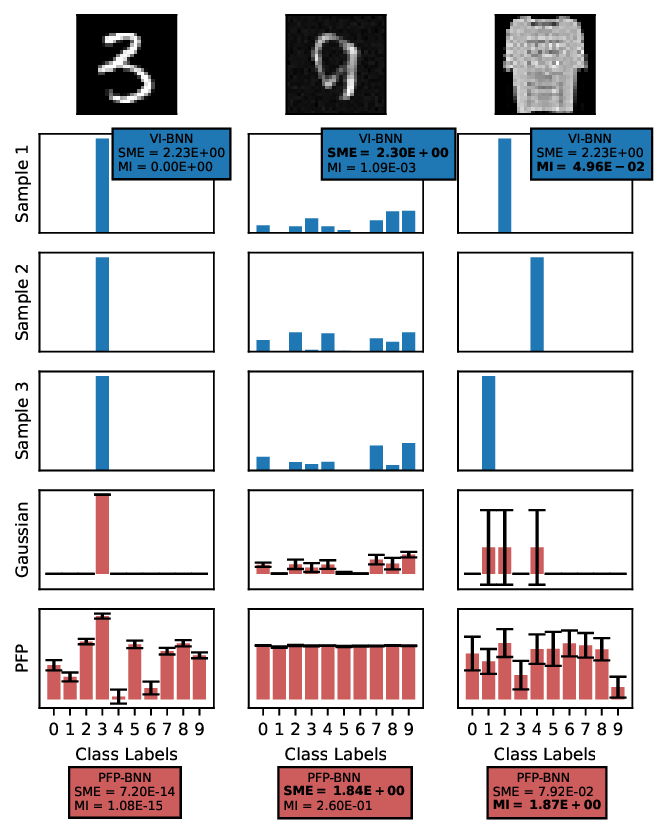

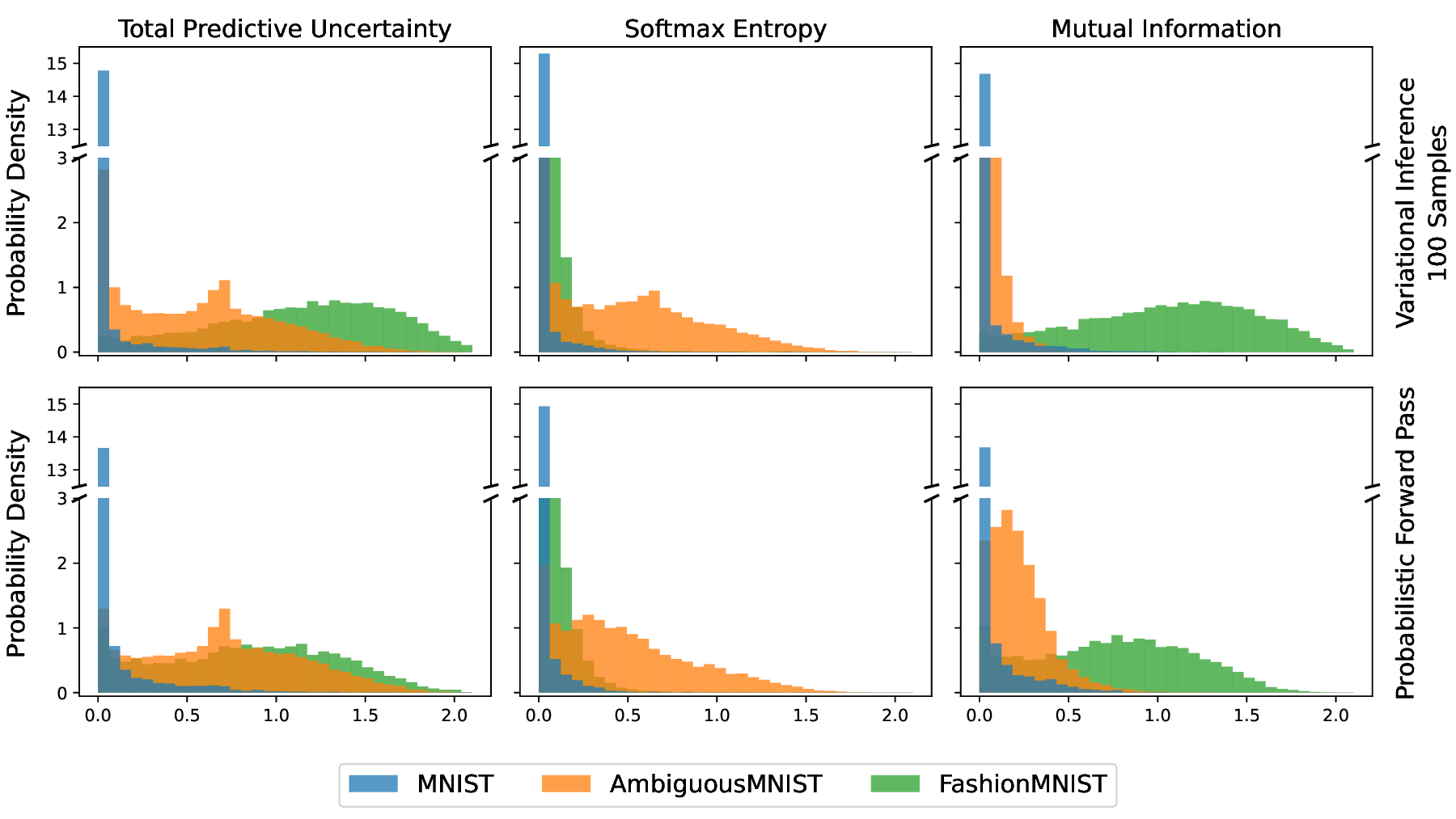

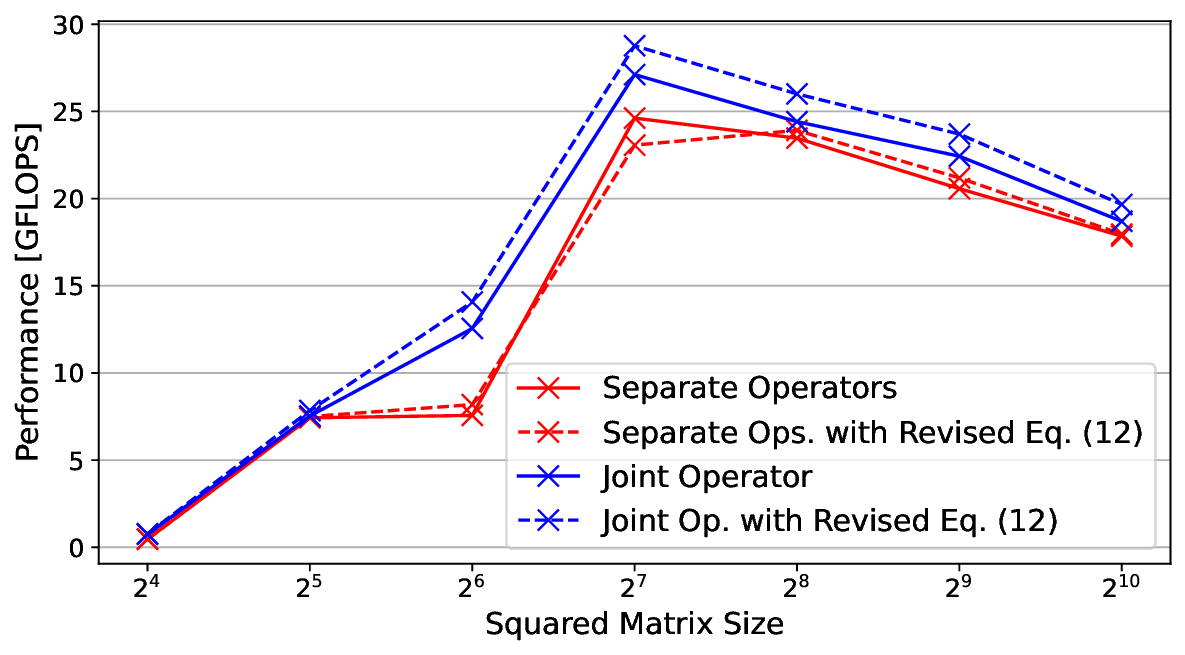

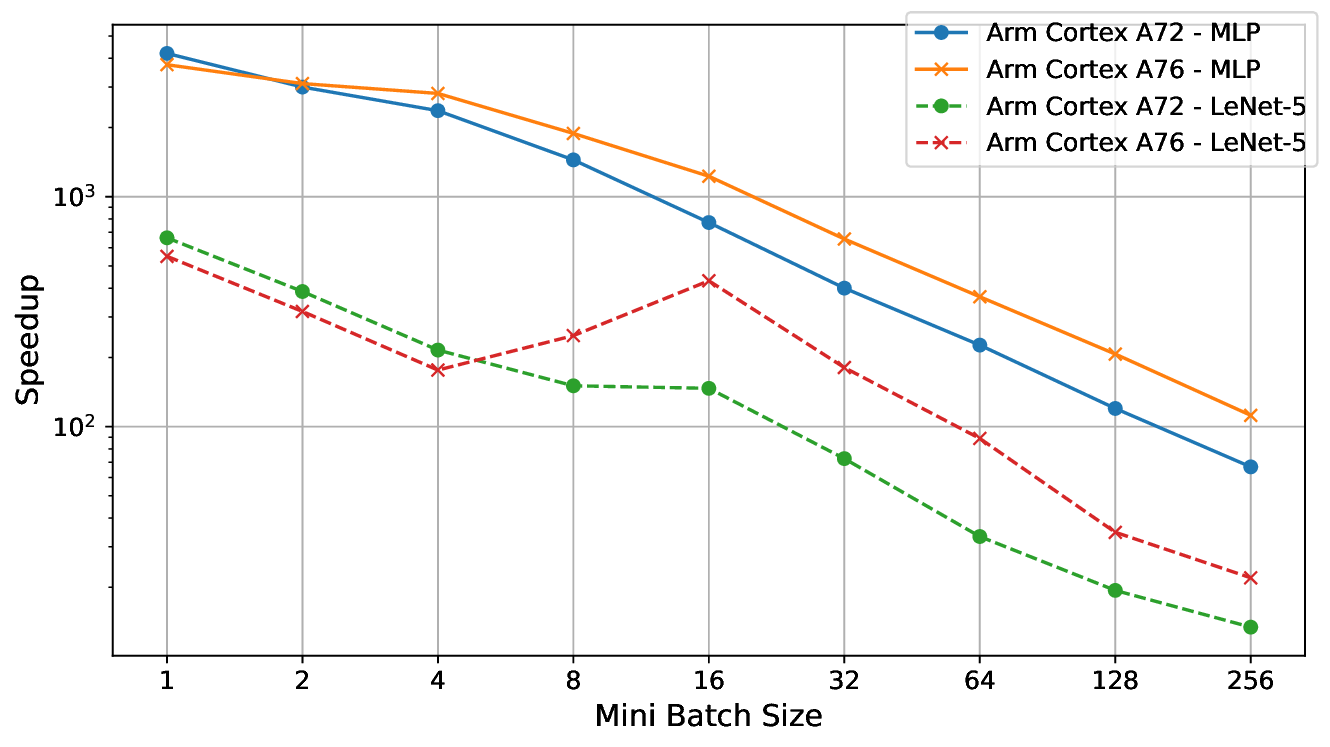

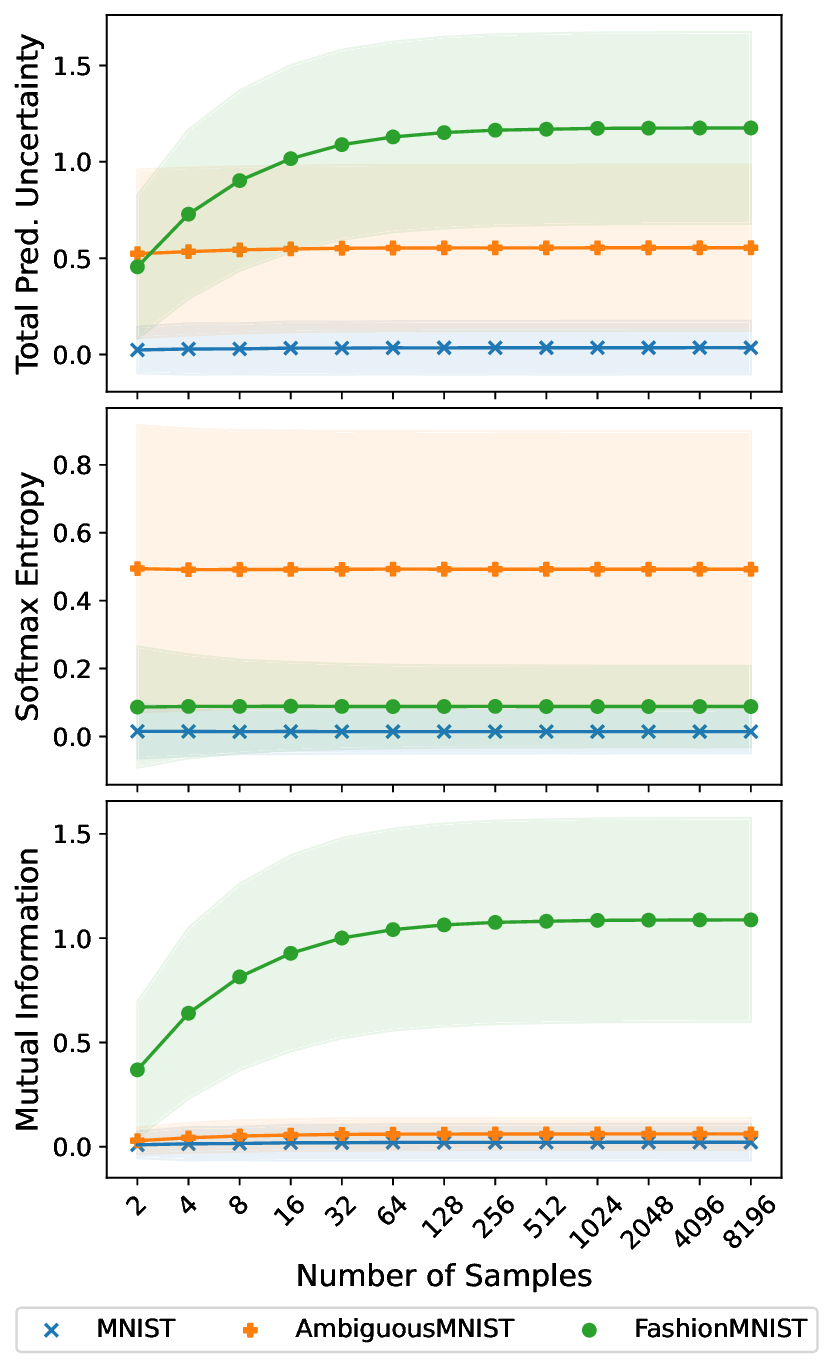

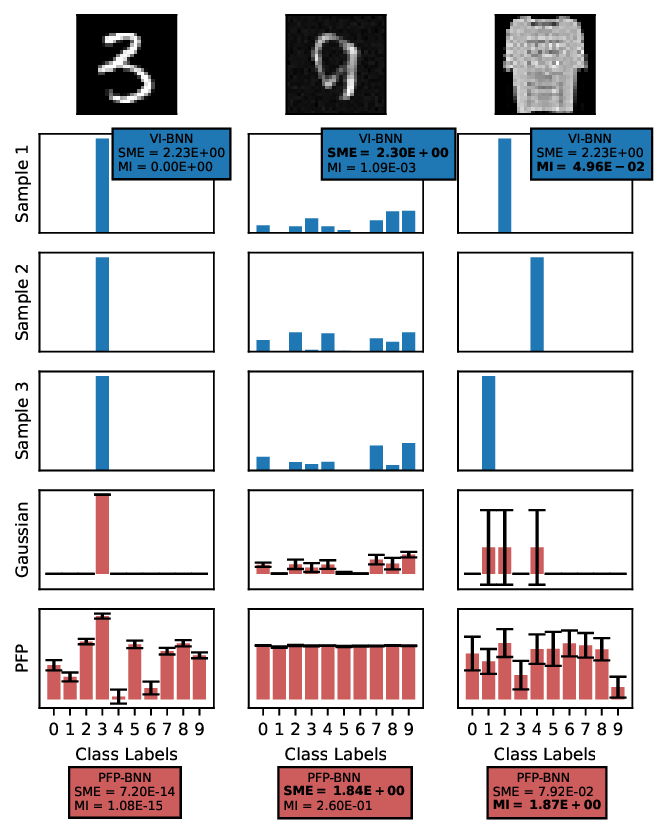

** 머신러닝 모델은 의료 진단, 날씨 예보, 자연어 처리, 자율 주행 등 다양한 분야에서 뛰어난 성능을 보이지만, 불확실성 처리 능력이 부족해 안전‑중요 응용에 한계가 있다. 기존 신경망은 영역 외(OOD) 데이터를 인식하지 못하고, 잘못된 예측을 내놓으며 불확실성을 표시하지 않는다. 베이지안 신경망(BNN)은 예측과 함께 통계적으로 근거 있는 확률을 제공함으로써 불확실성 추정을 가능하게 하지만, 가중치 분포에 대한 샘플링과 다중 전방 패스가 필요해 연산 비용이 크게 증가한다. 이를 해결하기 위해 확률 전방 패스(PFP)를 제안한다. PFP는 확률 변분 추론(SVI)의 극단적 근사로, SVI가 가중치에만 가우시안 가정을 두는 반면, PFP는 활성화에도 동일한 가정을 적용해 전파 과정을 완전히 해석적으로 수행한다. 따라서 다중 전방 패스를 하나의 복합 전방 패스로 대체할 수 있지만, 기존 딥러닝 라이브러리에는 없는 가우시안 전파 연산자가 필요하다. 본 연구는 임베디드 ARM CPU에서 PFP 기반 BNN을 학습·컴파일·최적화·배포하는 전 과정 파이프라인을 구축한다. 딥러닝 컴파일러 TVM에 맞춤 연산자를 구현해 다층 퍼셉트론과 합성곱 신경망을 지원하고, 여러 구현체와 수동·자동 튜닝 기법을 적용해 효율을 극대화한다. 실험 결과, 작은 미니배치(저지연) 상황에서 PFP는 SVI 대비 최대 4,200배의 속도 향상을 보이며, Dirty‑MNIST 데이터셋에서 정확도, 불확실성 정량화, OOD 탐지 측면에서 기존 SVI‑BNN과 동등한 성능을 유지한다. 이 연구는 베이지안 근사와 코드 생성·연산자 튜닝을 결합해 BNN 예측을 가속화하고, 자원 제한 임베디드 시스템에 효율적으로 배치할 수 있음을 입증한다.**

💡 논문 핵심 해설 (Deep Analysis)

이 논문은 베이지안 신경망(BNN)의 실용적 적용을 가로막는 핵심 장애물인 연산 비용 문제를 ‘확률 전방 패스(PFP)’라는 새로운 근사 기법으로 해결하려는 시도이다. 기존의 SVI(확률적 변분 추론)는 가중치에 대해 가우시안 분포를 가정하고, 각 입력에 대해 여러 샘플을 추출해 다중 전방 패스를 수행한다. 이 과정은 정확도와 불확실성 추정 측면에서는 강력하지만, 특히 임베디드 환경처럼 메모리와 연산량이 제한된 플랫폼에서는 현실적인 선택이 아니다.

PFP는 SVI의 가정 범위를 활성화까지 확장한다. 즉, 각 레이어의 출력도 가우시안으로 모델링하고, 선형 연산과 비선형 활성화 함수에 대해 가우시안 전파 규칙을 해석적으로 도출한다. 결과적으로 ‘샘플링·다중 전방 패스’ 대신 ‘단일 복합 전방 패스’를 수행하게 되며, 이는 확률적 연산자를 지원하는 컴파일러가 필요함을 의미한다. 저자는 TVM이라는 오픈소스 딥러닝 컴파일러에 맞춤형 연산자를 구현함으로써 이 문제를 해결한다.

TVM은 고수준 연산 그래프를 다양한 하드웨어에 맞게 최적화된 저수준 코드로 변환하는 프레임워크이다. 논문에서는 MLP와 CNN에 대한 가우시안 전파 연산자를 여러 버전(예: 루프 전개, SIMD 활용, 메모리 재배치)으로 구현하고, 수동 튜닝과 TVM의 자동 튜닝(AutoTVM) 기능을 병행해 최적의 스케줄을 찾았다. 이러한 다중 구현체와 튜닝 전략은 ARM Cortex‑A 시리즈와 같은 저전력 CPU에서 메모리 대역폭과 연산 파이프라인을 효율적으로 활용하도록 설계되었다.

실험은 Dirty‑MNIST(노이즈와 오염이 섞인 MNIST 변형) 데이터셋을 사용해 수행되었다. PFP 기반 BNN은 정확도와 기대 엔트로피, 예측 신뢰도 측면에서 SVI‑BNN과 거의 차이가 없으며, 특히 OOD 탐지(노이즈 이미지와 원본 이미지 구분)에서도 동일한 ROC‑AUC를 기록했다. 가장 주목할 점은 미니배치 크기가 1~4와 같이 실시간 추론에 적합한 작은 규모일 때, PFP가 SVI 대비 4,200배까지 속도가 빨라졌다는 것이다. 이는 연산량이 O(N·S) (N: 입력 크기, S: 샘플 수)에서 O(N)으로 감소했기 때문이며, 메모리 접근 횟수와 캐시 미스도 크게 감소한다는 점과 일맥상통한다.

하지만 몇 가지 한계도 존재한다. 첫째, 가우시안 가정이 모든 활성화 함수에 정확히 적용되지는 않는다. ReLU와 같은 비선형 함수는 평균과 분산만으로 완전히 기술하기 어려워 근사 오차가 누적될 가능성이 있다. 둘째, 현재 구현은 MLP와 CNN에 국한되며, 트랜스포머와 같은 복합 구조에는 추가 연구가 필요하다. 셋째, PFP는 학습 단계에서는 기존 SVI와 동일한 비용을 요구하므로, 전체 파이프라인에서 이득을 보는 시점은 추론 단계에 한정된다.

종합하면, 이 연구는 베이지안 불확실성 추정을 실시간 임베디드 시스템에 적용할 수 있는 실용적인 길을 제시한다. 코드 생성과 연산자 튜닝을 결합한 접근법은 앞으로 다른 확률적 모델(예: 베이지안 딥러닝, 확률적 그래픽 모델)에도 확장 가능성이 크며, 안전‑중요 AI 분야에서 불확실성 기반 의사결정을 가속화하는 핵심 기술이 될 전망이다.

**

📄 논문 본문 발췌 (Translation)

📸 추가 이미지 갤러리