통신 효율적인 연방 딥러닝 비동기 모델 업데이트와 시간 가중치 집합

📝 원문 정보

- Title: Communication-Efficient Federated Deep Learning with Asynchronous Model Update and Temporally Weighted Aggregation- ArXiv ID: 1903.07424

- 발행일: 2020-08-31

- 저자: Yang Chen, Xiaoyan Sun, Yaochu Jin

📝 초록

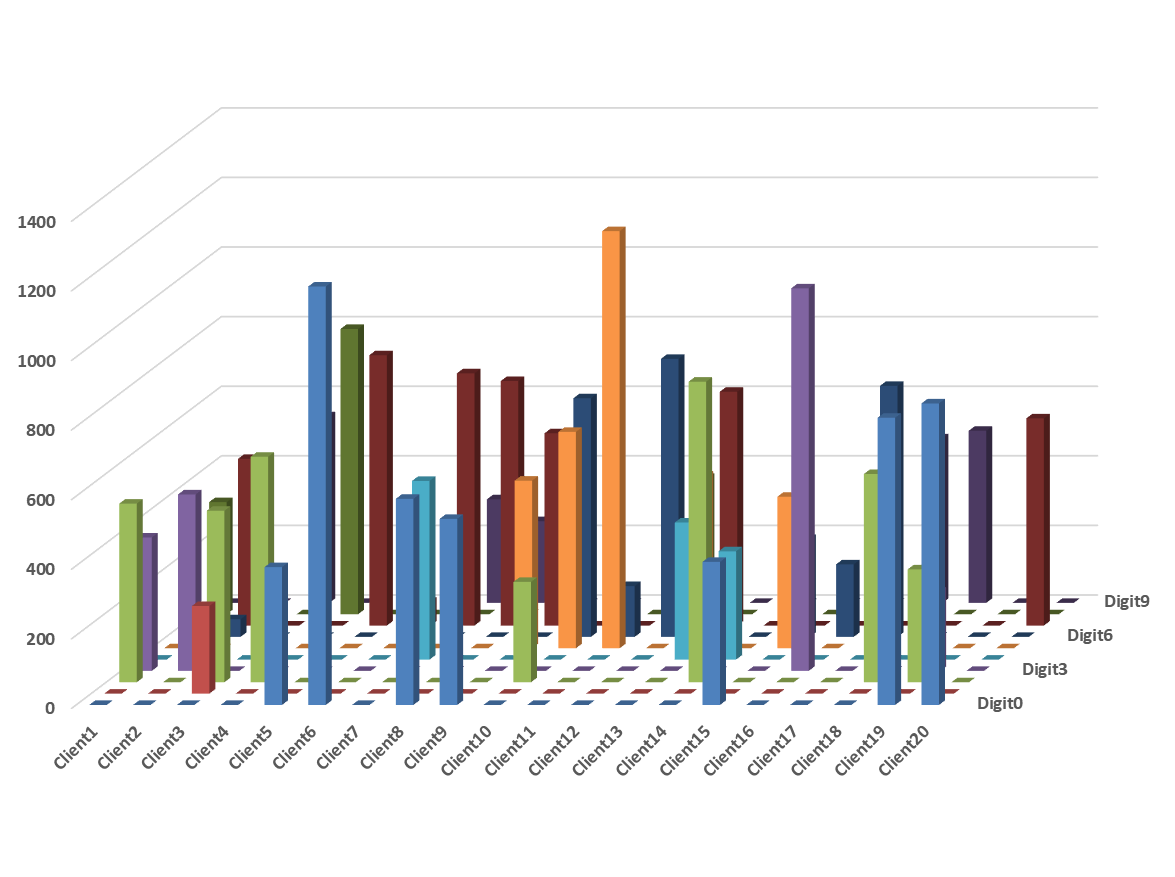

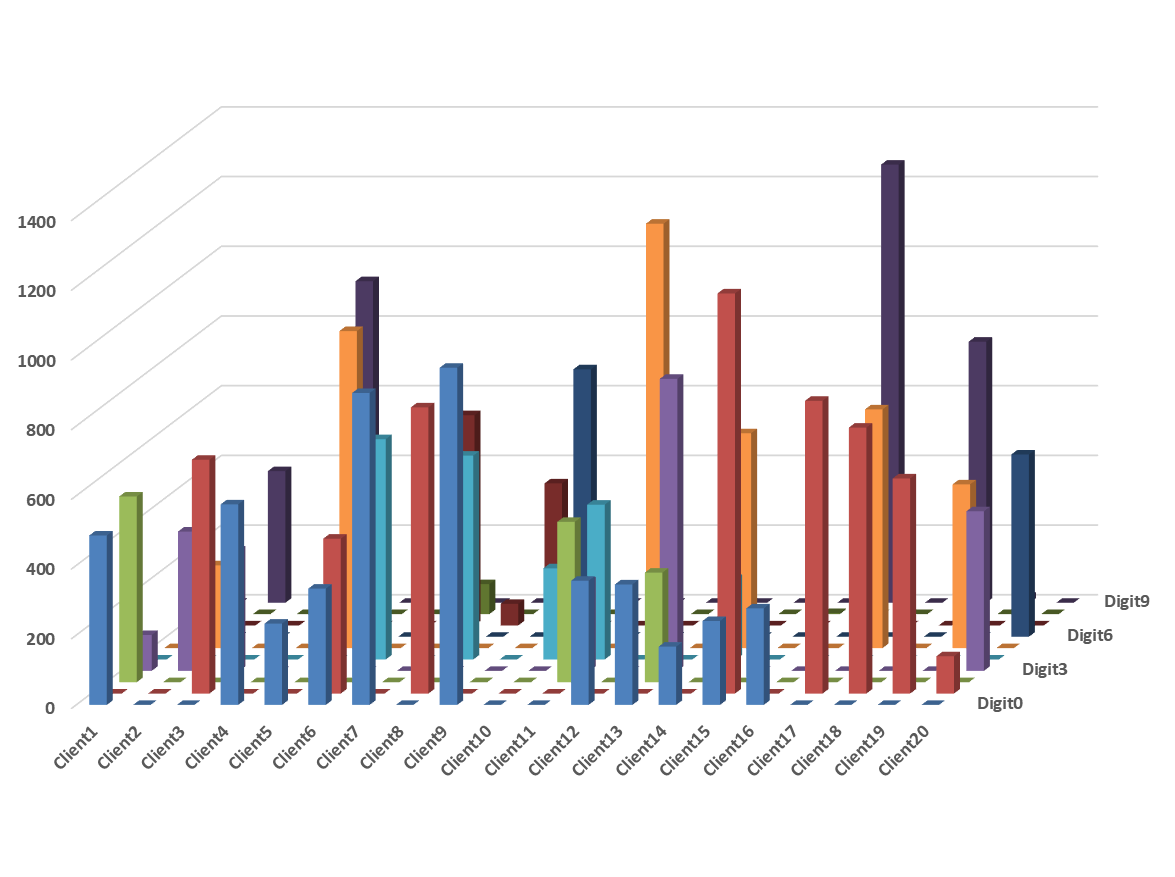

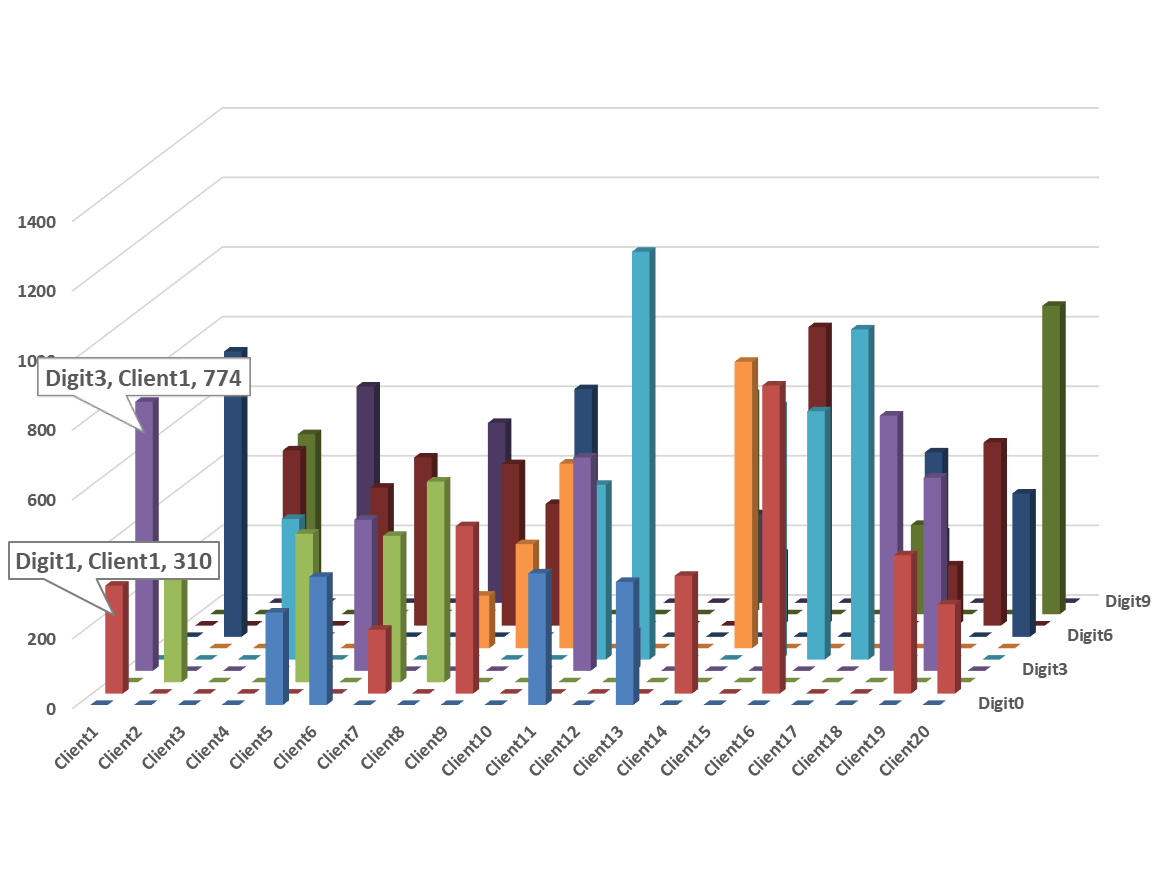

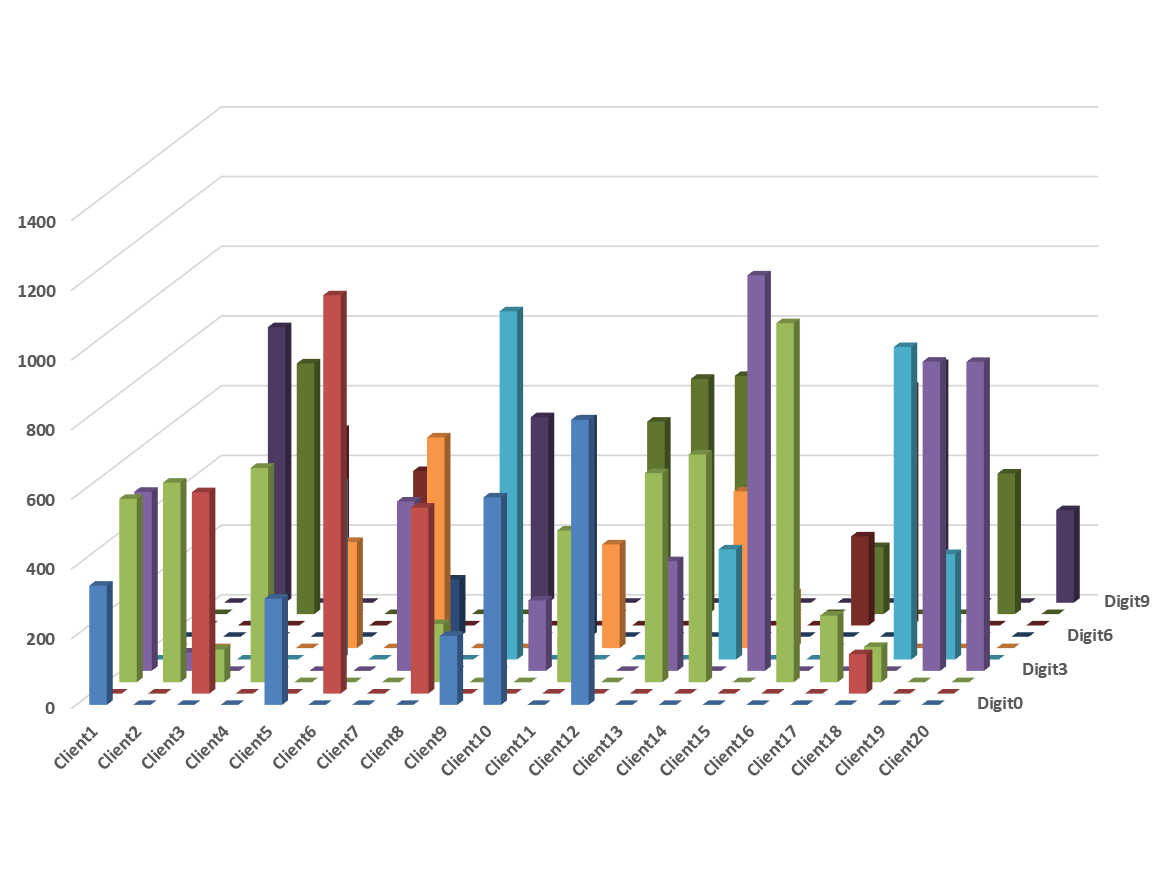

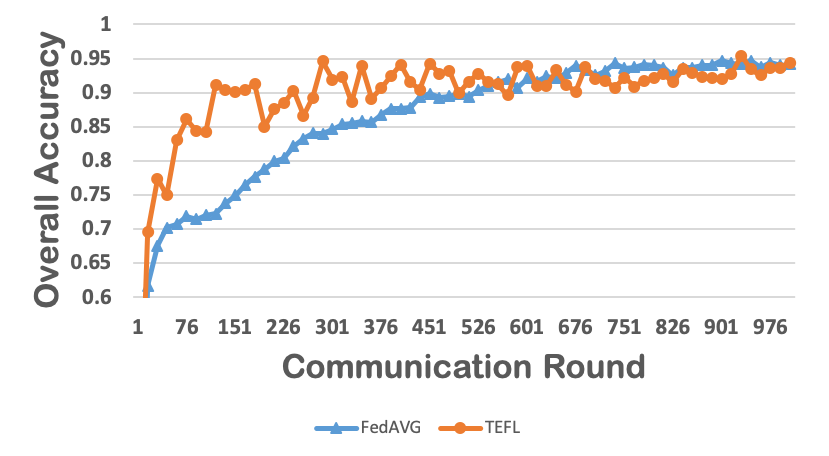

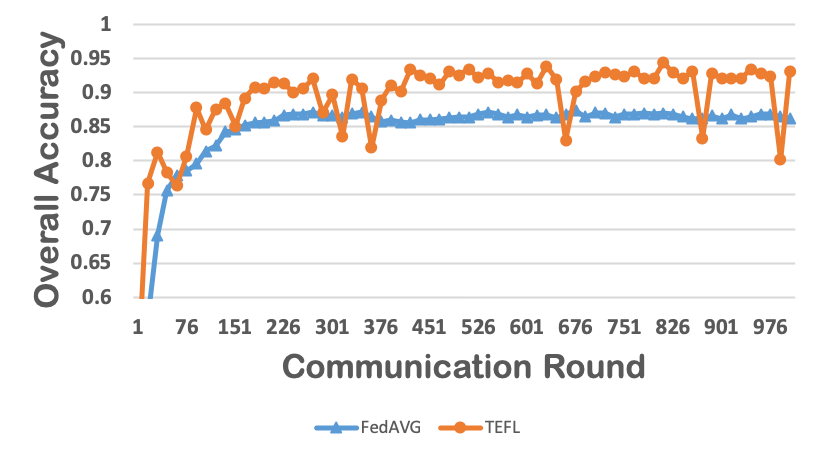

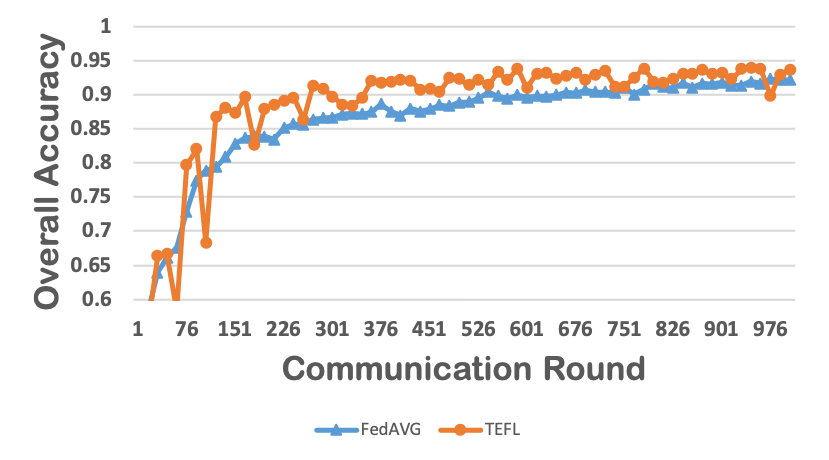

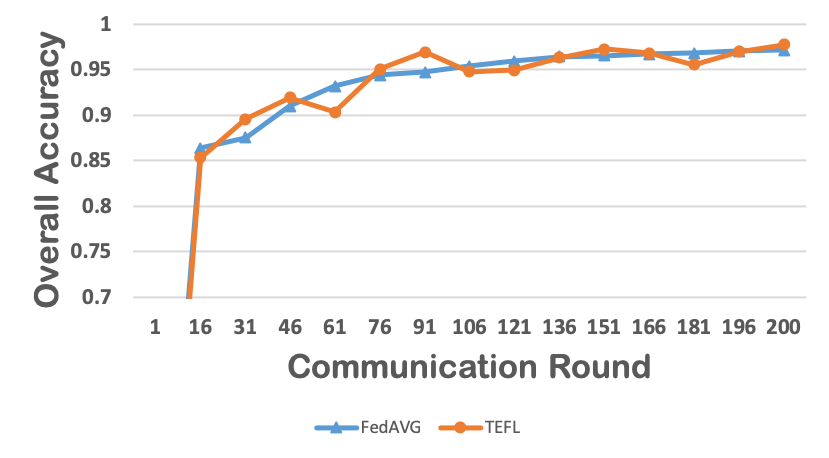

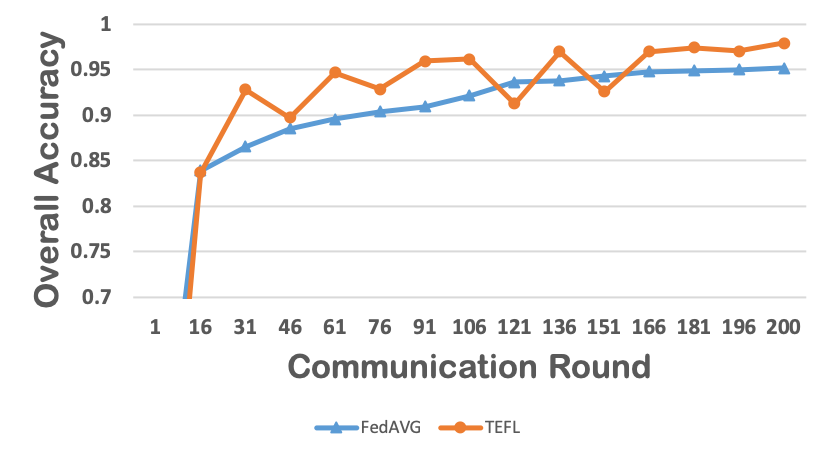

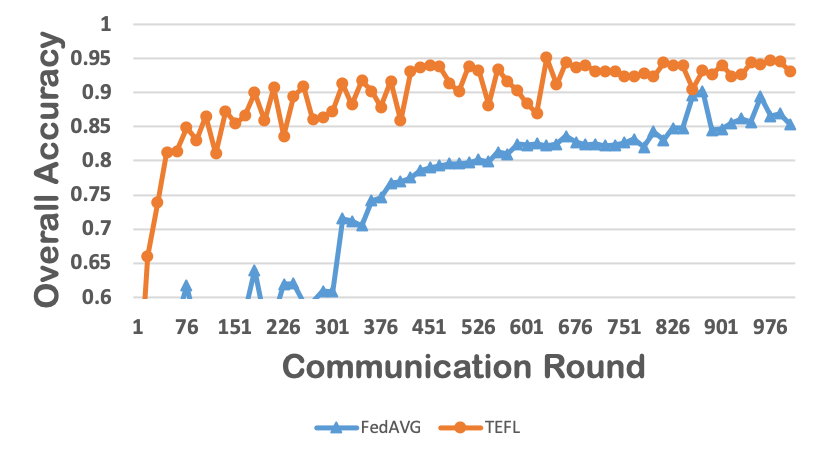

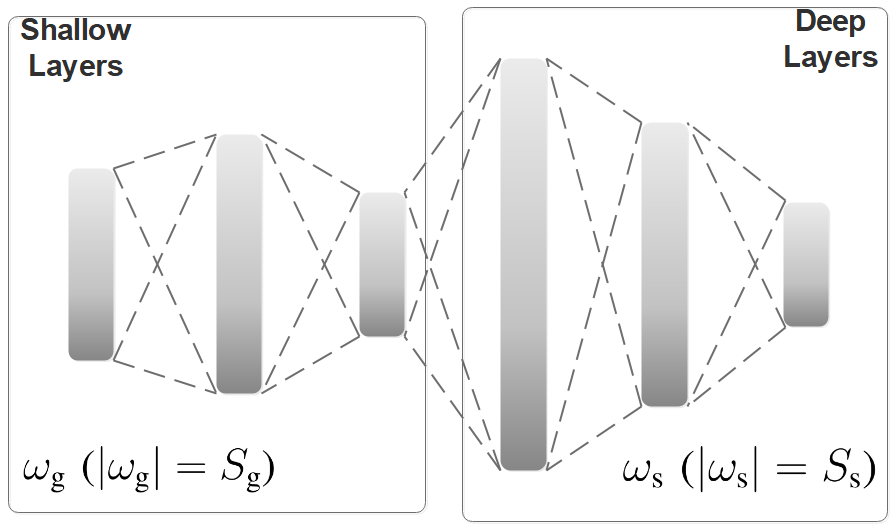

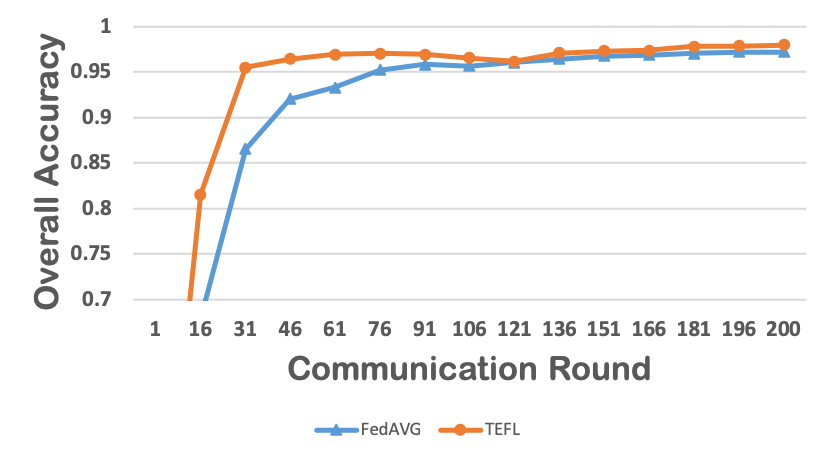

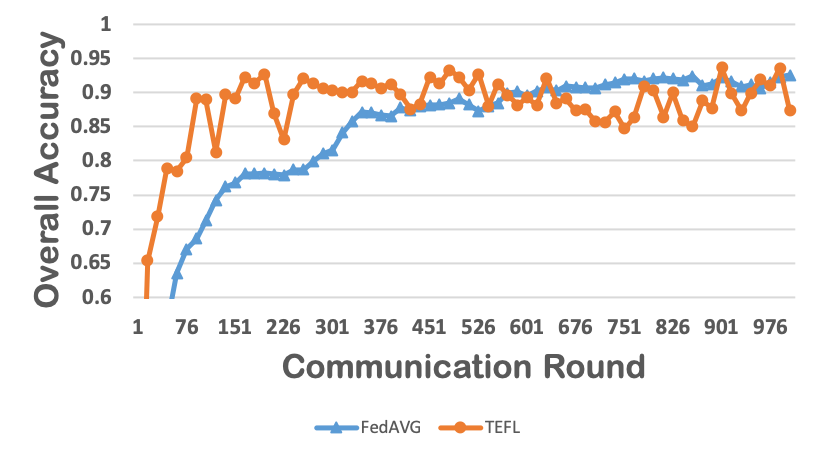

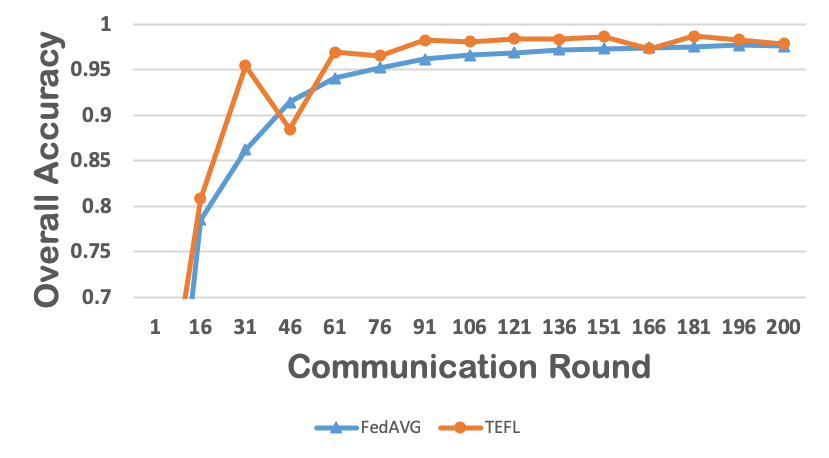

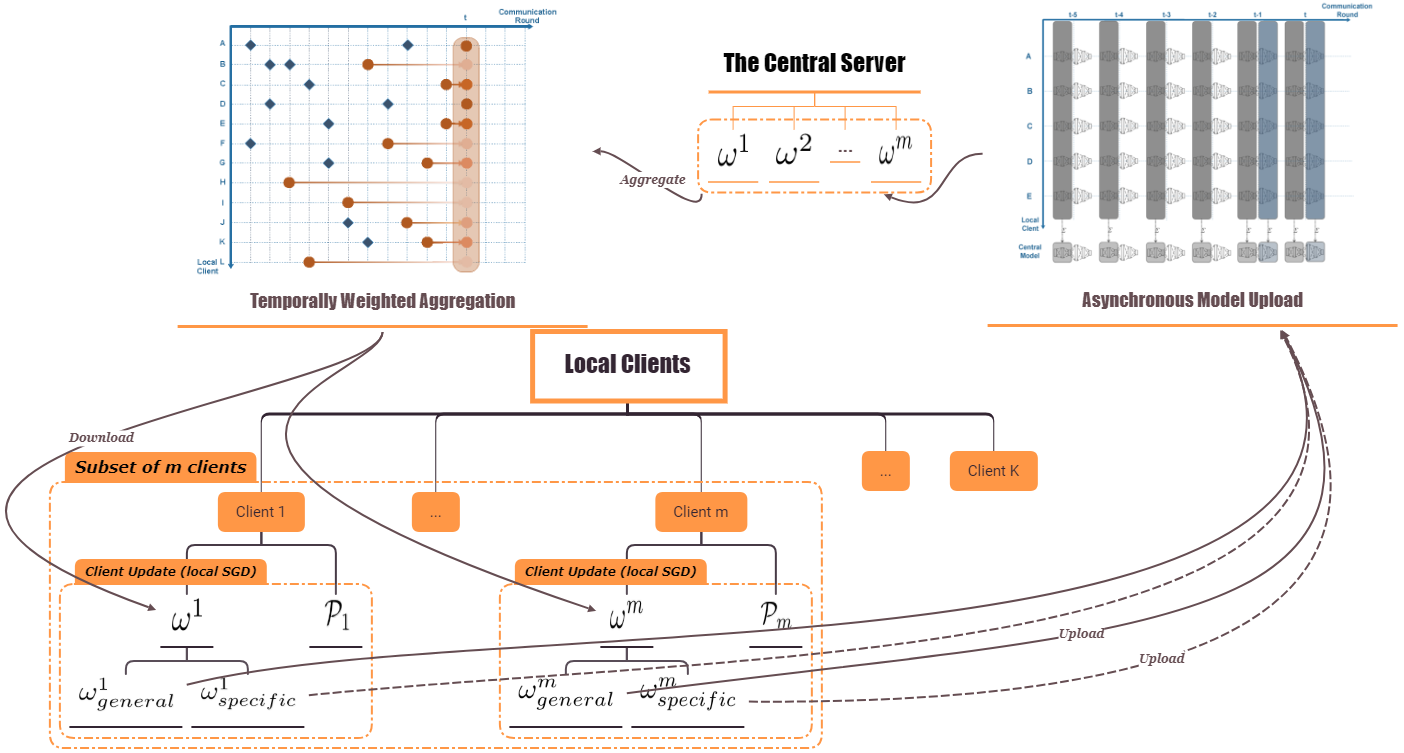

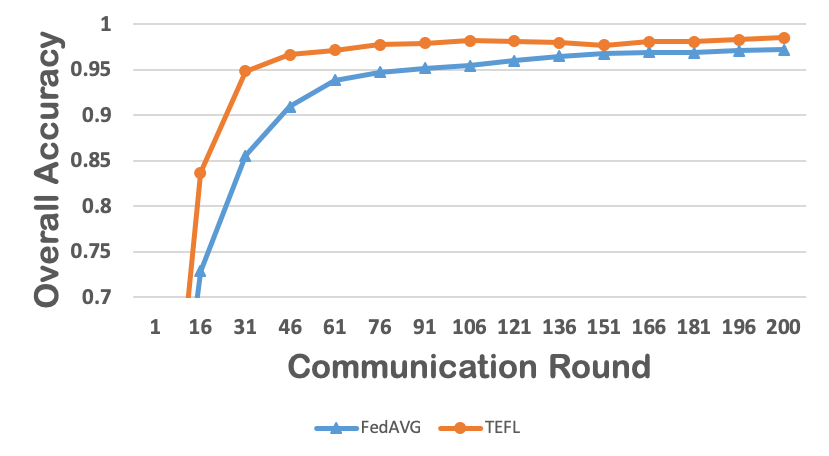

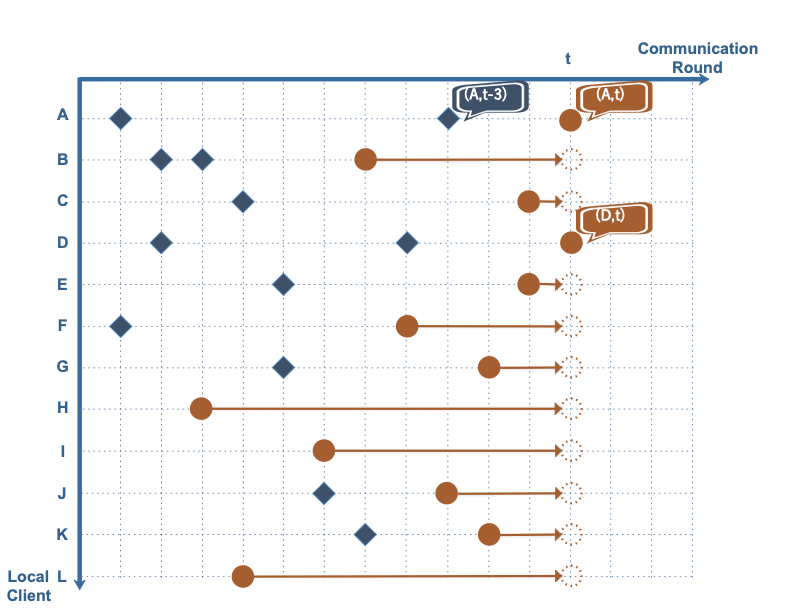

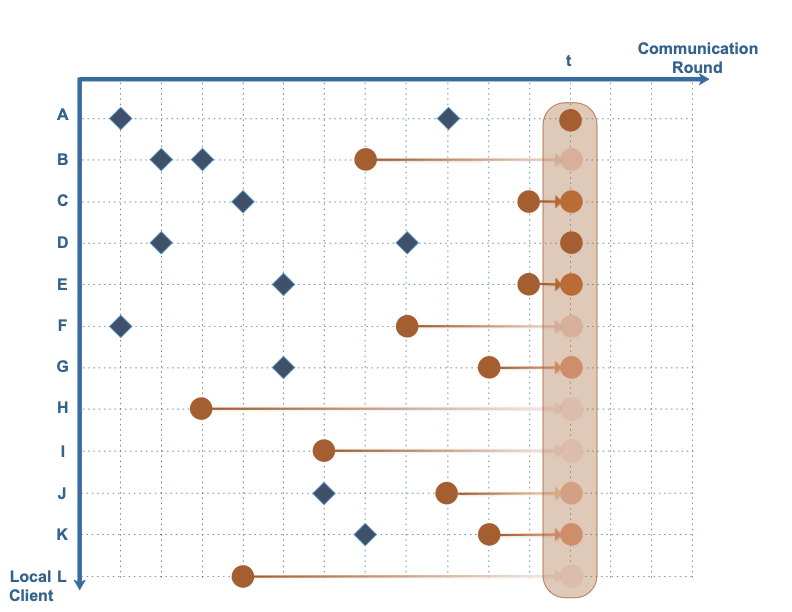

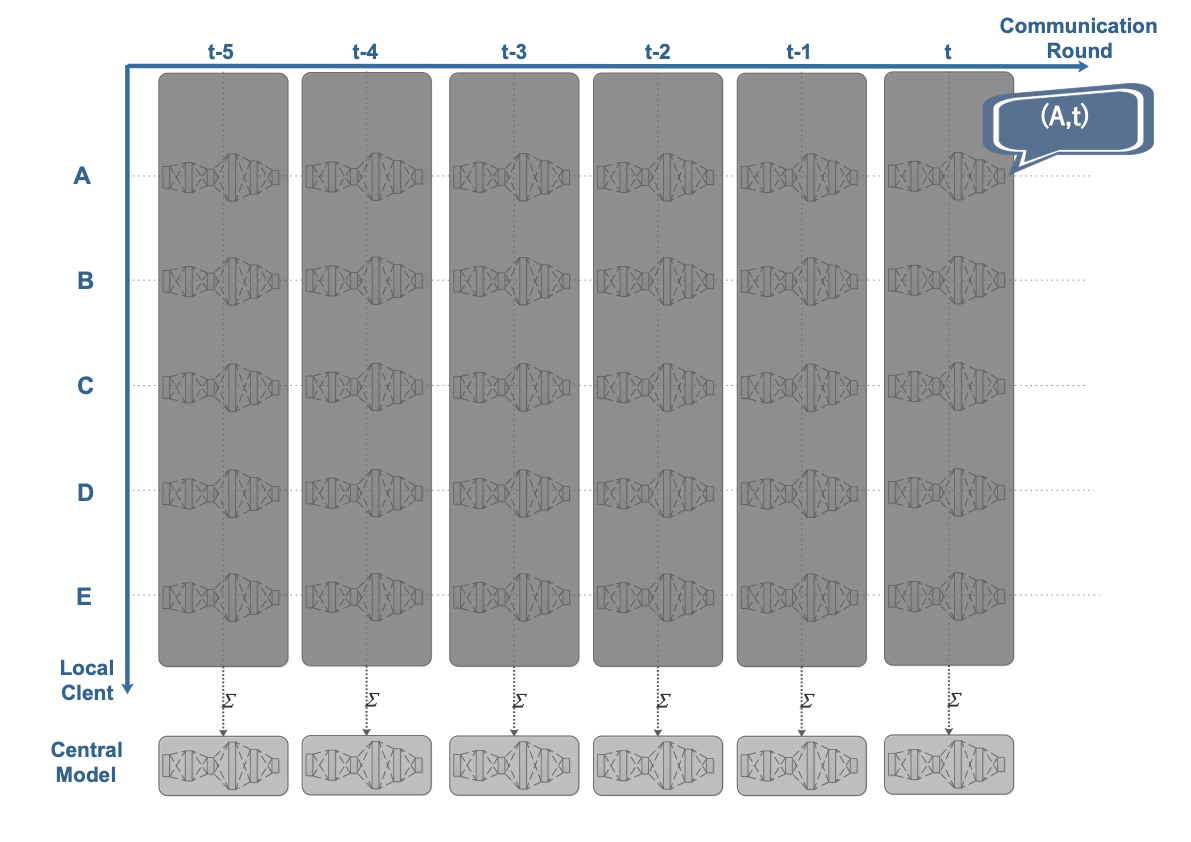

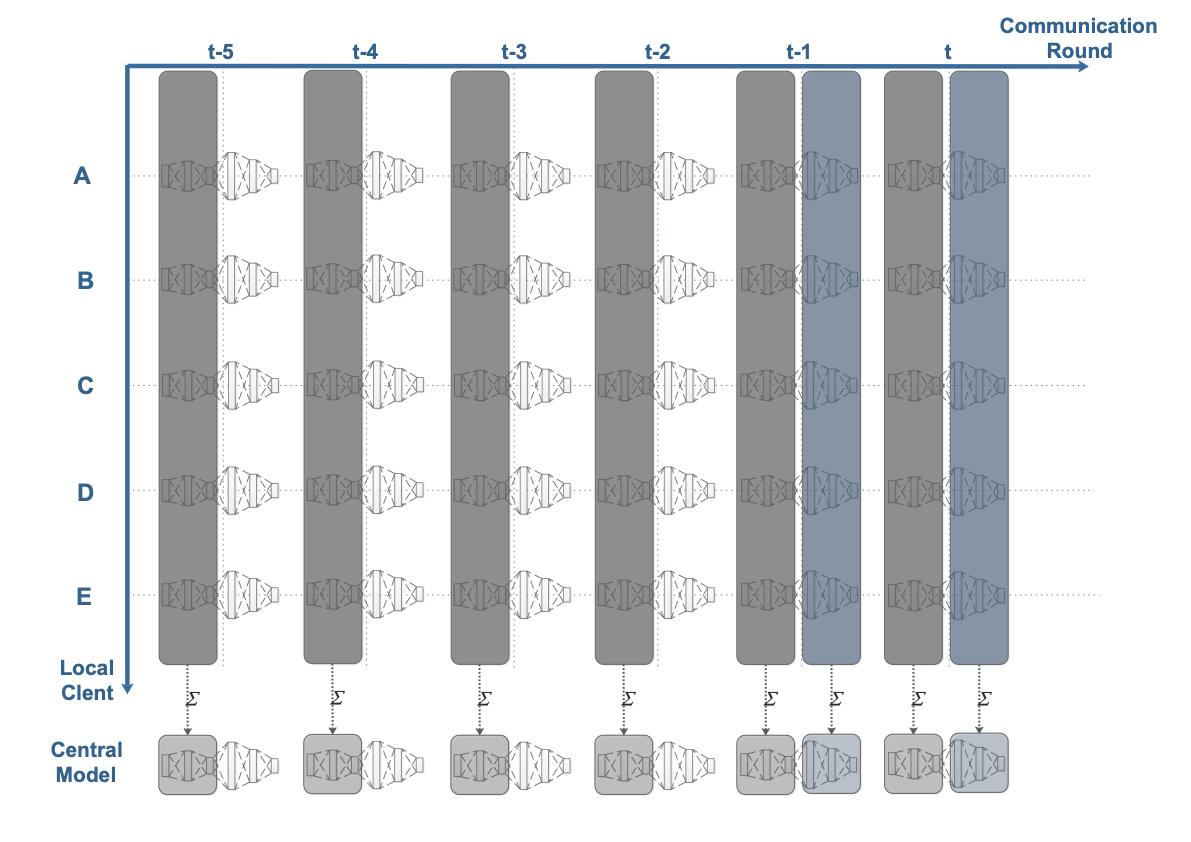

연방 학습은 클라이언트에서 로컬로 훈련된 모델을 집계하여 서버에 중앙 모델을 얻는다. 따라서 연방 학습은 클라이언트가 데이터를 서버에 업로드할 필요 없이 클라이언트의 데이터 프라이버시를 보호한다. 연방 학습에서 하나의 도전 과제는 클라이언트-서버 통신을 줄이는 것이다. 왜냐하면 종단 장치는 일반적으로 매우 제한적인 통신 대역폭을 가지고 있기 때문이다. 본 논문은 클라이언트에서 동기식 학습 전략을 사용하고 서버에서는 로컬 모델의 시간 가중 집계를 도입하여 개선된 연방 학습 기술을 제안한다. 비동기 학습 전략에서는 딥 뉴럴 네트워크의 서로 다른 계층이 얕은 계층과 깊은 계층으로 분류되며, 깊은 계층의 파라미터는 얕은 계층의 파라미터보다 덜 자주 업데이트된다. 또한 서버에서는 이전에 훈련된 로컬 모델을 활용하기 위해 시간 가중 집계 전략이 도입되어 중앙 모델의 정확도와 수렴성을 향상시킨다. 제안된 알고리즘은 두 가지 데이터셋과 다양한 딥 뉴럴 네트워크를 사용하여 실험적으로 평가된다. 우리의 결과는 제안된 비동기 연방 딥 학습이 통신 비용과 모델 정확도 측면에서 기준 알고리즘보다 우수함을 보여준다.💡 논문 해설

**핵심 요약**: 이 논문은 클라이언트와 서버 간의 통신 비용을 줄이면서 딥 뉴럴 네트워크를 훈련하는 방법에 대해 다룬다. 특히, 클라이언트에서 비동기 학습을 수행하고 서버에서는 시간 가중 집계를 통해 중앙 모델을 업데이트한다.문제 제기: 딥 뉴럴 네트워크의 훈련은 많은 데이터와 계산 리소스가 필요하며, 이를 클라우드 서버에서 수행하면 클라이언트와 서버 간 통신 비용이 증가한다. 특히 모바일 기기나 IoT 장치는 제한된 통신 대역폭을 가지고 있어 이 문제가 더욱 심각하다.

해결 방안 (핵심 기술): 이 논문은 클라이언트에서 비동기 학습을 수행하고 서버에서는 시간 가중 집계를 통해 중앙 모델을 업데이트하는 방법을 제안한다. 비동기 학습 전략에서는 딥 뉴럴 네트워크의 계층이 얕은 계층과 깊은 계층으로 분류되며, 깊은 계층의 파라미터는 덜 자주 업데이트된다. 이 방법을 통해 클라이언트와 서버 간 통신 비용을 줄일 수 있다.

주요 성과: 제안된 알고리즘은 두 가지 데이터셋과 다양한 딥 뉴럴 네트워크를 사용하여 실험적으로 평가되었으며, 기준 알고리즘보다 통신 비용과 모델 정확도 측면에서 우수한 성능을 보였다.

의의 및 활용: 이 연구는 클라이언트와 서버 간 통신 비용을 줄이는 방법을 제시함으로써 딥 뉴럴 네트워크를 훈련하는 효율성을 크게 향상시키고, 특히 IoT 기기나 모바일 기기에 적합한 학습 방법론을 제공한다. 이를 통해 클라이언트의 데이터 프라이버시를 보호하면서도 효과적인 딥 러닝 모델을 구축할 수 있다.

📄 논문 발췌 (ArXiv Source)

📊 논문 시각자료 (Figures)