[한글 번역 중] An introduction to decentralized stochastic optimization with gradient tracking

📝 원문 정보

- Title: An introduction to decentralized stochastic optimization with gradient tracking- ArXiv ID: 1907.09648

- 발행일: 2019-11-14

- 저자: Ran Xin and Soummya Kar and Usman A. Khan

📝 초록

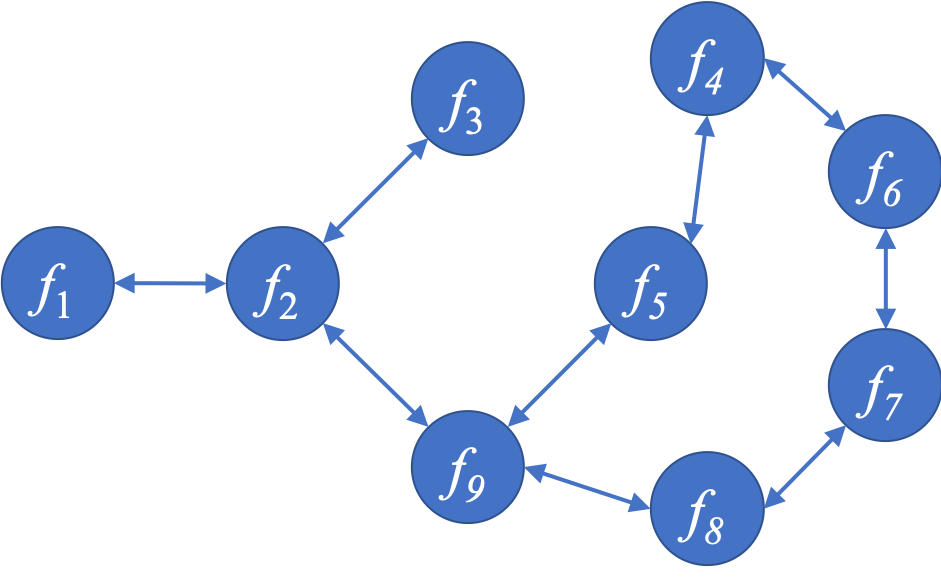

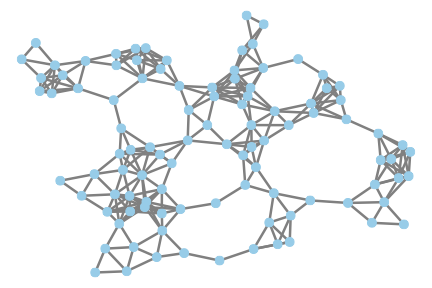

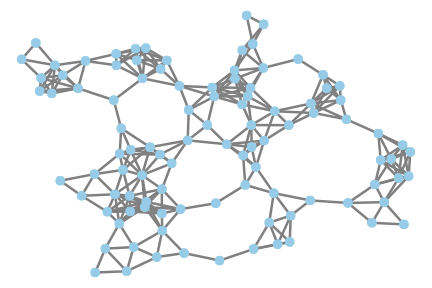

분산 최소화에 대한 분산해법은 신호 처리, 제어 및 머신 러닝 애플리케이션에서 중요한 역할을 합니다. 이러한 환경에서는 데이터가 임의로 연결된 노드 네트워크에 분포되어 있고 원시 데이터 공유는 통신이나 프라이버시 제약으로 인해 불가능한 경우가 많습니다. 본 논문에서는 분산 확률적 1차 최적화 방법을 검토하고, 최근의 개선 사항인 그래디언트 추적 및 변동 감소 기반의 개선사항에 대해 설명합니다. 특히 매끄럽고 강하게 볼록한 목적 함수에 초점을 맞추었습니다. 주요 기술적인 아이디어와 분산 머신 러닝 모델 학습에서 이러한 알고리즘의 적용 사례를 직관적으로 설명하였습니다.💡 논문 해설

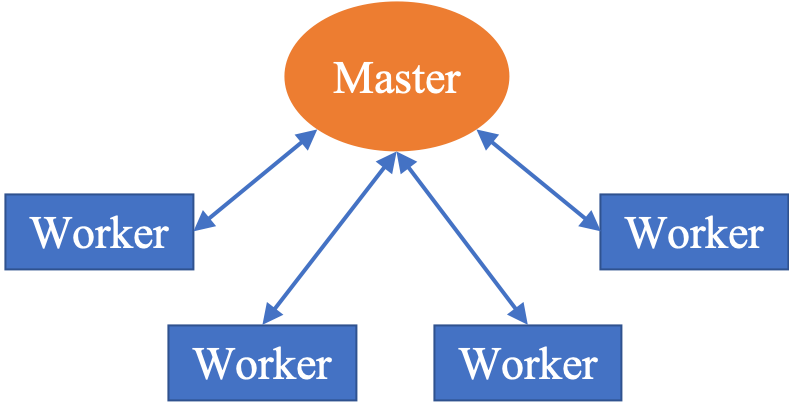

**핵심 요약**: 본 논문은 신호 처리, 제어 및 머신 러닝에 사용되는 분산 최적화 방법을 검토하고 있습니다. 특히 데이터가 네트워크의 노드에 분포되어 있는 상황에서 원시 데이터 공유가 불가능한 경우를 다룹니다.문제 제기: 기존의 중앙 집중식 학습 방식은 모든 데이터를 한 곳에 모아서 처리하는 것이 필요합니다. 그러나 실제 환경에서는 통신 비용이나 프라이버시 문제로 인해 원시 데이터를 공유할 수 없는 경우가 많습니다.

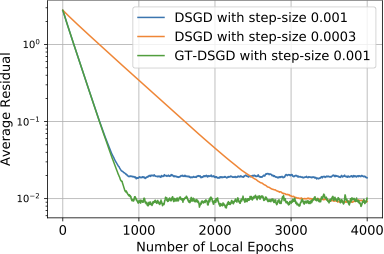

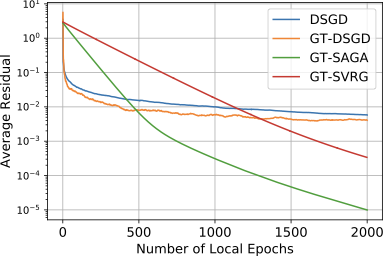

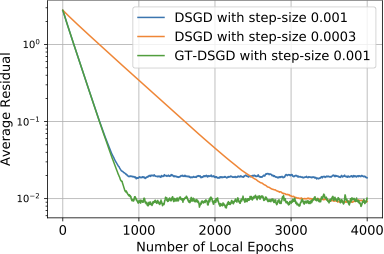

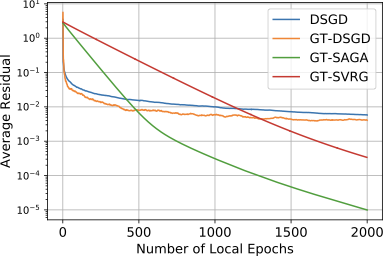

해결 방안 (핵심 기술): 이 논문은 그래디언트 추적과 변동 감소 기법을 사용한 분산 최적화 방법을 제시합니다. 각 노드는 자신의 데이터에 대해 그래디언트를 계산하고, 이를 통해 전체 그래디언트의 추정치를 업데이트하며, 이 과정에서 발생하는 변동을 줄이는 방식으로 효과적인 학습이 가능하도록 설계되었습니다.

주요 성과: 본 논문은 이러한 방법론을 통해 강하게 볼록한 목적 함수에 대한 최적화 문제를 효율적으로 해결할 수 있음을 보여주고 있습니다. 특히, 분산 학습 환경에서의 데이터 처리 및 통신 비용을 줄이는 데 성공하였습니다.

의의 및 활용: 이 연구는 분산 시스템에서 머신 러닝 모델을 효과적으로 학습하는 방법론을 제공함으로써, 실제 애플리케이션에서는 데이터 보안과 효율적인 통신이라는 두 가지 중요한 문제를 해결할 수 있습니다. 이를 통해 다양한 분야에서의 응용 가능성이 매우 넓어집니다.

📄 논문 발췌 (ArXiv Source)

📊 논문 시각자료 (Figures)