S&CNet: 자율 시스템과 3D 재구성 위한 단일 카메라 깊이 완성 네트워크

📝 원문 정보

- Title: S&CNet: Monocular Depth Completion for Autonomous Systems and 3D Reconstruction

- ArXiv ID: 1907.06071

- 발행일: 2019-08-30

- 저자: Lei Zhang, Weihai Chen, Chao Hu, Xingming Wu, Zhengguo Li

📝 초록 (Abstract)

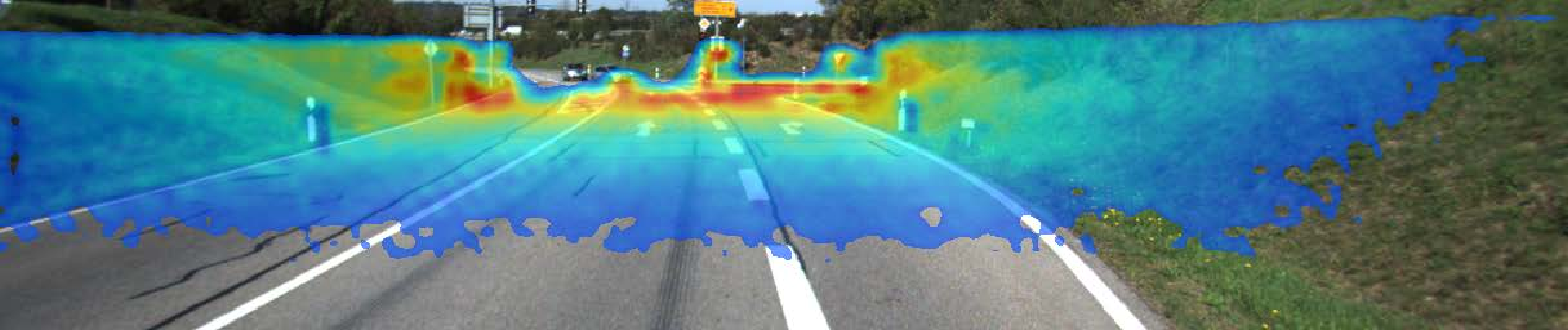

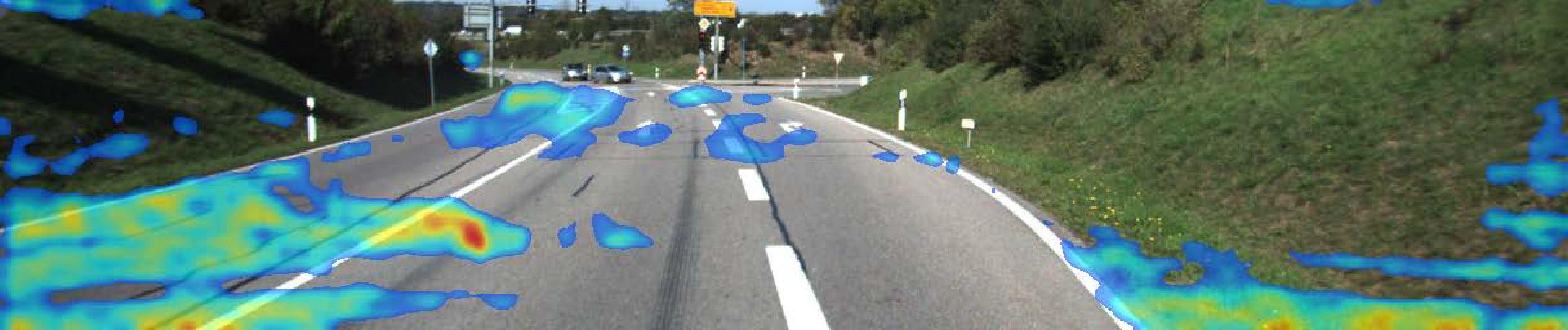

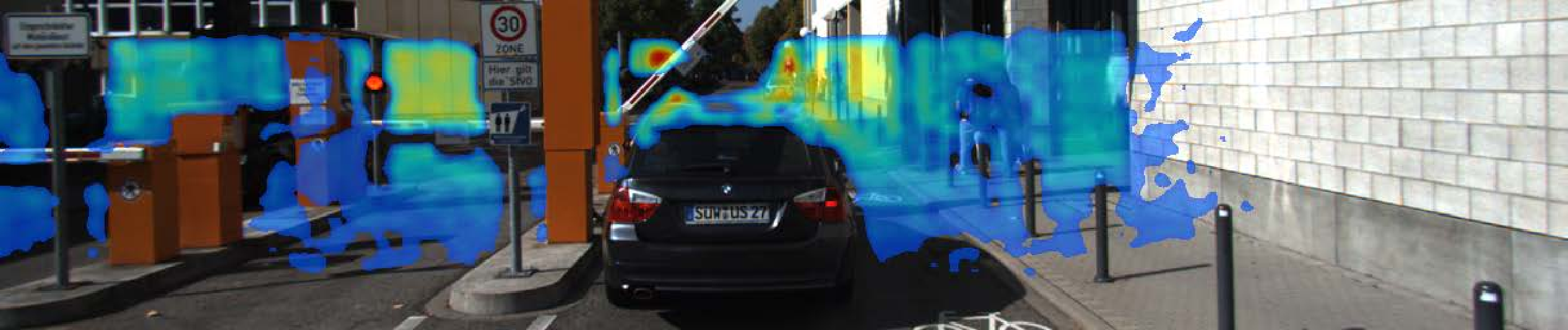

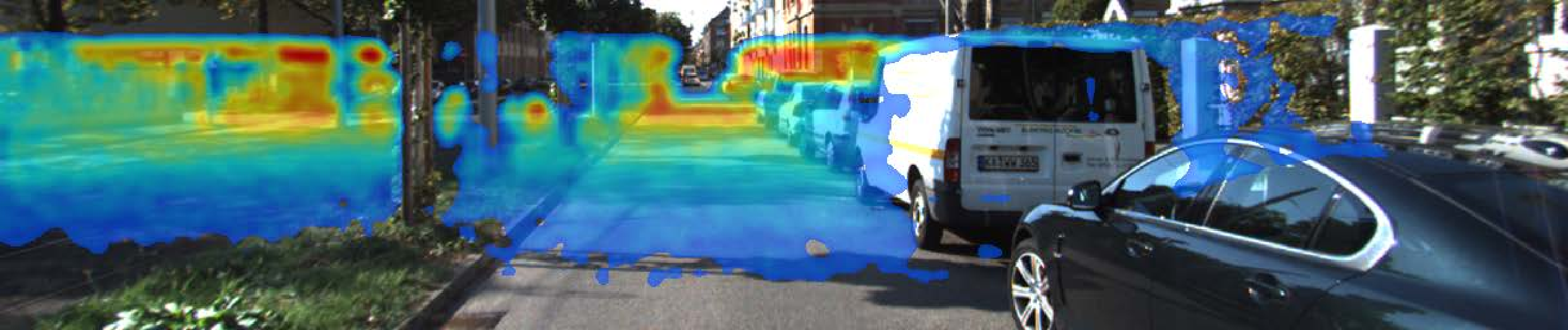

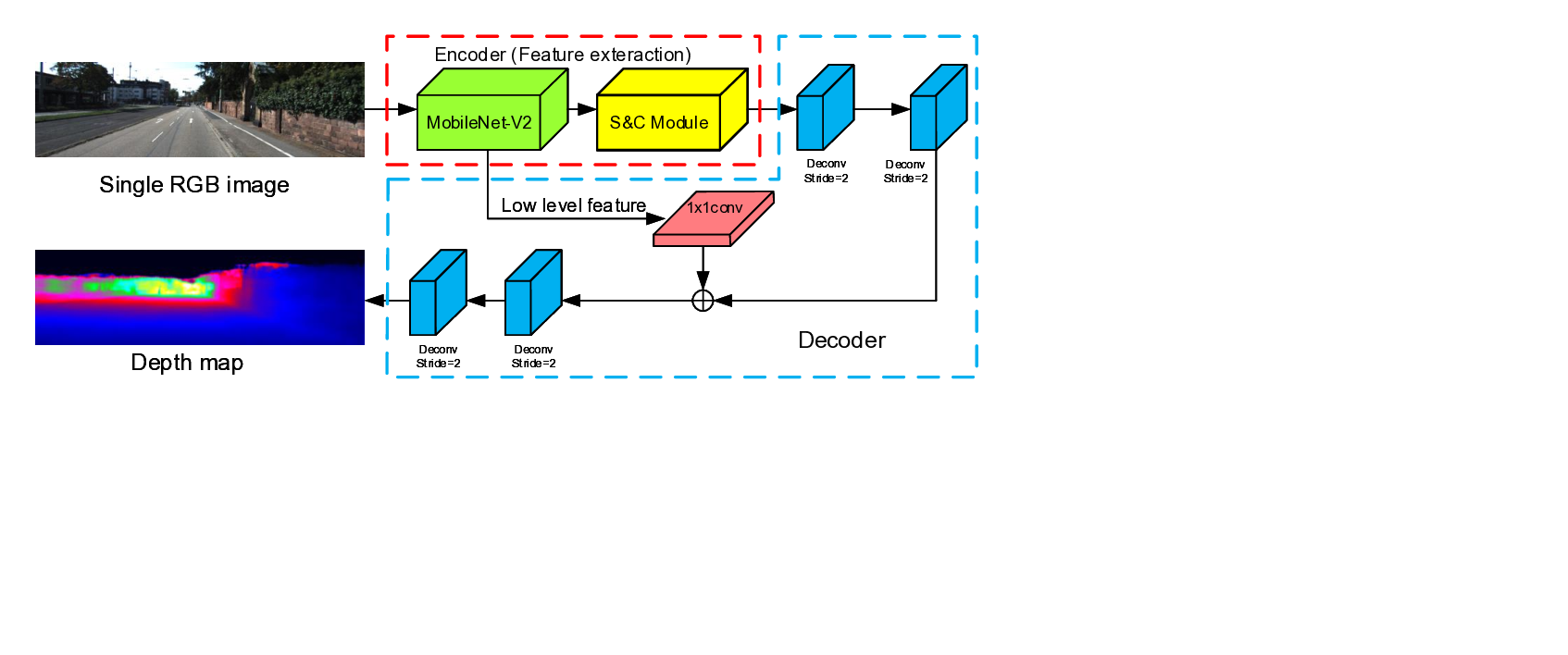

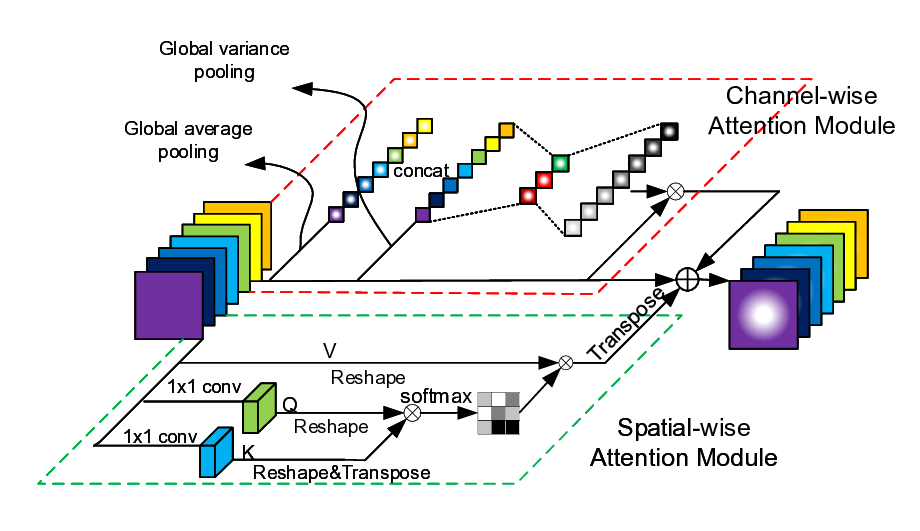

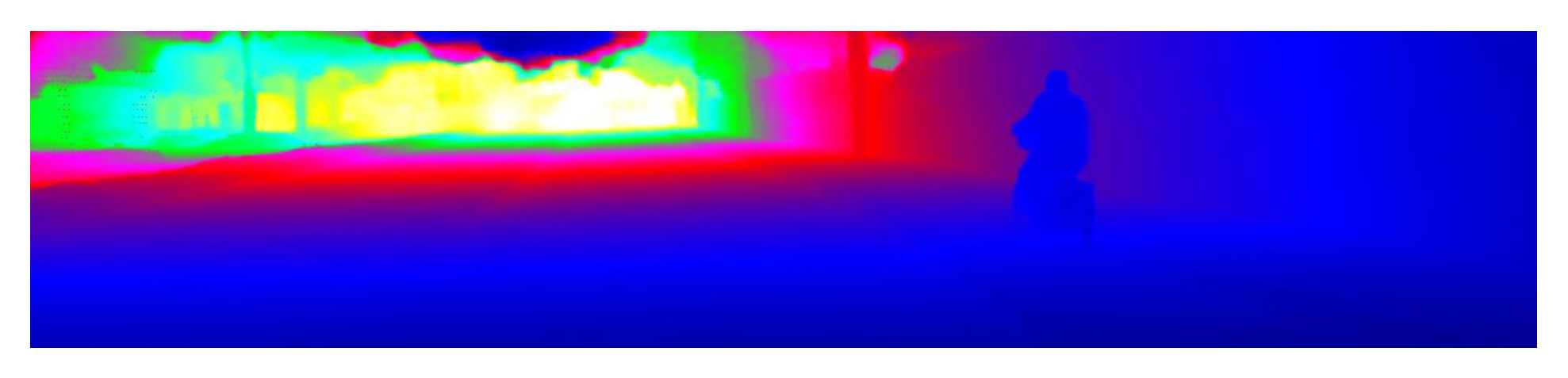

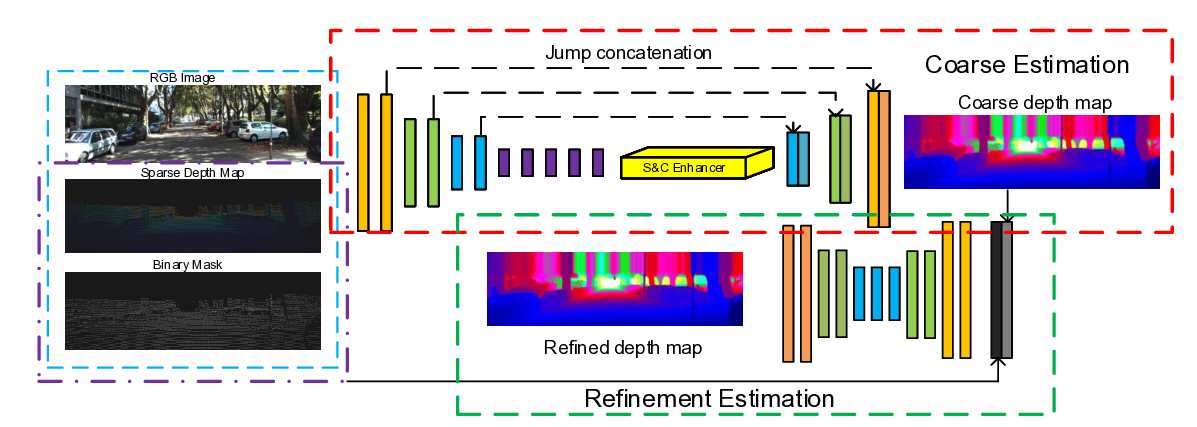

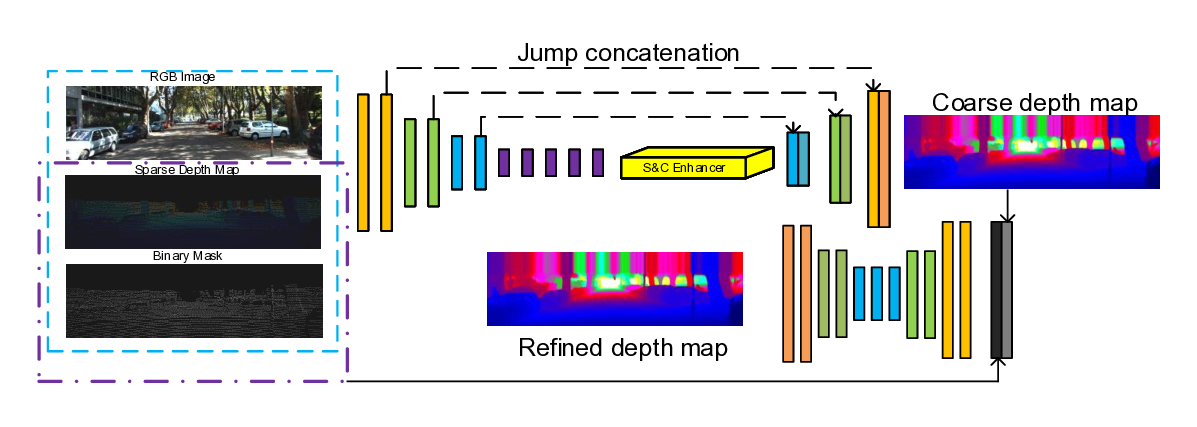

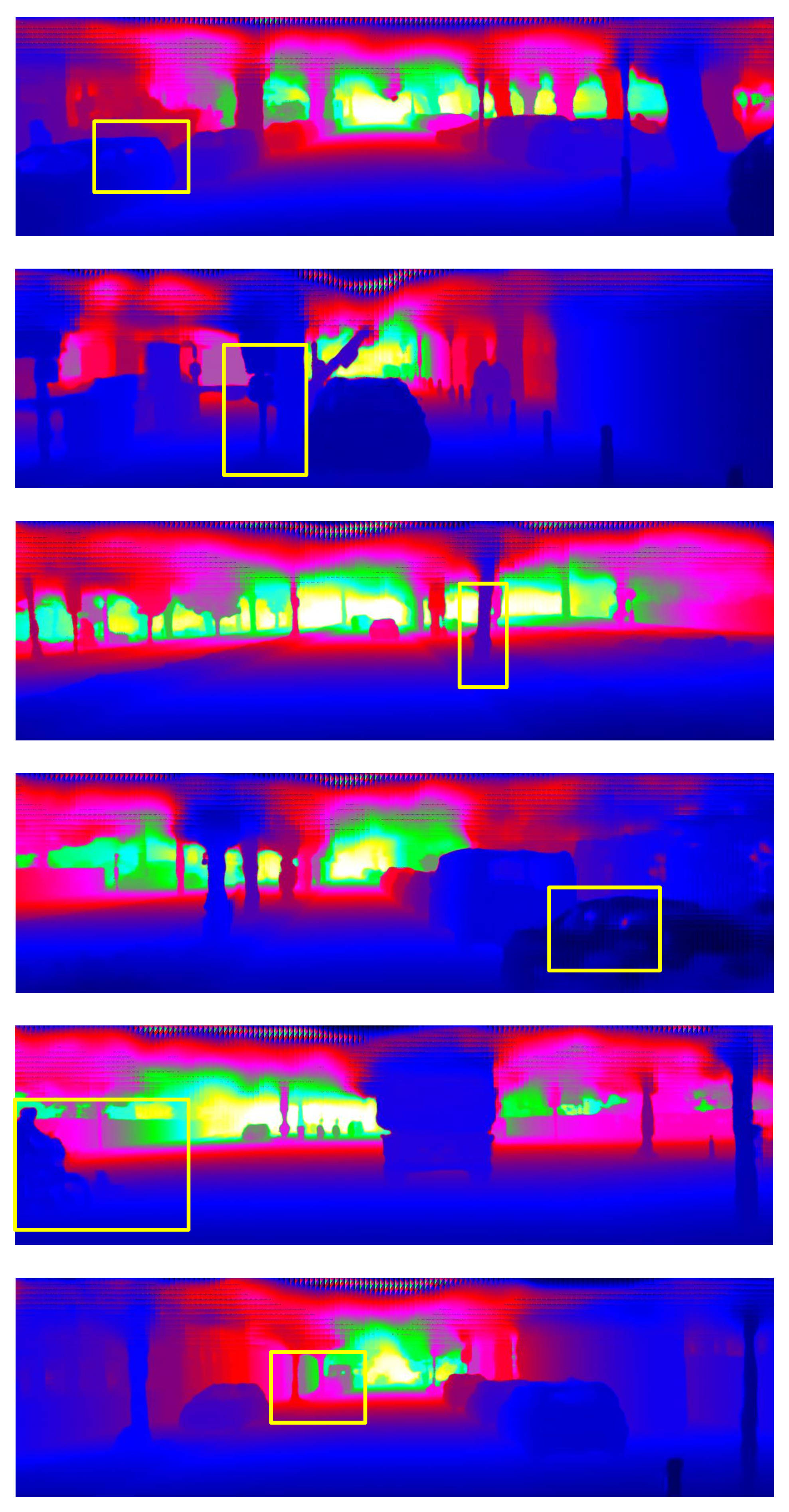

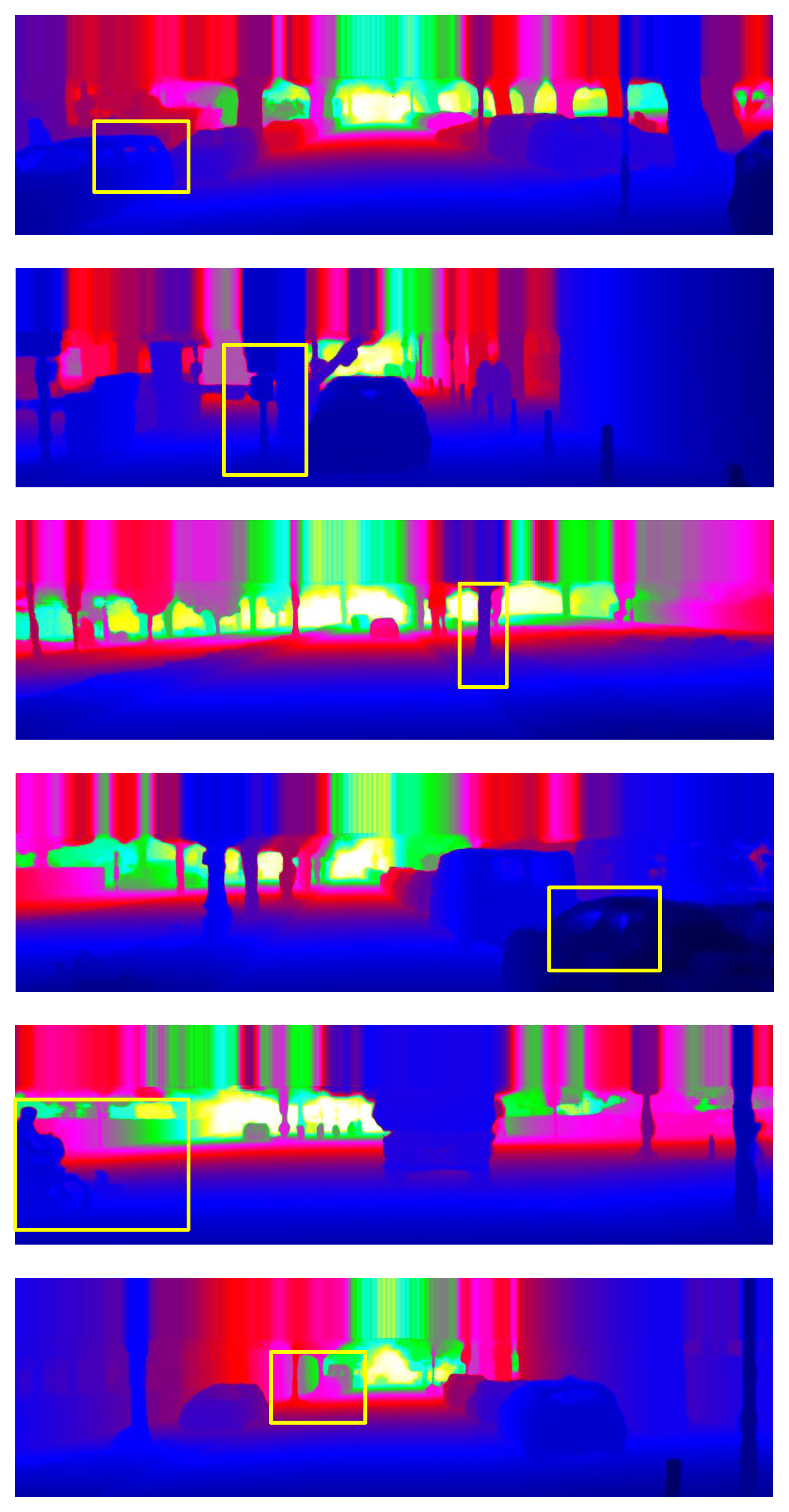

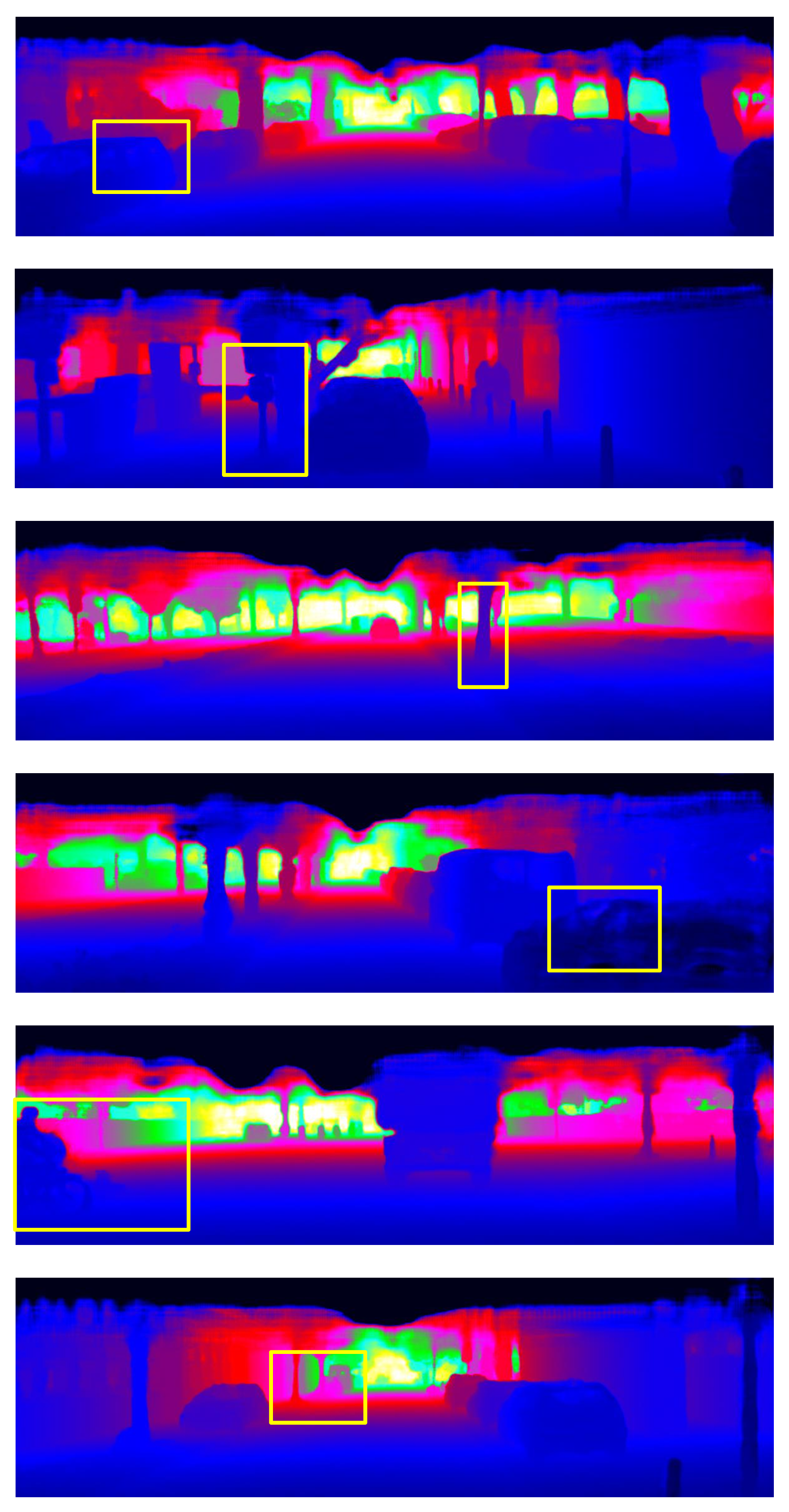

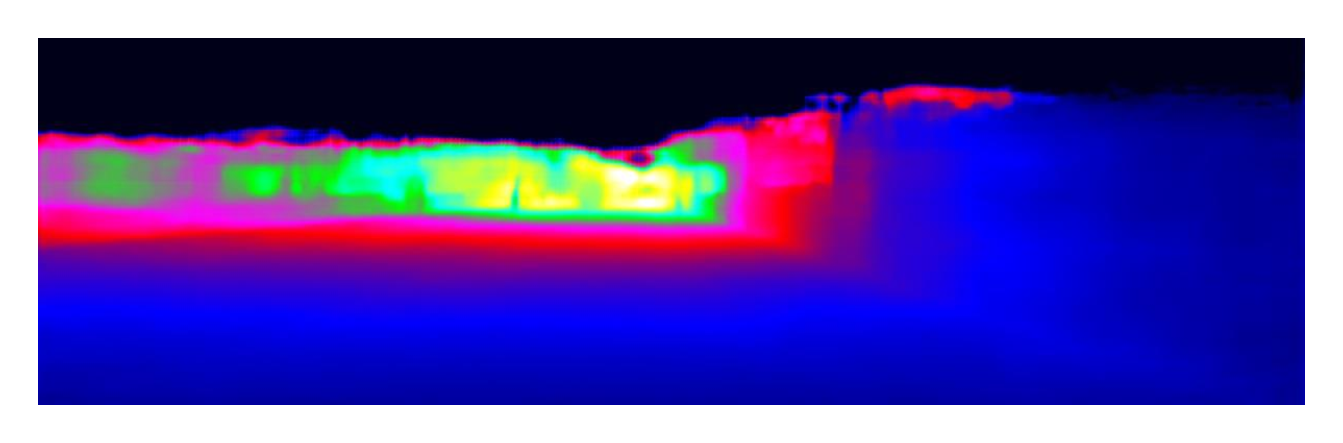

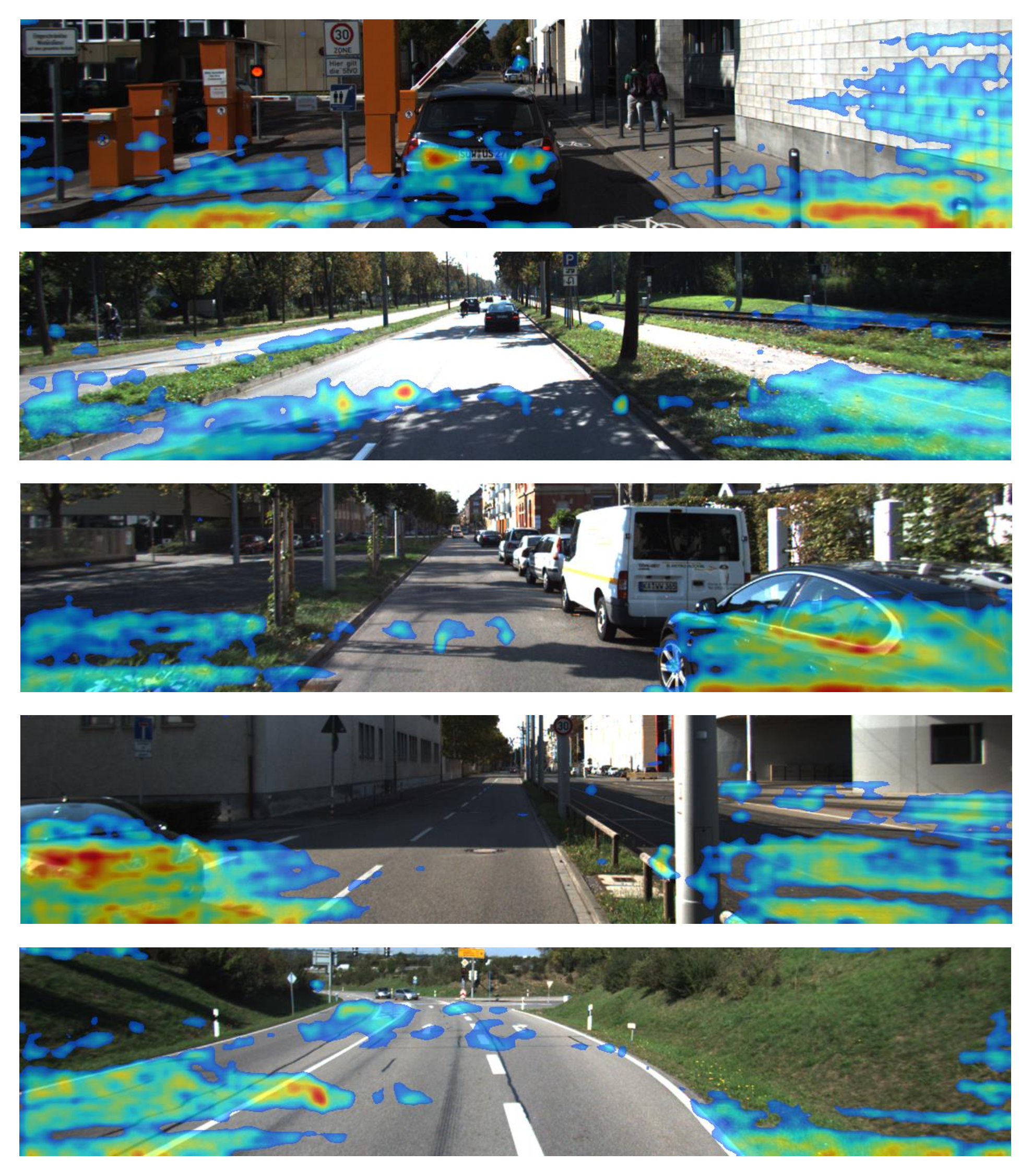

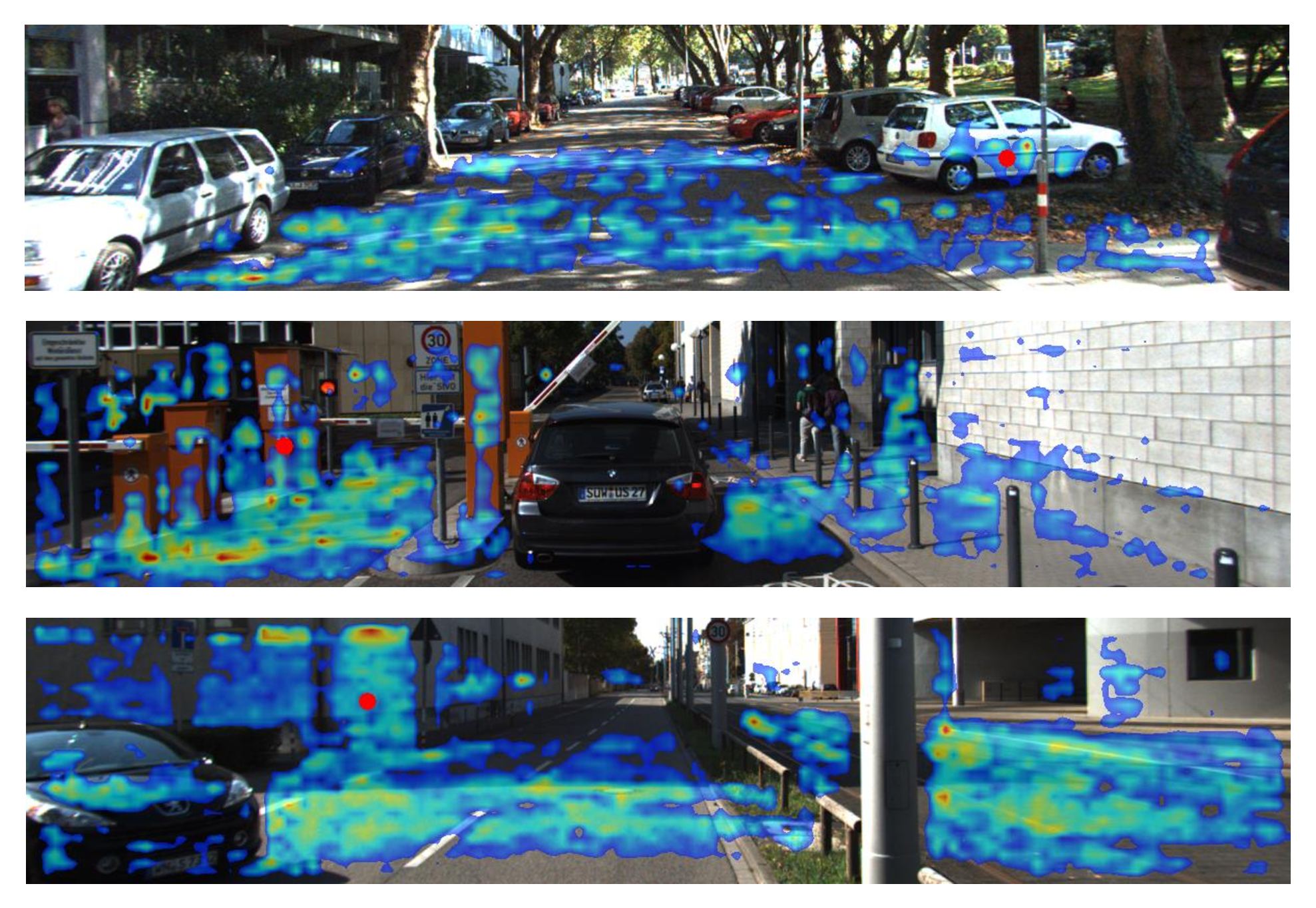

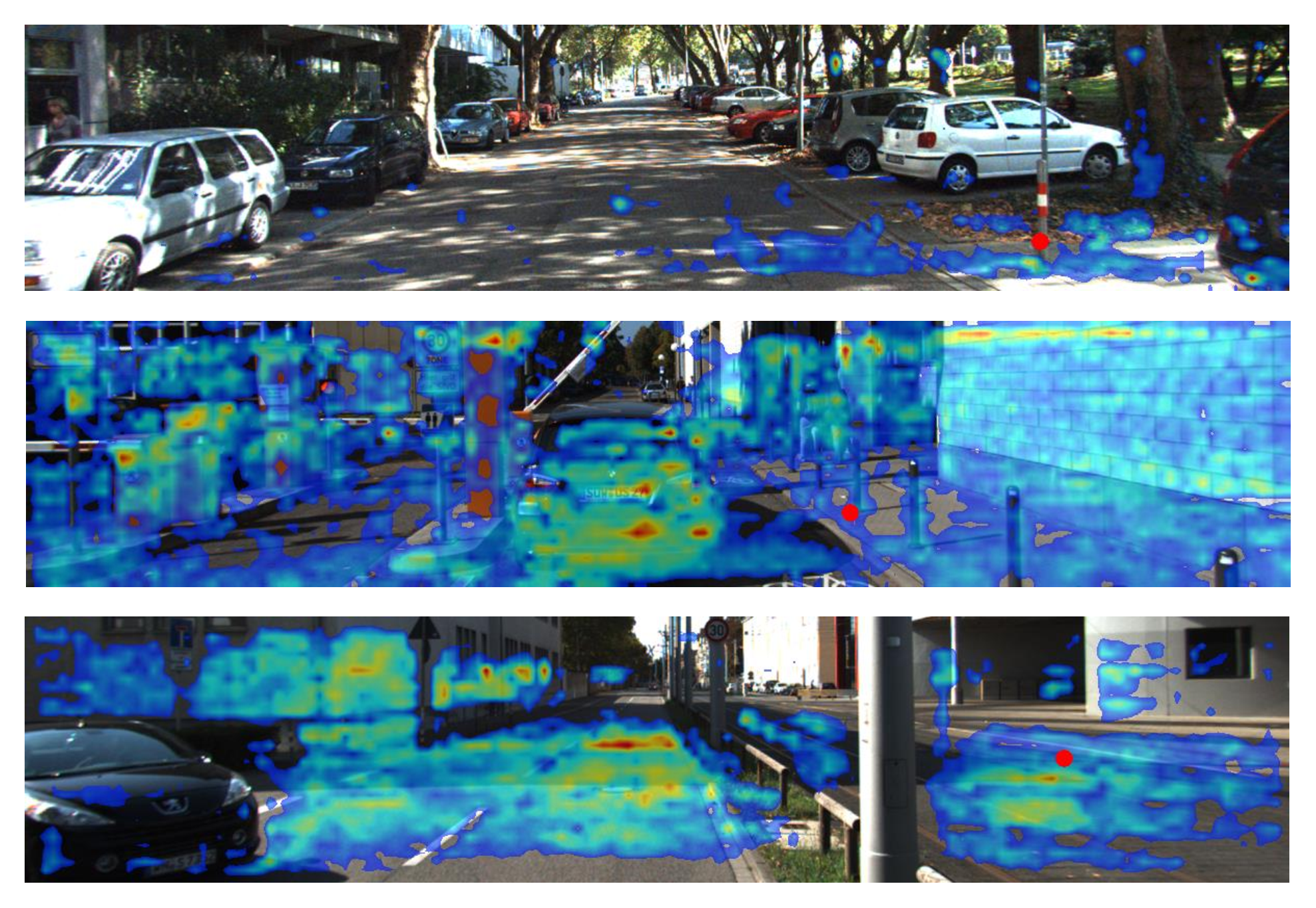

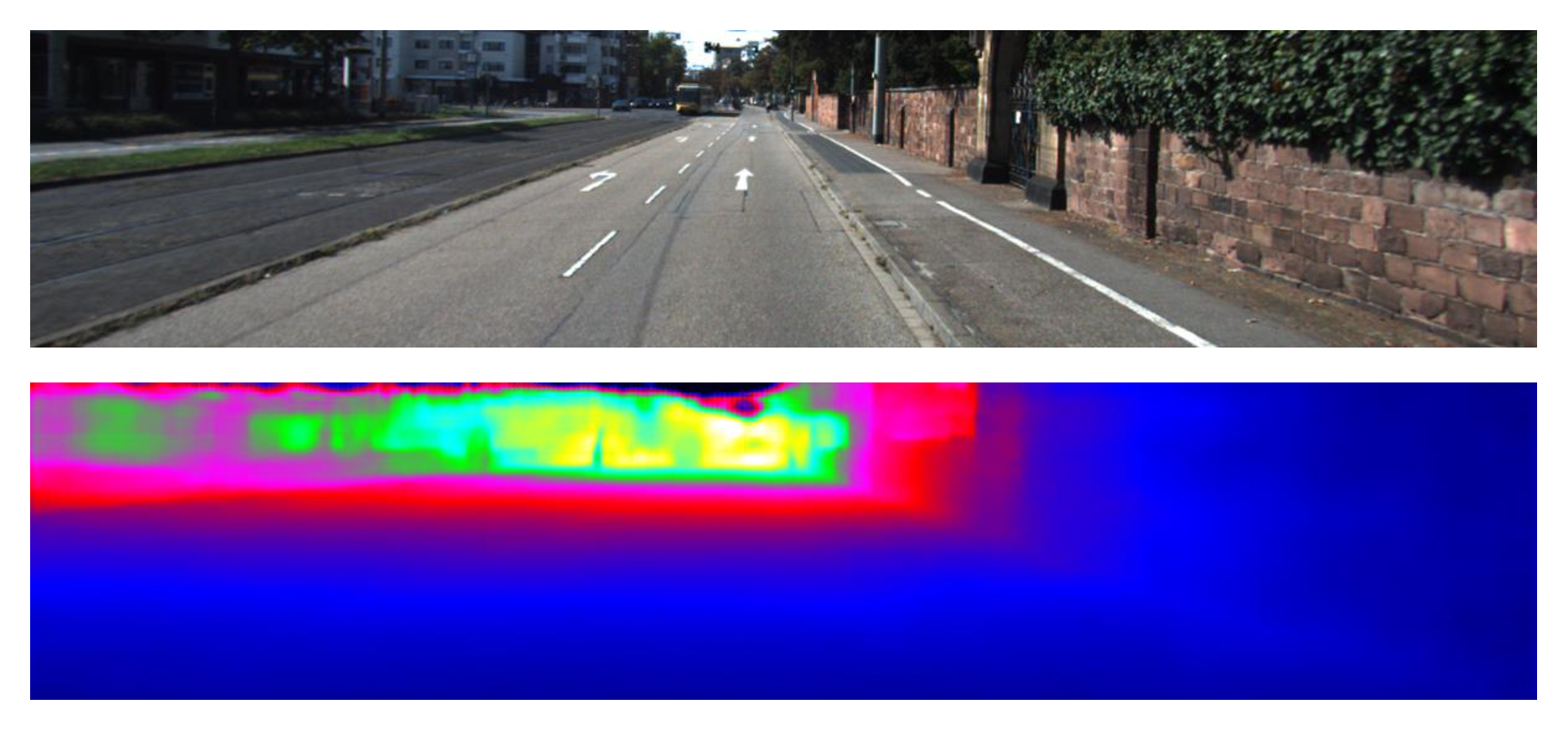

밀도적인 깊이 완성은 자율 시스템과 3D 재구성을 위한 필수 요소이다. 본 논문에서는 효율성과 정확성 사이의 좋은 균형을 이루는 가벼우면서도 효과적인 네트워크(S&CNet)를 제안한다. 공간적 측면과 채널별 전역 범위 관계를 측정하기 위해 이중 스트림 주의 모듈(S&C 강화기)을 도입하여 성능을 향상시킨다. 높은 추정 네트워크와 디코더 네트워크 사이에 제안된 S&C 강화기를 플러그인한 코스-투-파인 네트워크가 설계되었다. 실험 결과는 KITTI 데이터셋에서 기존의 작업들과 경쟁적인 성능을 보여주지만 거의 4배 빠르다는 것을 입증한다. 제안된 S&C 강화기는 기타 기존 작업에도 플러그인되어 무시할 수 있는 추가 계산 비용으로도 성능을 크게 향상시킬 수 있다.💡 논문 핵심 해설 (Deep Analysis)

The primary challenge addressed here is achieving accurate depth completion while maintaining high processing speeds—a critical requirement for real-time applications like autonomous driving and 3D modeling. S&CNet’s architecture includes a sophisticated mechanism to analyze feature relationships across different dimensions, leading to improved outcomes in dense depth estimation tasks.

Experimental results demonstrate that S&CNet achieves competitive performance on the KITTI dataset but operates nearly four times faster than existing methods. This speed advantage is significant for real-world applications where quick decision-making based on accurate depth information is crucial.

In summary, this work advances the field by providing a faster and more efficient solution to dense depth completion, with broad implications for autonomous systems and 3D reconstruction technologies.

📄 논문 본문 발췌 (Translation)

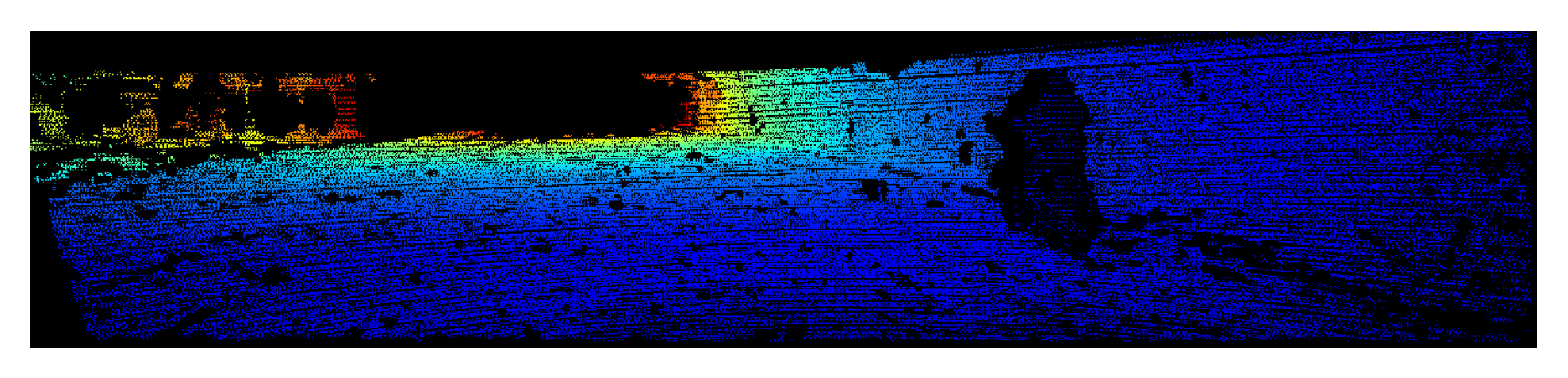

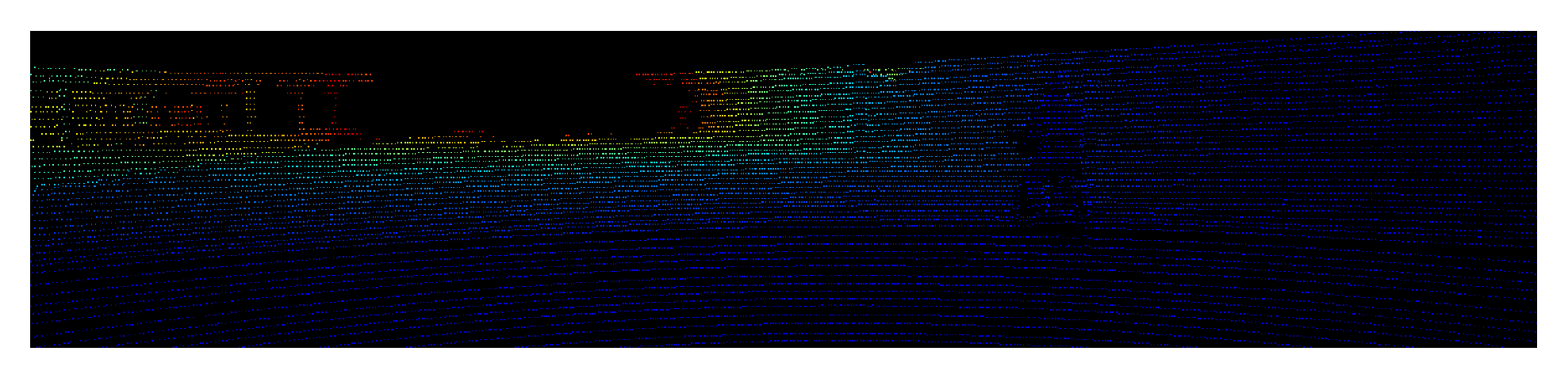

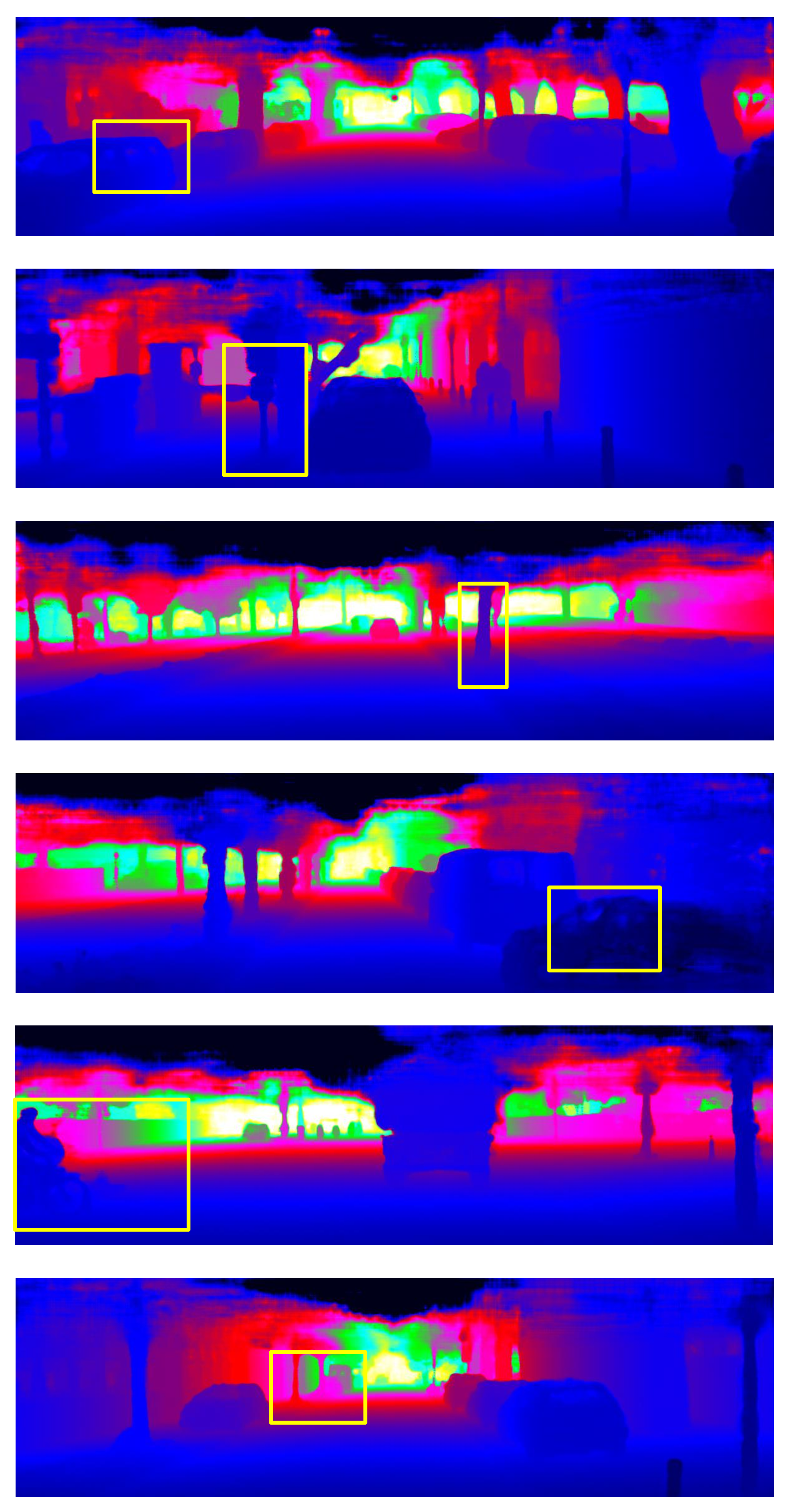

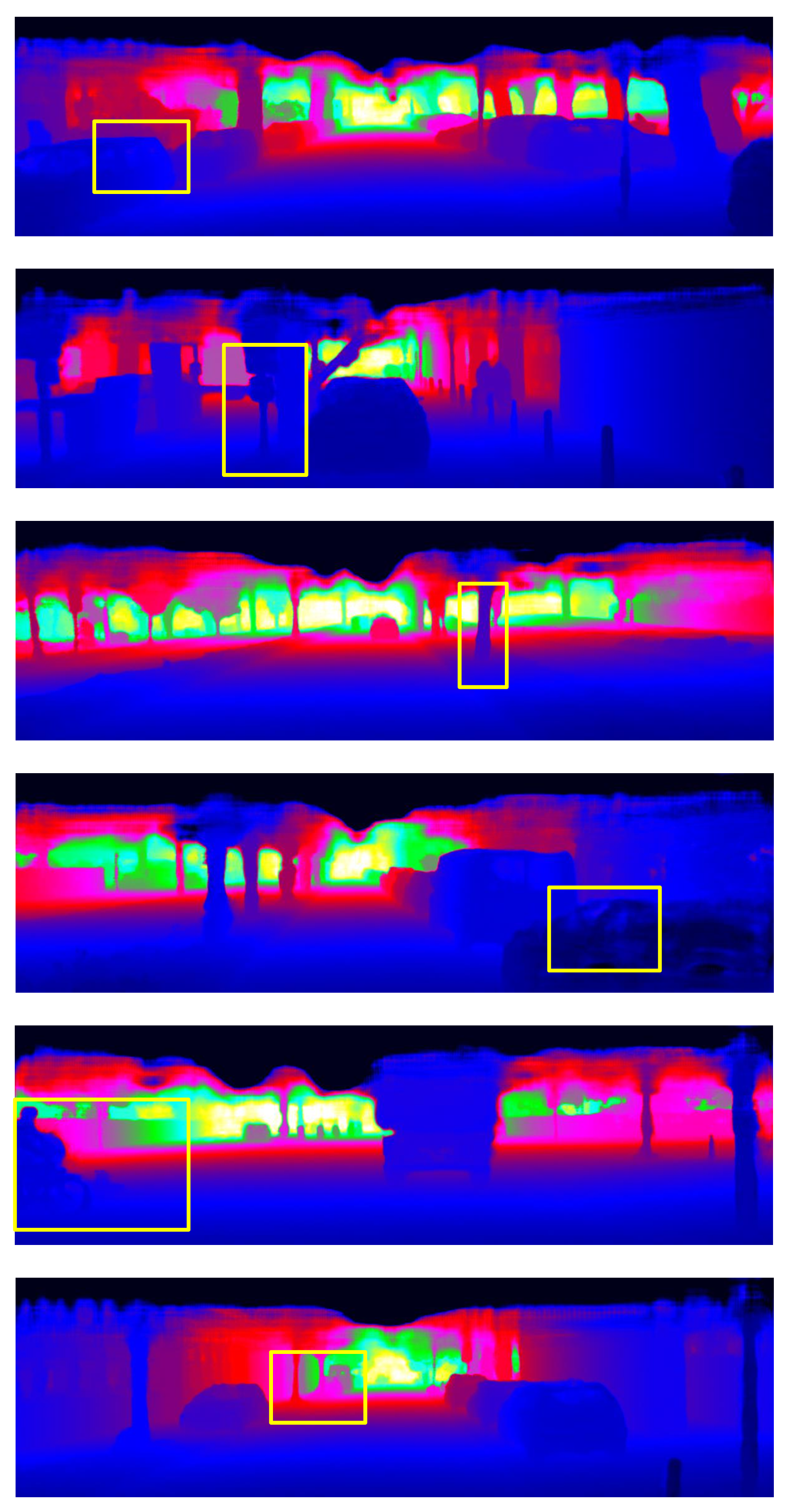

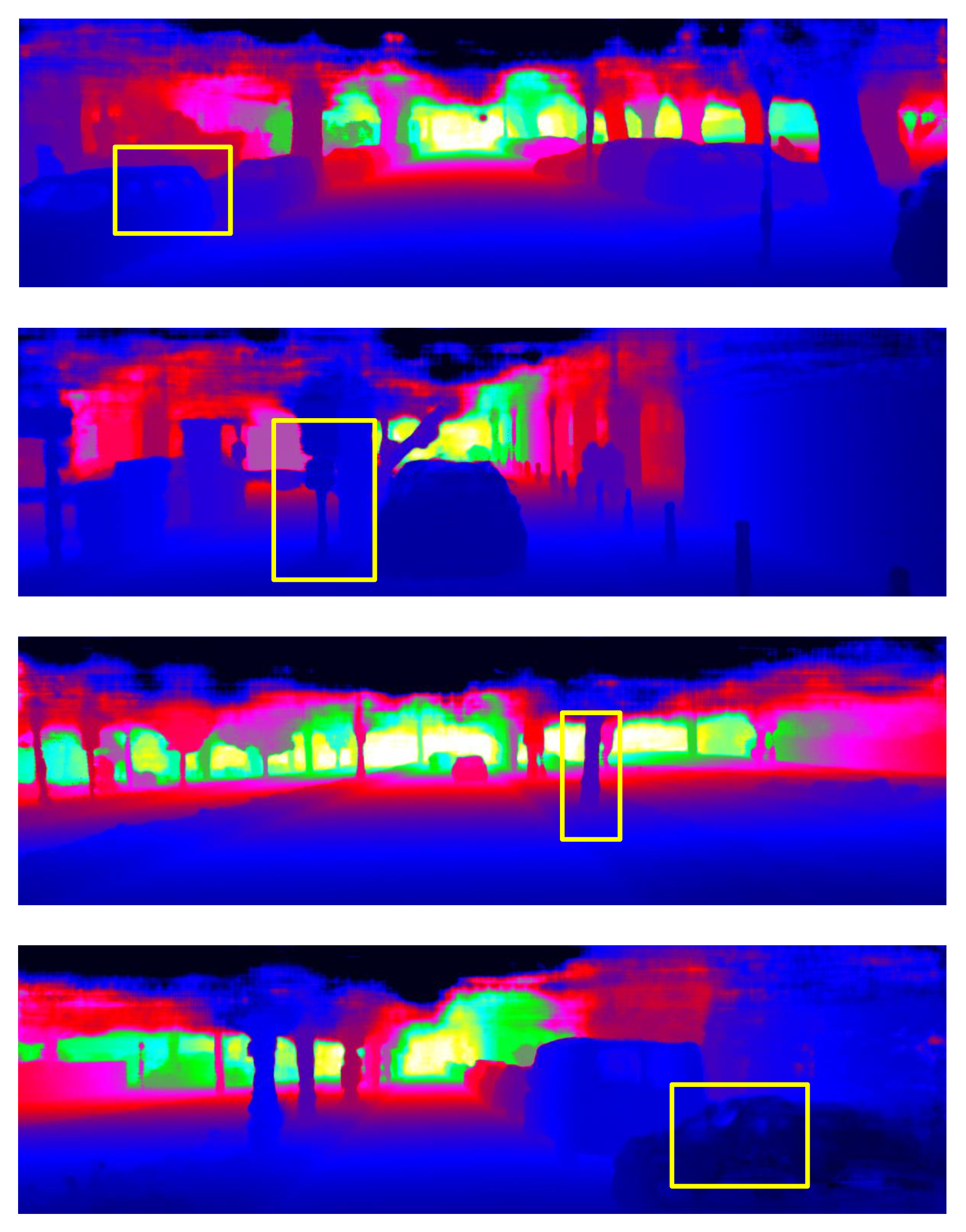

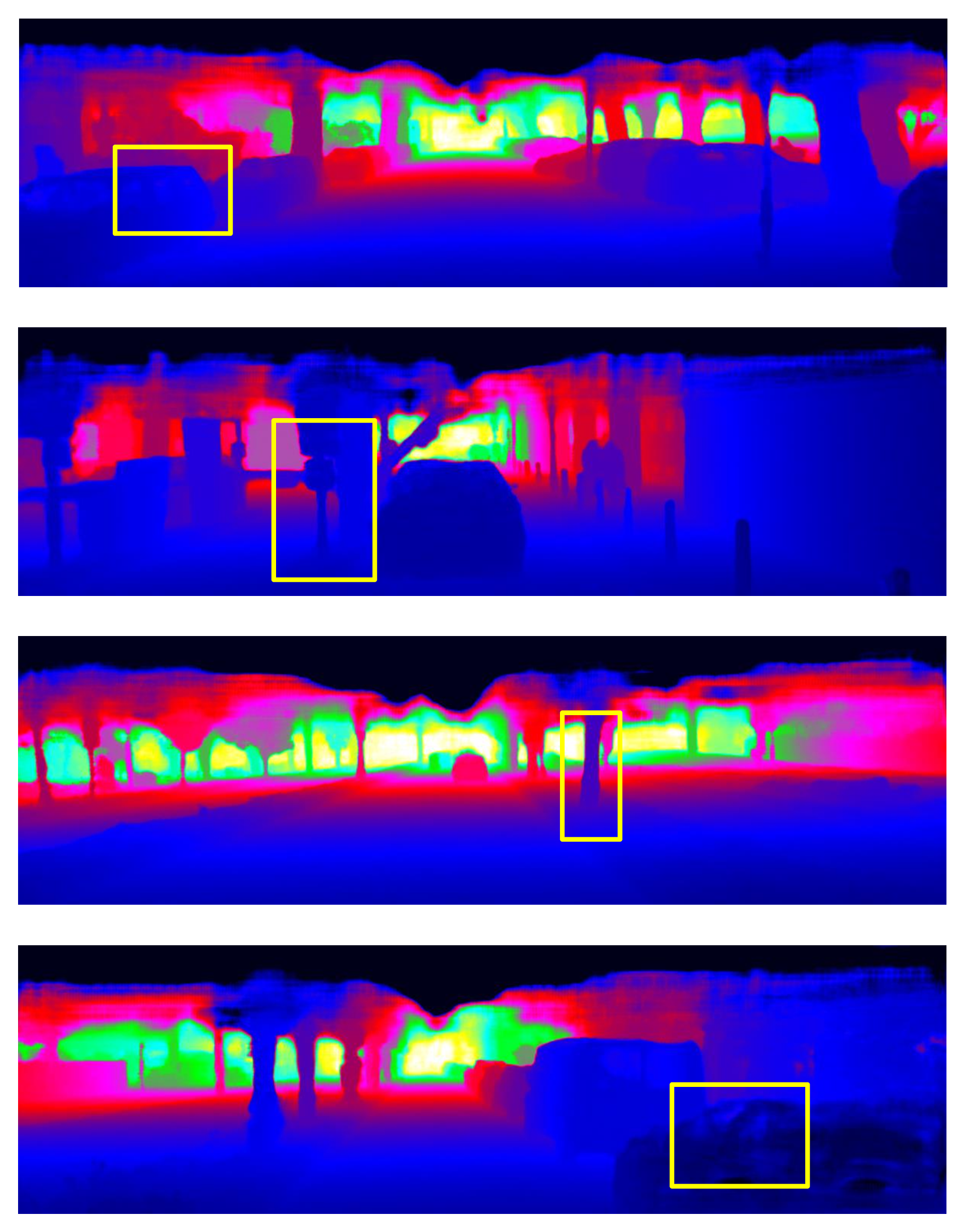

📸 추가 이미지 갤러리