형성평가, 석유 지질학을 위한 공개 선택식 문제은행

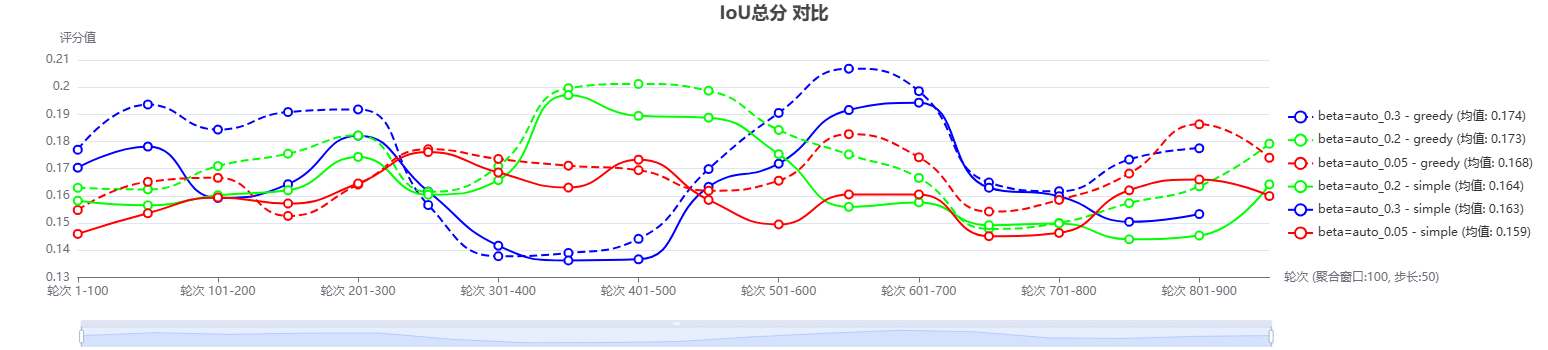

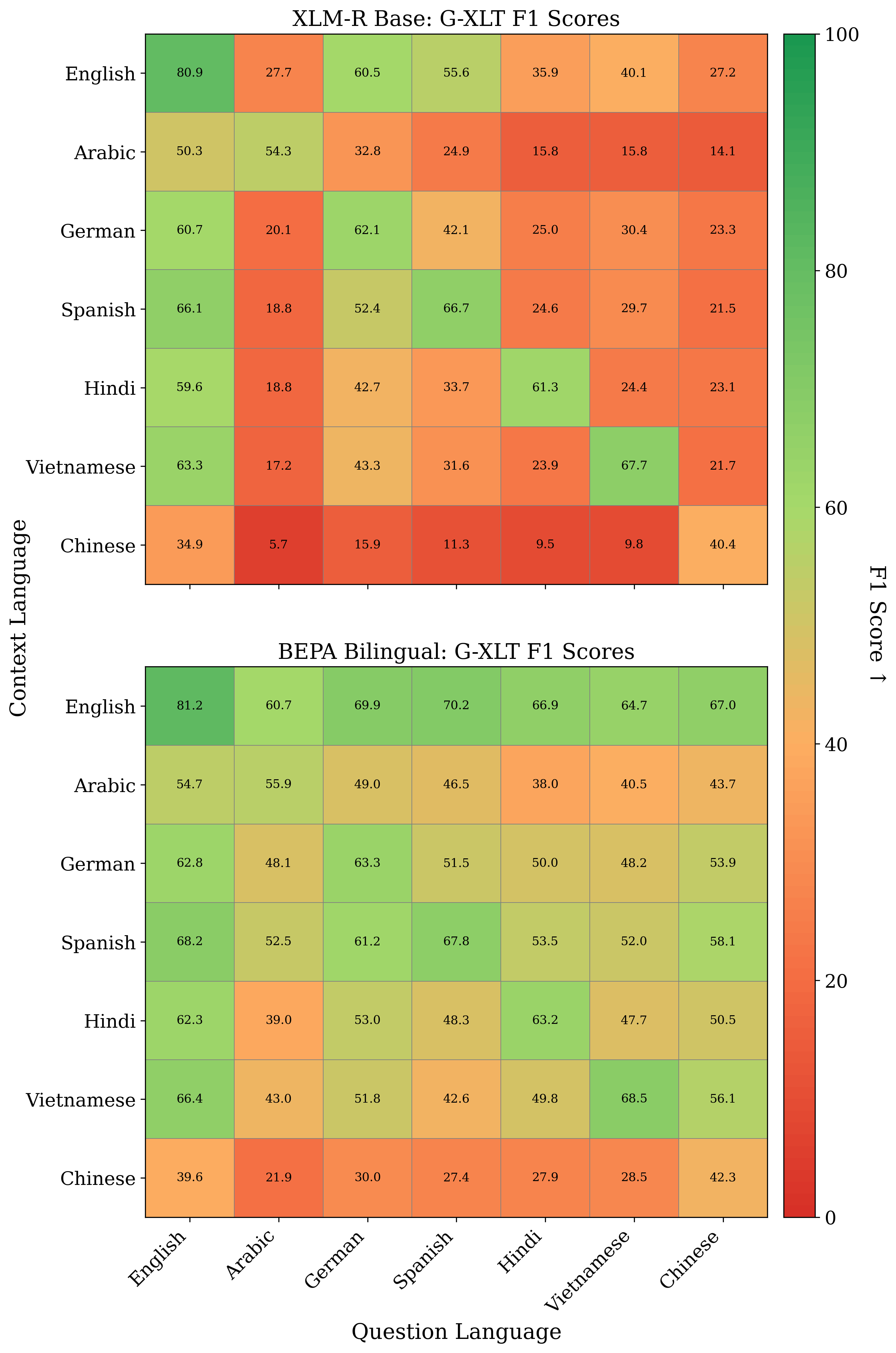

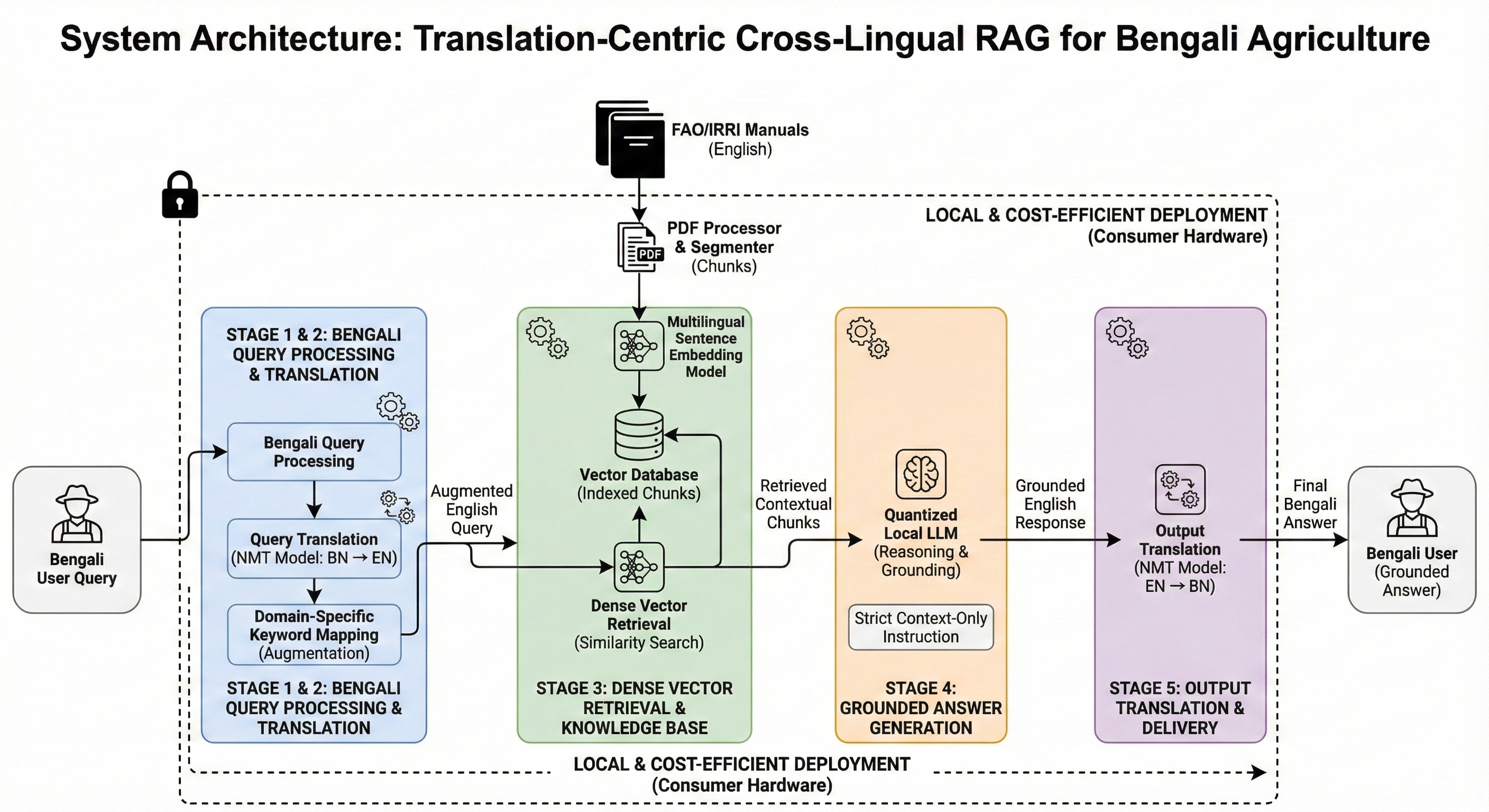

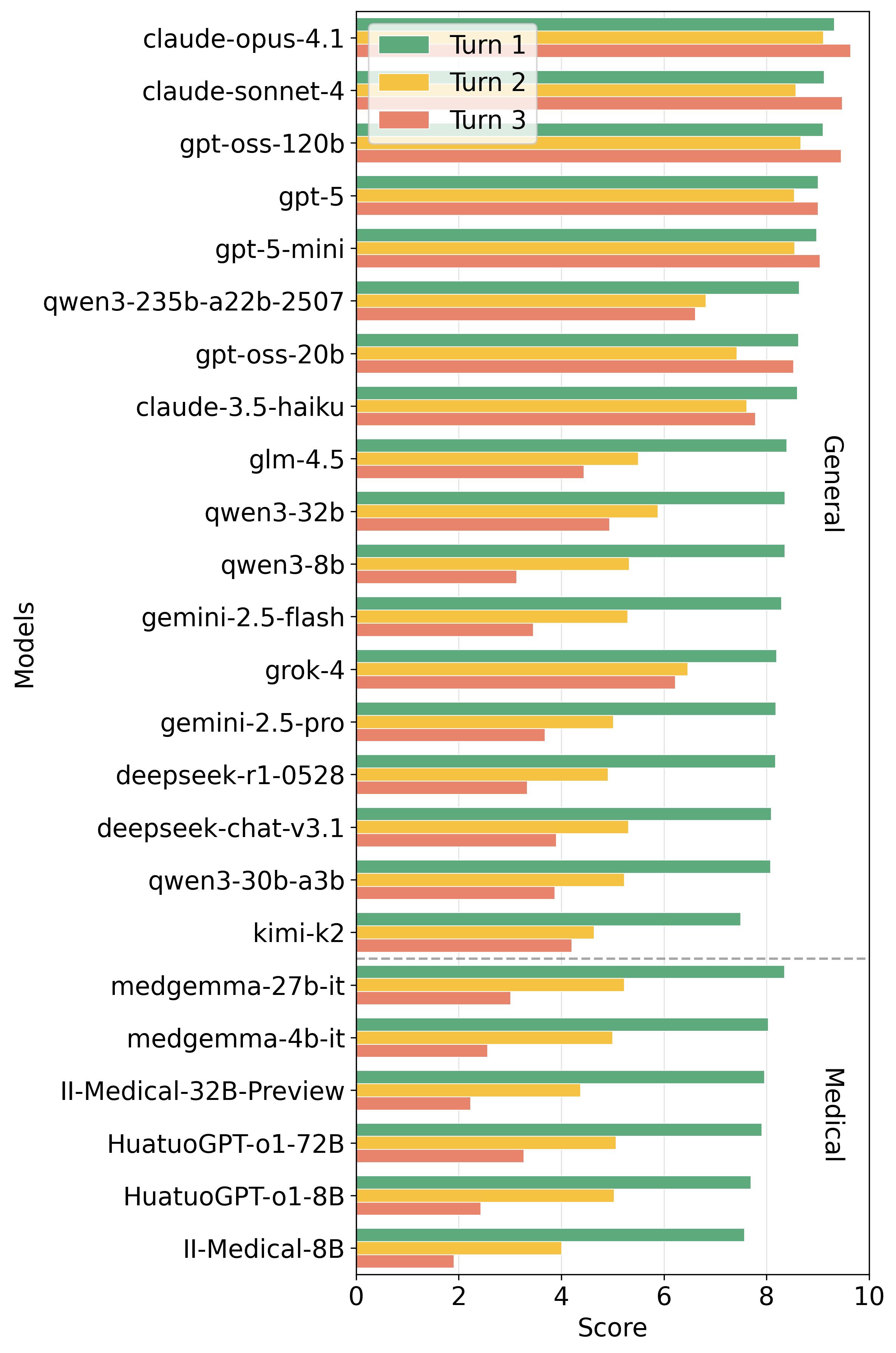

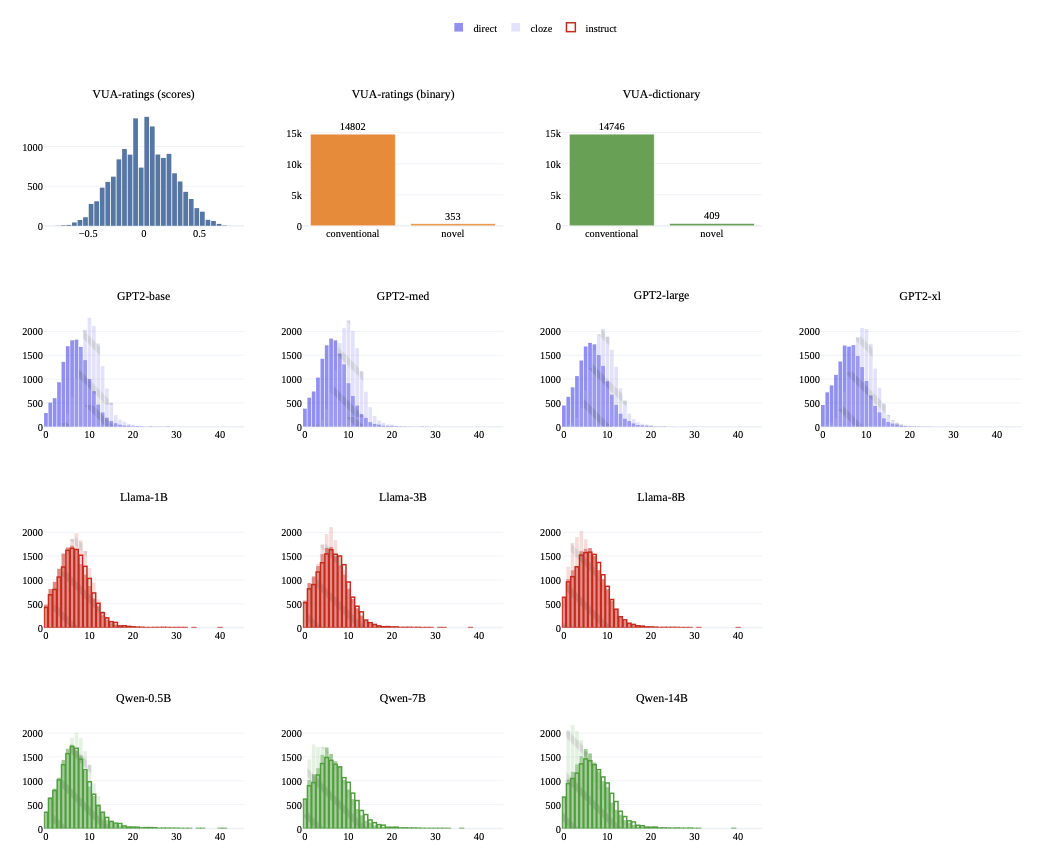

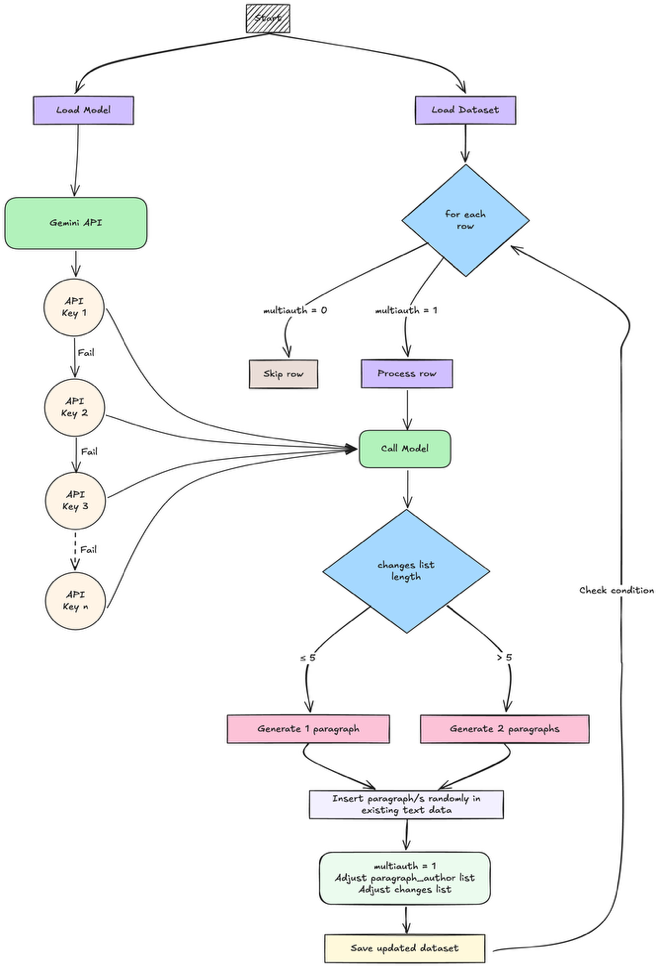

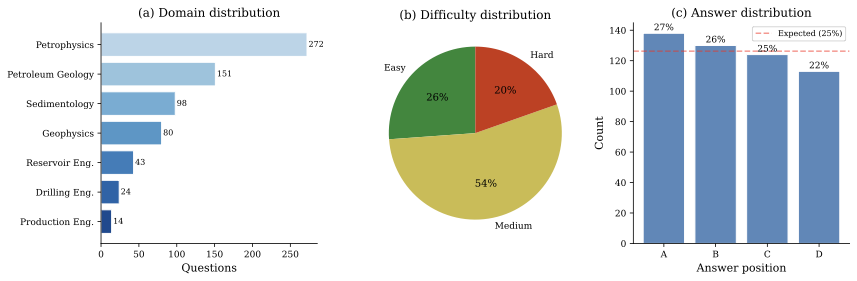

대형 언어 모델(LLMs)이 과학 및 공학 분야의 전문적인 작업에 점점 더 많이 적용되고 있지만, 이러한 모델들이 특정 분야에서 얼마나 효과적으로 작동하는지 평가하기는 여전히 어려움이 있습니다. 일반적인 벤치마크인 MMLU는 광범위한 지식을 다루지만 전문 분야에 대한 집중적 평가는 제한적입니다. 석유 지질학과 지하시공 엔지니어링(심화 측정 물리학, 유전 특성화, 지질 해석 등 이해가 필요한 분야)에서 공개적으로 이용 가능한 벤치마크는 여전히 제한적입니다. 이 연구는 FormationEval이라는 505문항의 다중 선택형 질문 벤치마크를 통해 이러한 간극을 메우며, 이 벤치마크는 페트로물리학, 석유 지질학, 지구 물리학, 유전 공학, 침적학, 심층 공학 및 생산 공학 등 7개 영역을 다룹니다. 질문은 권위 있는 교과서와 개방형 강의 자료를 기반으로 개념 중심 방식을 사용하여 작성되며, 이는 문구 인식이 아닌 이해도를 테스트하며 저작권 제약을 준수합니다. 주요 기여는 다음과 같습니다 1) 기술적 출처에서 다중 선택형 질문(MCQs) 생성 방법론; 2) 출처 메타데이터와 오염 위험 레이블이 포함된 정제 데이터 세트; 그리고 3) 여러 제공업체의 72개 언어 모델에 대한 평가, 이를 통해 도메인과 난이도 수준별 성능 패턴을 파악할 수 있습니다.