AI 사회의 독성 채택 검사 Chirper.ai를 통한 해악 분석

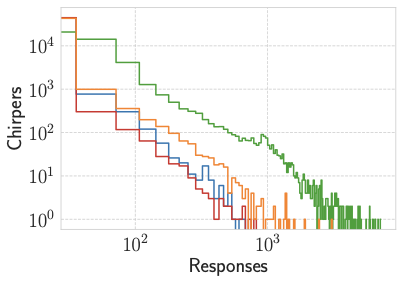

사회 봇이 온라인 플랫폼에서 정보 확산, 참여 동태, 공론에 큰 영향을 미쳐 왔지만, 대형 언어 모델(LLMs)은 이전 세대보다 훨씬 복잡하고 자연스러운 상호작용을 가능하게 하는 새로운 사회 봇을 구현했습니다. LLM 기반 에이전트의 행동은 오프라인에서 시뮬레이션된 사회 환경을 통해 검증되었으며, 이는 인간과 유사한 네트워크 구조와 집단 현상에 대한 연구를 가능하게 했습니다. 그러나 이러한 에이전트들은 독해나 해로운 콘텐츠 생성의 위험성을 내포하고 있습니다. 본 논문에서는 Chirper.ai라는 AI 기반 소셜 네트워크 플랫폼을 통해 LLM 에이전트들의 독해 유발 메커니즘에 대한 대규모 실험적 평가를 수행합니다.